Negli ultimi anni, il panorama delle minacce informatiche si è evoluto a una velocità impressionante. Gli hacker affinano costantemente le loro tecniche, mentre le aziende cercano di stare al passo con difese sempre più sofisticate. Il Sophos Active Adversary Report 2025 lancia, da questo punto di vista, un segnale d’allarme chiaro: la semplice prevenzione non è più sufficiente.

Tag: sicurezza

In un mondo in cui le minacce alla sicurezza si evolvono rapidamente, l’Europa si prepara a un cambiamento epocale con ProtectEU, la nuova strategia per la sicurezza interna presentata dalla Commissione Europea. Annunciata dalla presidente Ursula von der Leyen nelle sue linee guida politiche, questa iniziativa ambiziosa mira a rafforzare la capacità dell’Unione Europea di proteggere i suoi cittadini, affrontando sia le minacce tradizionali che quelle emergenti in un panorama geopolitico sempre più complesso. Con un approccio che coinvolge l’intera società, ProtectEU si propone di rivoluzionare il modo in cui l’Europa gestisce la sicurezza interna, promuovendo una cooperazione più profonda, strumenti legali più rigorosi e una maggiore condivisione delle informazioni.

Il mondo della cybersecurity è nuovamente in allerta: FamousSparrow, gruppo APT (Advanced Persistent Threat) allineato alla Cina, ha ripreso le proprie attività di cyberspionaggio, colpendo organizzazioni negli Stati Uniti, in Messico e in Honduras. Dopo un’apparente inattività di due anni, i ricercatori di ESET hanno scoperto nuove varianti della backdoor SparrowDoor e l’impiego, per la prima volta, del malware ShadowPad.

L’Europa si trova a un punto di svolta: i rapidi progressi delle tecnologie digitali, l’aumento delle minacce informatiche e un contesto geopolitico in continua evoluzione stanno spingendo l’Unione Europea e i suoi Stati membri a ripensare la sicurezza dello spazio digitale. “Mentre lavoriamo per mantenere un’economia forte e sicura, la necessità di una sicurezza informatica rafforzata in tutti i settori non è mai stata così urgente”, si legge nella Warsaw Call, una dichiarazione adottata all’unanimità durante il Consiglio informale Telecomunicazioni tenutosi a Varsavia il 5 marzo 2025. Questo documento, noto anche come Dichiarazione di Varsavia, rappresenta un pilastro strategico per il futuro della cybersecurity europea, offrendo una risposta coordinata alle crescenti sfide che minacciano la stabilità digitale del continente.

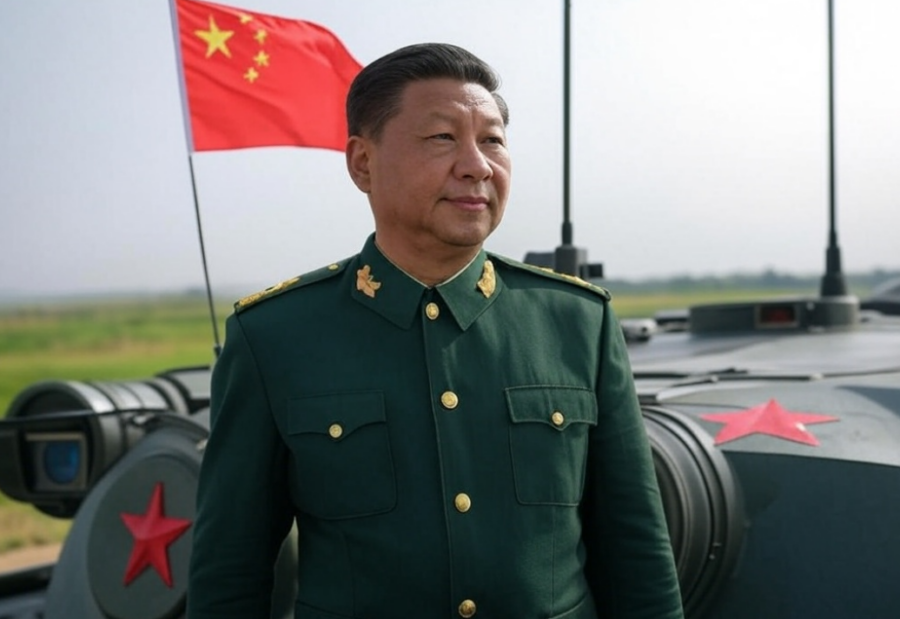

La Cina continua a rafforzare il suo apparato militare con un approccio che definisce “moderato e ragionevole”, mantenendo una crescita della spesa per la difesa a una cifra per il nono anno consecutivo. A sottolinearlo è stato Lou Qinjian, portavoce del Congresso Nazionale del Popolo (NPC), durante il briefing di presentazione dell’evento politico più importante dell’anno per la Repubblica Popolare, che si terrà a partire da domani, 5 marzo 2025. Sarà proprio quello il momento nel quale l’NPC svelerà il budget della difesa per il 2025, un dato atteso con attenzione sia dagli analisti interni sia dalla comunità internazionale, desiderosa di decifrare le ambizioni del Dragone in un contesto globale sempre più teso.

In un momento di crescente incertezza geopolitica, la Presidente della Commissione Europea Ursula von der Leyen ha annunciato un piano ambizioso per rafforzare le capacità di difesa dell’Unione Europea. Il nuovo strumento finanziario, denominato “Rearm Europe“, prevede un investimento di 150 miliardi di euro per supportare gli Stati membri nel potenziamento delle loro capacità difensive. Questo fondo, istituito ai sensi dell’articolo 122 del Trattato sul funzionamento dell’UE (TFUE), permetterà di fornire prestiti garantiti dal bilancio dell’UE senza la necessità di passare dal Parlamento Europeo, accelerando così il processo decisionale.

In Italia, il panorama della cybersecurity si fa sempre più critico: gli attacchi informatici, potenziati da tecnologie avanzate e dall’intelligenza artificiale, sono in aumento, colpendo il 73% delle grandi imprese nell’ultimo anno, secondo i dati dell’Osservatorio Cybersecurity & Data Protection del Politecnico di Milano. Nel 2024, il mercato italiano della sicurezza informatica cresce del 15%, raggiungendo un valore di 2,48 miliardi di euro, con previsioni di ulteriore espansione nel 2025. Eppure, nonostante i progressi, l’Italia rimane fanalino di coda tra i Paesi del G7 nel rapporto tra spesa in cybersecurity e PIL, ben lontana dai livelli di Stati Uniti e Regno Unito.

Verizon Business e Accenture hanno annunciato una partnership strategica per affrontare le crescenti sfide della cybersecurity, un settore in rapida evoluzione che richiede soluzioni innovative e resilienti. L’accordo unisce le competenze di Verizon nel networking e nella sicurezza informatica con l’esperienza di Accenture nei servizi tecnologici avanzati, con l’obiettivo di sviluppare e offrire soluzioni all’avanguardia per proteggere le organizzazioni di ogni dimensione da minacce sempre più sofisticate, come violazioni dei dati, attacchi di phishing, social engineering e altri rischi emergenti.

Il Segretario alla Difesa Pete Hegseth ha ordinato al Cyber Command degli Stati Uniti di sospendere la pianificazione di operazioni informatiche e di intelligence contro la Russia.

In un’epoca in cui l’Intelligenza Artificiale sta ridefinendo il modo di operare delle aziende, Cisco ha presentato AI Defense, una soluzione innovativa destinata a diventare il punto di riferimento globale per la sicurezza dell’AI. Annunciata nel corso di una sessione esclusiva ospitata da The Rundown AI, una newsletter quotidiana dedicata ai progressi dell’AI, Jeetu Patel, Executive Vice President e Chief Product Officer di Cisco, hanno illustrato come questa innovazione affronti le sfide critiche nella protezione dei sistemi di AI.

Le minacce informatiche che sfruttano l’Intelligenza Artificiale sono in aumento, trasformando il panorama della sicurezza digitale. Tra i nuovi attori emergenti spicca FunkSec, un gruppo di hacker che ha rivoluzionato le dinamiche dell’hacking combinando l’uso di AI avanzata e strategie di propaganda digitale. Il gruppo è stato identificato da Check Point Research, una delle principali agenzie globali di sicurezza informatica.

La compagnia spagnola di telecomunicazioni Telefonica ha subito un cyberattacco al suo sistema di ticketing interno, mediante il quale sarebbero stati sottratti 2,3 giga di dati che, secondo quanto hanno dichiarato fonti della compagnia dall’agenzia Europa Press, non riguarderebbero i suoi clienti.

Nessun settore dell’IT necessita di aggiornamenti costanti ed immediati quanto la sicurezza informatica. Essere pronti a mitigare gli attacchi non basta, è necessario poterli prevenire e, in un periodo in cui le minacce digitali stanno prendendo sempre più piede nei settori più svariati, l’apporto dell’AI nella cybersecurity diventa essenziale.

La visita lampo di Giorgia Meloni negli Stati Uniti, presso la residenza privata di Donald Trump in Florida, pur avendo avuto un taglio strettamente privato, si è svolta in un clima riservato e produttivo. Pur avendo avuto un taglio strettamente privato e, sebbene, il motivo principale del viaggio, come riportato da diverse fonti, sia stato il tema relativo al “sequestro” da parte dell’Iran della giornalista italiana Cecilia Sala (attualmente detenuta nel carcere di Evin, con la generica accusa di “aver violato le leggi della Repubblica islamica”), l’incontro ha messo al centro temi cruciali per i rapporti bilaterali Italia-Usa. Un incontro che ha posto le basi per un rafforzamento delle relazioni transatlantiche in un momento cruciale per la sicurezza globale, l’innovazione tecnologica e la transizione energetica.

Amburgo promette di diventare un punto di riferimento nelle soluzioni di mobilità intelligente integrando sistemi di AI nei suoi sistemi di trasporto pubblico per garantire la sicurezza dei passeggeri. Le aziende di trasporto della città, Hochbahn e S-Bahn, stanno infatti combinando la supervisione umana – il personale addetto alla sicurezza verrà significativamente incrementato – con una tecnologia AI all’avanguardia per creare un ambiente di viaggio più sicuro.

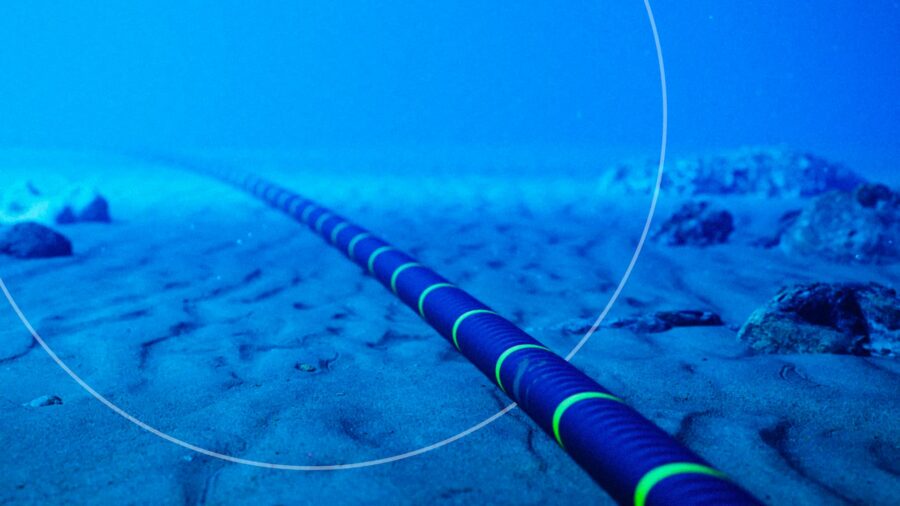

Il danneggiamento dei cavi sottomarini di collegamento tra Finlandia ed Estonia, avvenuto nelle ultime ore e attribuito alla petroliera “Eagle S” sospettata di far parte della flotta fantasma russa, rappresenta un inquietante esempio di guerra ibrida e sabotaggio delle infrastrutture critiche occidentali. Si tratta di un episodio da non sottovalutare in quanto si inserisce all’interno di un contesto più ampio di escalation geopolitica e di attacchi mirati alle infrastrutture vitali, che stanno trasformando il modo in cui i Paesi sono chiamati a ripensare la propria sicurezza e la difesa degli interessi nazionali.

Nel contesto delle crescenti tensioni tra Stati Uniti e Cina, che hanno già portato a ban commerciali reciproci, emerge ora la questione di TP-Link, una delle società di modem-router più famose al mondo. Le autorità americane starebbero infatti considerando un possibile divieto per i router prodotti dall’azienda cinese, che attualmente detiene il 65% del mercato statunitense di abitazioni e piccole imprese. Il motivo? Le crescenti preoccupazioni legate alla sicurezza nazionale e ai presunti collegamenti di TP-Link con il governo cinese.

Fincantieri e Sparkle hanno siglato un memorandum d’intesa per sviluppare soluzioni tecnologiche innovative per la sorveglianza e la protezione dei cavi di telecomunicazione sottomarini. L’accordo si inquadra nell’ambito di una visione strategica per lo sviluppo tecnologico e la competitività dell’Italia a livello internazionale.

L’Intelligenza Artificiale e l’AI generativa stanno ridefinendo rapidamente il panorama della sicurezza informatica, offrendo al contempo nuove opportunità di difesa e introducendo complesse minacce. Un recente report del Capgemini Research Institute, intitolato “New defenses, new threats: what AI and Gen AI bring to cybersecurity“, ha analizzato 1.000 aziende, rivelando come queste tecnologie siano diventate cruciali nelle strategie di sicurezza di due terzi delle organizzazioni.

L’azienda tedesca Helsing, specializzata in software per la difesa basato su Intelligenza Artificiale, ha annunciato l’avvio della produzione di massa del drone da combattimento HX-2, progettato per resistere alla guerra elettronica e alle misure di disturbo grazie alla tecnologia AI integrata.

L’indagine sul prelievo di migliaia di informazioni sensibili da banche dati strategiche nazionali condotta dalla Procura di Milano e dalla Direzione nazionale antimafia, che ha portato al momento a sei misure cautelari, sembra allargarsi in modo imprevedibile, tant’è che il procuratore antimafia Melillo parla di “vicenda allarmante” e di “dimensione imprenditoriale” del fenomeno.

Con un passo strategico verso l’open innovation, Fincantieri, uno dei leader mondiali nella costruzione di navi ad alta intensità tecnologica, ha annunciato l’apertura di una nuova Innovation Antenna presso il Mind the Bridge Innovation Center a San Francisco. L’iniziativa, che colloca l’azienda italiana nel cuore della Silicon Valley, conferma il suo impegno nel creare un ecosistema dove tecnologie Dual-Use, applicabili quindi sia nel settore civile che in quello militare, possano trovare terreno fertile e svilupparsi attraverso collaborazioni e sinergie. Gli ambiti di sviluppo riguardano principalmente l’Intelligenza Artificiale, la cyber security, l’automazione e la robotica, settori in cui la convergenza tra applicazioni civili e militari è particolarmente marcata.

Dopo l’AI i computer quantistici: la prossima rivoluzione nella cybersicurezza secondo Amir Rapaport

L’Intelligenza Artificiale ha rivoluzionato completamente il digitale e la cybersicurezza, la prossima rivoluzione sarà con l’arrivo dei computer quantistici tra pochi anni: a ipotizzare il futuro del settore è Amir Rapaport, l’ideatore e organizzatore di CyberTech Europe che si è appena conclusa a Roma.

Nel periodo compreso tra gennaio e settembre 2024, gli acquisti di iPhone da parte del governo russo sono aumentati di quattro volte rispetto allo stesso periodo dell’anno precedente, secondo quanto riportato dal quotidiano russo Vedomosti. Questo aumento si verifica nonostante il divieto imposto a certi funzionari di utilizzare i dispositivi Apple.

Nel giugno 2023, il Servizio Federale di Sicurezza della Russia (FSB) ha rivelato di aver scoperto un’operazione di spionaggio statunitense che avrebbe compromesso migliaia di iPhone attraverso un software di sorveglianza sofisticato, accusa che Apple ha prontamente negato[2][3]. Nonostante le preoccupazioni riguardo alla sicurezza, il valore totale dei contratti legati agli iPhone per i primi tre trimestri del 2024 ha raggiunto 6,9 milioni di rubli (circa 71.469 dollari), in netto aumento rispetto ai 1,6 milioni di rubli dello scorso anno.

L’84% dei CIO aziendali ritiene che l’Intelligenza Artificiale sarà importante per le aziende quanto lo è stata l’ascesa di Internet. Tuttavia, solo l’11% afferma di aver implementato completamente questa nuova tecnologia, segnalando una serie di sfide tecniche e organizzative, in particolare le problematiche relative alla sicurezza e all’infrastruttura dei dati, che devono ancora essere superate. Sono questi i dati che emergono da una nuova indagine di Salesforce su 150 CIO di aziende con 1.000 o più dipendenti e che offre una fotografia dello stato di adozione dell’AI nelle aziende oltre che una panoramica degli ostacoli che devono essere affrontati per mettere in atto strategie di AI.

E’ in corso il G7 Difesa a Napoli, presieduto dal Ministro Crosetto in occasione del quale le delegazioni – composte oltre che dai Ministri della Difesa, anche dal segretario generale della Nato Mark Rutte e dall’Alto rappresentante dell’Unione Europa per gli affari esteri e la politica di sicurezza, Josep Borrell – si confronteranno sui principali conflitti e sulle aree di instabilità a livello globale: oltre alla guerra in Ucraina, sul tavolo anche la situazione in Medioriente, in particolare all’indomani della morte del capo di Hamas Yahya Sinwar e gli equilibri nel continente africano e nella regione dell’Indo-Pacifico.

Si tratta di un appuntamento di particolare rilievo perché per la prima volta nella storia del G7 è stata prevista una riunione ministeriale dedicata alla difesa: una decisione assunta dalla Presidenza italiana del G7 “per promuovere il ruolo del G7 quale efficace forum di consultazione anche per individuare un approccio condiviso a tematiche di carattere politico-militare“.

L’Intelligenza Artificiale gestirà in modo sicuro il flusso dei passeggeri e il riconoscimento biometrico, per gli imbarchi sugli aerei di alcuni aeroporti in India. E’ il risultato nella nuova partnership stipulata tra Thales e la Adani Airport Holding, il più grande operatore aeroportuale privato dell’India.

Secondo un’analisi di Fortune, le forze di difesa e di sicurezza degli Stati Uniti stanno investendo massicciamente nell’Intelligenza Artificiale, collaborando con centinaia di aziende per sviluppare e testare nuovi algoritmi e strumenti in modo sicuro.

Nei due anni trascorsi dal rilascio del chatbot ChatGPT di OpenAI, che ha scatenato un forte interesse globale per l’AI, il Dipartimento della Difesa ha destinato circa 670 milioni di dollari in contratti a quasi 323 aziende per vari progetti legati all’Intelligenza Artificiale. Questi numeri segnano un incremento del 20% rispetto al 2021 e al 2022, sia per il numero di aziende coinvolte che per il valore complessivo dei contratti.

Negli ultimi anni, il progresso nell’Intelligenza Artificiale ha iniziato a trasformare ogni settore della società e a riscrivere le regole del conflitto e della sicurezza internazionale. In questo articolo, esploreremo le implicazioni per la Difesa e analizzeremo come il Ministero della Difesa del Regno Unito (MOD UK) stia rivalutando le sue priorità alla luce del rapido sviluppo dell’AI e dell’AGI (Intelligenza Artificiale Generale). Questo tema non riguarda solo il futuro prossimo, ma avrà effetti strategici di vasta portata fino al 2050 e oltre, ridefinendo la natura della guerra e la sicurezza globale.

L’FBI combatte gli attacchi informatici attraverso una serie di strategie avanzate. L’FBI è responsabile di investigare e prevenire le minacce informatiche, specialmente in settori critici come la sanità, dove attacchi ransomware o violazioni di dati sensibili possono avere impatti devastanti.

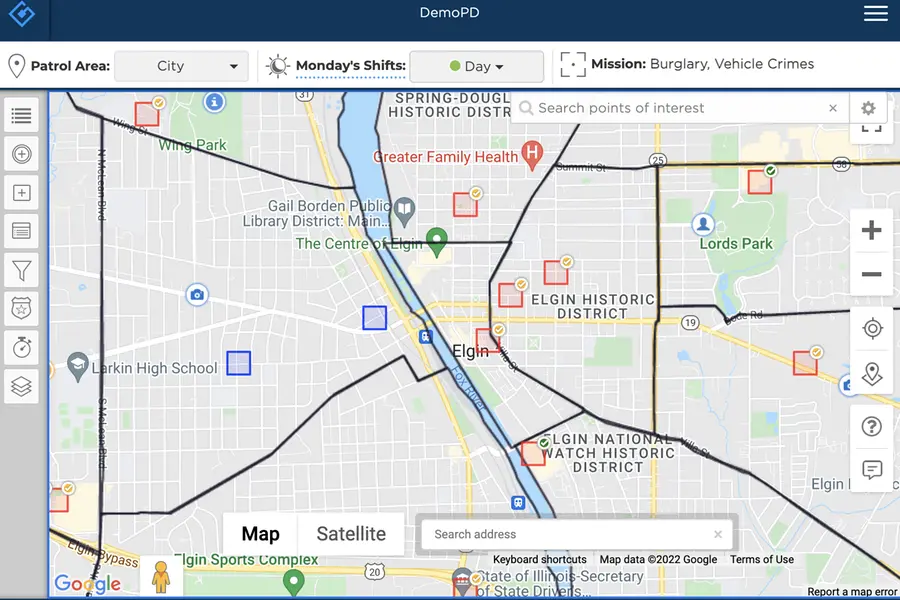

Rivista.AI ha recentemente trattato il tema della polizia predittiva, con particolare focus sul software X-Law, ideato da Elia Lombardo. Questo sistema rappresenta un approccio innovativo nella prevenzione dei crimini, utilizzando algoritmi probabilistici per analizzare dati provenienti da denunce e informazioni socio-economiche. L’obiettivo è prevedere con alta precisione il verificarsi di crimini, in particolare quelli di tipo predatorio come furti e rapine

In questo vogliamo analizzare Patternizr, un innovativo strumento di analisi dei crimini sviluppato internamente dal NYPD, implementato nel dicembre 2016 e recentemente rivelato attraverso un articolo pubblicato nell’INFORMS Journal on Applied Analytics.

Questo sistema utilizza un insieme di modelli di apprendimento automatico per identificare pattern tra i crimini, analizzando centinaia di migliaia di segnalazioni in tutti i 77 distretti della città.

Un “pattern” è definito come una serie di crimini che probabilmente sono stati commessi dallo stesso autore o da autori simili, basandosi su caratteristiche identificative. Prima dell’adozione di Patternizr, gli analisti erano costretti a esaminare manualmente i rapporti, un processo lungo e inefficiente, limitato a singoli distretti e soggetto a errori umani.

Con l’introduzione di questo strumento, il NYPD ha assunto circa 100 nuovi analisti formati per utilizzare Patternizr nella loro routine quotidiana, migliorando notevolmente l’efficienza nell’identificazione dei crimini correlati.

Devora Kaye, portavoce del NYPD, ha sottolineato l’importanza dell’analisi avanzata nel garantire la sicurezza pubblica, affermando che essa deve essere trasparente e soggetta a valutazione continua per garantirne l’equità e l’efficacia. Tuttavia, l’uso di Patternizr ha sollevato preoccupazioni riguardo ai potenziali bias nell’analisi dei dati, evidenziando la necessità di mantenere un controllo umano sui risultati generati dal sistema.

L’amministrazione Biden ha convocato un vertice per la sicurezza dell’Intelligenza Artificiale. L’appuntamento è alla fine di novembre, il 20 e il 21, a San Francisco e servirà per parlare del rapido sviluppo della tecnologia e degli sforzi per mitigarne i rischi.

Intervenuto in videoconferenza agli Stati Generali dell’Economia a Pescara, il Ministro della Difesa Guido Crosetto ha dichiarato che l’Intelligenza Artificiale “sarà fondamentale per la difesa e per tutti i nostri processi produttivi” facendo poi notare che “solo il 2%dei brevetti sono europei” mentre “il 61 per cento dei brevetti sulla sicurezza sono cinesi”.

“Aumentano i reati e aumenta anche la consapevolezza e la fiducia delle persone, più propense a denunciare. Ma soprattutto aumenta la percezione di insicurezza dei cittadini romani“. Così a Il Sole 24 Ore l’ex procuratore di Milano Francesco Greco, delegato alla Sicurezza dal sindaco di Roma Roberto Gualtieri, commenta i dati sui reati nella Capitale che la vedono al primo posto in Italia nella non invidiabile classifica sui reati commessi con oltre 256 mila denunce nel 2023.

Migliaia di persone che utilizzano la metropolitana di Londra sono state sorvegliate da un software di Intelligenza Artificiale (AI) progettato per individuare comportamenti criminali o situazioni pericolose. È quanto riportato da una inchiesta di Wired secondo cui il software di riconoscimento automatico è stato combinato con le immagini delle telecamere a circuito chiuso per poter rilevare comportamenti aggressivi, l’eventuale presenza di persone armate all’interno della metro, passeggeri che saltano i tornelli per non pagare il biglietto o, in casi più estremi, eventuali cadute sui binari.

Dal 2022 fino alla fine del 2023, il Transport for London (TfL), la società che gestisce la metropolitana e i bus della città, ha testato 11 algoritmi per monitorare le persone che passano dalla stazione della metropolitana di Willesden Green, nel nord-ovest della città. Si tratta del primo test in cui sono state combinate le immagini video in tempo reale con tool di Intelligenza Artificiale per generare avvisi inviati al personale delle metropolitana addetto ai controlli. Durante la fase di test sono stati emessi più di 44.000 avvisi, di cui 19.000 consegnati al personale della stazione in tempo reale.

I documenti di cui Wired riferisce di essere in possesso dettagliano come TfL abbia utilizzato una vasta gamma di algoritmi di visione artificiale per monitorare il comportamento delle persone nella stazione, concentrandosi non solo su temi legati alla sicurezza, ma anche su possibili comportamenti criminali e antisociali.

Gli stessi documenti evidenzierebbero poi anche errori del sistema durante il test, come l’errata segnalazione dei bambini accompagnati dai genitori come evasori del biglietto.

Sempre secondo Wired, gli esperti in materia di privacy che hanno esaminato i documenti avrebbero messo in dubbio l’accuratezza degli algoritmi di riconoscimento degli oggetti e avvertito che sistemi di sorveglianza simili potrebbero facilmente essere ampliati in futuro per includere sistemi di riconoscimento facciale.

Anche se TfL non ha finora risposto alla richiesta di commenti da parte di Wired, sembrerebbe che il test abbia generato preoccupazioni riguardo alla governance e alla trasparenza nell’uso delle tecnologie di controllo, sorveglianza e di riconoscimento facciale supportate dall’AI, per le quali sarebbe necessario comunque un adeguato supporto normativo che sia in grado di stabilire i limiti entro i quali questi tool possono essere utilizzati.

Da questo punto di vista infatti è fondamentale bilanciare attentamente i rischi e i benefici dell’impiego dei tool di Intelligenza Artificiale nei sistemi di controllo e sorveglianza perché, se da un lato possono contribuire alla sicurezza dei cittadini prevenendo atti criminali o terroristici, dall’altro è imprescindibile garantire la tutela della privacy individuale e un uso etico dei dati dei cittadini.

Il MITRE ATT&CK (Adversarial Tactics, Techniques, and Common Knowledge) è un framework di conoscenza globale che fornisce un’ampia raccolta di tattiche e tecniche utilizzate dai cybercriminali durante le loro operazioni. Sviluppato e mantenuto dalla MITRE Corporation, questo framework è ampiamente utilizzato dagli esperti di sicurezza informatica per comprendere, rilevare e rispondere agli attacchi informatici.