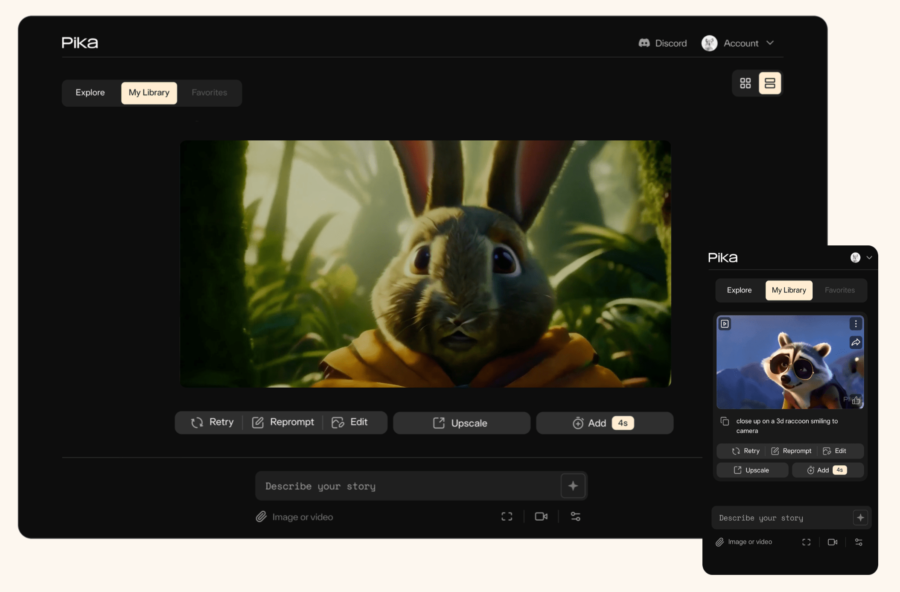

PIKA è un innovativo generatore di video basato su intelligenza artificiale che consente agli utenti di creare video a partire da testi, immagini o video esistenti. È stato lanciato da un team di sviluppatori che ha raccolto un significativo finanziamento di 55 milioni di dollari da nomi noti nel settore della tecnologia e dell’IA. Questo strumento si distingue per la sua capacità di generare e modificare video in vari stili seguendo il principio del text-to-video, rendendo la creazione video accessibile anche a chi non ha competenze tecniche.

Tag: pika

Sora è il nuovo generatore di text-to-video di OpenAI. Lo strumento, presentato giovedì scorso dall’azienda con sede a San Francisco, utilizza l’intelligenza artificiale generativa per creare istantaneamente brevi video basati su comandi scritti.

Sora non è il primo a lanciare questo tipo di tecnologia, dove sono già presenti realtà come Runway, Stable Video Diffusion, Pika e più recentemente Google con Lumiere. Tuttavia se andiamo ad analizzare i commenti dei vari esperti del settore rileviamo che sono tutti unanimi nel sottolineare l’alta qualità dei video realizzati finora e che l’introduzione di questa nuova App segni un passo avanti significativo sia per OpenAI che per il futuro della generazione di testo in video in generale.

Nel dettaglio Sora è un generatore di testo in video che crea video lunghi fino a 60 secondi in base a istruzioni scritte utilizzando l’Intelligenza Artificiale generativa. Il modello può anche generare video da un’immagine fissa esistente, tuttavia non è ancora disponibile per l’uso pubblico (OpenAI afferma che sta collaborando con politici e artisti prima di rilasciare ufficialmente lo strumento) e ci sono ancora molte cose che non sappiamo. Ma dall’annuncio di giovedì, la società ha condiviso una serie di esempi di video generati da Sora per mostrare cosa può fare e i risultati sembrano davvero impressionanti.

Contestualmente al rilascio, OpenAI ha dichiarato di essere consapevole che Sora potrebbe essere usata per produrre deepfake e disinformazione, specificando che l’azienda sta lavorando con i cosidetti “red teamer” esperti in aree come disinformazione, contenuti che incitano all’odio e pregiudizi, che testeranno il modello in modo contraddittorio, al fine di rilevare eventuali possibilità di rilevare contenuti fuorvianti. Immaginiamo quindi che non sarà possibile creare contenuti violenti o pornografici, né tantomeno riprodurre le fattezze di persone reali o lo stile di artisti famosi, come peraltro già succede per il suo generatore di immagini, Dall-E.

In ogni caso questo ulteriore passaggio evolutivo dell’AI generativa pone in capo a OpenAI una ulteriore responsabilità, non solo sul più vasto tema delle fake news che è possibile generare grazie a questi modelli ma anche dal punto di vista di eventuali problemi legati al diritto d’autore dei dati di addestramento per i quali OpenAI è già stata citata in giudizio da attori come il New York Times.