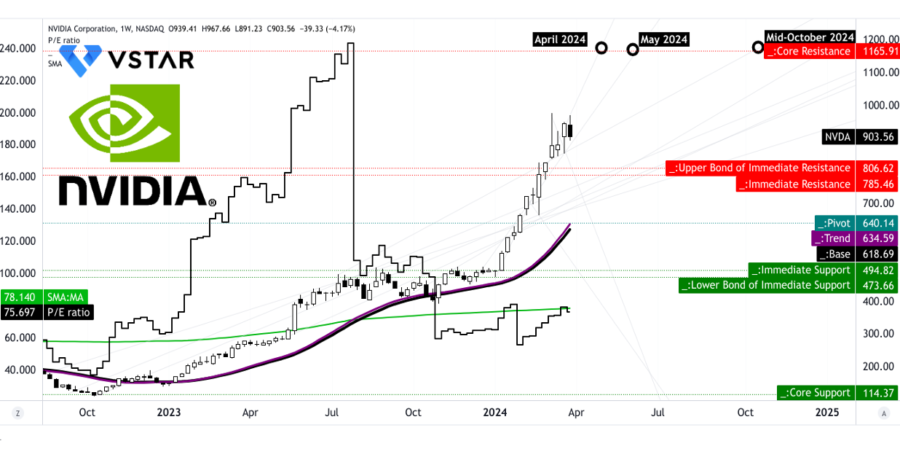

Nvidia è attualmente in trattative per acquisire Lepton AI, una startup emergente nel campo dell’intelligenza artificiale, per una cifra che si aggira intorno alle centinaia di milioni di dollari. Questa mossa strategica segue l’acquisizione di Gretel, specializzata nella generazione di dati sintetici, sottolineando l’impegno di Nvidia nel rafforzare il suo ecosistema AI.

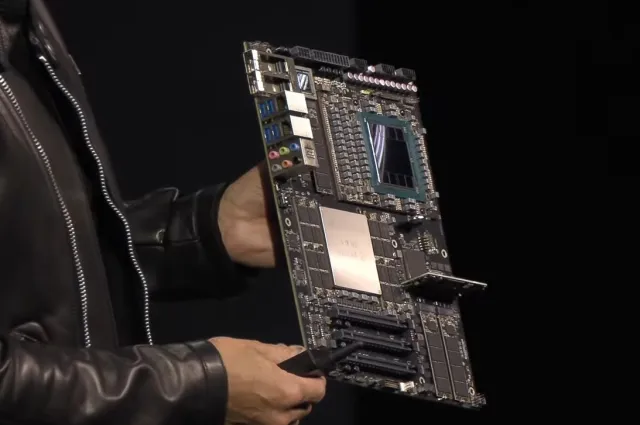

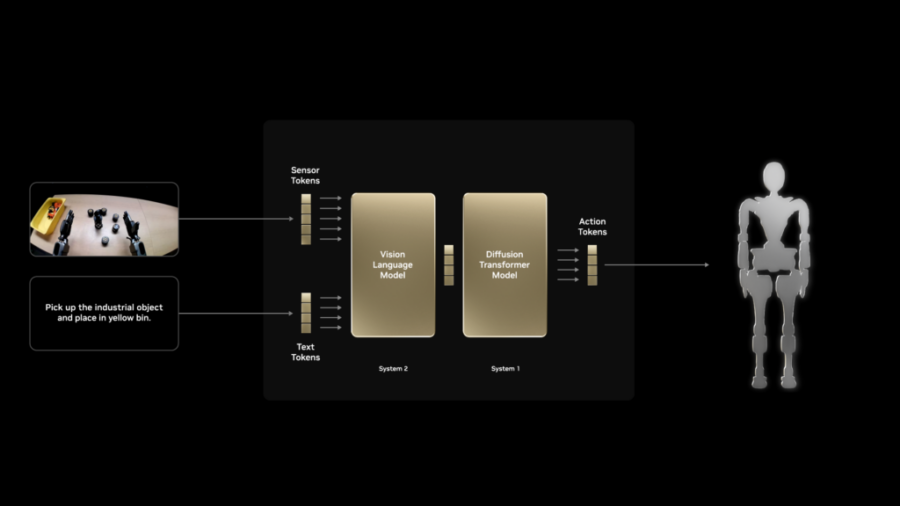

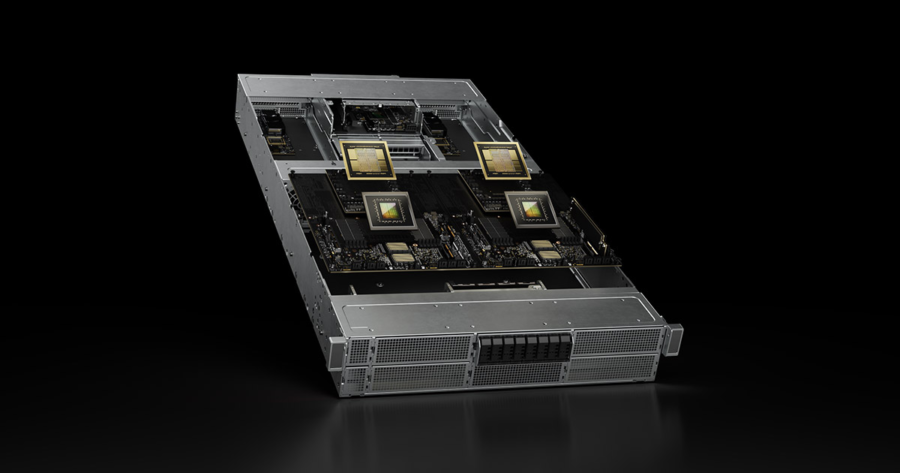

Lepton AI, fondata due anni fa, offre una piattaforma software AI cloud-native che fornisce accesso on-demand alle GPU NVIDIA Blackwell B200, ottimizzando l’orchestrazione dei carichi di lavoro per accelerare sia l’inferenza che l’addestramento. La piattaforma di Lepton si integra perfettamente con le soluzioni NVIDIA, offrendo agli utenti un’esperienza fluida e altamente efficiente.