La crescente diffusione di modelli di intelligenza artificiale (IA) come quelli sviluppati da OpenAI ha reso necessario l’impiego di sofisticati sistemi di moderazione per garantire un uso responsabile e sicuro di queste tecnologie. OpenAI ha implementato un modello di moderazione che categorizza i contenuti potenzialmente dannosi o inappropriati in diverse categorie, con l’obiettivo di identificare e prevenire violazioni delle proprie policy d’uso.

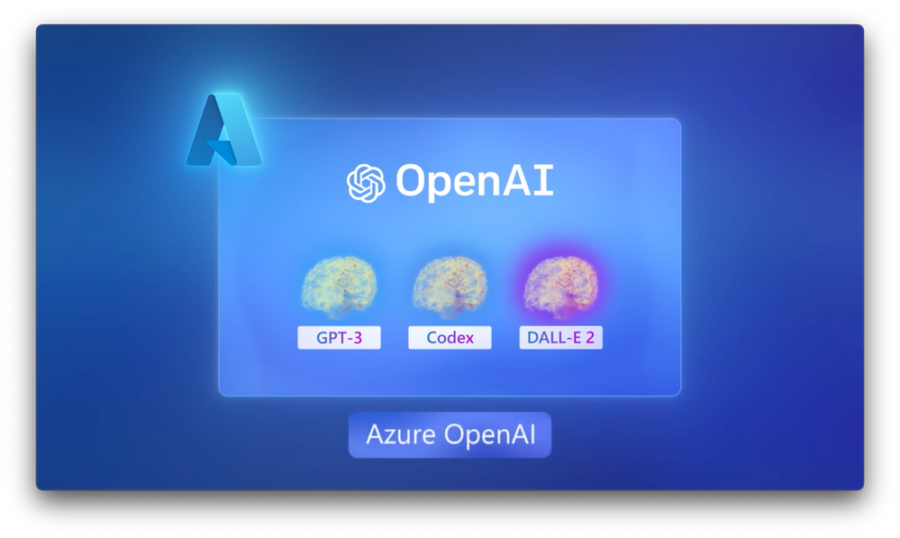

Servizio OpenAI di Azure include un sistema di filtro dei contenuti che funziona insieme a modelli di base, inclusi i modelli di generazione immagini DALL-E. Questo sistema funziona eseguendo sia la richiesta che il completamento tramite un insieme di modelli di classificazione concepiti per rilevare e impedire l’output di contenuti dannosi. Il sistema di filtro del contenuto rileva e agisce su categorie specifiche di contenuto potenzialmente dannoso sia nelle richieste di input che nei completamenti di output. Le variazioni nelle configurazioni dell’API e nella progettazione dell’applicazione potrebbero influire sui completamenti e quindi sul comportamento di filtro.

Questo articolo fornisce una panoramica scientifica delle categorie di moderazione impiegate da OpenAI, analizzando la loro funzione, efficacia e limitazioni.