“Il nucleare sta tornando in tutto il mondo”. Lo ha detto in questi giorni la commissaria Ue all’Energia Kadri Simson.

L’ Agenzia internazionale dell’energia faceva riferimento a “Una nuova alba per l’energia nucleare” nel report annuale del 2022 anno in cui l’Europa ha inserito questa risorsa assieme al gas tra quelle da utilizzare nella transizione energetica.

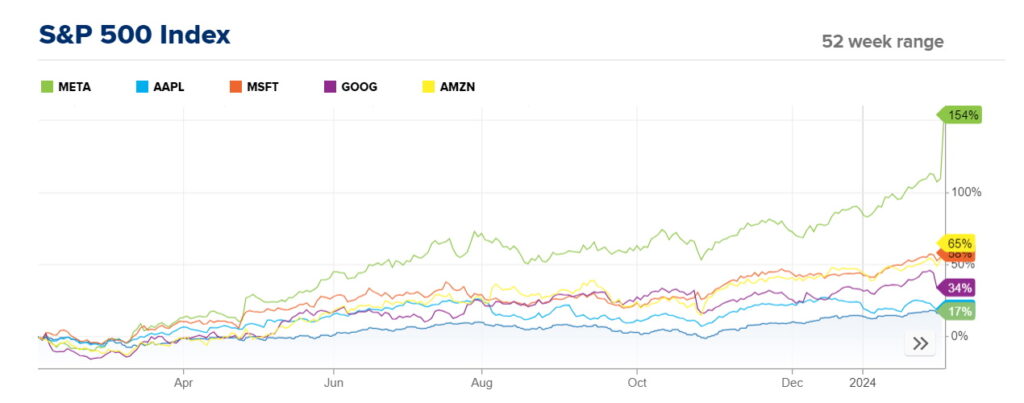

Dall’altra parte dell’atlantico le manovre strategiche di Microsoft nello spazio dell’intelligenza artificiale vanno ben oltre l’aiutare OpenAI a creare chatbot migliori in modo che possano vendere le licenze di Office 365 Co-Pilot.

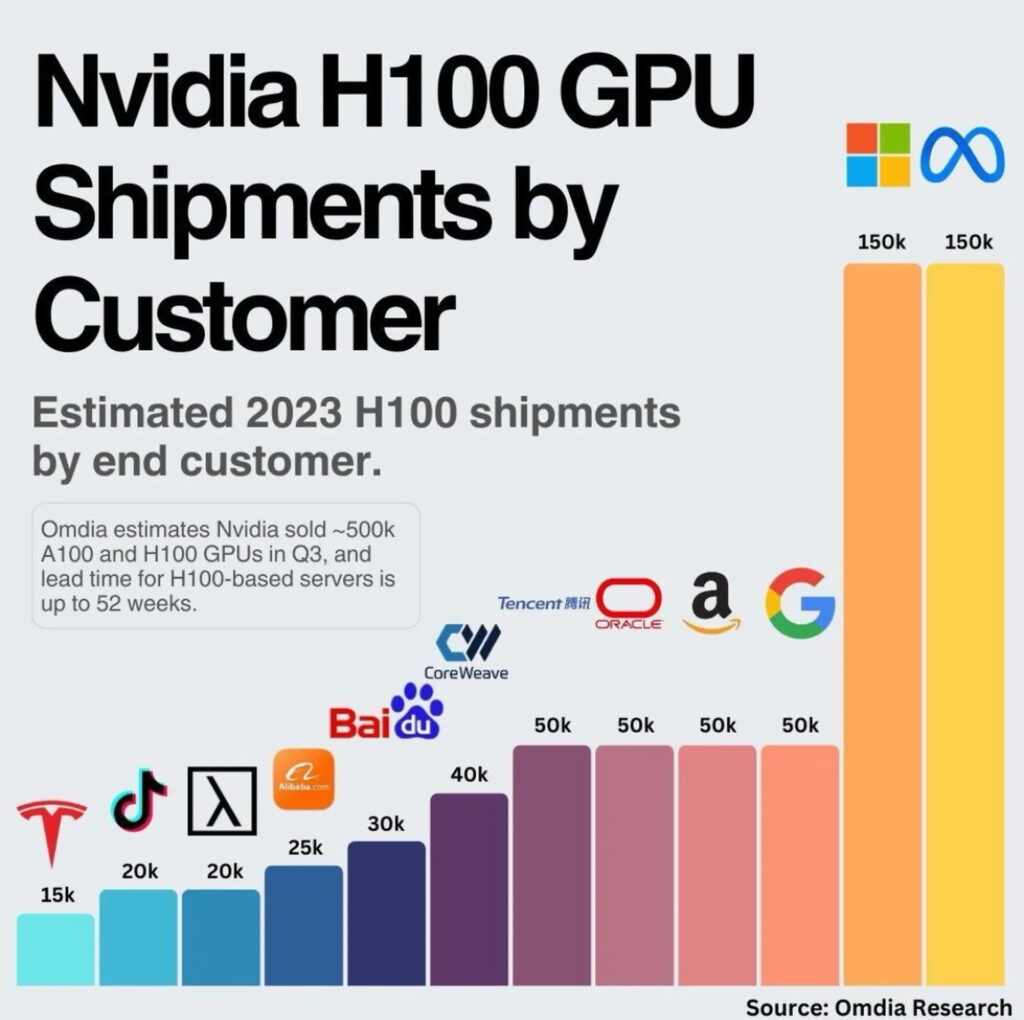

Mentre si rafforza la loro partnership con OpenAI e le loro alleanze si fanno sempre più profonde assistiamo anche a una trasformazione dell’infrastruttura, con Microsoft che investe pesantemente nell’energia nucleare (attraverso una società in portafoglio di Sam Altman Helion) per sostenere i suoi ampi data center creando una nuova business unit cloud competitiva che ha la promessa di offrire un insieme unico di servizi.

Bill Gates ha anche avviato un incubatore per progetti SMR chiamato TerraPower. Tuttavia, TerraPower “non ha attualmente alcun accordo per la vendita di reattori a Microsoft”, secondo una dichiarazione alla CNBC .

Sebbene Azure con OpenAI sia fondamentale, i costi diventeranno un problema.

Secondo quanto riferito, Sam Altman sta cercando di chiedere a Microsoft maggiori finanziamenti per gestire OpenAI poiché i costi per addestrare i modelli di intelligenza artificiale sono aumentati vertiginosamente.

Una parte importante di questo costo è l’elettricità. L’energia rappresenta il 60-70% dei costi di gestione di un data center. Se Microsoft riesce a ridurre questi costi (sia per OpenAI che per i suoi clienti), otterrà un enorme vantaggio in termini di prezzi che potrà offrire ai propri clienti finali.

Inoltre, Microsoft ha firmato una partnership con l’operatore della centrale nucleare con sede in Virginia Constellation Energy per portare l’energia nucleare nei propri data center, dimostrando l’impegno di Microsoft nel ridurre la propria impronta di carbonio e nell’innovazione nel settore energetico.

Ad esempio, in questa partnership, un data center a Boydton, in Virginia, avrà fino al 35% della sua energia fornita dall’energia nucleare.

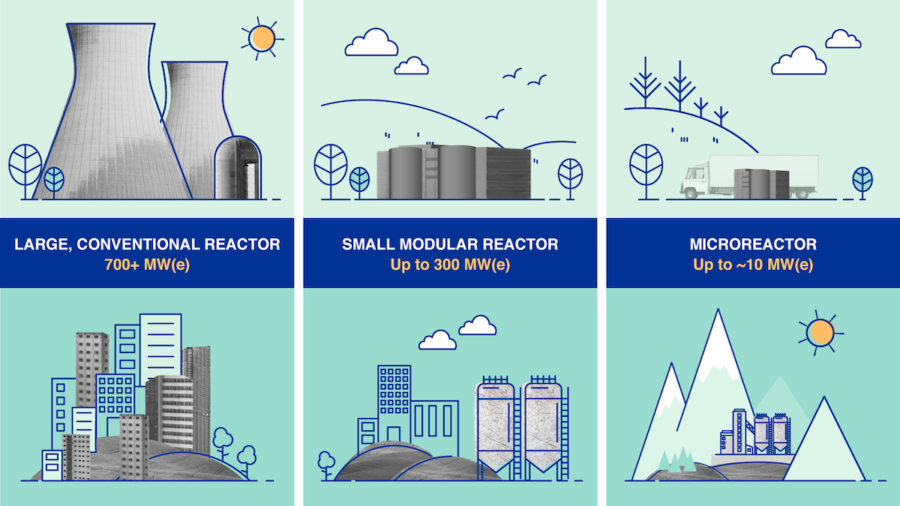

Questa strategia prevede l’adozione di piccoli reattori modulari (SMR), che rappresentano una potenziale soluzione ai limiti di potenza delle crescenti operazioni dei data center. In italia ci stanno lavorando Enea e Ansaldo Nucleare .

Gli SMR usano le scorie come combustibile per reattori. Sulla quarta generazione e sugli Smr si sta muovendo per esempio Enel che collabora con Newcleo, società italiana con sede a Londra.

In effetti, Microsoft sta assumendo attivamente esperti in tecnologia nucleare per implementare una strategia globale per l’energia SMR e microreattori per supportare le esigenze energetiche sia del cloud che dell’intelligenza artificiale di Microsoft.

Gli effetti di questo passaggio sono grandi. L’energia nucleare rappresenta solo il 50-70% del costo dell’energia da carbone (già considerata attualmente una delle fonti di elettricità più economiche).

Ci vuole molto capitale in anticipo per costruire una centrale nucleare (che si tratti di un SMR o di una centrale elettrica completa), ma per Microsoft il risparmio potrebbe valere miliardi di dollari per i propri data center.

Ciò significa realizzare una delle più rapide crescite di software o piattaforme aziendali mai viste (da dimostrare), oltre a riprogettare un nuovo alimentatore per gestire molti dei loro data center che alimenteranno il sistema ChatGPT/API di OpenAI a un costo molto più conveniente.!

Giovedì 9 marzo Eni ha firmato un accordo di cooperazione tecnologica con Commonwealth Fusion Systems, spinout dell’Mit. Obiettivo: accelerare l’industrializzazione dell’energia da fusione e non da fissione, ha un obiettivo ambizioso: realizzare nel 2025 il primo impianto pilota a confinamento magnetico, ed entro il 2035, costruire la prima centrale elettrica industriale in grado di immettere elettricità nella rete.

Il 6 Marzo Edf, Edison e Ansaldo hanno sottoscritto una lettera di intenti per collaborare allo sviluppo del nuovo nucleare in Europa, per favorirne la diffusione anche in Italia.

La sfida è complessa, sia dal punto di vista tecnico che da quello economico: nelle stesse ore dell’annuncio sono andati in fumo i piani della statunitense NuScale di costruire il primo reattore Smr sul suolo americano.