Nel gioco di potere dei Large Language Model, dove fino a ieri vinceva chi aveva la rete neurale più gonfia e il datacenter più affamato, Microsoft cala un jolly cinico e sorprendentemente umile: BitNet b1.58 2B4T, il primo LLM nativo a 1 bit, che anziché urlare “più grande è meglio”, sussurra qualcosa di molto più inquietante per i rivali: “più piccolo può batterti comunque”. Con 2 miliardi di parametri — roba che una volta avremmo definito mid-size — questo modello è un capolavoro di ottimizzazione brutale. E sì, “nativo a 1 bit” significa esattamente quello che sembra: la rete usa solo -1, 0 e 1 per rappresentare i pesi.

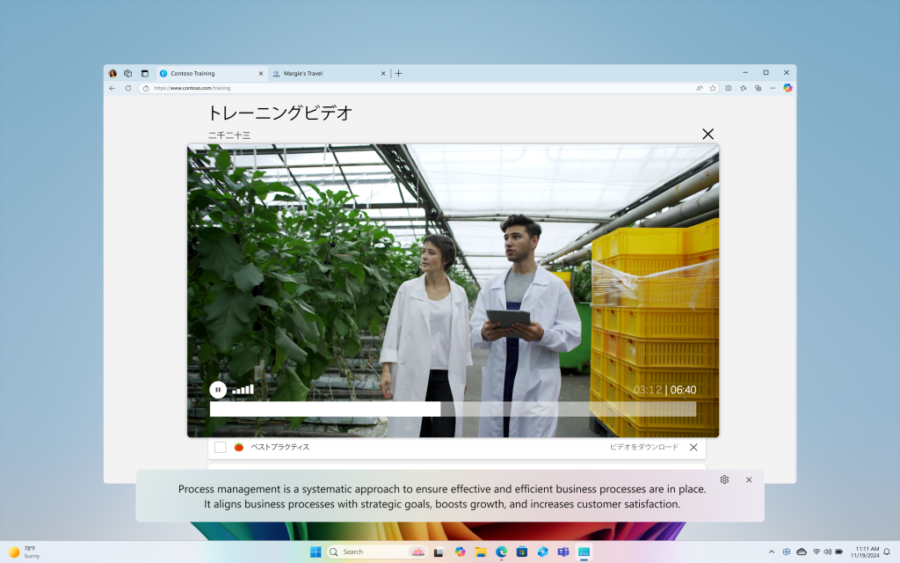

Dietro c’è un’idea tanto banale quanto rivoluzionaria: se riesci a riscrivere le fondamenta stesse della matematica neurale senza distruggere le performance, puoi infilare l’intelligenza artificiale ovunque. Non più solo in GPU da 10.000 dollari, ma anche nel laptop aziendale del 2018, o nel frigorifero smart di domani mattina.