Martedì la Commissione europea ha dichiarato che sta indagando su Meta Platforms per una potenziale violazione del Digital Services Act sulla base del fatto che non è riuscita a liberare Facebook e Instagram da “pubblicità ingannevoli e disinformazione”.

La CE ritiene che Meta non rispetti gli obblighi DSA “relativi alla diffusione di pubblicità ingannevoli, campagne di disinformazione e comportamenti non autentici coordinati nell’UE”.

L’indagine si concentrerà anche sui contenuti politici e sulla mancanza di disponibilità di uno strumento di monitoraggio in tempo reale “efficace” di terze parti in vista delle imminenti elezioni del Parlamento europeo e di altre elezioni nel blocco.

“Se non possiamo essere sicuri di poterci fidare dei contenuti che vediamo online, c’è il rischio di finire per non credere a nulla”, ha affermato in una nota la vicepresidente esecutiva della Commissione europea Margrethe Vestager .

“La pubblicità ingannevole rappresenta un rischio per il nostro dibattito online e, in ultima analisi, per i nostri diritti sia come consumatori che come cittadini. Sospettiamo che la moderazione di Meta sia insufficiente, che manchi di trasparenza nella pubblicità e nelle procedure di moderazione dei contenuti. Quindi oggi abbiamo aperto un procedimento contro Meta per valutare la loro conformità con la legge sui servizi digitali.”

La Commissione ha incaricato Meta di “adottare rapidamente tutte le azioni necessarie per garantire un efficace controllo pubblico in tempo reale del suo servizio, fornendo un accesso adeguato a ricercatori, giornalisti e funzionari elettorali agli strumenti di monitoraggio in tempo reale dei contenuti ospitati sui suoi servizi”.

L’azienda guidata da Mark Zuckerberg è inoltre invitata a rispondere entro cinque giorni lavorativi alle richieste di informazioni su come risolvere i problemi.

La direttiva fa parte del Digital Services Act, che è stato pubblicato nell’ottobre 2022 e ha concesso alle aziende tempo fino a gennaio 2024 per adeguarsi.

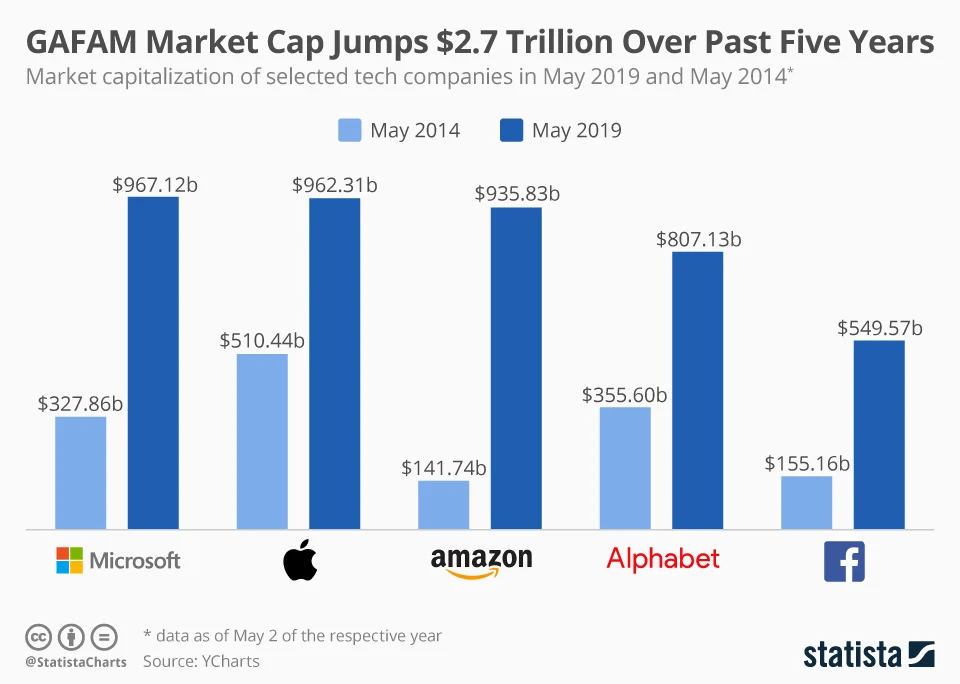

Il Digital Services Act ha costretto aziende come Meta, X (precedentemente nota come Twitter) e Google a dire alle autorità di regolamentazione esattamente cosa stanno facendo per combattere la disinformazione online e liberare rapidamente le loro piattaforme da contenuti illegali, come l’incitamento a terrorismo e abusi sessuali sui minori.

La notizia dell’indagine è stata riportata da Rivista.AI all’inizio di questa settimana, con particolare attenzione alle campagne di disinformazione provenienti dalla Russia e da altri paesi.

Iscriviti alla nostra newsletter settimanale per non perdere le ultime notizie sull’Intelligenza Artificiale.

[newsletter_form type=”minimal”]