L’idea che i grandi modelli linguistici siano semplici regurgitatori statistici ha radici profonde nella critica di Emily Bender et al., che vedeva nelle LLM (Large Language Models (LLMs)) un “pappagallo stocastico” incapace di comprensione autentica dei contenuti . Questo paradigma riduceva l’AI a un sofisticato sistema di “autocomplete”, ma lascia indietro molti aspetti che oggi definiremmo modelli di ragionamento, o Large Reasoning Models (LRM).

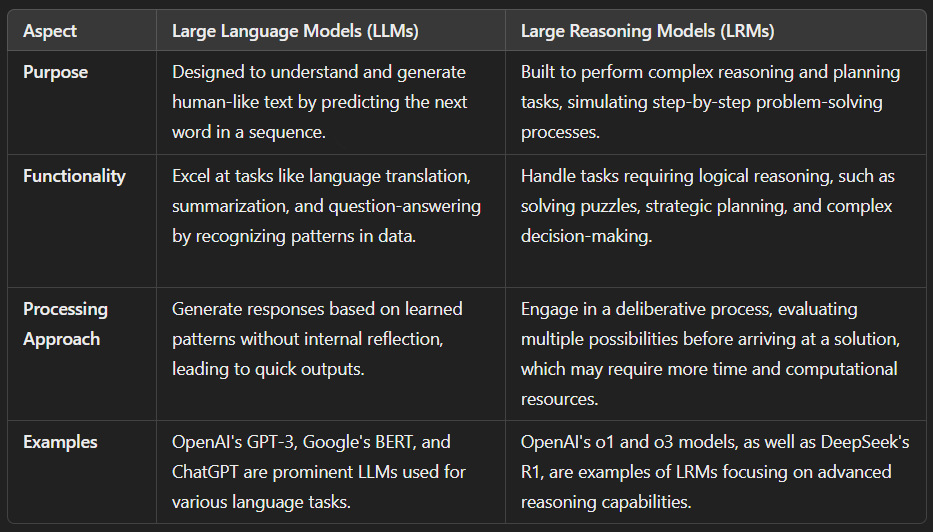

Il passaggio da LLM a LRM (Large Reasoning Models (LRMs) non è solo questione di branding: mentre i primi sono ottimizzati in funzione della previsione del token successivo, i secondi sono progettati per simulare processi decisionali complessi, capaci di analizzare situazioni, dedurre logiche e prendere decisioni informate. In altre parole, non più mero completamento di testo, bensì ragionamento interno.