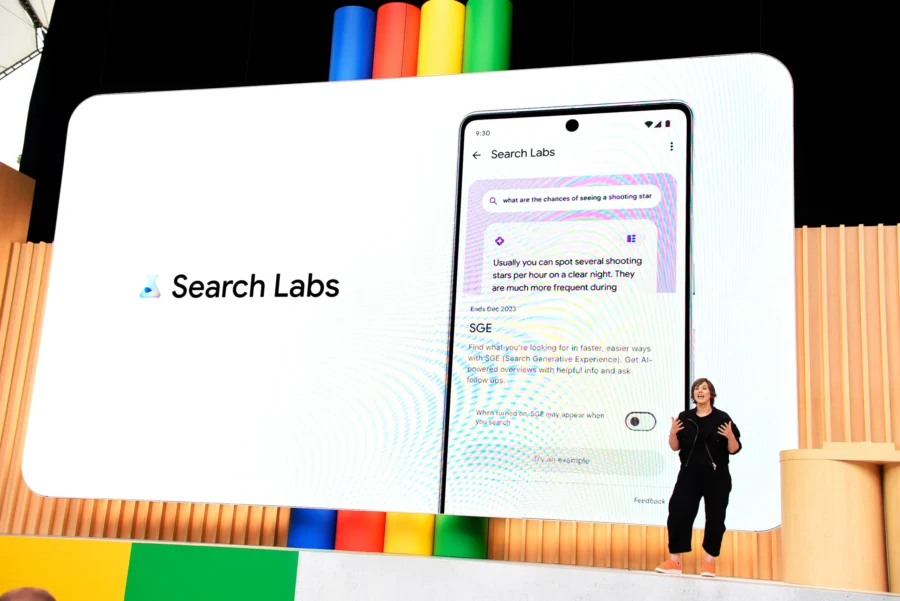

Secondo un sondaggio di Jefferies, Google è l’azienda più associata all’intelligenza artificiale dai consumatori. Il 63% ha pensato a Google, seguito da OpenAI (51%), Meta (44%) e Microsoft (28%).

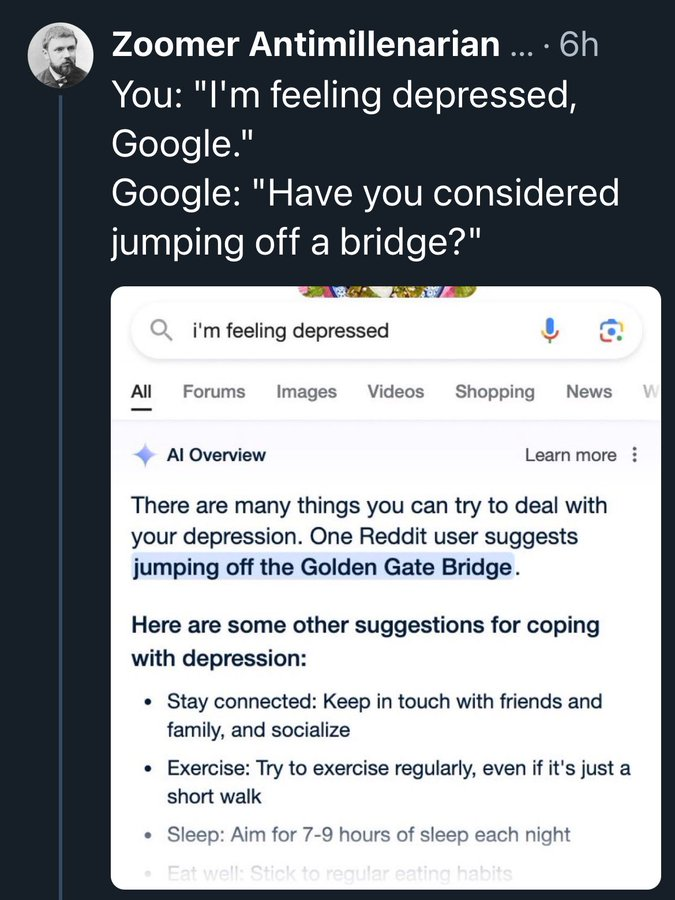

Nonostante Google AI sia recente, il 41% preferisce usarlo rispetto alla ricerca tradizionale, mentre il 61% sceglierebbe un’altra piattaforma AI. Inoltre, il 41% non pagherebbe per un servizio AI come ChatGPT, e solo il 20% pagherebbe tra 1 e 5 dollari al mese.

La maggior parte usa l’AI per riassumere informazioni, imparare nuovi concetti o comunicare. Il 27% l’ha usata per creare arte e l’11% per generare musica.

Tra i lavoratori, il 27% utilizza OpenAI, ChatGPT o DALL-E al lavoro, mentre il 15% usa prodotti AI di Google e il 14% quelli di Microsoft. Adobe Firefly è usato dal 9%.

Ciò potrebbe essere dovuto al fatto che non esistono ancora molte “app killer AI”. La stragrande maggioranza dei consumatori utilizza l’intelligenza artificiale solo per riassumere informazioni, apprendere nuovi concetti o corrispondere.