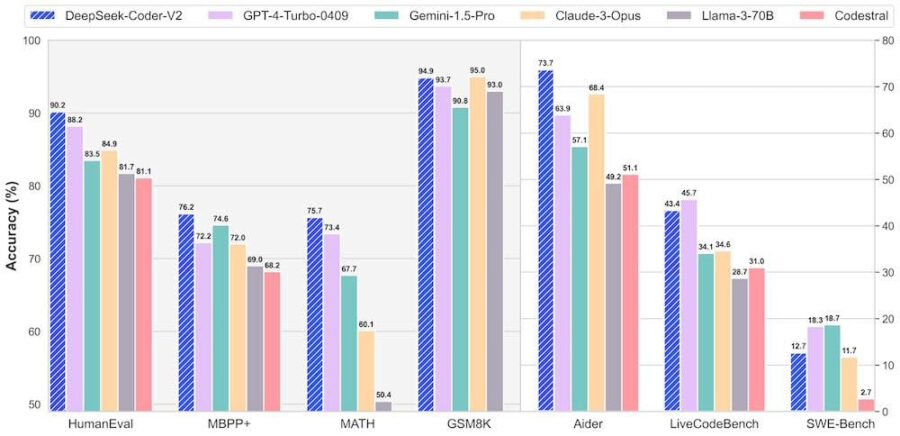

DeepSeek-Coder-V2 è un modello di linguaggio di codifica open source basato su una Mixture-of-Experts (MoE), che raggiunge prestazioni paragonabili a GPT4-Turbo nei compiti specifici del codice.

Il modello è stato ulteriormente pre-addestrato a partire da DeepSeek-Coder-V2-Base con 6 trilioni di token provenienti da un corpus di alta qualità e multi-sorgente.