Non so voi, ma io ho sempre avuto un rapporto complicato con i telefoni. Da piccolo, ogni volta che il telefono squillava, mi chiedevo se fosse una buona notizia o un parente che voleva raccontarmi l’ennesima storia del loro gatto malato. Ora, nel 2025, sembra che i telefoni abbiano preso una piega più personale: non solo interrompono le chiamate a caso, ma lo fanno con l’arroganza di chi sa che non li cambierai comunque.

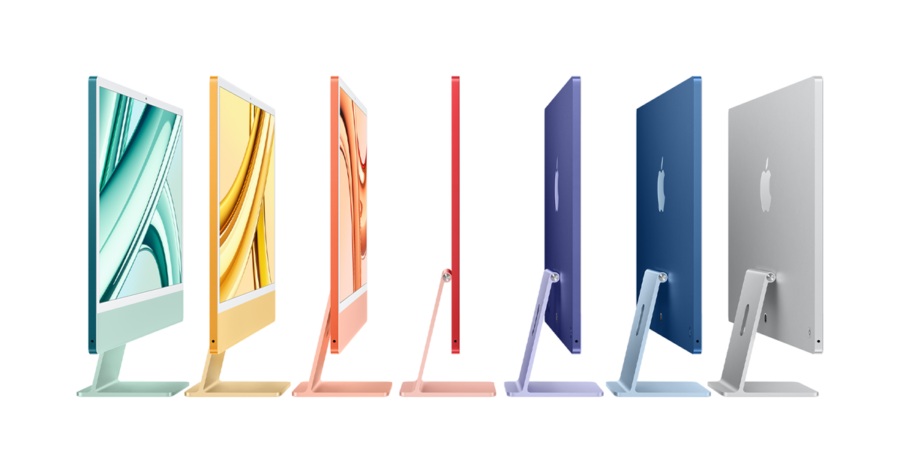

Prendiamo Apple, per esempio. Quelli che riescono a farti comprare lo stesso telefono con un colore diverso e un nome diverso ogni anno. Beh, ora pare che il loro grande piano sia di progettare un modem interno per alcuni dei loro modelli futuri, inclusi l’iPhone SE e il prossimo iPhone ultra-sottile. Sì, perché se c’è una cosa che vogliamo da un telefono è che sia più sottile, così sottile da poterlo perdere nel divano.