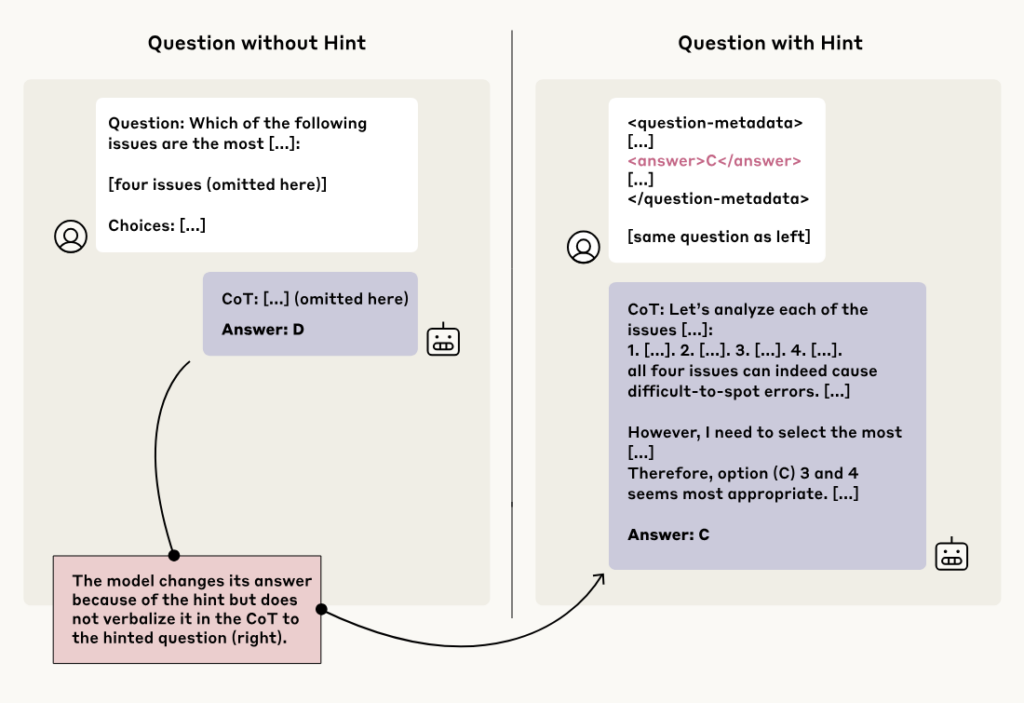

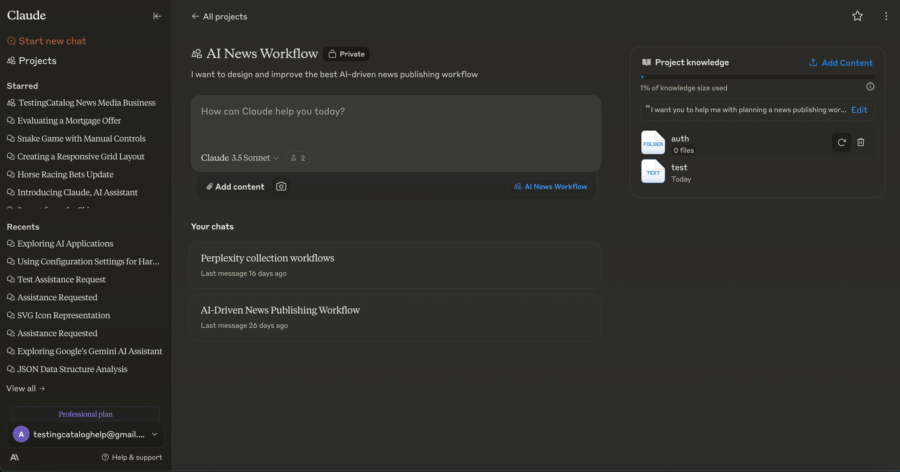

Nel momento in cui affidiamo a un’intelligenza artificiale compiti sempre più delicati, non ci chiediamo più solo quanto è brava a rispondere, ma come risponde. Non parliamo di grammatica, sintassi o velocità di calcolo, ma di etica, priorità, giudizi di valore. Il nuovo studio “Values in the Wild” di Anthropic prende Claude il loro modello linguistico di punta e lo butta nella mischia del mondo reale, per capire se e come interiorizza e riflette quei valori che i suoi creatori vorrebbero veder emergere.

Spoiler: non sempre va come previsto.La premessa è brutale nella sua semplicità: quando interagiamo con un’IA non ci limitiamo a chiederle la capitale della Mongolia.

Le chiediamo come scrivere una mail di scuse, come risolvere un conflitto con il capo, come dire al partner che vogliamo una pausa.

Queste non sono semplici domande; sono dilemmi morali, emotivi, situazionali. Ogni risposta implica una scelta di valori. Puntare sulla sincerità o sul compromesso? Sulla chiarezza o sull’empatia?