Notizie dagli USA.

La recente nomina di Scale AI come primo valutatore terzo autorizzato dall’Istituto per la Sicurezza dell’Intelligenza Artificiale degli Stati Uniti (AISI) rappresenta un passo significativo verso una maggiore sicurezza e affidabilità nello sviluppo dei modelli di intelligenza artificiale.

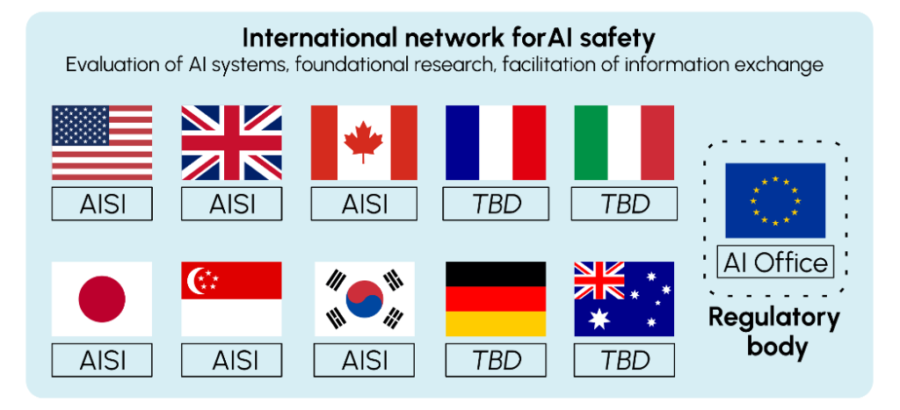

Questa collaborazione mira a sviluppare metodi avanzati per testare i modelli di frontiera dell’IA, includendo valutazioni congiunte tra l’AISI e il Safety, Evaluation, and Alignment Lab (SEAL) di Scale AI. Attraverso questi metodi, i costruttori di modelli di diverse dimensioni potranno accedere volontariamente a nuove forme di test affidabili, con la possibilità di condividere i risultati con una rete globale di istituti di sicurezza dell’IA.

Questa partnership non solo rafforza la posizione di Scale AI nel panorama dell’IA, ma suggerisce anche una visione ottimistica per il futuro dell’AISI. È improbabile che Scale AI avrebbe intrapreso questo accordo se ci fossero stati dubbi sulla stabilità o sulla continuazione dell’istituto, indipendentemente dalle dinamiche politiche attuali o future.