Alla luce dell’intensificarsi dei preparativi per le imminenti Olimpiadi di Parigi, l’integrazione dell’Intelligenza Artificiale nei sistemi di sorveglianza stradale in tempo reale ha acceso, in Francia e non solo, un acceso dibattito sulle libertà civili e le preoccupazioni per la sicurezza.

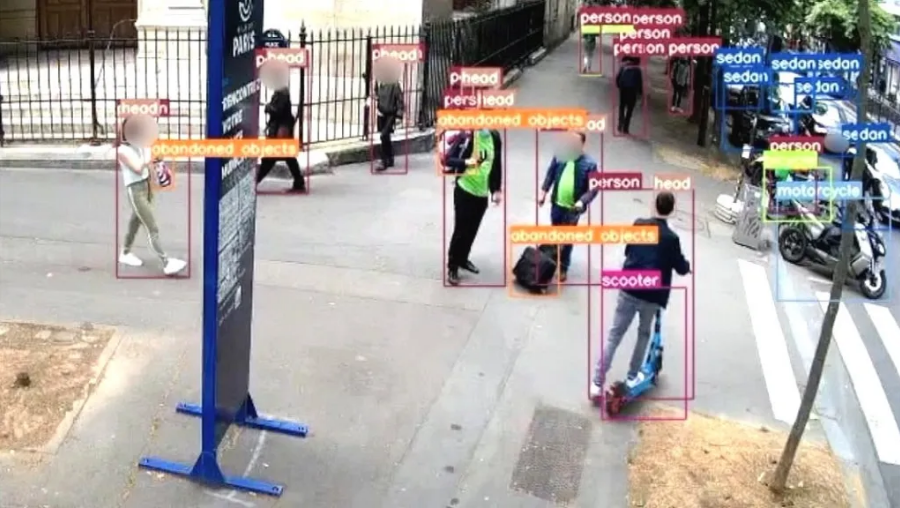

In base ai piani, avanzati algoritmi di Intelligenza Artificiale saranno dispiegati attraverso le telecamere CCTV in tutta Parigi, mirati a rilevare attività sospette come bagagli abbandonati e folle inaspettate. Mentre i i gruppi per i diritti civili esprimono preoccupazioni riguardo all’eventuale violazione delle libertà individuali, i sostenitori argomentano che tali misure siano cruciali per garantire la sicurezza pubblica durante eventi di rilievo.

Il quadro normativo che consente la video sorveglianaza algoritmica è contenuto nell’articolo 7 della Legge sui Giochi Olimpici, approvato dall’Assemblea Nazionale con 59 voti favorevoli e 14 contrari, che autorizza l’uso della cosiddetta videosorveglianza “intelligente” , basata su algoritmi per analizzare le immagini catturate da telecamere o droni, al fine di rilevare automaticamente azioni e azioni potenzialmente rischiose.

Secondo la formulazione dell’articolo, le immagini ottenute avranno il solo scopo di rilevare “in tempo reale eventi predeterminati idonei a manifestare o rivelare tali rischi e di segnalarli”, mentre il riconoscimento facciale non sembrerebbe autorizzato.

Tuttavia, lo scetticismo persiste tra coloro che sostengono che la videosorveglianza alimentata dall’AI, anche senza il riconoscimento facciale, costituisca una significativa minaccia alla privacy e all’autonomia personale per il rischio che tali tecnologie possano consentire una sorveglianza di massa, erodendo i diritti degli individui all’anonimato e alla libertà di movimento negli spazi pubblici.

L’introduzione di tale tecnologia rappresenta comunque una novità nel continente europeo. In una lettera aperta, 38 organizzazioni europee della società civile sostengono che l’uso generalizzato della videosorveglianza guidata da algoritmi presenta un rischio significativo per le libertà individuali e civili e viola il diritto internazionale sui diritti umani.

Mentre il governo francese naviga in un equilibrio delicato tra la sicurezza e le libertà civili, ancora una volta la questione mette in evidenza l’importanza delle considerazioni etiche nell’adozione dei sistemi di AI che toccano temi come la privacy e le libertà individuali, che stanno plasmando i discorsi pubblici in vista delle Olimpiadi di Parigi.

L’uso della tecnologia di sorveglianza automatizzata è un tema controverso, proprio per il rischio che l’integrazione dell’Intelligenza Artificiale possa rappresentare una nuova transizione nella sorveglianza di massa delle popolazioni civili. Questo perché l’uso di algoritmi nella videosorveglianza significa che il comportamento di chiunque venga filmato in uno spazio pubblico è costantemente analizzato e da qui al riconoscimento biometrico e facciale il passo è breve. Quello che è certo è che occorre trovare il giusto equilibrio tra i rischi per la sicurezza e la limitazione delle libertà civili.