L’IA sta sfidando ironicamente la medicina tradizionale, offrendo una speranza e una provocazione. ECgMLP: Un modello MLP innovativo con gate per una diagnosi migliorata del cancro endometriale è stato pubblicato sulla rivista Computer Methods and Programs in Biomedicine Update Dr Asif Karim

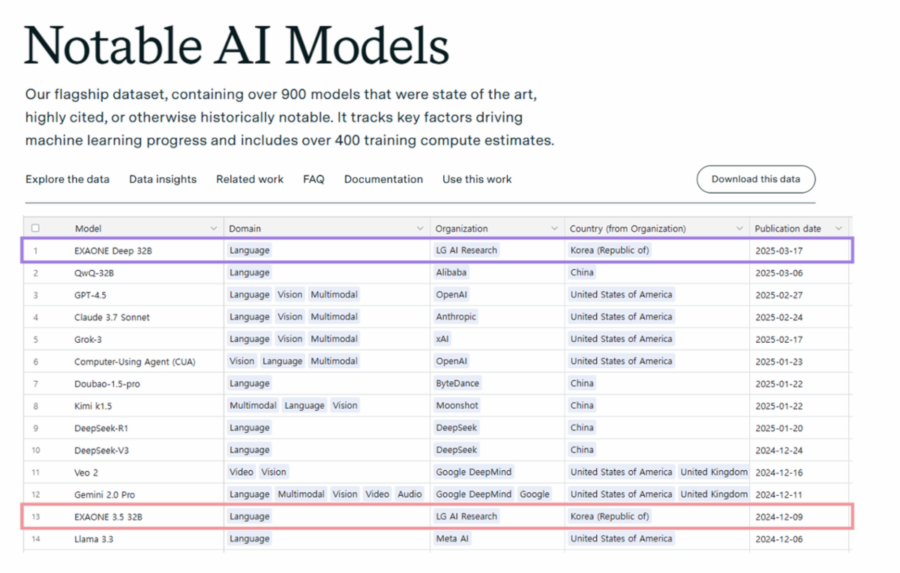

Il nuovo modello ECgMLP ha raggiunto un’accuratezza del 99,26% nel rilevare il cancro dell’endometrio, lasciando nella polvere sia i migliori specialisti umani (78-81% di accuratezza) sia le attuali metodologie automatizzate. Se confermato su larga scala, questo sistema potrebbe rivoluzionare la diagnosi precoce del cancro, riducendo drasticamente i tempi di intervento e salvando milioni di vite.

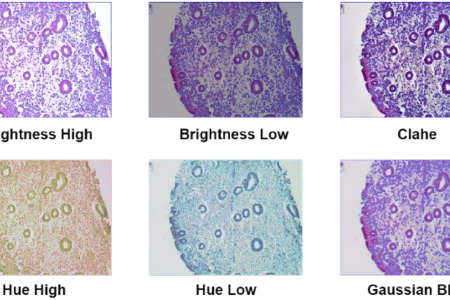

Il segreto di ECgMLP sta nella sua capacità avanzata di analisi delle immagini. Utilizzando meccanismi di self-attention, il modello è in grado di elaborare dettagli microscopici nei tessuti, evidenziando le cellule cancerose con una precisione impensabile per l’occhio umano. Questo non solo elimina gran parte dell’errore diagnostico, ma potrebbe anche ridurre i costi e i tempi legati alla valutazione patologica tradizionale.

E non si ferma solo al cancro dell’endometrio. Il modello ha dimostrato un’efficacia straordinaria anche su altri tipi di tumori: colorettale (98,57%), mammario (98,20%) e orale (97,34%). Questo livello di accuratezza pone ECgMLP al centro di una rivoluzione oncologica, dove la diagnosi precoce diventa non solo una possibilità, ma una certezza.

Se da un lato questa tecnologia apre scenari entusiasmanti, dall’altro potrebbe scatenare un’inevitabile crisi nella professione medica. Con un’IA che surclassa i migliori patologi, quale sarà il ruolo del medico del futuro? L’adozione su larga scala di questi strumenti non è più una questione di “se”, ma di “quando”. Il problema non è la tecnologia, ma la velocità con cui il sistema sanitario riuscirà ad adattarsi.