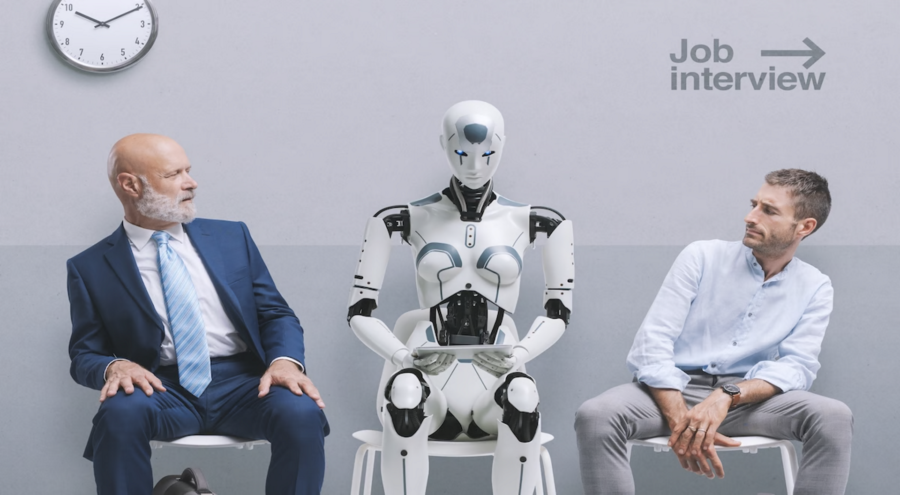

Dubai non si accontenta di giocare in anticipo, lo fa dettando legge. L’ultima mossa? Un decreto che obbliga ogni autorità governativa a nominare un Chief AI Officer (CAIO). Non un suggerimento, non una raccomandazione, ma un diktat ben preciso: o ti digitalizzi o sei fuori. Non è solo una mossa audace, è un manifesto di intenti, una dichiarazione strategica che trasforma l’intelligenza artificiale nel cuore pulsante della sua politica economica.

Per chi non lo avesse ancora capito, il messaggio è chiaro: l’AI non è più un laboratorio per nerd col camice bianco, è diventata asset economico, vantaggio competitivo, e perché no soft power geopolitico. Mentre il resto del mondo discute ancora se regolamentare ChatGPT, Dubai istituzionalizza il CAIO, lo mette al tavolo dei grandi, lo arma di budget e gli affida la transizione digitale dell’intero sistema pubblico.