OpenAI ha appena pubblicato una scheda tecnica di 33 pagine dedicata al modello GPT-4o, svelando dettagli significativi su capacità, sicurezza e ambiti di utilizzo che lo collocano tra le innovazioni più avanzate nel campo dell’intelligenza artificiale. Questo aggiornamento va ben oltre le funzionalità delle versioni precedenti e offre uno spaccato delle nuove potenzialità del modello, inclusa una simulazione quasi perfetta della rapidità e fluidità della conversazione umana, con un tempo di risposta di appena 320 millisecondi.

Categoria: Sicurezza Pagina 3 di 4

Cybersecurity, Data Protection, Difesa, Aerospazio, Settori Strategici e Analisi Predittiva

L’amministrazione Biden ha recentemente rilasciato un memorandum sulla sicurezza nazionale, strutturato per affrontare i rischi emergenti nell’uso dell’intelligenza artificiale (IA) da parte delle agenzie federali e delle aziende private. Questo memorandum si fonda su un ordine esecutivo emesso nell’ottobre 2023, e mira a creare una collaborazione più stretta tra il governo e il settore privato, enfatizzando la necessità di prevenire l’uso dell’IA per scopi pericolosi, tra cui lo sviluppo di armi di distruzione di massa o attacchi autonomi.

Possiamo immaginare alcuni leader come proprietari di una casa senza serratura. Non si rendono conto che la loro sicurezza è compromessa e che un’apertura così evidente attira intrusi. Senza un’adeguata protezione delle informazioni e dei sistemi, è facile per malintenzionati entrare e mettere in pericolo non solo la privacy individuale, ma anche l’intero sistema politico. Proprio come un proprietario deve garantire che la propria casa sia sicura, così i leader devono impegnarsi a proteggere le loro informazioni e a rafforzare le misure di sicurezza per prevenire accessi indesiderati.

Recenti rivelazioni hanno messo in luce una situazione allarmante che coinvolge non solo la sicurezza nazionale, ma anche la privacy e la riservatezza dei più alti rappresentanti dello Stato. L’inchiesta condotta dalla Direzione Distrettuale Antimafia (DDA) di Milano e dalla Procura Nazionale Antimafia ha svelato un sofisticato sistema di spionaggio industriale e dossieraggio abusivo, orchestrato da una rete di hacker. Tra i dettagli più inquietanti, la possibile violazione dell’email del Presidente della Repubblica, Sergio Mattarella, segna una nuova frontiera nella violazione della sicurezza istituzionale in Italia.

Gli Stati Uniti e il Canada stanno rafforzando le difese contro potenziali minacce cyber attribuite ad attori sponsorizzati dalla Cina, mirate a infrastrutture critiche e istituzioni democratiche. Dopo che l’FBI ha rilevato attività sospette nei confronti del settore delle telecomunicazioni, la Cybersecurity and Infrastructure Security Agency (CISA) ha collaborato strettamente con le aziende colpite, offrendo assistenza tecnica e condividendo rapidamente informazioni per prevenire ulteriori attacchi.

L’indagine sul prelievo di migliaia di informazioni sensibili da banche dati strategiche nazionali condotta dalla Procura di Milano e dalla Direzione nazionale antimafia, che ha portato al momento a sei misure cautelari, sembra allargarsi in modo imprevedibile, tant’è che il procuratore antimafia Melillo parla di “vicenda allarmante” e di “dimensione imprenditoriale” del fenomeno.

Con un passo strategico verso l’open innovation, Fincantieri, uno dei leader mondiali nella costruzione di navi ad alta intensità tecnologica, ha annunciato l’apertura di una nuova Innovation Antenna presso il Mind the Bridge Innovation Center a San Francisco. L’iniziativa, che colloca l’azienda italiana nel cuore della Silicon Valley, conferma il suo impegno nel creare un ecosistema dove tecnologie Dual-Use, applicabili quindi sia nel settore civile che in quello militare, possano trovare terreno fertile e svilupparsi attraverso collaborazioni e sinergie. Gli ambiti di sviluppo riguardano principalmente l’Intelligenza Artificiale, la cyber security, l’automazione e la robotica, settori in cui la convergenza tra applicazioni civili e militari è particolarmente marcata.

L’amministrazione Biden ha rilasciato un memorandum di sicurezza nazionale che richiede al Pentagono e alle agenzie di intelligence di intensificare l’uso dell’intelligenza artificiale. Questo documento non solo stabilisce le aspettative per l’integrazione dell’IA nelle operazioni militari, ma sottolinea anche l’importanza di proteggere gli strumenti di IA delle aziende statunitensi dai tentativi di furto da parte di spie straniere.

Il memorandum specifica, tuttavia, che le agenzie governative non possono utilizzare l’IA per monitorare il discorso degli americani o eludere i controlli esistenti sulle armi nucleari. Questa direttiva evidenzia una tensione fondamentale tra l’innovazione tecnologica e la protezione dei diritti civili, ponendo limiti chiari per garantire che l’uso dell’IA non comprometta la privacy dei cittadini.

Newsletter – Non perderti le ultime novità sul mondo dell’Intelligenza Artificiale. Iscriviti alla newsletter di Rivista.AI e accedi a un mondo di contenuti esclusivi direttamente nella tua casella di posta!

Dopo l’AI i computer quantistici: la prossima rivoluzione nella cybersicurezza secondo Amir Rapaport

L’Intelligenza Artificiale ha rivoluzionato completamente il digitale e la cybersicurezza, la prossima rivoluzione sarà con l’arrivo dei computer quantistici tra pochi anni: a ipotizzare il futuro del settore è Amir Rapaport, l’ideatore e organizzatore di CyberTech Europe che si è appena conclusa a Roma.

Negli ultimi anni, i progressi nell’intelligenza artificiale (AI) e nei sistemi autonomi hanno iniziato a cambiare radicalmente il panorama militare. Secondo il generale Mark Milley, ex Presidente del Comitato dei Capi di Stato Maggiore degli Stati Uniti, entro i prossimi 10-15 anni tra il 25% e il 33% delle forze armate statunitensi potrebbe essere costituito da unità robotiche. Milley ha fatto queste osservazioni durante un evento organizzato da Axios, sottolineando che il futuro delle operazioni militari sarà fortemente caratterizzato dall’integrazione di AI e robotica.

Come affermato nella Strategia di Difesa Nazionale, la missione primaria del DoD è quella di fornire forze militari credibili sul campo per dissuadere la guerra e proteggere la sicurezza della nazione. Mantenere un vantaggio tecnologico e militare è fondamentale per adempiere a questa missione, ma non deve avvenire a scapito dei valori democratici che sono alla base del sistema di governo statunitense. Lo sviluppo e l’uso dell’IA da parte del DoD riflette questa sfida: mantenere la supremazia tecnologica senza compromettere principi etici e legali fondamentali.

Al ComoLake 2024, Roberto Cingolani, CEO di Leonardo, ha tenuto un discorso profondo e stimolante, affrontando le complesse sfide e opportunità che emergono dall’intersezione tra tecnologia, sicurezza dei dati e conflitti globali. Le sue riflessioni risuonano in modo particolare nel contesto dell’attuale panorama digitale, che evolve a un ritmo incessante e solleva nuove domande sulla sicurezza e la gestione delle informazioni. Cingolani ha presentato un quadro ricco di spunti, ponendo l’accento sulla necessità di strategie integrate per affrontare le minacce contemporanee.

E’ in corso il G7 Difesa a Napoli, presieduto dal Ministro Crosetto in occasione del quale le delegazioni – composte oltre che dai Ministri della Difesa, anche dal segretario generale della Nato Mark Rutte e dall’Alto rappresentante dell’Unione Europa per gli affari esteri e la politica di sicurezza, Josep Borrell – si confronteranno sui principali conflitti e sulle aree di instabilità a livello globale: oltre alla guerra in Ucraina, sul tavolo anche la situazione in Medioriente, in particolare all’indomani della morte del capo di Hamas Yahya Sinwar e gli equilibri nel continente africano e nella regione dell’Indo-Pacifico.

Si tratta di un appuntamento di particolare rilievo perché per la prima volta nella storia del G7 è stata prevista una riunione ministeriale dedicata alla difesa: una decisione assunta dalla Presidenza italiana del G7 “per promuovere il ruolo del G7 quale efficace forum di consultazione anche per individuare un approccio condiviso a tematiche di carattere politico-militare“.

L’Intelligenza Artificiale gestirà in modo sicuro il flusso dei passeggeri e il riconoscimento biometrico, per gli imbarchi sugli aerei di alcuni aeroporti in India. E’ il risultato nella nuova partnership stipulata tra Thales e la Adani Airport Holding, il più grande operatore aeroportuale privato dell’India.

Secondo un’analisi di Fortune, le forze di difesa e di sicurezza degli Stati Uniti stanno investendo massicciamente nell’Intelligenza Artificiale, collaborando con centinaia di aziende per sviluppare e testare nuovi algoritmi e strumenti in modo sicuro.

Nei due anni trascorsi dal rilascio del chatbot ChatGPT di OpenAI, che ha scatenato un forte interesse globale per l’AI, il Dipartimento della Difesa ha destinato circa 670 milioni di dollari in contratti a quasi 323 aziende per vari progetti legati all’Intelligenza Artificiale. Questi numeri segnano un incremento del 20% rispetto al 2021 e al 2022, sia per il numero di aziende coinvolte che per il valore complessivo dei contratti.

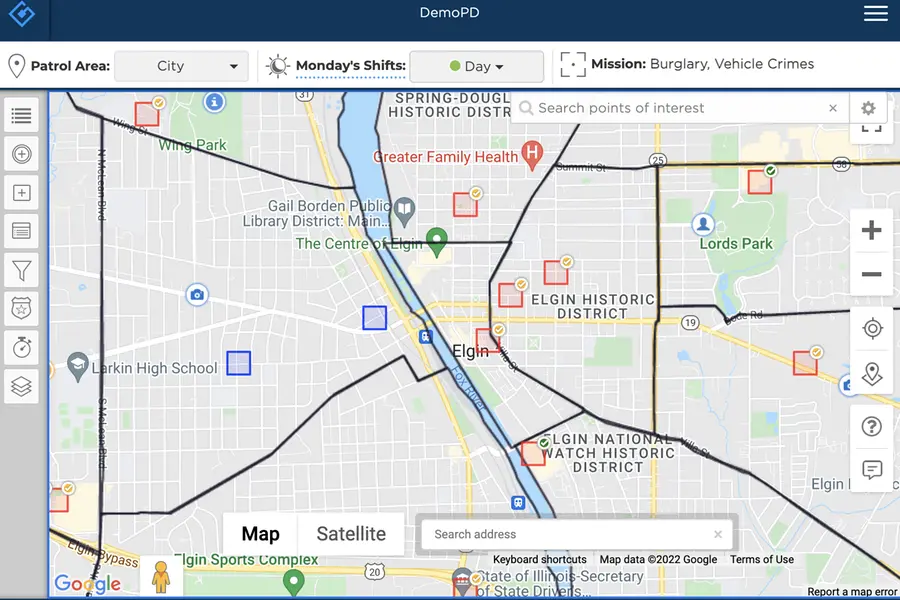

I sistemi XLAW e KeyCrime rappresentano approcci innovativi nell’ambito della sicurezza urbana e della prevenzione della criminalità, utilizzando tecnologie avanzate di analisi dei dati e intelligenza artificiale.

Nel recente dibattito sull’uso della polizia predittiva in Europa, è evidente che molti tendono a confondere diversi sistemi come se fossero simili per logica e obiettivi.

Dopo aver letto il saggio “La predictive policing nel regolamento europeo sull’intelligenza artificiale” di Elisabetta Pietrocarlo, è arrivato il momento di fare chiarezza, soprattutto sui sistemi come XLAW e KeyCrime.

Negli ultimi anni, il progresso nell’Intelligenza Artificiale ha iniziato a trasformare ogni settore della società e a riscrivere le regole del conflitto e della sicurezza internazionale. In questo articolo, esploreremo le implicazioni per la Difesa e analizzeremo come il Ministero della Difesa del Regno Unito (MOD UK) stia rivalutando le sue priorità alla luce del rapido sviluppo dell’AI e dell’AGI (Intelligenza Artificiale Generale). Questo tema non riguarda solo il futuro prossimo, ma avrà effetti strategici di vasta portata fino al 2050 e oltre, ridefinendo la natura della guerra e la sicurezza globale.

Vulnerabilità critiche nei robot con Intelligenza Artificiale: sfide e opportunità per il futuro della sicurezza

Nel panorama in continua evoluzione dell’intelligenza artificiale (IA) e della robotica, le innovazioni portano con sé non solo opportunità rivoluzionarie, ma anche rischi significativi. Un recente studio condotto dai ricercatori di Penn Engineering ha evidenziato una serie di vulnerabilità critiche nei robot alimentati da IA, rivelando potenziali scenari in cui questi sistemi possono essere manipolati per compiere azioni pericolose, come ignorare semafori rossi o, in situazioni estreme, detonare bombe.

Negli ultimi decenni, il concetto di guerra ha subito una trasformazione profonda, spostando progressivamente il fulcro dallo scontro fisico al dominio delle informazioni. Questa evoluzione ha reso la guerra dell’informazione una componente predominante nella geopolitica moderna, con implicazioni strategiche che trascendono i confini convenzionali della forza militare. L’evoluzione tecnologica e la globalizzazione delle comunicazioni hanno creato un contesto nel quale l’informazione non è solo un mezzo di supporto, ma uno strumento di guerra in sé, capace di plasmare percezioni, orientare ideologie e influenzare decisioni politiche su larga scala.

La recente scoperta (in allegato) dei ricercatori cinesi, guidati da Wang Chao dell’Università di Shanghai, rappresenta una svolta significativa nel campo del calcolo quantistico e della cybersecurity. Utilizzando un computer quantistico D-Wave, il team è riuscito a violare metodi di crittografia ampiamente utilizzati, tra cui gli algoritmi RSA e Advanced Encryption Standard (AES). Questo risultato non solo evidenzia il potenziale della computazione quantistica di minacciare le attuali misure di sicurezza, ma sottolinea anche la necessità urgente di sviluppare soluzioni crittografiche resistenti ai quanti.

L’FBI combatte gli attacchi informatici attraverso una serie di strategie avanzate. L’FBI è responsabile di investigare e prevenire le minacce informatiche, specialmente in settori critici come la sanità, dove attacchi ransomware o violazioni di dati sensibili possono avere impatti devastanti.

Palmer Luckey figura controversa, è considerato un visionario nel campo delle tecnologie emergenti, sia per quanto riguarda la realtà virtuale che le applicazioni militari avanzate.

Capitolo 1: la visione di Palmer

Era una mattina di primavera quando Palmer Luckey, il fondatore di Anduril, ricevette una chiamata cruciale. La sua azienda, nota per la sua innovativa piattaforma Lattice, era stata selezionata per collaborare con Microsoft su un progetto rivoluzionario: l’integrazione del software di Anduril con il sistema di visualizzazione IVAS dell’esercito degli Stati Uniti. L’obiettivo? Trasformare la guerra moderna attraverso la tecnologia.

AIセーフティに関するレッドチーミング手法ガイドの公開

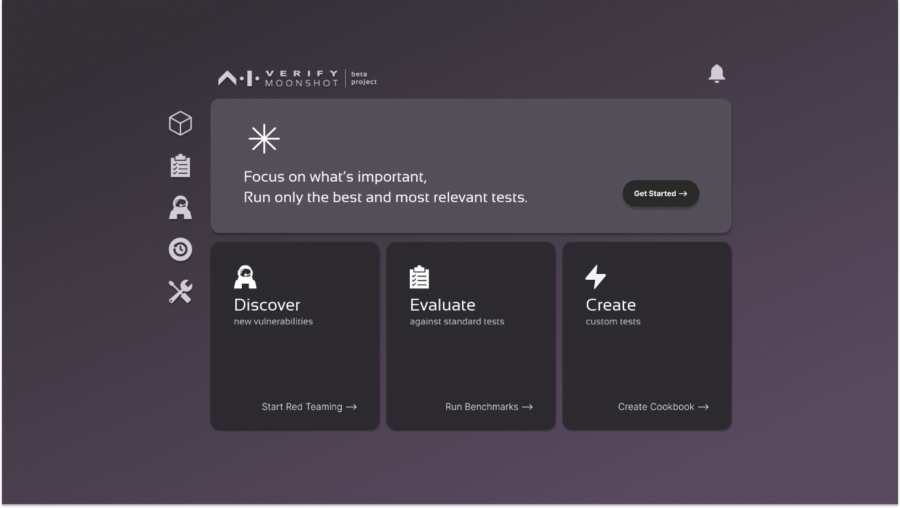

Nell’era dell’intelligenza artificiale (AI), la sicurezza dei sistemi che utilizzano questa tecnologia è diventata una priorità fondamentale. Di fronte a minacce sempre più sofisticate, l’Istituto giapponese per la sicurezza dell’intelligenza artificiale ha recentemente pubblicato una guida dettagliata sulle metodologie di red teaming, un approccio strategico volto a identificare e mitigare le vulnerabilità nei sistemi AI.

Cos’è il Red Teaming?

Il red teaming è un metodo di valutazione della sicurezza in cui esperti, noti come “red team”, emulano le tattiche e le tecniche di attacco degli aggressori per testare la resilienza di un sistema. Questo approccio non si limita a identificare vulnerabilità tecniche; si estende anche all’analisi dell’impatto sociale ed etico delle soluzioni AI. La guida dell’istituto giapponese sottolinea l’importanza di un approccio multidisciplinare, che combina competenze tecniche con una comprensione profonda delle implicazioni etiche e sociali.

Dataminr è una piattaforma di intelligenza artificiale specializzata nel rilevamento in tempo reale di eventi critici e rischi. Utilizza modelli avanzati di fusione multi-modale, che integrano diverse fonti di dati pubblici, come testi, immagini e dati da sensori, per generare avvisi tempestivi su eventi emergenti. Il sistema sfrutta oltre 50 modelli di intelligenza artificiale proprietari, supportati da una tecnologia chiamata ReGenAI, che aggiorna continuamente le informazioni in tempo reale.

Questa piattaforma è utilizzata da settori come sicurezza aziendale, pubblica sicurezza e media per rispondere a minacce in rapida evoluzione.

La città di East Palo Alto, una comunità operaia che sembra lontana anni luce dai vicini di Silicon Valley, è uno dei primi dipartimenti di polizia in California ad adottare un nuovo strumento di intelligenza artificiale (AI) per la stesura di rapporti di polizia. L’ufficiale Wendy Venegas ha recentemente affrontato una situazione delicata con una quattordicenne trovata in lacrime lungo una strada residenziale. Il padre della ragazza, dopo averla sorpresa con il fidanzato, aveva aggredito quest’ultimo, portando all’intervento della polizia. Nulla di straordinario in un contesto di routine operativa, ma la vera novità è emersa quando Venegas ha dovuto redigere il rapporto sull’incidente. (the Guardian)

Control AI è un’organizzazione che si dedica alla regolamentazione e alla gestione dei rischi associati all’intelligenza artificiale (IA). La sua missione è quella di promuovere politiche e pratiche che garantiscano lo sviluppo sicuro e responsabile dell’IA, affrontando le sfide legate alla privacy, ai bias, alla manipolazione delle informazioni e alla sicurezza globale.

Control AI propone misure come la creazione di regimi di licenza per la ricerca sull’IA e divieti su determinate direzioni di ricerca, al fine di prevenire lo sviluppo di sistemi di IA potenzialmente pericolosi, come la superintelligenza artificiale. L’organizzazione cerca di mobilitare risorse e talenti per costruire un consenso globale su come gestire i rischi legati all’IA avanzata e promuove un dialogo inclusivo tra i decisori politici, i ricercatori e la società civile.

Control AI ha pubblicato un piano politico intitolato “A Narrow Path” (Un Sentiero Stretto), volto ad affrontare i rischi associati all’intelligenza artificiale (IA). Questo piano propone un divieto allo sviluppo di superintelligenza artificiale nei prossimi 20 anni e delinea tre regimi di licenza insieme a divieti su alcune direzioni di ricerca. Tuttavia, la fattibilità dell’implementazione di tali misure appare discutibile.

Rivista.AI ha recentemente trattato il tema della polizia predittiva, con particolare focus sul software X-Law, ideato da Elia Lombardo. Questo sistema rappresenta un approccio innovativo nella prevenzione dei crimini, utilizzando algoritmi probabilistici per analizzare dati provenienti da denunce e informazioni socio-economiche. L’obiettivo è prevedere con alta precisione il verificarsi di crimini, in particolare quelli di tipo predatorio come furti e rapine

In questo vogliamo analizzare Patternizr, un innovativo strumento di analisi dei crimini sviluppato internamente dal NYPD, implementato nel dicembre 2016 e recentemente rivelato attraverso un articolo pubblicato nell’INFORMS Journal on Applied Analytics.

Questo sistema utilizza un insieme di modelli di apprendimento automatico per identificare pattern tra i crimini, analizzando centinaia di migliaia di segnalazioni in tutti i 77 distretti della città.

Un “pattern” è definito come una serie di crimini che probabilmente sono stati commessi dallo stesso autore o da autori simili, basandosi su caratteristiche identificative. Prima dell’adozione di Patternizr, gli analisti erano costretti a esaminare manualmente i rapporti, un processo lungo e inefficiente, limitato a singoli distretti e soggetto a errori umani.

Con l’introduzione di questo strumento, il NYPD ha assunto circa 100 nuovi analisti formati per utilizzare Patternizr nella loro routine quotidiana, migliorando notevolmente l’efficienza nell’identificazione dei crimini correlati.

Devora Kaye, portavoce del NYPD, ha sottolineato l’importanza dell’analisi avanzata nel garantire la sicurezza pubblica, affermando che essa deve essere trasparente e soggetta a valutazione continua per garantirne l’equità e l’efficacia. Tuttavia, l’uso di Patternizr ha sollevato preoccupazioni riguardo ai potenziali bias nell’analisi dei dati, evidenziando la necessità di mantenere un controllo umano sui risultati generati dal sistema.

Un nuovo report dell’organizzazione WITNESS, intitolato “Audiovisual Generative AI and Conflict Resolution“, mette in evidenza i rischi associati all’uso dell’intelligenza artificiale generativa nei contesti di conflitto. Questo documento analizza come le tecnologie di sintesi mediatica possano influenzare negativamente i processi di pace e il panorama informativo, contribuendo a distorcere la realtà e a fomentare tensioni tra le popolazioni coinvolte.

L’amministrazione Biden ha convocato un vertice per la sicurezza dell’Intelligenza Artificiale. L’appuntamento è alla fine di novembre, il 20 e il 21, a San Francisco e servirà per parlare del rapido sviluppo della tecnologia e degli sforzi per mitigarne i rischi.

Palantir ha ottenuto un contratto di 99,8 milioni di dollari per licenze utente per il sistema intelligente AI Maven, supporto software accessorio e hardware.

Maven, in particolare il Maven Smart System (MSS), è uno strumento avanzato di intelligenza artificiale (AI) sviluppato da Palantir Technologies per applicazioni militari. La sua funzione principale è quella di integrare e analizzare enormi quantità di dati provenienti da diverse fonti per migliorare la consapevolezza situazionale e il processo decisionale sul campo di battaglia.

“Aumentano i reati e aumenta anche la consapevolezza e la fiducia delle persone, più propense a denunciare. Ma soprattutto aumenta la percezione di insicurezza dei cittadini romani“. Così a Il Sole 24 Ore l’ex procuratore di Milano Francesco Greco, delegato alla Sicurezza dal sindaco di Roma Roberto Gualtieri, commenta i dati sui reati nella Capitale che la vedono al primo posto in Italia nella non invidiabile classifica sui reati commessi con oltre 256 mila denunce nel 2023.

Allo Asia Tech x Singapore (ATxSG) 2024, il Ministro per le Comunicazioni e l’Informazione di Singapore, Mrs. Josephine Teo, ha presentato il Progetto Moonshot, un’iniziativa significativa volta ad affrontare le sfide di sicurezza e protezione associate ai modelli di linguaggio di grandi dimensioni (LLM). Questo toolkit, che è uno dei primi strumenti open-source del suo genere, integra red-teaming, benchmarking e test di base in un’interfaccia user-friendly, rendendolo accessibile anche a utenti non tecnici.

CIA e MI6 usano l’Intelligenza Artificiale Generativa per combattere le minacce tecnologiche moderne

In una dichiarazione congiunta pubblicata sul Financial Times, il Direttore della CIA Bill Burns e il Capo del MI6 Richard Moore hanno delineato come le loro agenzie stanno utilizzando l’IA per combattere le minacce moderne.

I due hanno rivelato che entrambe le organizzazioni stanno attivamente sfruttando l’IA generativa per migliorare le attività di intelligence, in particolare per elaborare grandi quantità di informazioni.

Palantir ha ampliato le sue partnership strategiche: a maggio, l’azienda ha ottenuto un contratto dal Dipartimento della Difesa degli Stati Uniti per il suo sistema operativo AI, con un premio iniziale di 153 milioni di dollari e possibili premi aggiuntivi fino a 480 milioni di dollari in 5 anni. Ad aprile, l’azienda ha annunciato una partnership con Oracle Corporation, spostando i carichi di lavoro della sua piattaforma Foundry su Oracle Cloud Infrastructure. Gli analisti di Argus Research hanno osservato nel loro rapporto (fonte proprietaria, agosto 2024) che questa partnership:

“mira ad ampliare il mercato di riferimento di Palantir sfruttando la rete cloud globale di Oracle, consentendo ai clienti di massimizzare il valore dell’analisi dei dati e rispondendo al contempo ai requisiti di sovranità dei dati”.

alantir ha ottenuto a Marzo un contratto da 178,4 milioni di dollari dall’esercito statunitense per sviluppare prototipi per il programma Tactical Intelligence Targeting Access Node (TITAN). Questo progetto mira a “fornire informazioni di puntamento utilizzabili per un comando di missione avanzato e tiri di precisione a lungo raggio”. Questi risultati evidenziano la recente prosperità dell’azienda.

Palantir Technologies, una società americana di analisi dei dati, sta fornendo un significativo supporto all’Ucraina nel suo conflitto con la Russia attraverso l’uso di tecnologie avanzate, in particolare l’intelligenza artificiale (AI).

Il Dipartimento del Commercio degli Stati Uniti, attraverso il National Institute of Standards and Technology (NIST), ha stabilito una collaborazione con i principali sviluppatori di intelligenza artificiale OpenAI e Anthropic tramite l’U.S. Artificial Intelligence Safety Institute (AISI). Questa partnership mira a migliorare la ricerca e la valutazione della sicurezza dell’AI, segnando un passo significativo nello sviluppo responsabile delle tecnologie AI.

Qubes OS è un sistema operativo orientato alla sicurezza progettato per offrire una protezione robusta agli utenti, compartimentalizzando le loro attività digitali in ambienti isolati chiamati qubes. Questo approccio aumenta la sicurezza, poiché se un qube viene compromesso, gli altri rimangono intatti, limitando così le potenziali minacce.

Palantir e Microsoft collaborano per fornire servizi di AI alle agenzie di difesa e intelligence USA

Palantir Technologies e Microsoft collaborano per fornire funzionalità di cloud sicuro, intelligenza artificiale e analisi alla difesa e all’intelligence degli Stati Uniti. Integreranno i modelli linguistici di grandi dimensioni (LLM) di Microsoft tramite Azure OpenAI con la piattaforma AI di Palantir (AIP) nei cloud governativi e classificati di Microsoft.

Come afferma il CEO:

“Palantir è un’azienda davvero unica e la domanda ‘come hai ottenuto questa crescita di fatturato da un’azienda tecnologica in fase avanzata’ è molto interessante. Ciò è accaduto perché la nostra attività è semplicemente diversa da quella che troverai nella maggior parte delle aziende di software.

La maggior parte delle aziende di software crea software in base a quelle che erano le esigenze passate di quei clienti e riduce tali esigenze a una piccola chiave inglese comprensibile che puoi acquistare e inserire nel tuo mostro di Frankenstein di (SW aziendale).

Palantir ha scoperto nel settore Intelligence e della difesa che il modo più efficiente per fornire software è fornire l’intero stack.

Che l’utente finale, per ottenere il vero alpha dell’azienda, ha bisogno di uno stack che funzioni dal primo giorno o, nel nostro caso, dalla seconda ora..” –

Alex Karp, CEO di Palantir

Ne avevamo parlato circa un mese fa, Palantir si è aggiudicata un contratto a prezzo fisso da 480 milioni di dollari dal Dipartimento della Difesa degli Stati Uniti per sviluppare un prototipo del suo sistema di intelligenza artificiale (IA) chiamato Maven Smart System.

La Guerra con l’Intelligenza Artificiale: Il Progetto Maven

La guerra moderna è cambiata. L’uso dell’intelligenza artificiale (IA) in campo militare non è più un concetto teorico, ma una realtà che si sta sempre più consolidando. In questi ultimi tempi, gli algoritmi di visione computerizzata del progetto Maven, lanciato dal Dipartimento della Difesa statunitense, hanno localizzato lanciatori di razzi in Yemen e navi da superficie nel Mar Rosso, aiutando a ridurre i bersagli per gli attacchi in Iraq e in Siria, come riferito da Schuyler Moore, ufficiale tecnico capo del Comando Centrale degli Stati Uniti.

Il Comunicato dei Leader G7 di Apulia è stato emesso il 14 giugno 2024 durante il Summit G7 tenutosi a Borgo Egnazia, Apulia, Italia.

Il comunicato è una dichiarazione congiunta dei leader dei paesi membri G7, inclusi Canada, Francia, Germania, Italia, Giappone, Regno Unito e Stati Uniti, nonché il Presidente del Consiglio europeo e la Presidente della Commissione europea, rappresentanti dell’Unione europea.

Palantir ha ottenuto un contratto da 480 milioni di dollari dal Dipartimento della Difesa degli Stati Uniti per un prototipo del sistema di intelligenza artificiale Maven.

Il contratto dovrà essere completato entro il 28 maggio 2029 e sarà gestito dall’US Army Contracting Command di Aberdeen Proving Ground, Maryland. L’anno scorso, il Pentagono ha pubblicato un avviso che descriveva il sistema di Palantir. L’azienda è coinvolta nel Project Maven, un sistema di sorveglianza e targeting AI che analizza immagini e video dai droni per identificare automaticamente potenziali bersagli.

Nella sua notifica dell’anno scorso, il Pentagono ha dichiarato che il Maven Smart System di Palantir è stato sviluppato e testato sulla sua piattaforma cloud proprietaria, che è stata personalizzata e dimostrata con nuove funzionalità. La piattaforma è anche scalabile, permettendo l’aggiunta rapida di nuovi feed e dati con strumenti di analisi aggiuntivi.

Negli ultimi anni è nata la necessità di dover garantire che i sistemi basati sull’Intelligenza Artificiale siano in grado di evitare in maniera efficace eventuali comportamenti dannosi o pericolosi, soprattutto quando si parla di sistemi dotati di alta autonomia oppure per quelli impiegati in contesti

critici.