Nessun settore dell’IT necessita di aggiornamenti costanti ed immediati quanto la sicurezza informatica. Essere pronti a mitigare gli attacchi non basta, è necessario poterli prevenire e, in un periodo in cui le minacce digitali stanno prendendo sempre più piede nei settori più svariati, l’apporto dell’AI nella cybersecurity diventa essenziale.

Categoria: Sicurezza Pagina 2 di 4

Cybersecurity, Data Protection, Difesa, Aerospazio, Settori Strategici e Analisi Predittiva

Nonostante ci troviamo ancora nel cuore delle festività, la riflessione sui cambiamenti geopolitici, sulle implicazioni morali e sull’uso delle nuove tecnologie è inevitabile. Il mondo della politica internazionale, infatti, non si ferma mai, nemmeno quando le luci natalizie brillano nelle piazze. I recenti sviluppi legati all’intelligenza artificiale nell’ambito delle operazioni militari, in particolare con le Forze di Difesa Israeliane (IDF), rappresentano una delle questioni più complesse e urgenti da analizzare, sia dal punto di vista tecnologico che geopolitico.

Il caso di Gaza è emblematico di come l’integrazione di tecnologie avanzate possa ridefinire i confini dell’etica e della legalità nelle operazioni militari. Le decisioni legate all’uso dell’IA in guerra sollevano interrogativi che non possono essere ignorati, perché toccano aspetti fondamentali della sicurezza, dei diritti umani e delle responsabilità internazionali.

In un mondo sempre più interconnesso e tecnologicamente avanzato, come è giusto che si evolva la nostra percezione della guerra? Cosa implica l’adozione di tecnologie come il machine learning e l’automazione per la responsabilità politica e per la legittimità degli attacchi? E come si conciliano le esigenze di sicurezza con la tutela dei diritti umani in contesti di conflitto sempre più complessi e dinamici?

Anche se la pausa festiva ci offre un’opportunità di riflessione, i temi di sicurezza globale e geopolitica sono questioni che richiedono un’attenzione immediata. Mentre il mondo si riprende dalle festività, è importante tenere presente come gli sviluppi tecnologici influenzano il nostro futuro comune, e come nazioni, alleanze e gruppi più piccoli possano muoversi in un panorama sempre più digitalizzato.

L’intelligenza artificiale (AI) ha portato una trasformazione radicale non solo nell’ambito delle operazioni belliche, ma anche nel ruolo geopolitico delle forze armate di molte nazioni. In particolare, l’adozione dell’AI da parte dell’IDF (Israel Defense Forces) non solo ha ridefinito le modalità operative sul campo, ma ha avuto un impatto significativo sulla posizione strategica e diplomatica di Israele nel contesto internazionale. Esaminando il caso israeliano, possiamo notare come l’adozione della tecnologia avvenga in un momento cruciale della sua storia, in cui le sfide geopolitiche, le minacce regionali e le alleanze globali si intersecano con la crescente capacità L’IDF.

Amburgo promette di diventare un punto di riferimento nelle soluzioni di mobilità intelligente integrando sistemi di AI nei suoi sistemi di trasporto pubblico per garantire la sicurezza dei passeggeri. Le aziende di trasporto della città, Hochbahn e S-Bahn, stanno infatti combinando la supervisione umana – il personale addetto alla sicurezza verrà significativamente incrementato – con una tecnologia AI all’avanguardia per creare un ambiente di viaggio più sicuro.

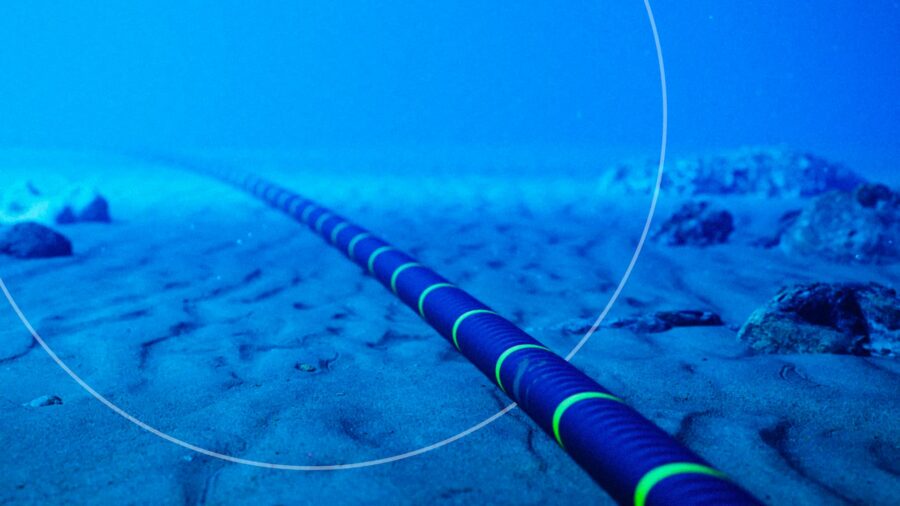

Il danneggiamento dei cavi sottomarini di collegamento tra Finlandia ed Estonia, avvenuto nelle ultime ore e attribuito alla petroliera “Eagle S” sospettata di far parte della flotta fantasma russa, rappresenta un inquietante esempio di guerra ibrida e sabotaggio delle infrastrutture critiche occidentali. Si tratta di un episodio da non sottovalutare in quanto si inserisce all’interno di un contesto più ampio di escalation geopolitica e di attacchi mirati alle infrastrutture vitali, che stanno trasformando il modo in cui i Paesi sono chiamati a ripensare la propria sicurezza e la difesa degli interessi nazionali.

La Diplomazia Predittiva: Uno Scudo Contro l’Instabilità

Nella complessità crescente delle relazioni internazionali, la piattaforma Deeplomacy, sviluppata dal Lab dell’Università degli Studi di Torino, emerge come un faro di innovazione. La sua missione è ambiziosa: trasformare l’incertezza in azioni mirate attraverso l’uso di intelligenza artificiale e machine learning. Con l’aumento del 12% dei conflitti globali rispetto al 2022 e del 40% rispetto al 2020, è evidente che i tradizionali approcci alla diplomazia e alla gestione delle crisi necessitano di una rivoluzione.

Un decennio fa, Peter Thiel dichiarava con fermezza che “la competizione è per perdenti”, sostenendo l’investimento in startup capaci di monopolizzare i loro mercati attraverso prodotti ineguagliabili. Tuttavia, la sua visione si sta evolvendo. Oggi, gran parte dei finanziamenti del Founders Fund di Thiel è concentrata in aziende che forniscono tecnologie avanzate, servizi e armi al governo degli Stati Uniti.

Nel contesto delle crescenti tensioni tra Stati Uniti e Cina, che hanno già portato a ban commerciali reciproci, emerge ora la questione di TP-Link, una delle società di modem-router più famose al mondo. Le autorità americane starebbero infatti considerando un possibile divieto per i router prodotti dall’azienda cinese, che attualmente detiene il 65% del mercato statunitense di abitazioni e piccole imprese. Il motivo? Le crescenti preoccupazioni legate alla sicurezza nazionale e ai presunti collegamenti di TP-Link con il governo cinese.

Fincantieri e Sparkle hanno siglato un memorandum d’intesa per sviluppare soluzioni tecnologiche innovative per la sorveglianza e la protezione dei cavi di telecomunicazione sottomarini. L’accordo si inquadra nell’ambito di una visione strategica per lo sviluppo tecnologico e la competitività dell’Italia a livello internazionale.

L’Intelligenza Artificiale e l’AI generativa stanno ridefinendo rapidamente il panorama della sicurezza informatica, offrendo al contempo nuove opportunità di difesa e introducendo complesse minacce. Un recente report del Capgemini Research Institute, intitolato “New defenses, new threats: what AI and Gen AI bring to cybersecurity“, ha analizzato 1.000 aziende, rivelando come queste tecnologie siano diventate cruciali nelle strategie di sicurezza di due terzi delle organizzazioni.

Le norme dell’UE in materia di cybersicurezza introdotte nel 2016 sono state aggiornate dalla Direttiva UE 2022/2555, meglio conosciuta come “Direttiva NIS2” e recepita in Italia tramite il Decreto Legislativo 138/2024, “Decreto NIS”. La direttiva ha voluto modernizzare il quadro giuridico esistente per tenere il passo con una maggiore digitalizzazione e un panorama in evoluzione delle minacce alla cybersicurezza: estendendo l’ambito di applicazione delle norme in materia di cybersecutity a nuovi settori e entità, migliora ulteriormente la resilienza e le capacità di risposta agli incidenti degli enti pubblici e privati, delle autorità competenti e dell’Ue nel suo complesso.

Oggi entra in vigore la legge sulla cyber resilienza, un atto legislativo fondamentale. Si tratta di un importante passo avanti negli sforzi dell’UE volti a proteggere i suoi cittadini e le sue imprese dalle minacce informatiche.

In quella che potrebbe tranquillamente essere la sceneggiatura di un episodio di Black Mirror (se la serie mai decidesse di scambiare la distopia per una strana commedia d’azione), la polizia cinese ha lanciato l’ultima innovazione in fatto di tecnologia autonoma per combattere il crimine: e no, non si tratta di un robot snodato, minaccioso, con occhi elettronici e movimenti agili. No, si tratta di una palla da bowling. Beh, quasi.

Uno studio ha scoperto che gli attuali modelli linguistici di intelligenza artificiale e gli strumenti biologici non pongono rischi immediati per la biosicurezza, ma che sono necessarie ricerche più rigorose sulle potenziali minacce future. Parallelamente Air Street Press ha sostenuto che, nonostante esistano rischi per la biosicurezza dell’intelligenza artificiale, concentrarsi principalmente sugli LLM piuttosto che su strumenti di bioprogettazione più specializzati potrebbe essere un errore.

l’AI red teaming. La parola d’ordine dell’industria, capace di evocare visioni di eroi cibernetici che irrompono nel castello dell’intelligenza artificiale come cavalieri digitali alla ricerca della gloria della sicurezza. Affascinante, vero? Ma ammettiamolo: dietro al dramma dell’“AI red teaming” si nasconde una bestia molto familiare – il solito processo di testing che l’industria del software sta affrontando da decenni. Nel caso te ne fossi dimenticato, la valutazione dell’AI è solo un altro episodio della saga senza fine di “vediamo se questo software si rompe prima di farci ammazzare tutti.” È come se stessimo guardando una replica, ma questa volta abbiamo sostituito i cattivi con algoritmi e le esplosioni con decisioni “intelligenti” andate storte. (vedi articolo su CISA) don’t reinvent the wheel

Sens. Elizabeth Warren, D-Mass., and Eric Schmitt, R-Mo

Nel cuore della crescente preoccupazione globale per il dominio delle grandi aziende tecnologiche, due senatori statunitensi, Elizabeth Warren (D-Massachusetts) e Eric Schmitt (R-Missouri), si stanno unendo per fare una mossa audace che potrebbe riequilibrare il panorama competitivo nella difesa e nella tecnologia. Con la proposta del Protecting AI and Cloud Competition in Defense Act, i due legislatori cercano di smantellare l’influenza spropositata che giganti come Google, Amazon e Microsoft esercitano sui contratti del Pentagono, in particolare quelli legati all’intelligenza artificiale (AI) e al cloud computing.

Il 2025 si prospetta come un anno critico per le imprese globali, caratterizzato da un significativo aumento dei cyberattacchi volti a interrompere le operazioni aziendali. Sono queste le non rosee previsioni della Unit42, la divisione di esperti di sicurezza informatica di Palo Alto Networks, che ha definito quello che sta per iniziare come “Anno delle Interruzioni delle Attività”, che promette di mettere alla prova la resilienza delle infrastrutture tecnologiche e la prontezza delle difese informatiche.

L’azienda tedesca Helsing, specializzata in software per la difesa basato su Intelligenza Artificiale, ha annunciato l’avvio della produzione di massa del drone da combattimento HX-2, progettato per resistere alla guerra elettronica e alle misure di disturbo grazie alla tecnologia AI integrata.

OpenAI, il gigante dell’intelligenza artificiale noto per la creazione di ChatGPT, ha annunciato una partnership strategica con Anduril Industries, un’azienda leader nella tecnologia per la difesa, con l’obiettivo di sviluppare e implementare soluzioni avanzate di intelligenza artificiale per missioni di sicurezza nazionale. Questa mossa segna il primo passo significativo di OpenAI nel settore della difesa, un ambito altamente strategico e tecnologicamente complesso.

L’industria marittima, pilastro del commercio globale, è alle prese con sfide complesse legate alla sicurezza, all’efficienza operativa e alla sostenibilità ambientale. La crescente complessità delle operazioni e l’aumento delle minacce sofisticate richiedono soluzioni innovative. In questo contesto, l’Intelligenza Artificiale si configura come una risposta trasformativa, rivoluzionando la sorveglianza marittima e rafforzando la resilienza del settore.

Predictive Diplomacy: A Shield Against Instability

As international relations grow increasingly complex, Deeplomacy, a platform developed by 2i3T at the University of Turin, stands out as a beacon of innovation. Its ambitious mission: transforming uncertainty into targeted actions through artificial intelligence and machine learning. With a 12% increase in global conflicts compared to 2022 and a staggering 40% rise since 2020, it’s clear that traditional approaches to diplomacy and crisis management require a revolutionary upgrade.

Boom degli attacchi cyber con i deepfake. A livello globale, nel 2024, più del 10% delle aziende si è trovata ad affrontare tentativi di frode, riusciti o meno, tramite falsi realizzati con l’Intelligenza Artificiale.Secondo i dati, contenuti nel ‘Risk Report 2024’ di Tinexta Cyber (Gruppo Tinexta), tra i Paesi maggiormente colpiti in generale dagli attacchi informatici ci sono gli Stati Uniti (1.176),sebbene in lieve calo rispetto all’ultimo semestre 2023 (-3,6%). Per quanto riguarda l’Italia, è stata osservata una diminuzione delle vittime (- 14,8%) ma nel nostro Paese grazie ai ransomware sono stati compromessi oltre 15mila gigabyte di dati, di cui 12,6 mila pubblicati nei primi sei mesi dell’anno.

L’Intelligenza Artificiale è un’arma formidabile arma che può incrementare il numero e la qualità degli attacchi cibernetici, ma allo stesso tempo può essere adeguatamente sfruttata anche per difendersi in modo altrettanto efficace ed efficiente da attacchi cibernetici. E il pensiero di Bruno Frattasi, direttore generale dell’Agenzia per la cybersicurezza nazionale in audizione alla Commissione parlamentare per la semplificazione nell’ambito dell’indagine conoscitiva in materia di semplificazione e digitalizzazione delle procedure amministrative nei rapporti tra cittadino e pubblica amministrazione.

La crescente minaccia cibernetica e di manipolazione dell’informazione proveniente dalla Russia sta assumendo una forma sempre più sofisticata e pervasiva. Un esempio emblematico è rappresentato dall’Operazione Undercut, una campagna orchestrata dalla controversa società moscovita Social Design Agency (SDA), già colpita da sanzioni statunitensi a marzo 2023. Questa operazione evidenzia come l’uso di tecnologie avanzate, come l’intelligenza artificiale (AI), e strategie di disinformazione sia diventato un’arma cruciale nella guerra cibernetica moderna.

Le mafie e il terrorismo sono molto più avanti di noi nella transizione digitale e si servono delle nuove tecnologie per operare su scala globale e stabilire nuove partnership. La criminalità organizzata si avvale già dell’Intelligenza Artificiale per ottimizzare attività illecite classiche come il riciclaggio ma anche per rendere impossibile tracciare i flussi finanziari. E rischi ancora più seri arrivano dal terrorismo: gruppi suprematisti ariani e organizzazioni jihadiste sono da tempo in prima linea, con il reclutamento tramite piattaforme di gaming on linea e miscelando sapientemente strategie di innesco di azioni violente e forme di raccolta di finanziamento.

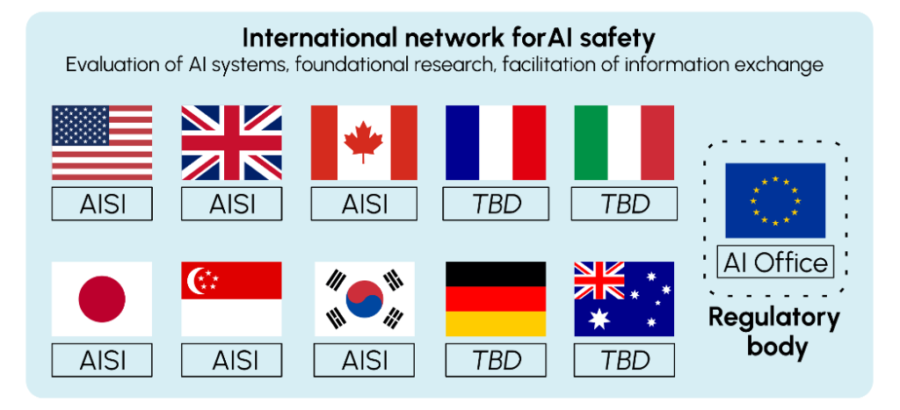

Recentemente, diversi sviluppi chiave nel campo dell’intelligenza artificiale (IA) e della sicurezza nucleare hanno attirato l’attenzione globale. Gli Stati Uniti e il Regno Unito sono al centro di iniziative volte a proteggere i sistemi critici da possibili minacce provenienti dall’uso dell’IA, mentre si aprono nuove discussioni internazionali riguardo alle politiche di test e cooperazione tra paesi. Il Dipartimento dell’Energia degli Stati Uniti, il NIST e l’Istituto Britannico per la Sicurezza dell’Intelligenza Artificiale sono tra i principali attori in questo scenario in evoluzione.

La crescente competizione tra potenze globali, in particolare l’Occidente e la Cina, ha posto l’intelligenza artificiale (IA) al centro di una battaglia tecnologica che potrebbe determinare il futuro dell’economia globale e della sicurezza internazionale.

Questa settimana BSA | L’alleanza del software ha chiesto Trump e JD Vance di affrontare le leggi che potrebbero “bloccare l’uso dell’intelligenza artificiale“. Ha anche chiesto “una legge nazionale per obbligare chi sviluppa e usa l’AI ad alto rischio a gestire i rischi e fare valutazioni d’impatto“.

Parallelamente alcuni analisti hanno dichiarato che “Sconfiggere la Cina” non implica necessariamente compromettere la sicurezza, ma anzi potrebbe rappresentare un’opportunità per accelerare l’innovazione, come sottolineato dal fatto che i test di sicurezza siano relativamente economici rispetto ai costi di formazione.

Nel recente aggiornamento di iOS 18.1, Apple ha introdotto una funzione di riavvio automatico nascosto che ha destato non poca curiosità e attenzione. Questa novità, implementata in modo discreto, mira a rafforzare la sicurezza del sistema operativo, intervenendo automaticamente nel caso in cui venga rilevata un’anomalia, una potenziale minaccia di sicurezza o un comportamento sospetto che potrebbe compromettere l’integrità del dispositivo.

L’intelligenza artificiale sta rapidamente evolvendo, e con essa emerge anche una nuova e complessa frontiera: la sicurezza. Due recenti sviluppi hanno messo in evidenza la necessità di riflessioni più approfondite sulla protezione dei modelli AI, dimostrando che anche le intelligenze più avanzate non sono immuni da vulnerabilità.

Il Pentagono ha recentemente assegnato il suo primo contratto di difesa basato sull’intelligenza artificiale generativa (GenAI) a Jericho Security, una startup innovativa nel campo della cybersecurity. Questo contratto segna un passo significativo nell’integrazione delle tecnologie avanzate nella strategia di difesa degli Stati Uniti, evidenziando l’importanza crescente dell’AI generativa nella protezione delle infrastrutture critiche e nella prevenzione delle minacce informatiche.

La discussione sulla governance dell’intelligenza artificiale negli Stati Uniti è stata recentemente intensificata, con un focus particolare sull’ordine esecutivo (EO) emesso sotto l’amministrazione Biden e le sue implicazioni per enti chiave come il National Institute of Standards and Technology (NIST) e l’AI Safety Institute (AISI). In una riflessione precedente, avevo sottolineato che gran parte di questa governance si fonda sull’EO, incluso l’AISI, ma alcuni lettori hanno prontamente fatto notare che l’AISI non è effettivamente menzionato nell’EO. Questo spunto di riflessione merita una correzione e una comprensione più approfondita, specialmente alla luce di alcune nuove informazioni emerse recentemente.

L’Italia sta puntando in modo deciso sull’intelligenza artificiale (IA) come pilastro della sicurezza nazionale. In questo contesto, il ministro della Difesa Guido Crosetto ha delineato una strategia volta a integrare tecnologie ibride avanzate nel settore della cybersecurity. Questo approccio prevede la combinazione di IA, cloud computing e infrastrutture digitali spaziali, mirando a proteggere le infrastrutture critiche e a rispondere a minacce sempre più sofisticate. Tale strategia punta a rendere l’Italia resiliente e capace di difendersi da attacchi informatici che spaziano da attori statali a gruppi criminali e terroristici, spesso intenzionati a destabilizzare il paese attraverso il cyberspazio.

REUTERS: Il panorama tecnologico globale sta affrontando un nuovo dibattito sull’equilibrio tra protezione dei dati e opportunità di investimento, come dimostrato dalla recente proposta di legge in Vietnam che cerca di inasprire le regole sulla protezione dei dati e limitare i trasferimenti di dati all’estero. Un gruppo commerciale che rappresenta le aziende tecnologiche statunitensi ha avvertito il governo vietnamita che tali normative potrebbero ostacolare la crescita delle aziende di social media e degli operatori di data center nel paese.

Vietnam si è affermato come uno dei mercati più grandi per Facebook, di proprietà di Meta Platforms, e altre piattaforme online. Il paese ha anche l’intenzione di espandere la propria industria dei data center attraverso investimenti esteri nei prossimi anni. Tuttavia, la proposta di legge attualmente in discussione potrebbe cambiare drasticamente il panorama dell’industria tech.

Le minacce catastrofiche ed esistenziali rappresentano un pericolo concreto per la civiltà umana, poiché pongono in gioco la sopravvivenza e il benessere a lungo termine dell’umanità. È con questa consapevolezza che il Congresso degli Stati Uniti ha approvato nel 2022 il Global Catastrophic Risk Management Act, una legge che delega al Dipartimento di Sicurezza Interna e alla Federal Emergency Management Agency (FEMA) il compito di coordinare un’analisi globale delle minacce catastrofiche e dei rischi correlati. Per realizzare questo obiettivo, la Direzione per la Scienza e la Tecnologia del Dipartimento di Sicurezza Interna, insieme a FEMA, ha richiesto il supporto del Homeland Security Operational Analysis Center. I risultati emersi da questa analisi rappresentano un importante passo avanti nella comprensione e nella gestione di rischi che potrebbero influire profondamente sull’umanità.

Anthropic, uno dei protagonisti più attivi nel campo dell’Intelligenza Artificiale (IA), ha recentemente sollecitato i governi di tutto il mondo ad adottare misure rapide e incisive per regolamentare i rischi potenzialmente catastrofici legati all’avanzamento dell’IA. Secondo l’azienda, il tempo per un’azione preventiva si sta rapidamente esaurendo, e ogni ritardo potrebbe compromettere seriamente la capacità dei governi di prevenire potenziali crisi legate a questa tecnologia.

L’azienda sottolinea che il ritmo dello sviluppo dell’IA è tale da giustificare questa urgenza. Circa un anno fa, Anthropic aveva avvisato che i modelli di IA di frontiera avrebbero potuto presentare rischi significativi nel campo della sicurezza informatica e delle minacce chimiche, biologiche, radiologiche e nucleari (CBRN) entro un periodo di 2-3 anni. Oggi, l’azienda avverte che siamo già molto più vicini a quel tipo di rischi di quanto si pensasse inizialmente.

À mesure que les relations internationales deviennent de plus en plus complexes, Deeplomacy, une plateforme développée par 2i3T à l’Université de Turin, se distingue comme un phare d’innovation. Sa mission ambitieuse : transformer l’incertitude en actions ciblées grâce à l’intelligence artificielle et à l’apprentissage automatique. Avec une augmentation de 12 % des conflits mondiaux par rapport à 2022 et une hausse impressionnante de 40 % depuis 2020, il est évident que les approches traditionnelles de la diplomatie et de la gestion des crises nécessitent une mise à jour révolutionnaire.

A settembre, il tenente generale He Lei, ex vicedirettore dell’Accademia delle scienze militari (AMS), ha esortato le Nazioni Unite a stabilire restrizioni sull’uso dell’intelligenza artificiale (IA) in contesti bellici. Tuttavia, questo appello sembra nascondere un intento più profondo: la Repubblica Popolare Cinese (RPC) non sta cercando di limitare i rischi associati all’IA militare, ma piuttosto sta accelerando l’integrazione della tecnologia IA nelle proprie forze armate. La RPC sta attivamente sfruttando le tecnologie occidentali, come il modello open source Llama di Meta, per potenziare le proprie capacità militari e i vantaggi strategici.

L’atteso decreto in materia di cybersicurezza slitta, improvvisamente, alla seconda metà di novembre. Il provvedimento, così come previsto, affiderebbe la competenza investigativa sulla criminalità informatica alla Procura nazionale antimafia – che dipende dal Ministero della Giustizia – limitando, di fatto, le competenze dell’Agenzia per la cybersicurezza nazionale – che dipende invece dalla Presidenza del Consiglio. Formalmente il rinvio sarebbe dovuto alla necessità di “aggiustamenti” e di coinvolgere il Quirinale sul tema, anche se i più maliziosi voluto leggere, dietro alla vicenda, un possibile segnale di conflitto tra Carlo Nordio e Alfredo Mantovano sui poteri e le competenze dei rispettivi Ministeri, tant’è che, contrario all’attuale formulazione del decreto, sarebbe anche Bruno Frattasi, attuale direttore dell’ACN, l’Agenzia per la Cybersicurezza Nazionale.