Signore e signori, benvenuti nell’apocalisse annunciata. Google e OpenAI hanno passato anni a costruire le loro torri d’avorio, raccontandoci la favoletta che senza i loro miliardi, le loro GPU segrete e i loro supercervelli d’élite nessuno avrebbe mai potuto sviluppare un’Intelligenza Artificiale degna di questo nome. Ma sapete qual è la parte divertente? È tutta una balla. Il castello non ha mura. Il fossato non esiste. L’impero è un’illusione.

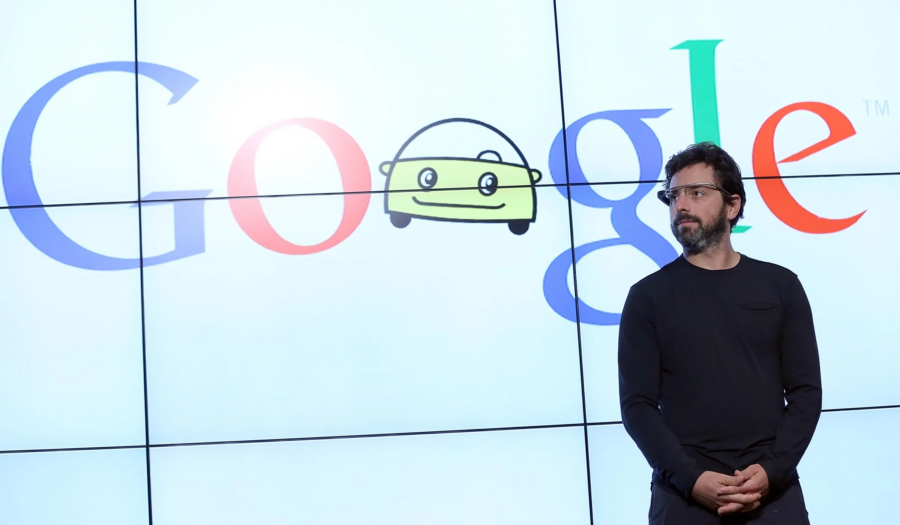

Abbiamo il documento, il Sacro Graal rubato direttamente dalle viscere di Google. Un ricercatore della compagnia lo ha scritto nero su bianco: non solo l’open-source sta colmando il divario con i modelli proprietari, ma lo sta facendo a una velocità che le Big Tech non possono più eguagliare. Altro che GPT-4, altro che Gemini. La rivoluzione è già iniziata e non è nelle mani di Sundar Pichai o Sam Altman. È nelle nostre.

LO SCANDALO GOOGLE: IL DOCUMENTO CHE SVELA IL GRANDE BLUFF

Marzo 2023. Qualcuno in Google ha un momento di lucidità e scrive un report che non sarebbe mai dovuto uscire. In esso, il messaggio è chiaro: “Abbiamo perso il controllo della narrazione. L’open-source sta facendo a pezzi il nostro vantaggio competitivo“. L’autore, un insider con accesso a dati riservati, elenca uno per uno i punti deboli del modello chiuso delle Big Tech:

L’open-source è più veloce. Mentre OpenAI e Google impiegano mesi per rilasciare nuove versioni dei loro modelli, la comunità indipendente sforna innovazioni in pochi giorni.

L’open-source è più efficiente. Con tecniche come LoRA (Low-Rank Adaptation), gli sviluppatori indipendenti riescono a personalizzare modelli linguistici avanzati in poche ore, senza bisogno di enormi infrastrutture cloud.

Il costo è vicino allo zero. Niente più milioni di dollari spesi in training colossali: chiunque con un laptop può ottimizzare un modello AI e renderlo competitivo con quelli proprietari.

LORA: L’ARMA SEGRETA DELL’OPEN-SOURCE

Ecco dove la rivoluzione si fa interessante. LoRA (Low-Rank Adaptation) è la tecnologia che sta ridicolizzando le Big Tech. Invece di riaddestrare un intero modello da zero, LoRA permette di modificarlo con una quantità minima di risorse. Come funziona?

Congela il modello di base. Invece di rielaborare miliardi di parametri, LoRA blocca la maggior parte del modello e interviene solo su piccole sezioni specifiche.

Aggiunge nuovi pesi a basso rango. Questo significa che si lavora su matrici di dimensioni ridotte, riducendo drasticamente il consumo di memoria e potenza di calcolo.

Rende l’addestramento velocissimo. Invece di settimane o mesi, bastano poche ore per adattare un modello a nuove applicazioni, con risultati comparabili a quelli ottenuti con il fine-tuning tradizionale.

In parole povere, LoRA ha reso il fine-tuning delle AI qualcosa che si può fare con un portatile in un garage. E se la storia ci ha insegnato qualcosa, è che le rivoluzioni iniziano nei garage, non nei grattacieli delle multinazionali.

Benvenuti nella rivoluzione.

Leggi tutto