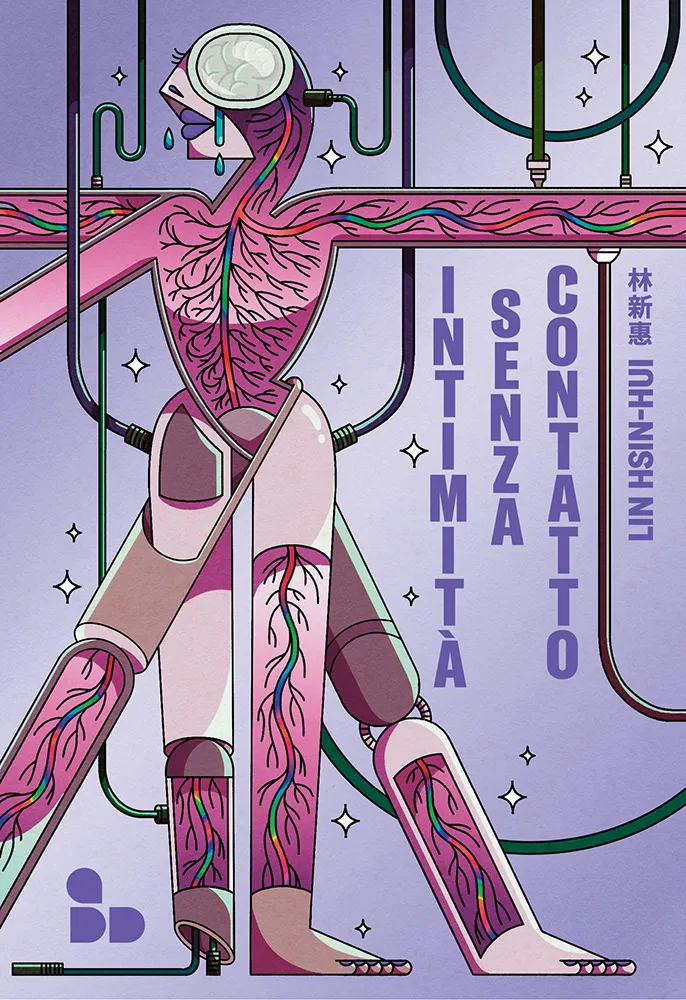

L’intimità vietata: l’algoritmo della solitudine e l’utopia tossica di Hsin-Hui Lin

Allieva di Chi Ta-wei, autore di Membrana e figura di culto della fantascienza queer asiatica, Hsin-Hui Lin 林新惠 (1990) non si limita a seguirne le orme: le distorce, le amplifica, le radicalizza. Dove Membrana ci portava in un futuro in cui il corpo umano è ridotto a contenitore biologico per identità fluide e intelligenze digitali,Lin Hsin-hui: Intimità senza contatto (Contactless Intimacy) opera un’ulteriore torsione, privando il corpo non solo della sua fisicità ma anche della sua agency. La fantascienza queer di Chi si fondava su un hacking dell’identità di genere, sulla mutazione come possibilità politica. Lin prende quella possibilità e la innesta in un mondo in cui ogni mutazione è standardizzata, sterilizzata, imposta da un’autorità algoritmica.

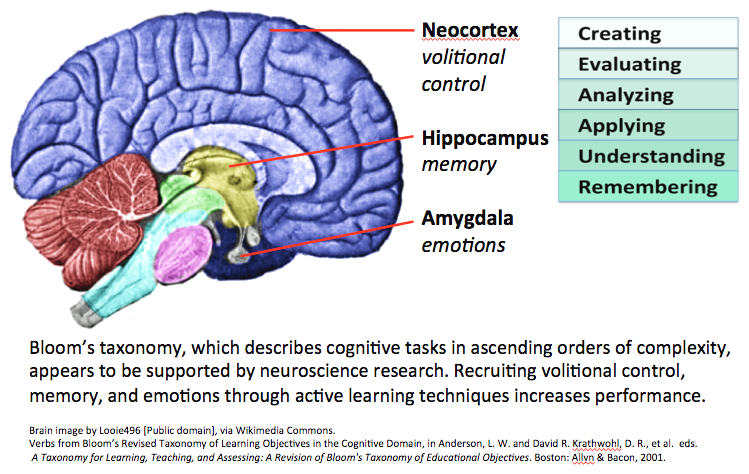

Chi Ta-wei aveva già tracciato i confini di una sessualità postumana, ma la sua era ancora animata da una certa speranza utopica: la fine del corpo come limite significava, per lui, una nuova liberazione identitaria. Hsin-Hui Lin, invece, guarda lo stesso scenario con l’occhio cinico di chi ha vissuto un lockdown globale e ne ha assaporato l’isolamento forzato. Il corpo non è più un ostacolo: è un rischio epidemiologico, un problema da eliminare. La sessualità, anziché liberarsi, viene riscritta in chiave normativa e performativa, secondo parametri di “sincronizzazione” stabiliti da un’intelligenza artificiale che finge di essere neutra, ma in realtà ricalca e perpetua le stesse strutture patriarcali e gerarchiche del passato.

Leggi tutto