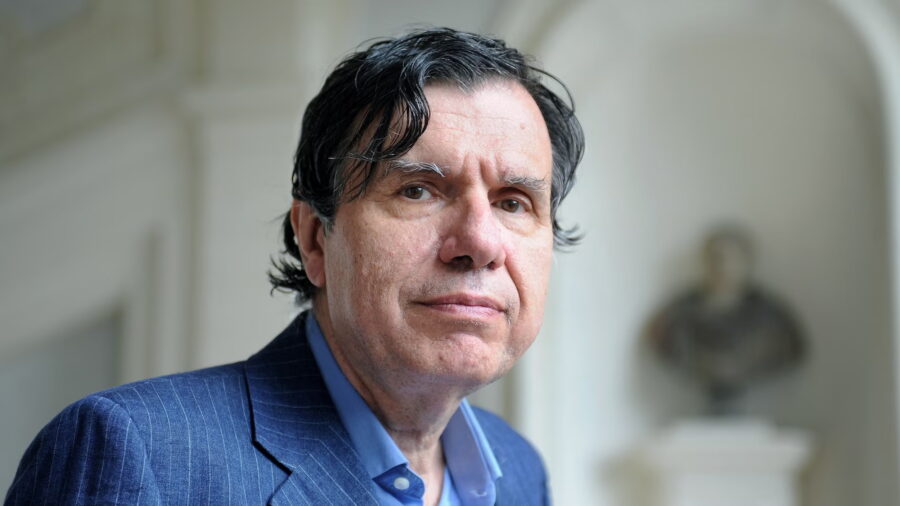

Ivan Shkvarun, Fondatore e CEO di Social Links, e Autore dell’Iniziativa Darkside AI. Lo abbiamo incontrato all’ AI Festival dove ha presentato per la prima volta l’iniziativa Darkside AI, con esempi reali di manipolazione dei consumatori, abbiamo condiviso una intervista sulle strategie per aiutare le aziende a difendersi dalle inganni alimentati dall’AI.

Ivan è un esperto di punta nell’AI e nell’intelligence a codice aperto (OSINT), con oltre 15 anni di esperienza nella mitigazione dei rischi guidata dalla tecnologia. Sotto la sua leadership, Social Links — riconosciuta da Frost & Sullivan come leader nel settore OSINT — ha sviluppato soluzioni alimentate dall’AI che espongono e neutralizzano il crimine informatico, la disinformazione e le frodi digitali a livello globale.

Evoluzione delle minacce AI-driven

Rivista.AI: Negli ultimi 15 anni, come sono cambiati i modelli operativi degli attori malevoli nell’utilizzo dell’AI per frodi e disinformazione? Quali tecniche emergenti (es. generative adversarial networks, LLM avanzati) stanno rivoluzionando il panorama delle minacce? [Esempi specifici?]

In che modo le identità sintetiche e i deepfake stanno superando le tradizionali difese biometriche o di verifica dell’identità? Esistono differenze geografiche nell’adozione di queste tecnologie a scopo malevolo?

Ivan Shkvarun: Negli ultimi dieci anni, ho assistito all’evoluzione del cybercrimine, passato da semplici violazioni di sistema a una manipolazione su larga scala della percezione e della fiducia umana. L’AI non è più solo uno strumento di innovazione: viene anche utilizzata come arma, trasformando le classiche truffe di phishing e i botnet in deepfake iper-realistici, disinformazione generata dall’AI e reti di frode completamente automatizzate.

Questo cambiamento non è ipotetico; stiamo già vedendo le conseguenze. Si prevede che le perdite per frodi legate all’AI passeranno dai 12,3 miliardi di dollari del 2023 a 40 miliardi entro il 2027, e questa è una stima prudente. L’impatto finanziario è concreto, ma il problema più profondo è la fiducia. Quando l’AI può generare identità sintetiche credibili, documenti finanziari falsificati e notizie generate dall’AI su larga scala, mina le fondamenta stesse della sicurezza digitale.

Leggi tutto