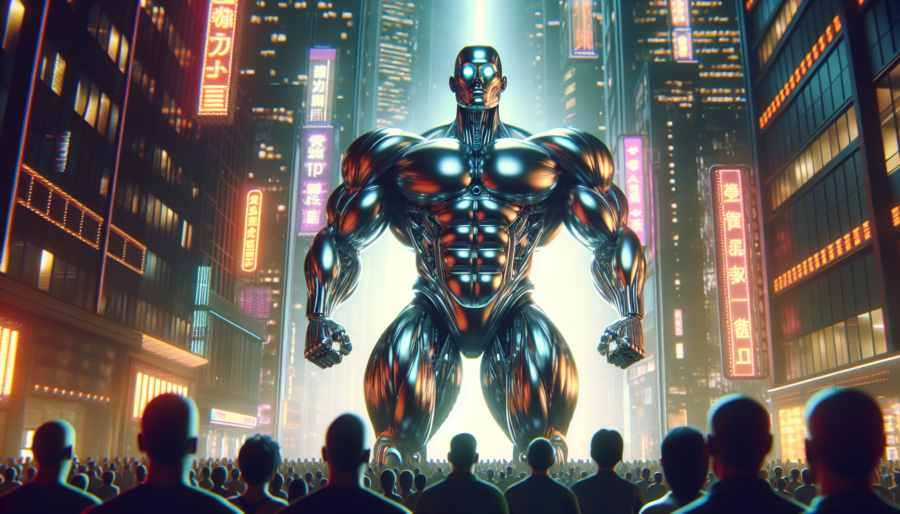

Un nuovo fronte di sfruttamento dei lavoratori a contratto? Uber, colosso noto per il ride-hailing e le consegne a domicilio, si sta espandendo nel settore del data labeling per l’intelligenza artificiale (AI), utilizzando ancora una volta il modello di business basato sui lavoratori indipendenti. Questo approccio apre interrogativi significativi sul futuro del lavoro e sul trattamento equo dei gig worker.

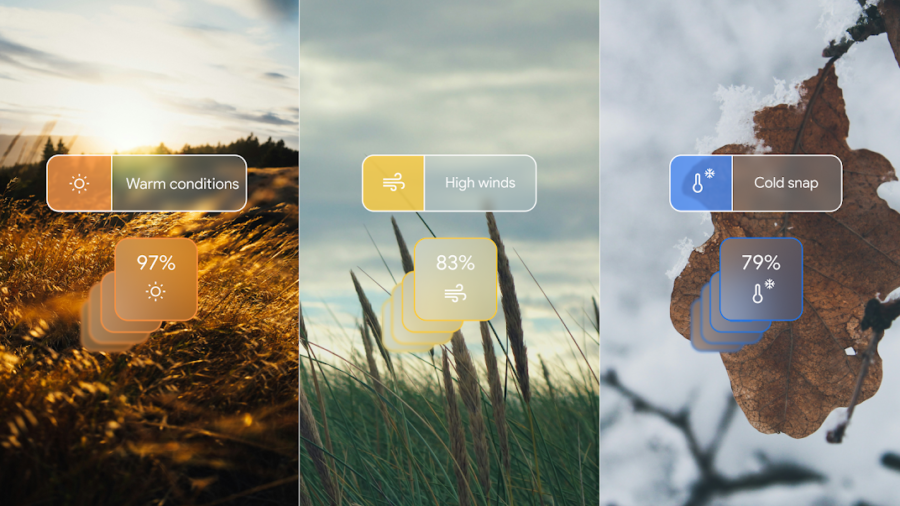

Con il lancio della divisione “Scaled Solutions”, Uber promette di mettere in contatto le aziende con “analisti, tester e operatori di dati indipendenti” tramite la sua piattaforma. Questa nuova iniziativa nasce da un team interno di supporto, che da anni si occupa di attività come il test di nuove funzionalità e la conversione dei menu dei ristoranti in opzioni Uber Eats. Ora, la stessa forza lavoro sarà messa a disposizione di aziende esterne per attività cruciali nel campo dell’AI, come la classificazione e l’etichettatura dei dati.

Leggi tutto