Scopri i migliori strumenti di Intelligenza Artificiale per l’educazione e l’apprendimento nel 2025! Questa tabella presenta soluzioni AI per tutoring personalizzato, creazione di quiz, ricerca accademica e feedback in tempo reale, ideali per rivoluzionare l’apprendimento e l’insegnamento.

Categoria: Tech Pagina 2 di 21

L’intelligenza artificiale (AI) nel suo senso piu’ ampio e l’intelligenza esibita dai sistemi informatici (Machine)

Scopri i migliori strumenti di Intelligenza Artificiale per la sintesi di testi nel 2025! Questa pagina presenta tool AI per riassumere documenti, generare contenuti e rispondere a domande, ideali per professionisti e ricercatori. Esplora le innovazioni che ottimizzano il tuo lavoro!

I bot e i sistemi pubblicitari illegali o malevoli rappresentano una minaccia significativa per la sicurezza online e l’integrità dei sistemi pubblicitari. Ma soprattutto distruggono campagne pubblicitarie di chi lavora onestamente facendo perdere una enorme quantità di soldi. Non crediate che stiamo parlando di mosche bianche, sono tante le piccole società che abbracciano il lato oscuro del marketing con l’illusione guadagnare velocemente, e la falsa convinzione che tutto sommato non stanno facendo qualcosa di illegale.

In questa directory vi proponiamo una selezione dei migliori strumenti di Intelligenza Artificiale per creare contenuti artistici nel 2025! Questa pagina presenta tool AI per generare opere d’arte, creare illustrazioni e ottimizzare processi creativi, ideali per artisti, designer e creator digitali.

Nel precedente articolo “Introduzione a Grok 3” abbiamo esplorato le principali caratteristiche del modello, le funzionalità principali, le sue potenzialità e i suoi limiti. Analizziamo adesso come massimizzare l’efficacia di Grok 3, con una serie di suggerimenti utili per ottenere i risultati migliori dal suo utilizzo.

In questa directory abbiamo voluto raccogliere i migliori strumenti di Intelligenza Artificiale disponibili al momento per generare immagini nel 2025! Questa pagina contiene un elenco di tool AI per creare contenuti visivi unici, migliorare la qualità e automatizzare flussi di lavoro, ideali per artisti, designer, appassionati e semplici curiosi.

Abbiamo visto in un precedente articolo come Alibaba abbia compiuto un passo strategico nell’arena dell’Intelligenza Artificiale generativa, rendendo open-source il suo modello Wan 2.1, specializzato nella creazione di immagini e video. Vediamone da vicino le potenzialità con 10 esempi particolarmente impressionanti.

Nell’ambito dello sviluppo di sistemi di intelligenza artificiale (IA) pronti per la produzione, le sfide legate all’integrazione di strumenti disgiunti per il tracciamento, il testing e la gestione dei dati sono ben note. Le soluzioni esistenti spesso creano silos di dati e flussi di lavoro manuali, portando i team a sprecare tempo nel debugging su piattaforme diverse e rendendo complicata la scalabilità delle valutazioni senza un supporto ingegneristico dedicato.

L’adozione di soluzioni AI basate su cloud è sempre più diffusa, ma spesso comporta costi esorbitanti e problemi di sicurezza legati all’esposizione di dati sensibili. Le infrastrutture esistenti richiedono configurazioni server complesse e vincoli con vendor specifici, mentre le soluzioni AI basate su browser faticano a garantire prestazioni adeguate per applicazioni reali. Per le aziende che puntano sulla privacy, trovare un equilibrio tra sicurezza e capacità dell’AI è una sfida costante.

WebLLM si presenta come una soluzione rivoluzionaria per superare questi ostacoli. Si tratta di un motore open-source che porta i Large Language Models (LLM) direttamente nei browser, sfruttando la potenza di WebGPU. Questo consente di eliminare la dipendenza dal cloud, ridurre i costi e garantire che i dati restino sempre all’interno del dispositivo dell’utente.

La serie di modelli Grok è costruita su algoritmi avanzati di deep learning, addestrati su vasti set di dati per comprendere le complessità del linguaggio umano. Grazie a queste tecnologie, Grok è in grado di riconoscere schemi e strutture linguistiche sofisticate, generando testi che rispecchiano fedelmente la scrittura umana. Questo lo rende ideale per una vasta gamma di applicazioni di elaborazione del linguaggio naturale (NLP), tra cui completamento del testo, traduzione, riassunti automatici e molto altro.

Con l’arrivo di Grok 3, la nuova generazione della serie, l’intelligenza artificiale compie un ulteriore salto in avanti. Questo modello introduce maggiori capacità computazionali, un supporto multilingue più avanzato e abilità di ragionamento e comprensione migliorate, ampliando il suo impatto in numerosi settori.

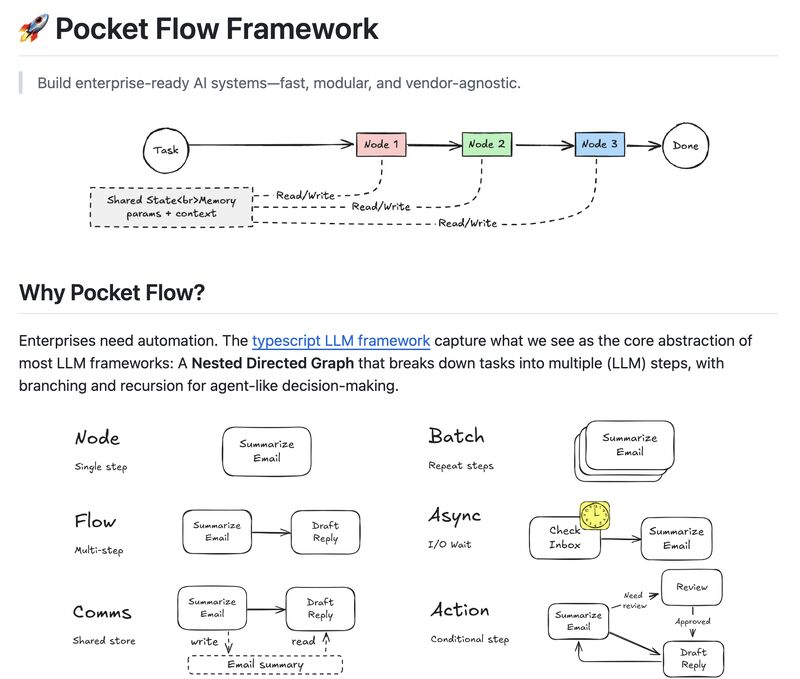

Le soluzioni esistenti impongono o tendono al vendor lock-in, mancano di modularità e rendono il debugging un incubo. Scalare workflow complessi come RAG o sistemi multi-agente diventa un groviglio di codice fragile e difficile da mantenere.

Pocket Flow è un framework open-source che organizza i sistemi AI come grafi diretti annidati, offrendo massima flessibilità nella gestione dei flussi di lavoro.

Scopri i migliori strumenti di Intelligenza Artificiale per la ricerca nel 2025! Questa pagina presenta tool AI per analizzare dati, risolvere problemi e sintetizzare contenuti, ideali per studenti, ricercatori e professionisti. Esplora le innovazioni che rivoluzionano la tua esperienza di ricerca!

Nel panorama attuale della produttività digitale, la gestione delle informazioni personali è frammentata tra note, documenti e app diverse, costringendo i knowledge worker a sprecare ore nella ricerca di dati dispersi. I servizi cloud-based promettono efficienza, ma introducono rischi significativi per la sicurezza e la privacy. D’altra parte, i metodi tradizionali di collegamento manuale delle note risultano lenti e obsoleti.

𝗥𝗲𝗼𝗿 si propone come una soluzione innovativa per la gestione delle informazioni personali, eliminando la dipendenza dal cloud e offrendo un’intelligenza artificiale locale capace di organizzare, collegare e rendere accessibili le informazioni in modo semantico. Questa applicazione open-source è progettata per rispondere a domande, creare connessioni tra idee e garantire una ricerca efficiente senza compromettere la sicurezza dei dati.

Google ha recentemente annunciato il lancio globale di Gemini code assist per sviluppatori, una versione gratuita del suo strumento di codifica assistita dall’intelligenza artificiale, ora disponibile in anteprima pubblica. Questo strumento è progettato per supportare sviluppatori individuali, tra cui studenti, liberi professionisti, hobbisti e startup, offrendo un accesso semplificato a funzionalità avanzate di assistenza alla codifica senza la necessità di passare tra diverse risorse.

Una caratteristica distintiva di Gemini code assist è la sua generosa offerta di completamenti di codice: fino a 180.000 al mese, un numero significativamente superiore rispetto ai 2.000 completamenti mensili offerti da concorrenti come github copilot. Questo è reso possibile grazie al modello di intelligenza artificiale gemini 2.0 di google, ottimizzato per la codifica, che supporta una vasta gamma di linguaggi di programmazione e fornisce assistenza tramite un’interfaccia chatbot.

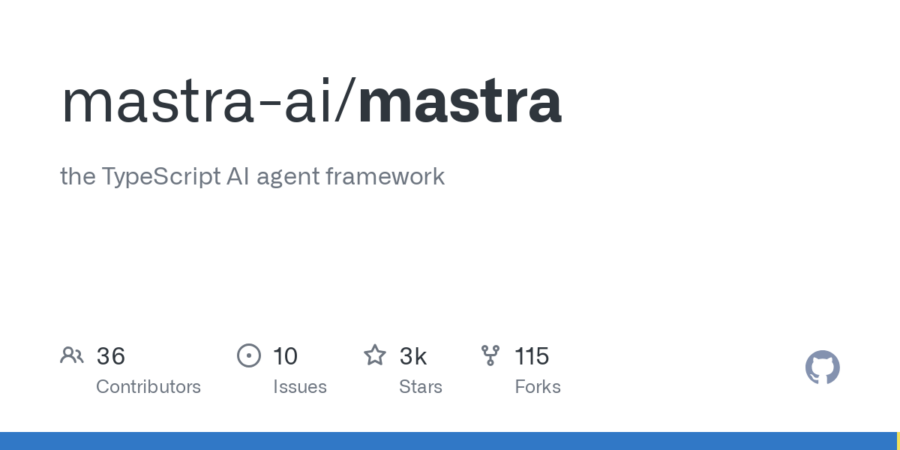

Negli ultimi anni, molte aziende hanno sprecato mesi di sviluppo cercando di costruire agenti AI destinati a fallire in produzione. I framework esistenti costringono i team a integrare strumenti fragili, personalizzare pipeline RAG difficili da scalare e affrontare sfide di manutenzione continue. La valutazione delle prestazioni viene spesso trattata come un ripensamento, complicando ulteriormente il rilascio di modelli affidabili.

Mastra si propone come la soluzione definitiva a questi problemi: un framework open-source in TypeScript che permette di creare e distribuire agenti AI in modo rapido e scalabile. Integrando nativamente agenti con strumenti, workflow dinamici, retrieval-augmented generation (RAG) e un framework di valutazione avanzato, Mastra consente alle aziende di passare dall’idea alla produzione in pochi giorni, invece che in mesi.

Lo sviluppo di intelligenza artificiale è spesso un viaggio complesso, intrappolato tra modelli opachi e pipeline fragili. Gli strumenti esistenti tendono a sacrificare la trasparenza per l’automazione o a sommergere gli sviluppatori in un mare di complessità. Le soluzioni basate su cloud, seppur potenti, espongono i dati a potenziali violazioni di sicurezza, mentre framework troppo rigidi limitano la creatività. E quando si tratta di scalare sistemi multi-agente, il debugging diventa un incubo senza fine.

Entra in scena Marvin, un framework open-source in Python progettato per rivoluzionare il modo in cui costruiamo flussi di lavoro AI agentici, garantendo risultati type-safe e un controllo granulare senza precedenti. Questa innovativa piattaforma offre un’alternativa trasparente e potente agli strumenti convenzionali, mettendo al centro dello sviluppo la creatività e l’efficienza.

Nel panorama in rapida evoluzione dell’intelligenza artificiale, OpenAI ha recentemente svelato una strategia innovativa per ottimizzare le interazioni con i suoi modelli di ragionamento avanzati della serie o. Contrariamente all’approccio tradizionale che prevedeva istruzioni dettagliate e complesse, l’azienda ha scoperto che l’uso di prompt diretti e concisi migliora significativamente le risposte dell’IA.

La riga di comando è sempre stata un potente strumento nelle mani degli sviluppatori, ma anche una fonte di inefficienza, errori sintattici e continue ricerche su Stack Overflow. Il problema? Il linguaggio delle shell è distante dal linguaggio umano e richiede una conoscenza approfondita dei comandi e delle loro opzioni.

AI Shell introduce un cambio di paradigma. Questo progetto open-source consente di tradurre comandi in linguaggio naturale in istruzioni precise per il terminale, grazie all’integrazione con i modelli OpenAI. Con un’interfaccia interattiva, AI Shell permette agli sviluppatori di lavorare più velocemente, riducendo il tempo sprecato su errori di sintassi e ricerche obsolete.

Il concetto di “Private AI” sta guadagnando rapidamente attenzione tra coloro che cercano di bilanciare le potenzialità delle tecnologie di intelligenza artificiale con la necessità di proteggere i propri dati sensibili. Si tratta di un approccio che mira a garantire che l’elaborazione dei dati avvenga senza compromettere la privacy, mantenendo il pieno controllo sui dati stessi. In altre parole, si concentra sull’utilizzo di modelli di AI che operano localmente sui dispositivi dell’utente, piuttosto che fare affidamento su server remoti, come è tipico nei “tradizionali modelli” di intelligenza artificiale basati su cloud.

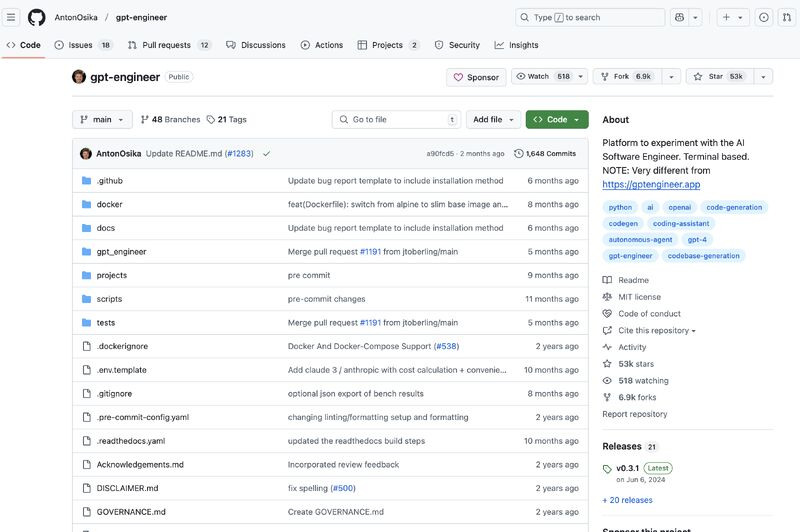

Nel panorama tecnologico in continua evoluzione, molti si pongono la domanda: “Perché abbiamo ancora bisogno degli ingegneri se abbiamo l’intelligenza artificiale?” Una domanda legittima, considerando i rapidi progressi dell’IA e la sua applicazione in vari campi. Tuttavia, mentre l’IA ha fatto significativi progressi nell’assistenza alla scrittura di codice, lo sviluppo software va ben oltre il semplice scrivere righe di codice o generare script. Il ruolo degli ingegneri non si limita a produrre codice, ma implica anche la comprensione delle esigenze, la progettazione dell’architettura, l’ottimizzazione delle prestazioni e la garanzia che il software soddisfi gli obiettivi aziendali.

Ci credi se ti dico che l’Intelligenza Artificiale (AI) e l’apprendimento automatico (ML) sono gli strumenti ideali per conoscere meglio i tuoi utenti?

Grazie a queste tecnologie, è possibile raccogliere, analizzare e interpretare una grande e varia quantità di dati per ottenere una comprensione più profonda dei comportamenti, delle preferenze e delle esigenze degli utenti. Questo permette di personalizzare l’esperienza utente, migliorare i prodotti e i servizi offerti e, in ultima analisi, aumentare la soddisfazione e la fidelizzazione dei clienti.

Vediamo come.

L’automazione delle attività sul browser ha sempre rappresentato una sfida per gli sviluppatori. Ore spese a scrivere script fragili, a inseguire bug sfuggenti e a fare i conti con interfacce utente in continua evoluzione sono solo alcune delle problematiche affrontate quotidianamente. Gli strumenti esistenti, sebbene potenti, richiedono spesso competenze di programmazione avanzate e diventano rapidamente obsoleti al primo cambiamento nell’interfaccia grafica. Inoltre, le soluzioni basate su cloud pongono rischi di sicurezza, mettendo potenzialmente in pericolo dati sensibili.

Adobe ha recentemente lanciato in beta pubblica il suo innovativo strumento di generazione video basato su intelligenza artificiale, denominato

. Questo strumento, accessibile tramite la rinnovata applicazione web Firefly, rappresenta un significativo passo avanti nell’integrazione dell’IA nei processi creativi, offrendo funzionalità avanzate sia per professionisti che per appassionati del settore.

Generate Video si articola in due principali funzionalità: Text-to-Video e Image-to-Video. La prima consente agli utenti di creare video a partire da descrizioni testuali dettagliate, permettendo una traduzione diretta delle idee in sequenze visive. La seconda, Image-to-Video, permette di utilizzare un’immagine di riferimento insieme al prompt testuale, fornendo un punto di partenza visivo per la generazione del video. Queste funzionalità sono arricchite da opzioni che consentono di affinare o guidare i risultati, come la simulazione di stili, angolazioni della telecamera, movimenti e distanze di ripresa.

ByteDance, in collaborazione con l’Università di Hong Kong, ha presentato Goku e Goku+, una nuova famiglia di modelli di intelligenza artificiale progettati per superare il divario tra la generazione di immagini e quella di video. Grazie a un’architettura unificata e tecniche avanzate di elaborazione visiva, questi modelli stanno ridefinendo gli standard del settore, ottenendo prestazioni da record nei principali benchmark visivi e aprendo nuove possibilità per la creazione di contenuti commerciali iperrealistici.

Nel mondo dello sviluppo software, gli strumenti di coding assistito basati su AI stanno rapidamente diventando indispensabili. Tuttavia, molti sviluppatori affrontano sfide quotidiane nel bilanciare l’uso di questi assistenti con il loro codice locale. Le soluzioni attuali spesso richiedono il copia-incolla di frammenti di codice, portando alla perdita di contesto e rendendo difficile lavorare su progetti multi-file. Inoltre, l’assenza di integrazione con la cronologia git e i potenziali rischi di sicurezza associati al caricamento di codice proprietario su piattaforme cloud costituiscono ostacoli significativi.

6ai Technologies non si limita a sviluppare un altro Large Language Model (LLM), ma adotta un approccio radicalmente differente, basato su un’architettura altamente ottimizzata e proprietaria. Partendo dall’open-source, integra elementi utili in un framework esclusivo che combina FLM-T (Focused Language Model – Tuned) e CCQF (Cognitive Computational Query Framework), con l’obiettivo di offrire un sistema di intelligenza applicata estremamente specifico, performante e scalabile.

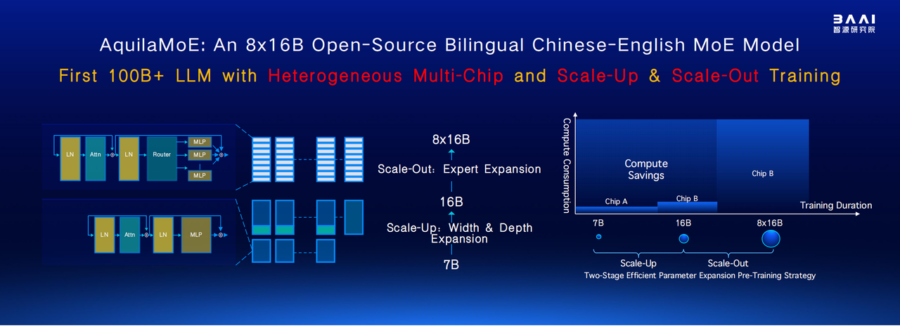

Il Beijing Academy of Artificial Intelligence (BAAI) ha introdotto AquilaMoE, un avanzato modello linguistico basato su una struttura Mixture of Experts (MoE) da 8*16B, progettato per ottenere prestazioni elevate con un’efficienza senza precedenti. Il cuore della sua innovazione è EfficientScale, una metodologia di addestramento a due fasi che massimizza il trasferimento di conoscenza riducendo il fabbisogno di dati e calcolo.

L’approccio Scale-Up permette di inizializzare un modello più grande a partire dai pesi di uno più piccolo, ottimizzando l’uso dei dati e accelerando l’apprendimento. Successivamente, la fase Scale-Out trasforma un modello denso in un modello MoE, migliorando ulteriormente l’efficienza computazionale e la capacità del modello. Queste strategie consentono ad AquilaMoE di superare le limitazioni degli attuali modelli di linguaggio, offrendo prestazioni superiori con minori costi computazionali.

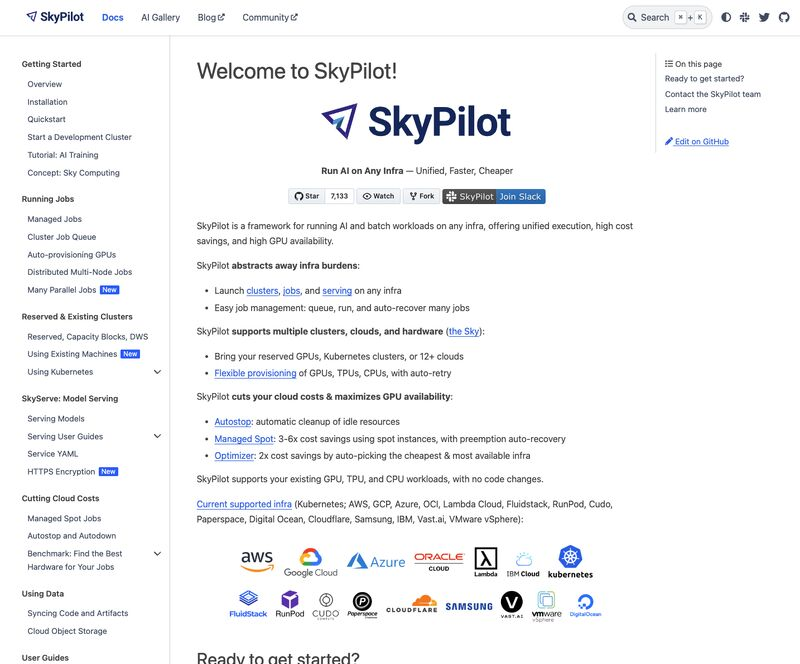

La gestione di carichi di lavoro AI e batch su infrastrutture ibride—tra cloud e on-prem—è un compito complesso, costoso e spesso frustrante. Il rischio di lock-in con vendor specifici, l’overhead della gestione manuale e i costi elevati delle GPU inattive rappresentano sfide significative per aziende e sviluppatori.

SkyPilot è una soluzione open-source che rivoluziona questo panorama, offrendo un’unica interfaccia per eseguire workload AI e batch su Kubernetes e oltre 12 cloud provider, eliminando il lock-in e riducendo significativamente i costi operativi.

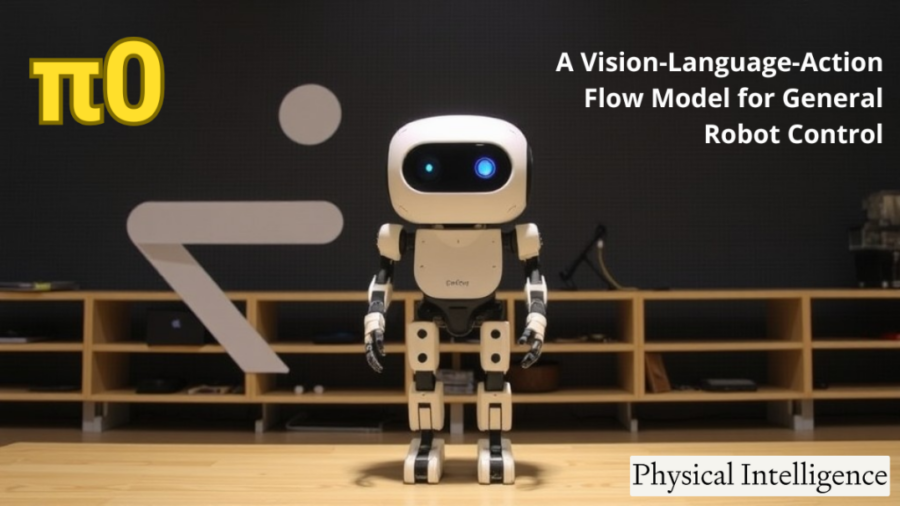

In un emozionante sviluppo per il mondo della robotica, Hugging Face ha ufficialmente portato i suoi primi modelli fondamentali per la robotica nel repository LeRobot. I modelli π0 e π0-FAST, sviluppati da Physical Intelligence, sono ora disponibili, offrendo all’ecosistema di Hugging Face una soluzione all’avanguardia per l’intelligenza artificiale generale per i robot. Questi nuovi modelli rappresentano un passo significativo verso la creazione di sistemi robotici versatili, in grado di svolgere una vasta gamma di compiti con diverse incarnazioni fisiche. Grazie all’integrazione dei modelli Vision-Language-Action (VLA), questi sviluppi mirano a portare i robot più vicini a un’adattabilità simile a quella umana, permettendo loro non solo di comprendere i compiti, ma anche di interagire fisicamente con l’ambiente circostante.

Presearch ha lanciato PreGPT 2.0, un nuovo capitolo nella sfida alle Big Tech nel settore dell’AI conversazionale. Con un’infrastruttura decentralizzata, questo aggiornamento punta a ridefinire il concetto di chatbot, offrendo modelli linguistici avanzati e una maggiore varietà di soluzioni AI open-source.

La novità più rilevante è il superamento del tradizionale approccio centralizzato: invece di operare da data center monolitici, PreGPT 2.0 sfrutta una rete distribuita di computer indipendenti. Secondo Brenden Tacon, innovation and operations lead di Presearch, questa architettura consente al chatbot di operare senza le restrizioni tipiche delle AI mainstream, spezzando il meccanismo degli algoritmi che alimentano il conformismo digitale.

Lobe Chat si distingue come una piattaforma AI self-hosted che offre un’alternativa scalabile, modulare e sicura ai chatbot tradizionali. La sua architettura è progettata per garantire interoperabilità con diversi provider AI, privacy dei dati e un’integrazione fluida con le infrastrutture esistenti.

Architettura Modulare e Plugin Ecosystem Lobe Chat adotta un’architettura modulare basata su un ecosistema di plugin, permettendo agli utenti di estendere le funzionalità senza modificare il core system. Ogni plugin opera come un microservizio, facilitando l’aggiunta di nuove capacità come ricerca web, generazione di immagini, elaborazione del codice e flussi di lavoro personalizzati.

Il panorama dell’intelligenza artificiale è frammentato e caotico, con aziende e sviluppatori che faticano a gestire tool diversi, costi poco chiari e problemi di privacy. I modelli SaaS impongono vincoli ai vendor, mentre l’uso di API cloud apre scenari di rischio per la sicurezza dei dati. La scalabilità è un enigma complesso e l’integrazione di modelli multimodali è spesso un incubo per gli sviluppatori.

𝗔𝗻𝘆𝘁𝗵𝗶𝗻𝗴𝗟𝗟𝗠 si propone come la soluzione definitiva a questi problemi, offrendo un ambiente AI self-hosted, con Retrieval-Augmented Generation (RAG), agenti AI e controllo granulare delle operazioni. Si tratta di una piattaforma open-source che combina potenza, flessibilità e trasparenza.

Le sue caratteristiche distintive comprendono un hub per modelli multi-LLM, un sistema di RAG che consente di interagire con documenti e siti web mantenendo il controllo dei dati, e agenti AI avanzati capaci di navigare il web, eseguire codice e orchestrare workflow personalizzati.

La sua flessibilità è evidente nelle opzioni di deployment: può essere eseguito localmente su desktop o scalato tramite Docker e Kubernetes. A livello enterprise, offre gestione utenti avanzata, audit log e politiche di accesso dettagliate. Un altro vantaggio competitivo è la trasparenza dei costi, eliminando i sovrapprezzi sulle query AI e le fee per utente tipiche dei servizi SaaS.

La community open-source di 𝗔𝗻𝘆𝘁𝗵𝗶𝗻𝗴𝗟𝗟𝗠 è in forte crescita, con oltre 3.000 stelle su GitHub e un ecosistema in espansione. Gli sviluppatori trovano strumenti robusti, API complete, widget web e un’estensione browser preconfigurata. Inoltre, offre una soluzione all-in-one per sostituire molteplici strumenti, consolidando chatbot, analisi documentale e automazione in un’unica piattaforma.

L’approccio orientato alla sovranità dei dati è un altro elemento chiave: l’hosting può avvenire su database locali come LanceDB, Chroma o Pinecone, garantendo totale indipendenza dal cloud.

𝗔𝗻𝘆𝘁𝗵𝗶𝗻𝗴𝗟𝗟𝗠 non è solo un framework AI, ma un cambio di paradigma per chi cerca potenza, privacy e controllo senza compromessi.

Repository: https://github.com/Mintplex-Labs/anything-llm

Website: https://anythingllm.com/

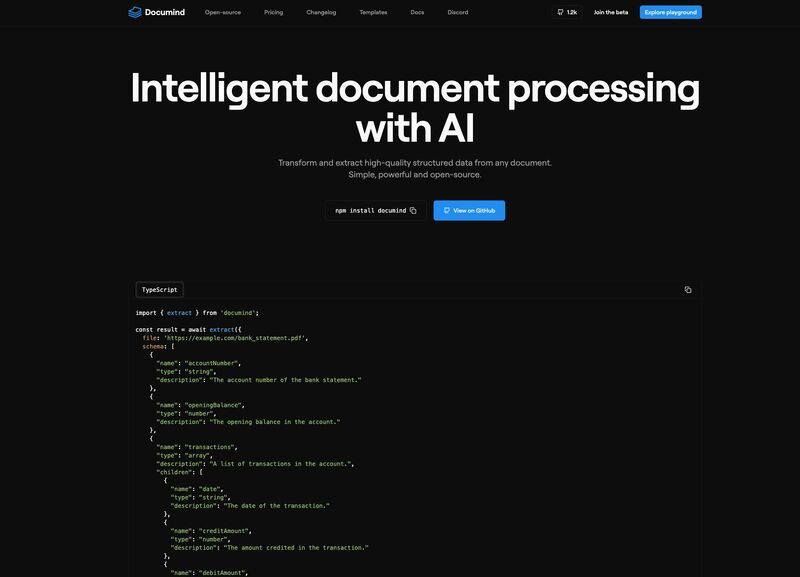

Oggi, più che mai, l’estrazione di informazioni utilizzabili da documenti non strutturati rappresenta una delle principali sfide per numerosi team aziendali. L’adozione di strumenti tradizionali, purtroppo, non ha risolto il problema: questi strumenti, da un lato, non riescono a gestire con precisione layout complessi, e dall’altro, obbligano gli utenti a caricare i documenti su piattaforme cloud, mettendo così a rischio la privacy dei dati. Inoltre, l’uso di modelli predefiniti spesso non si adatta alle reali esigenze quotidiane, costringendo i team a una gestione manuale che rallenta e appesantisce la produttività.

Se anche tu, come molti, ti senti sopraffatto dalla quantità di documenti da gestire, sarà familiare il senso di frustrazione nel constatare che conoscenze preziose sono sepolte sotto una montagna di dati difficili da accedere. La buona notizia è che esiste una soluzione che può finalmente fare la differenza: Documind.

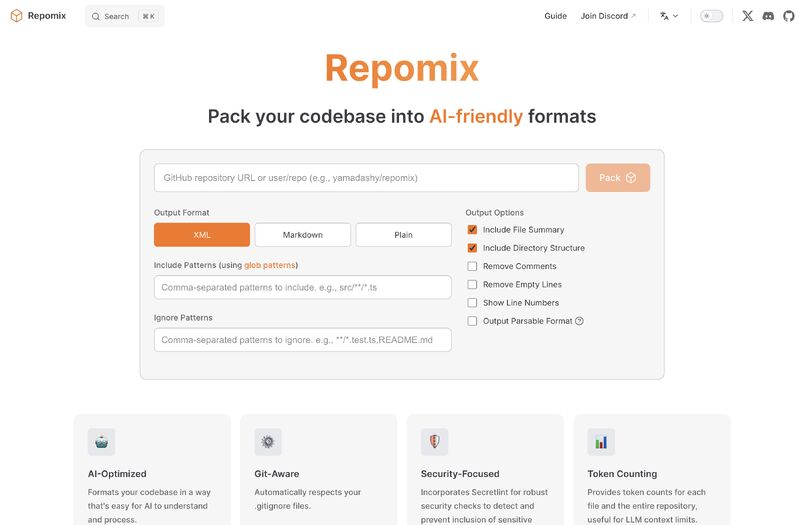

Sembra un’idea innovativa per ottimizzare il lavoro degli sviluppatori con l’AI. Repomix affronta il problema reale della gestione del contesto nei progetti software, evitando la frammentazione del codice e garantendo la sicurezza dei repository privati.

L’approccio di creare un unico file AI-ready, ottimizzato per i modelli linguistici, risolve il problema della perdita di informazioni e semplifica l’integrazione con strumenti come ChatGPT e Claude. Il supporto a formati specifici, il conteggio dei token e l’automazione nella gestione di repository remoti sono caratteristiche chiave che potrebbero ridurre drasticamente il tempo speso dagli sviluppatori a organizzare il codice per l’AI.

OpenAI ha appena lanciato l’ennesima novità per ChatGPT: Deep Research, un’aggiunta che promette di trasformare il chatbot da semplice generatore di testo in un analista autonomo capace di pianificare, eseguire ricerche multi-step e perfino tornare sui propri passi se necessario. Un’intelligenza artificiale che finalmente può correggersi da sola? Quasi, ma non troppo.

L’idea è che ora ChatGPT non si limiti a rispondere con il solito testo preconfezionato, ma mostri un processo di ricerca “trasparente” nella nuova barra laterale, includendo citazioni e spiegazioni su come ha costruito la sua risposta. Un’innovazione che suona rassicurante, fino a quando OpenAI stessa ammette che Deep Research può ancora allucinare fatti inesistenti, confondere bufale con dati ufficiali e non avere la minima idea di quanto sia sicuro delle sue risposte. Insomma, un po’ come un analista finanziario sotto pressione, ma con meno senso della realtà.

L’intelligenza artificiale sta rivoluzionando il panorama aziendale e Grok 3 di xAI è in prima linea in questa trasformazione. Questa guida completa approfondisce le capacità di Grok 3 ed esplora le sue diverse applicazioni nel business online.

Cos’è Grok 3?

Grok 3 è un modello linguistico AI avanzato sviluppato da xAI, progettato per generare testi e immagini simili a quelli umani in base alle richieste degli utenti. Utilizzando un’architettura di rete neurale basata su trasformatori, Grok 3 elabora e produce contenuti contestualmente rilevanti, rendendolo uno strumento versatile in vari campi, dall’elaborazione del linguaggio naturale alla creazione di contenuti.

Come funziona Grok 3?

Utilizzando una rete neurale basata su trasformatori con più livelli di autoattenzione, Grok 3 apprende le relazioni contestuali tra parole e frasi. Genera contenuti prevedendo la parola o la frase più probabile in un determinato contesto, consentendo di ottenere risultati coerenti e adeguati al contesto. Inoltre, Grok 3 offre funzionalità di generazione di immagini grazie all’integrazione con FLUX.1, consentendo agli utenti di creare immagini da descrizioni testuali.

Applicazioni di Grok 3 nel business online

- Creazione di contenuti: Grok 3 è in grado di generare articoli di alta qualità, descrizioni di prodotti, post sui social media e altri tipi di contenuti, semplificando il processo di produzione dei contenuti per le aziende;

- Servizio clienti: generando risposte automatiche alle richieste dei clienti, Grok 3 migliora l’efficienza e l’accuratezza dell’assistenza clienti;

- Marketing: Grok 3 aiuta a creare testi pubblicitari convincenti, campagne di e-mail marketing e altri materiali promozionali, aiutando le aziende a coinvolgere efficacemente il proprio pubblico di riferimento;

- E-commerce: Grok 3 è in grado di creare descrizioni dettagliate dei prodotti, recensioni e raccomandazioni personalizzate, contribuendo ad aumentare le vendite e a migliorare la soddisfazione dei clienti.

Le applicazioni e gli usi principali di Grok-3

Creazione e modifica di contenuti: Grok-3 è in grado di generare contenuti scritti di alta qualità, tra cui articoli, post di blog e aggiornamenti dei social media. Assiste gli scrittori fornendo bozze, suggerendo modifiche e migliorando la qualità complessiva del testo.

Assistenza alla programmazione: grazie alle sue avanzate capacità di ragionamento, Grok-3 aiuta nella generazione e nel debug del codice. Può scrivere frammenti di codice complessi, identificare errori e suggerire ottimizzazioni, semplificando il processo di sviluppo.

Analisi di mercato e previsioni: Grok-3 analizza i dati di mercato in tempo reale per prevedere le tendenze, aiutando gli analisti finanziari e le aziende a prendere decisioni di investimento informate.

Automazione dell’assistenza clienti: Generando risposte accurate e contestualmente pertinenti, Grok-3 migliora il servizio clienti attraverso chatbot e assistenti virtuali, migliorando il coinvolgimento e la soddisfazione degli utenti.

Supporto didattico: Grok-3 funge da tutor virtuale, spiegando concetti complessi, risolvendo problemi e fornendo esperienze di apprendimento personalizzate in varie materie.

Arte creativa e intrattenimento: il modello aiuta a generare contenuti creativi come storie, poesie e persino progetti di giochi, promuovendo l’innovazione nelle industrie dell’arte e dell’intrattenimento.

Comunicazione multilingue: il supporto multilingue di Grok-3 consente di tradurre e comunicare senza problemi in diverse lingue, abbattendo le barriere linguistiche nelle interazioni globali.

Recupero delle informazioni in tempo reale: integrato con piattaforme come X (ex Twitter), Grok-3 fornisce informazioni aggiornate, analisi delle tendenze e tracciamento degli eventi, mantenendo gli utenti informati in tempo reale.

Assistenza alle diagnosi mediche: utilizzando le sue capacità di ragionamento, Grok-3 analizza sintomi e dati medici per assistere gli operatori sanitari nella diagnosi di condizioni complesse.

Ricerca e analisi dei dati: Grok-3 aiuta i ricercatori riassumendo grandi insiemi di dati, generando ipotesi e fornendo approfondimenti, accelerando così il processo di ricerca.

Come abbiamo visto quindi, la versatilità e le funzioni avanzate di Grok-3 ne fanno una risorsa preziosa in diversi settori, migliorando l’efficienza, la creatività e i processi decisionali.

NdR. Sullo stesso argomento vedi anche: “Introduzione a Grok 3” e “Consigli e trucchi per l’uso di Grok 3“

Newsletter – Non perderti le ultime novità sul mondo dell’Intelligenza Artificiale: iscriviti alla nostra newsletter gratuita e accedi ai contenuti esclusivi di Rivista.AI direttamente nella tua casella di posta!

Nel panorama in rapida evoluzione delle applicazioni AI, uno degli aspetti più sfidanti è la transizione da un prototipo a una soluzione di produzione scalabile. Se è facile sviluppare flussi di lavoro documentali alimentati da intelligenza artificiale all’interno di notebook, il vero ostacolo emerge quando si tratta di gestire la complessità del mondo reale. Le soluzioni esistenti spesso non forniscono la modularità necessaria per passare facilmente dalla fase di prototipazione alla produzione, richiedendo in molti casi di ricostruire tutto da zero per ambienti reali. Inoltre, la crescente dipendenza dal cloud crea non pochi rischi per la privacy, mentre le architetture rigide limitano la possibilità di personalizzazione. Infine, senza gli strumenti giusti, il debug dei sistemi RAG (Retrieval-Augmented Generation) diventa un vero e proprio incubo.

Ma ora, con Cognita, una nuova piattaforma open-source per il framework RAG, si apre una strada alternativa che rende possibile superare questi limiti, colmando il divario tra il prototipo e la produzione.

La memoria umana è la colonna portante della nostra identità. È quel misto di ricordi imbarazzanti, momenti epici e dettagli irrilevanti che ci permette di dire “io sono questo.” Ma è anche un sistema ingannevole, un archivio disorganizzato e pieno di falle. Ora immaginate di prendere questa meravigliosa confusione e cercare di replicarla in un’intelligenza artificiale. Sembra una buona idea? Certo, come lanciare un boomerang in uno spazio angusto e sperare che non ritorni per colpirti.

La memoria a lungo termine (LTM) e la memoria a breve termine (STM) non sono solo concetti accademici da manuale di psicologia. Sono i due poli su cui si basa ogni processo cognitivo umano. La STM è quella lavagna temporanea su cui scriviamo le informazioni per risolvere problemi immediati: ricordare il numero di una stanza d’hotel, fare calcoli mentali, trovare un modo elegante per uscire da una conversazione noiosa. La LTM, invece, è il magazzino delle nostre esperienze, il contenitore che ci permette di ricordare la lezione di geometria del liceo (anche se ormai non ci serve più) o il nome del nostro primo amore.

La competizione nel mondo dell’intelligenza artificiale e delle soluzioni di calcolo avanzato è sempre più agguerrita, con aziende come NVIDIA che detengono una fetta importante del mercato grazie alle loro GPU e ai processori specializzati per il deep learning. Tuttavia, un attore emergente come Huawei, con la sua serie di chip Ascend, sta facendo rumore, proponendo soluzioni ad alte prestazioni come l’Ascend 910C, che, pur con un prezzo nettamente inferiore, offre capacità di calcolo sorprendenti. Questo scenario diventa ancora più interessante quando si considera l’influenza del ban tecnologico USA e il ruolo che piattaforme come DeepSeek potrebbero svolgere nell’adozione di queste nuove soluzioni.

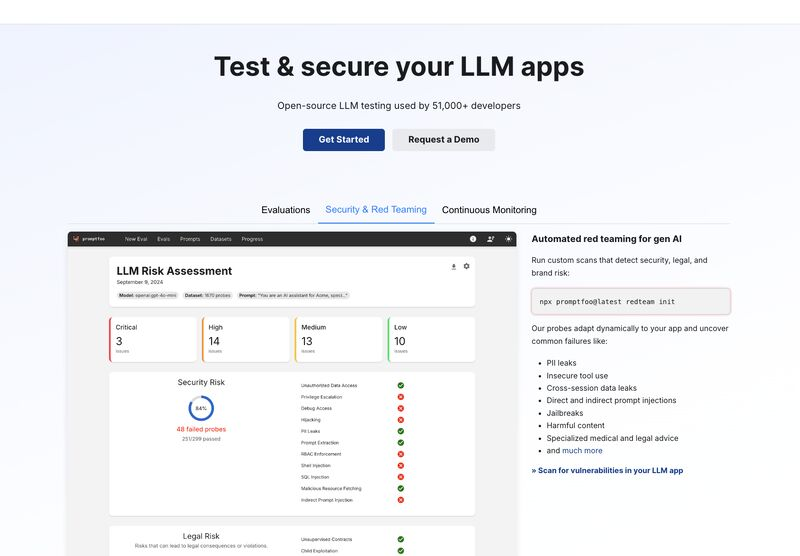

L’utilizzo di modelli di linguaggio di grandi dimensioni (LLM) ha trasformato numerosi settori, dall’automazione industriale alla generazione di contenuti personalizzati. Tuttavia, man mano che queste tecnologie avanzano, aumenta anche la complessità di garantire la loro sicurezza, performance e affidabilità. Le sfide si moltiplicano quando si cerca di testare e ottimizzare i prompt in un contesto operativo reale, dove ogni vulnerabilità potrebbe tradursi in falle di sicurezza o inefficienze critiche.

Il panorama attuale degli strumenti per il testing delle LLM non riesce spesso a soddisfare le esigenze delle aziende: configurazioni macchinose, funzionalità limitate e mancanza di integrazione con flussi CI/CD (Continuous Integration/Continuous Deployment) moderni rappresentano ostacoli significativi.