I ricercatori di DeepMind, la divisione di Google dedicata all’intelligenza artificiale, hanno recentemente svelato un nuovo metodo per accelerare l’addestramento dell’intelligenza artificiale (IA). Questa innovativa tecnica promette di ridurre significativamente le risorse computazionali e il tempo necessari per addestrare i modelli di IA, rendendo così lo sviluppo di queste tecnologie più veloce ed economico.

Categoria: Tech Pagina 18 di 21

L’intelligenza artificiale (AI) nel suo senso piu’ ampio e l’intelligenza esibita dai sistemi informatici (Machine)

Babylon Health è un’azienda britannica fondata a Londra nel 2013, che offre servizi sanitari di cure primarie attraverso una piattaforma digitale. Questa piattaforma, basata su un’applicazione installata su smartphone, consente agli utenti di accedere a consulenze mediche tramite videochiamate e messaggi di testo, oltre a fornire altre funzionalità come la gestione delle prescrizioni e la prenotazione di visite specialistiche.

In un mondo sempre più dominato dalle intelligenze artificiali, una nuova e promettente alternativa si fa strada: Moshi. Annunciato dal laboratorio francese di intelligenza artificiale Kyutai, Kyutai è co-fondato da Xavier Niel, fondatore e azionista di maggioranza del gruppo Iliad, Moshi si propone come una versione avanzata e multimodale delle attuali tecnologie linguistiche, come il celebre GPT-4.

In soli 6 mesi, con un team di 8 persone, il laboratorio di ricerca Kyutai ha sviluppato da zero un modello di intelligenza artificiale (AI) con capacità vocali senza precedenti chiamato Moshi

comunicato stampa in allegato

Questa innovativa piattaforma non solo promette di rivoluzionare il modo in cui le macchine interagiscono con il mondo, ma anche di superare le attuali limitazioni dei modelli basati esclusivamente su testo. Moshi presenta ancora alcune limitazioni. Attualmente l’assistente supporta solo la lingua inglese.

Cloudflare, una delle principali aziende di sicurezza internet al mondo, che dichiara di proteggere quasi il 20% del traffico web globale, ha recentemente introdotto una nuova funzionalità rivolta ai proprietari di siti web: un pulsante “easy button” per bloccare i servizi di intelligenza artificiale (IA) dall’accesso ai loro contenuti. Questa iniziativa risponde all’aumento esponenziale della domanda di contenuti utilizzati per l’addestramento dei modelli di IA.

La clonazione vocale tramite intelligenza artificiale (AI) è un campo in rapida crescita che sta trasformando il modo in cui interagiamo con la tecnologia. Microsoft, una delle principali aziende nel settore tecnologico, ha sviluppato una tecnologia avanzata che permette di replicare una voce con un campione di soli tre secondi. Sebbene questa innovazione offra opportunità straordinarie, solleva anche preoccupazioni significative riguardo alla sicurezza, alla privacy e all’etica.

Il “State of AI Report H1 2024” di Retool offre una panoramica dettagliata sull’adozione e l’uso dell’intelligenza artificiale (AI) nel settore tecnologico nella prima metà del 2024. Il rapporto esamina vari aspetti dell’AI, tra cui le tendenze nelle applicazioni aziendali, l’adozione delle tecnologie AI, i casi d’uso principali e le sfide affrontate dalle aziende.

Presentazione di Apple Vision Pro con funzionalità AI

L’attesissimo visore per realtà mista di Apple, Vision Pro, è destinato a portare l’elaborazione spaziale a nuovi livelli con l’integrazione della più recente tecnologia di intelligenza artificiale (AI) dell’azienda.

Mentre Apple Intelligence, la piattaforma AI del gigante della tecnologia, era stata inizialmente annunciata per i recenti computer Mac e iPhone 15 Pro, un nuovo rapporto di Bloomberg suggerisce che Apple sta lavorando attivamente per portare queste funzionalità AI avanzate anche su Vision Pro.

Vision Pro, presentato da Apple a giugno 2023, è un rivoluzionario computer spaziale che fonde perfettamente i contenuti digitali con il mondo fisico.

Grazie al visionOS personalizzato dell’azienda, il visore offre agli utenti una tela infinita per le app, esperienze di intrattenimento immersive e la possibilità di catturare e rivivere i ricordi in modo veramente tridimensionale.

Il modello Gen-3 Alpha di Runway, disponibile al pubblico dal 1° luglio 2024, rappresenta un grande passo avanti nella generazione di video con intelligenza artificiale. Accessibile con un abbonamento a partire da $12 al mese, questo modello avanzato permette di creare video ad alta fedeltà, coerenti e controllabili tramite prompt di testo, immagine o video, diventando uno strumento prezioso per registi, creatori di contenuti e altri professionisti creativi.

La condivisione di Ophira Orwits su Twitter riguardo alla tecnica di many-shot jailbreaking è un richiamo all’azione per la comunità AI.

Mentre l’intelligenza artificiale continua a progredire e a diventare sempre più integrata nelle nostre vite quotidiane, è essenziale affrontare le vulnerabilità e garantire che i modelli siano sicuri e affidabili. La collaborazione tra ricercatori, sviluppatori e responsabili delle politiche sarà cruciale per affrontare queste sfide e migliorare la sicurezza dei modelli linguistici, proteggendo così gli utenti e la società nel suo complesso.

Ci auguriamo che la pubblicazione sul jailbreaking many-shot incoraggi gli sviluppatori di LLM potenti e la comunità scientifica più ampia a considerare come prevenire questo jailbreak e altri potenziali exploit della finestra di contesto lunga. Man mano che i modelli diventano più capaci e hanno più potenziali rischi associati, è ancora più importante mitigare questo tipo di attacchi.

Grazie all’introduzione delle nuove schede NPU (Neural Processing Unit) di Tenstorrent sul cloud Seeweb, le aziende possono portare il training e l’inferenza di modelli di intelligenza artificiale a un livello superiore.

Queste NPU offrono una potenza di calcolo significativamente maggiore rispetto alle tradizionali GPU, consentendo di accelerare i carichi di lavoro AI in modo più efficiente.

Inoltre, l’adozione di queste soluzioni in cloud permette di ottimizzare i costi e ridurre i consumi energetici, in quanto le risorse vengono erogate in modalità “pay-per-use” senza la necessità di investimenti iniziali in hardware.

Google ha mantenuto la promessa di aprire al pubblico il suo modello AI più potente, Gemini 1.5 Pro, dopo la versione beta del mese scorso per gli sviluppatori. L’azienda ha recentemente annunciato l’integrazione di Gemini 1.5 Pro nell’app NotebookLM, destinata a ricercatori, studenti e altri utenti che necessitano di organizzare informazioni.

I ricercatori di Microsoft hanno scoperto una tecnica di jailbreak chiamata “Skeleton Key” che può superare le protezioni di molti modelli di intelligenza artificiale generativa, permettendo agli hacker di ottenere informazioni sensibili o dannose.

OpenAI ha presentato CriticGPT, un nuovo modello di intelligenza artificiale basato su GPT-4 progettato per identificare errori nel codice generato da ChatGPT, segnando un passo significativo verso il miglioramento della precisione e dell’affidabilità degli output generati dall’intelligenza artificiale, ricorda il personaggio Grillo di Pinocchio, Jiminy Cricket.

Il nuovo modello di intelligenza artificiale chiamato EMethylNET è in grado di rilevare 13 diversi tipi di cancro con una precisione del 98,2% utilizzando solo dati di metilazione del DNA da campioni di tessuto.[1] Questo modello di IA è stato sviluppato dai ricercatori dell’Università di Cambridge nel Regno Unito e potrebbe potenzialmente accelerare la diagnosi precoce, la diagnosi e il trattamento del cancro.

Intel ha presentato mercoledì il primo chiplet di interconnessione di calcolo ottico completamente integrato da utilizzare nell’intelligenza artificiale Il chiplet, noto come OCI, è assemblato con una CPU Intel e esegue dati in tempo reale.

La necessità di un Modello di Fondazione nella Previsione delle Serie Temporali

La previsione delle serie temporali gioca un ruolo cruciale in numerosi ambiti, dal piano della domanda nel retail e la previsione dei mercati finanziari fino alla meteorologia e alla gestione del traffico.

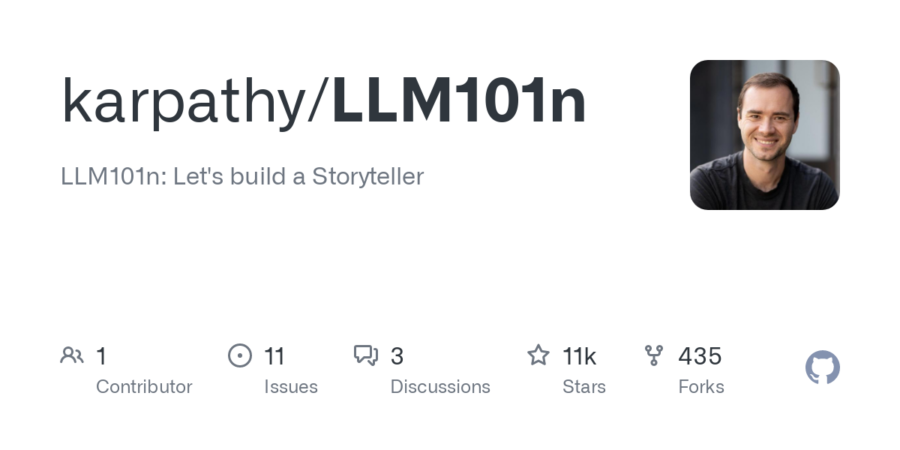

Andrej Karpathy, noto esperto di intelligenza artificiale e deep learning, ha recentemente annunciato l’apertura di un nuovo corso online intitolato “LLM101n: Let’s Build a Storyteller”. Questo corso si propone di guidare gli studenti nella costruzione di un modello di linguaggio di grandi dimensioni (Large Language Model o LLM) in grado di generare storie in modo collaborativo.

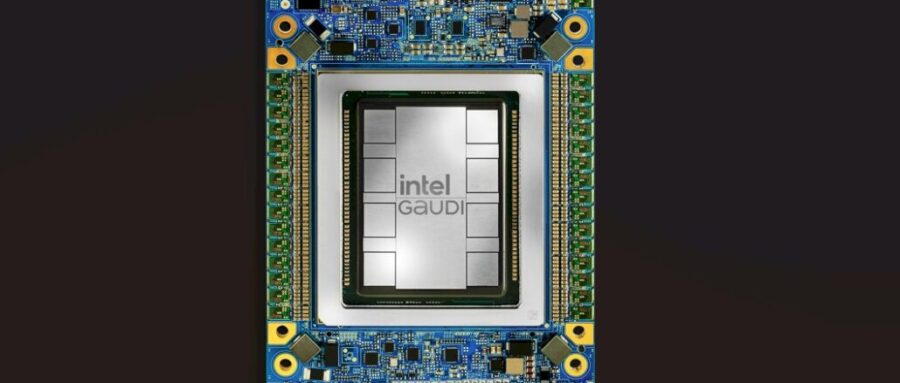

L’acceleratore AI Gaudi 3 di Intel si sta affermando come un’opzione economica rispetto all’H100 di Nvidia. Intel offre una scheda con otto processori Gaudi 3 a $125.000, a un prezzo molto inferiore rispetto a Nvidia, e sostiene di avere prestazioni migliori nei carichi di lavoro AI, secondo TechRadar e Ars Technica.

Costo Gaudi 3 vs. H100

Oggi siamo tutti dei followers e continuiamo a finanziare i grandi players che sono lontani dal nostro paese e dalle nostra Europa. Stiamo vivendo un periodo di innovazione nell’ambito dell’intelligenza artificiale! Ogni giorno sembra esserci una nuova innovazione che spinge oltre i limiti di ciò che le macchine possono fare. Uno dei settori di sviluppo più emozionanti è quello dei modelli linguistici di grandi dimensioni (LLM). Questi modelli stanno assumendo un ruolo centrale, impressionandoci con la loro capacità di generare testi simili a quelli umani e comprendere complessi schemi linguistici.

Indigo.ai è una startup italiana che si occupa di intelligenza artificiale (IA) e ha sviluppato una piattaforma per progettare assistenti virtuali, tecnologie di linguaggio e chatbot. La piattaforma “no-code” permette a chiunque in azienda di creare assistenti virtuali di ultima generazione, aumentando le vendite, migliorando la relazione con gli utenti e ottenendo insight sulla propria base clienti.

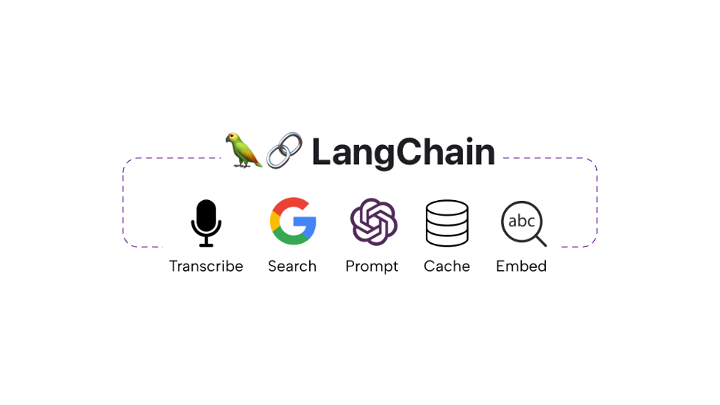

Quando ho iniziato a esplorare GenAI, ho commesso alcuni errori. L’argomento era immenso e mi sentivo piuttosto intimorito. Tuttavia, scoprire LangChain e i numerosi repository ed esempi open source ha semplificato il percorso (anche se con qualche frustrazione, ad essere sinceri). Ho avuto la fortuna di lavorare con un team straordinario, il che è stato fondamentale per l’esplorazione, l’apprendimento e il ricevimento di feedback.

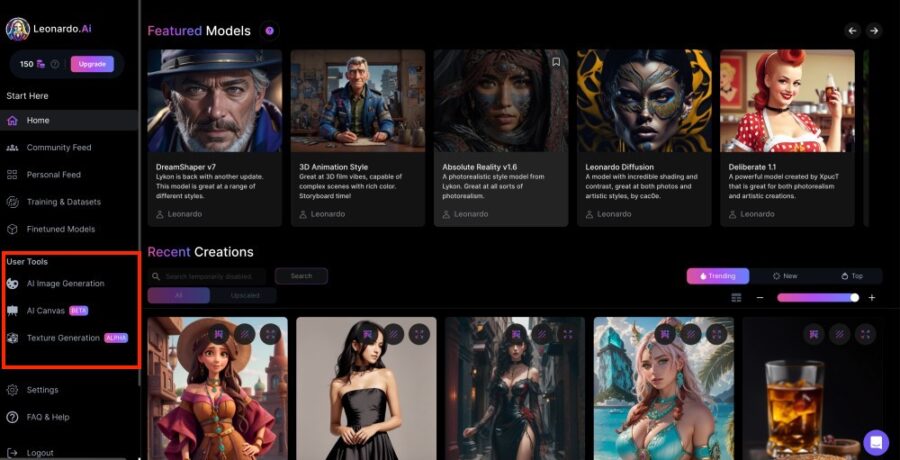

Leonardo AI, un potente generatore di immagini basato sull’intelligenza artificiale, ha recentemente lanciato un nuovo modello che promette di rivoluzionare la creazione di contenuti visivi. Questo strumento, noto per la sua versatilità e capacità di generare immagini di alta qualità, si è guadagnato una reputazione tra gli artisti e gli utenti di contenuti digitali.

La Trustworthy AI (TAI) è l’Intelligenza Artificiale sostenibile, affidabile, di cui ci si può fidare, che promuove il benessere degli esseri umani e dell’ambiente e rispetta i diritti umani fondamentali. È diventata una necessità sempre più urgente, poiché sulla fiducia si costruiscono le fondamenta delle società, delle economie e del loro sviluppo sostenibile.

L’intelligenza artificiale (AI) si concentra su elementi chiave come il ragionamento, la pianificazione e l’utilizzo di strumenti specifici, che sono essenziali per l’applicazione dell’AI in contesti complessi.

Una ricerca condotta da Tula Masterman (Neudesic) e colleghi ha evidenziato come gli agenti AI siano in grado di raggiungere obiettivi complessi.

Google DeepMind ha annunciato un modello di intelligenza artificiale chiamato V2A (video-to-audio) che può generare audio sincronizzato, compresi musica, effetti sonori e dialoghi, per input video. Questa tecnologia si propone di migliorare la realtà virtuale dei video generati da AI mediante la creazione di soundtrack appropriati direttamente dai pixel del video, senza bisogno di allineamento manuale o descrizioni di testo.

Generare Dati Sintetici con Nemotron-4 340B di NVIDIA

NVIDIA ha recentemente annunciato il rilascio di Nemotron-4 340B, una famiglia rivoluzionaria di modelli progettati per generare dati sintetici per l’addestramento di modelli di linguaggio su larga scala (LLM) in vari ambiti commerciali. Questo lancio rappresenta un importante passo avanti nell’intelligenza artificiale generativa, offrendo un insieme completo di strumenti ottimizzati per NVIDIA NeMo e NVIDIA TensorRT-LLM, inclusi modelli all’avanguardia per istruzioni e ricompense.

Luma AI (ne avevamo scritto recentemente) è una startup fondata nel 2021 con sede a San Francisco, che si concentra sulla creazione di tecnologia di intelligenza artificiale per generare contenuti 3D realistici da promemoria di testo o immagini. Il team di Luma AI è composto da esperti in campo di visione computerizzata, grafica e apprendimento automatico, con una visione condivisa di democratizzare la creazione di contenuti 3D attraverso l’IA. LUMA AI offre un’interfaccia intuitiva che consente agli utenti di creare contenuti 3D senza bisogno di formazione specializzata o attrezzature costose.

Affrontare GenAI e LLM potrebbe essere travolgente.

Gestire letteralmente tonnellate di informazioni, framework, guide, video e qualsiasi altro tipo di cosa disponibile GRATUITAMENTE per iniziare con GenAI e LLM potrebbe essere impegnativo.

Dopo una carriera di oltre 22 anni, posso affermare senza ombra di dubbio che lo sviluppo software è un’arte.

Come ogni forma d’arte, richiede impegno, talento e conoscenza. Anche se sembra un lavoro individuale per le abilità tecniche, in realtà dipende dall’interazione e collaborazione del team per ottenere risultati straordinari. Vedere per credere.

La ricerca recente sul campo dell’intelligenza artificiale (IA) ha visto un aumento significativo dell’attenzione verso l’utilizzo di modelli di linguaggio per compiti clinici.

Tuttavia, i dispositivi mobili e indossabili, come ad esempio dispositivi di monitoraggio della salute, forniscono dati longitudinali ricchi e personalizzati che possono essere utilizzati per monitorare la salute personale. In questo contesto, gli autori presentano il Personal Health Large Language Model (PH-LLM), un modello di linguaggio fine-tunato per comprendere e ragionare su dati di serie temporali numerici relativi alla salute personale.

Luma AI ha recentemente lanciato Dream Machine, un sistema di generazione di video basato sull’intelligenza artificiale che consente di creare scene realistiche e fantastiche da istruzioni di testo e immagini. Questo strumento, diverso da altri come Sora, è completamente aperto e disponibile per l’utilizzo gratuito da parte di tutti.

Stability AI ha annunciato l’uscita di Stable Diffusion 3 (SD3), il generatore di immagini più potente e open-source disponibile attualmente. Questo modello di intelligenza artificiale (IA) è stato progettato per generare immagini realistiche e dettagliate da descrizioni testuali, superando i migliori generatori di immagini AI esistenti per capacità di realismo fotografico.

Apple sta sviluppando l’intelligenza artificiale con la sua nuova suite di funzionalità Apple Intelligence su iPhone, iPad e Mac. Alcune richieste, con il permesso dell’utente, saranno inviate a ChatGPT di OpenAI.

Un dirigente afferma che i servizi di intelligenza artificiale di Apple usano un modello “blockchain” per garantire la privacy.

Dopo la presentazione di Apple, il vicepresidente senior dell’ingegneria del software Craig Federighi e il vicepresidente senior della strategia di machine learning e intelligenza artificiale John Giannandrea hanno parlato alla stampa insieme a Justine “iJustine” Ezarik.

Alla domanda su come Apple protegge la privacy dei clienti, Federighi ha detto che le richieste inviate ai server Apple sono anonime, con IP mascherati e senza registrazione delle informazioni.

Inoltre, il software del server sarà pubblico per la verifica da parte di ricercatori indipendenti, e i dispositivi interagiranno solo con server verificabili. Apple Intelligence è il sistema di intelligenza personale che porta potenti modelli generativi su iPhone, iPad e Mac.

Per funzionalità avanzate, abbiamo creato Private Cloud Compute (PCC), un sistema di intelligenza cloud progettato per l’elaborazione AI privata.

Ci sono quei momenti in cui trovi qualcosa di incredibile e dici WOW!

Queste sono state esattamente le mie parole quando ho visto per la prima volta LangChain Tools. Non avrei creduto a ciò che affermava la documentazione senza provarlo personalmente.

Molte altre aziende cinesi, dai più grandi giganti della tecnologia a una miriade di start-up, hanno fatto passi avanti nei propri sforzi di sviluppo LLM. Alibaba Cloud ha rilasciato Qwen2, la seconda versione della sua famiglia di modelli linguistici Tongyi Qianwen open source, utilizzata in chatbot come ChatGPT di OpenAI.

Include aggiornamenti come pre-formazione multilingue e una finestra di contesto ampliata, permettendo domande e risposte più lunghe, posizionandosi tra i LLM open source più potenti al mondo, include Tongyi Qianwen LLM, il modello di visione AI Qwen-VL e Qwen-Audio.

L’intelligenza artificiale (IA) è una tecnologia in rapida evoluzione che ha cambiato radicalmente il modo in cui viviamo e lavoriamo. Anthropic, una società di intelligenza artificiale, ha recentemente introdotto la sua famiglia di modelli Claude 3, che rappresenta un significativo progresso nel campo dell’IA generativa. In questo articolo, esploreremo le cinque fasi della maturità dell’IA di Anthropic, analizzando le sue caratteristiche, le sue applicazioni e le sue implicazioni per il futuro.

L’intelligenza artificiale, l’intelligenza artificiale generativa e i modelli linguistici di grandi dimensioni sono letteralmente ovunque.

Fino a poco prima dell’estate scorsa posso dire senza vergogna che non sapevo nulla sull’implementazione dell’intelligenza artificiale, per non parlare di come sviluppare soluzioni. Ero particolarmente scettico.

DuckDuckGo, noto per il suo motore di ricerca e browser web incentrato sulla privacy, ha lanciato un nuovo servizio che permette agli utenti di interagire con chatbot AI in modo privato e anonimo.

Il servizio, chiamato DuckDuckGo AI Chat e accessibile su Duck.ai, è disponibile a livello globale.

Raspberry Pi Foundation. Il piccolo e conveniente Raspberry Pi ha creato una grande comunità di fai-da-te, che usa questi computer delle dimensioni di una carta di credito per vari scopi, dai media center ai nodi Bitcoin. Raspberry Pi è molto usato per insegnare ai bambini a costruire e programmare computer, oltre che per altri progetti.

Realizzato in collaborazione con lo sviluppatore di processori di intelligenza artificiale Hailo, il kit AI Raspberry Pi è ora disponibile per l’aggiornamento del Raspberry Pi 5 e viene venduto al prezzo di $70, come dichiarato dall’organizzazione di beneficenza britannica.