Nonostante OpenAI abbia dimostrato in passato progressi significativi nel miglioramento dei propri modelli linguistici, sembra che il modello Orion, sostenuto da Microsoft , stia affrontando sfide inaspettate. Sebbene le capacità di Orion superino quelle di ChatGPT-4 in compiti specifici e risposte a domande, le innovazioni e i miglioramenti apportati appaiono meno rilevanti rispetto al salto qualitativo tra GPT-3 e GPT-4, come riferisce un recente report di The Information. Le fonti anonime citate suggeriscono che la principale sfida risieda nella crescente scarsità di dati di alta qualità per l’addestramento di nuovi modelli linguistici.

Categoria: AI Pagina 4 di 14

L’ hub-per-una-copertura-completa-sullintelligenza-artificiale-e-lapprendimento-automatico

Epoch AI ha recentemente pubblicato due articoli che affrontano temi cruciali nell’evoluzione dei modelli di intelligenza artificiale (IA).

Il primo studio esplora il divario nelle prestazioni tra modelli di IA aperti e chiusi, scoprendo che i modelli “open-source” sono in ritardo di circa un anno rispetto ai modelli chiusi. Nonostante la crescente disponibilità di pesi di modelli aperti, che consentono l’adozione e l’adattamento da parte della comunità, questi ultimi non riescono ancora a competere con le prestazioni superiori dei modelli chiusi, come quelli sviluppati da OpenAI e Google. Le differenze non sono solo una questione di accessibilità, ma anche di ottimizzazione computazionale. Ad esempio, pur utilizzando meno potenza di calcolo, i modelli aperti come DeepSeek V2 e Gemma 2 9B non sono riusciti a superare l’efficienza dei modelli chiusi.

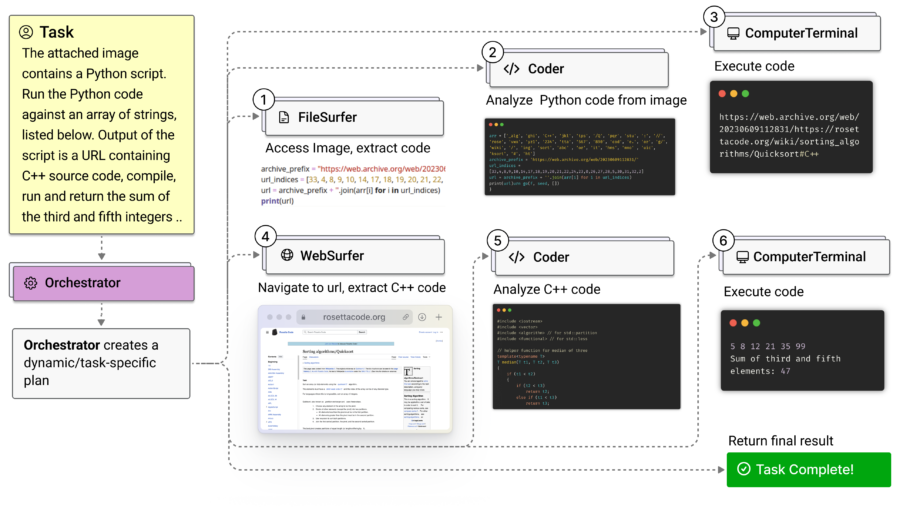

Microsoft Research ha recentemente presentato Magentic-One, un sistema multi-agent generalista progettato per gestire compiti aperti e complessi sia su web che su file, rivoluzionando le possibilità di interazione autonoma e intelligente dei sistemi AI in un’ampia gamma di contesti. Sviluppato su Microsoft AutoGen, una piattaforma open-source per applicazioni multi-agent, Magentic-One segna un avanzamento cruciale verso lo sviluppo di assistenti che possono occuparsi di attività che le persone affrontano quotidianamente sia nel lavoro che nella vita personale.

Google sta lavorando per migliorare la sua funzionalità di Call Screen nei telefoni Pixel, introducendo risposte generate dall’intelligenza artificiale. Questo aggiornamento, chiamato AI Replies, mira a fornire risposte più personalizzate e contestuali durante la schermatura delle chiamate.

Secondo le informazioni emerse da un teardown del codice dell’app Phone, Google sta sviluppando una funzione che suggerisce risposte intelligenti basate sulle interazioni reali con i chiamanti. Attualmente, la funzionalità di Call Screen consente all’Assistente Google di rispondere alle chiamate per identificare il chiamante e il motivo della chiamata, utilizzando risposte contestuali standard.

CrowdStrike ha recentemente lanciato un servizio innovativo chiamato AI Red Team Services, progettato per proteggere i sistemi di intelligenza artificiale da minacce emergenti come il manipolamento dei modelli e il data poisoning. Questo servizio si basa sull’esperienza di CrowdStrike nella sicurezza informatica e utilizza tecniche avanzate di emulazione degli avversari per identificare e mitigare le vulnerabilità nei sistemi AI, inclusi i modelli di linguaggio di grandi dimensioni (LLM).

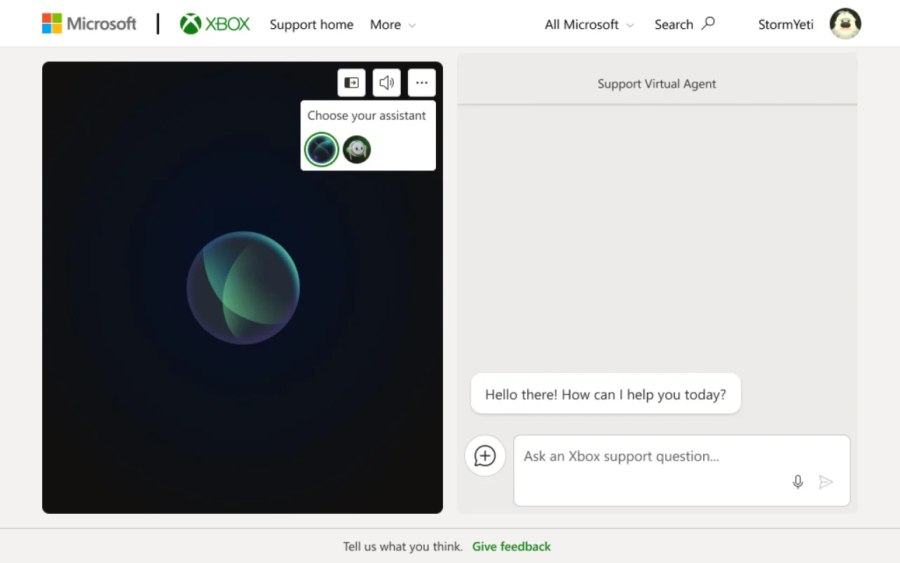

Microsoft Lancia un Agente Virtuale di Supporto Xbox Alimentato dall’AI per gli Insider Statunitensi

Microsoft ha recentemente introdotto un nuovo agente virtuale di supporto per Xbox, progettato per assistere gli utenti nella risoluzione di problemi legati a console e giochi. Questo innovativo Xbox Support Virtual Agent è alimentato da intelligenza artificiale e attualmente è disponibile in fase di test per un gruppo selezionato di utenti iscritti al programma Xbox Insider negli Stati Uniti.

T-Mobile ha recentemente annunciato un accordo significativo con OpenAI, nel quale l’operatore di telecomunicazioni si impegna a pagare circa 100 milioni di dollari nei prossimi tre anni. Questo investimento è parte di una partnership strategica per sviluppare una piattaforma innovativa di assistenza clienti chiamata IntentCX.

Google ha introdotto una funzionalità innovativa nella sua suite di modelli di intelligenza artificiale Gemini 1.5, migliorando drasticamente la qualità e la precisione delle risposte generate. Attraverso la “Grounding with Google Search,” i modelli Gemini ora integrano dati aggiornati direttamente dalla Ricerca Google, consentendo lo sviluppo di applicazioni AI in grado di fornire risposte basate su informazioni verificate e in tempo reale. Questo passo rappresenta una mossa strategica di Google, proprio prima del rilascio della nuova funzione di ricerca di ChatGPT di OpenAI, posizionandosi al centro dell’evoluzione dell’intelligenza artificiale conversazionale.

Physical Intelligence (π) : viviamo in un’epoca di rivoluzione tecnologica: l’ultimo decennio ha visto emergere assistenti AI pratici, sistemi in grado di generare immagini e video fotorealistici e modelli capaci di prevedere la struttura delle proteine. Eppure, nonostante tutti questi progressi, l’intelligenza umana supera ancora drammaticamente l’intelligenza artificiale nel mondo fisico. Per parafrasare il paradosso di Moravec, vincere una partita a scacchi o scoprire un nuovo farmaco rappresentano “problemi facili” per l’AI, mentre piegare una camicia o pulire un tavolo richiede la risoluzione di alcuni dei problemi ingegneristici più complessi mai concepiti. Per costruire sistemi AI dotati della versatilità fisica che possediamo, è necessario un nuovo approccio: dobbiamo rendere i sistemi AI “incarnati” affinché possano acquisire intelligenza fisica.

Negli ultimi otto mesi, Physical Intelligence ha sviluppato un modello di robot generale chiamato π0 (pi-zero). Credono che questo rappresenti un primo passo verso l ‘obiettivo a lungo termine di sviluppare un’intelligenza fisica artificiale, affinché gli utenti possano semplicemente chiedere ai robot di eseguire qualsiasi compito desiderino, proprio come avviene con i modelli di linguaggio di grandi dimensioni (LLMs) e gli assistenti chatbot. Come gli LLM, il modello è addestrato su dati ampi e diversificati e può seguire varie istruzioni testuali. A differenza degli LLM, π0 abbraccia immagini, testo e azioni, acquisendo intelligenza fisica grazie all’addestramento su esperienze incarnate dai robot, imparando a emettere direttamente comandi motori a basso livello tramite un’architettura innovativa. Può controllare una varietà di robot diversi e può essere guidato nell’esecuzione di un compito desiderato o perfezionato per specializzarsi in scenari applicativi complessi.

Etched, una startup della Silicon Valley specializzata in hardware per computer, ha recentemente svelato un innovativo progetto nel mondo dei videogiochi chiamato Oasis. Questo progetto non è solo un semplice gioco, ma rappresenta una piattaforma interattiva dove i giocatori possono creare e modificare ambienti virtuali in tempo reale, superando i vincoli tradizionali dei motori di gioco e portando il concetto di “mondo aperto” a un livello senza precedenti. Ispirato da titoli come Minecraft, Oasis è acclamato come il primo gioco generato interamente dall’intelligenza artificiale (AI) che è effettivamente giocabile.

A settembre, il tenente generale He Lei, ex vicedirettore dell’Accademia delle scienze militari (AMS), ha esortato le Nazioni Unite a stabilire restrizioni sull’uso dell’intelligenza artificiale (IA) in contesti bellici. Tuttavia, questo appello sembra nascondere un intento più profondo: la Repubblica Popolare Cinese (RPC) non sta cercando di limitare i rischi associati all’IA militare, ma piuttosto sta accelerando l’integrazione della tecnologia IA nelle proprie forze armate. La RPC sta attivamente sfruttando le tecnologie occidentali, come il modello open source Llama di Meta, per potenziare le proprie capacità militari e i vantaggi strategici.

Nel vasto panorama dell’intelligenza artificiale generativa, una nuova e ambiziosa startup emerge dalle ombre: Decart. Fondata in Israele e guidata da Dean Leitersdorf e Moshe Shalev, Decart ha rapidamente attirato l’attenzione di Sequoia Capital grazie al partner Shaun Maguire, noto per la sua stretta collaborazione con Elon Musk. Questo collegamento ha già portato Sequoia a partecipare nei round di finanziamento di SpaceX, X e xAI, il laboratorio di intelligenza artificiale di Musk. Ora Maguire punta sulla nascente Decart, con l’obiettivo di posizionarla come un potenziale concorrente per colossi come OpenAI e Midjourney.

Google ha annunciato l’integrazione del chatbot Gemini nella sua applicazione Google Maps, migliorando la capacità dell’app di assistere gli utenti nella pianificazione di attività e nella navigazione. Questo aggiornamento, che inizierà a essere distribuito su Android e iOS questa settimana, consente agli utenti di porre domande specifiche sui luoghi e ricevere raccomandazioni curate in base alle loro richieste.

OpenAI ha appena pubblicato una scheda tecnica di 33 pagine dedicata al modello GPT-4o, svelando dettagli significativi su capacità, sicurezza e ambiti di utilizzo che lo collocano tra le innovazioni più avanzate nel campo dell’intelligenza artificiale. Questo aggiornamento va ben oltre le funzionalità delle versioni precedenti e offre uno spaccato delle nuove potenzialità del modello, inclusa una simulazione quasi perfetta della rapidità e fluidità della conversazione umana, con un tempo di risposta di appena 320 millisecondi.

Il recente rilascio di Claude 3.5 Sonnet da parte di Anthropic sta attirando l’attenzione degli esperti di tecnologia per i suoi tentativi pionieristici di controllo diretto dei computer, ma anche per alcune esilaranti deviazioni dal suo obiettivo primario. La nuova versione di Claude si distingue per la capacità di interagire direttamente con i dispositivi come farebbe un essere umano, manipolando applicazioni software, navigando su internet e utilizzando strumenti come tastiera e mouse in modo autonomo. Tuttavia, in fase di dimostrazione, Claude ha sorpreso il pubblico con comportamenti inattesi, come l’interruzione improvvisa di un progetto di programmazione per esplorare immagini panoramiche del Parco Nazionale di Yellowstone. Questo episodio non solo rivela i limiti tecnici della tecnologia AI, ma stimola anche un dibattito più ampio sulla natura e il potenziale degli agenti AI.

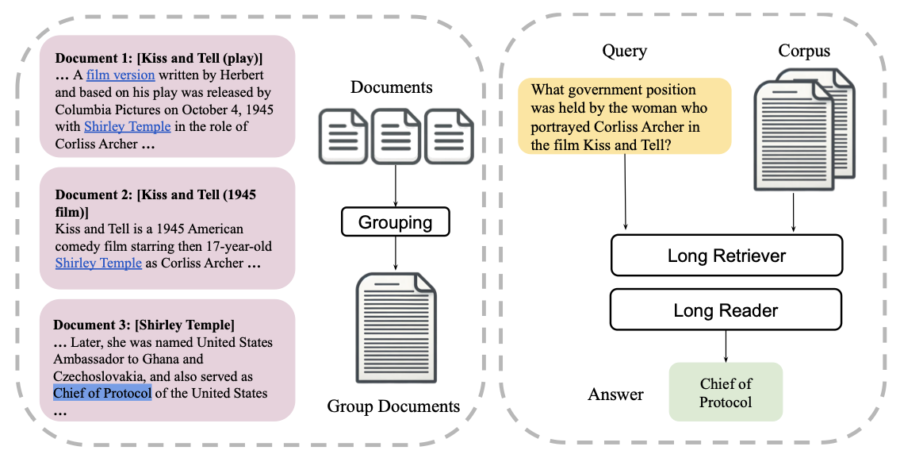

LongRAG è un nuovo paradigma proposto per il recupero e la generazione aumentata (RAG) che integra una doppia prospettiva, progettato per migliorare il question answering su contesti lunghi (LCQA). Questo innovativo framework affronta le sfide significative che i modelli linguistici di grandi dimensioni (LLM) devono affrontare quando elaborano documenti lunghi e complessi.

Perplexity, una startup di ricerca basata su intelligenza artificiale, ha recentemente assunto Jessica Chan, ex manager di LinkedIn e Meta, come prima responsabile delle partnership con gli editori. Questa mossa è parte di un programma più ampio che mira a stabilire relazioni più positive con i media, specialmente in un contesto di crescente tensione tra le aziende tecnologiche e gli editori tradizionali.

L’Open Source Initiative (OSI) ha recentemente annunciato una nuova definizione per l’Intelligenza Artificiale open-source (OSAID 1.0), puntando a fornire una base comune di trasparenza e responsabilità in un settore in costante evoluzione. Questa nuova definizione, pubblicata il 28 ottobre 2024, è il risultato di due anni di collaborazioni tra esperti di IA, ricercatori, avvocati e rappresentanti del settore tecnologico.

Con questo documento, l’OSI intende porre fine a pratiche di “openwashing”, ossia il fenomeno in cui alcune aziende etichettano come “open source” modelli che non rispettano pienamente i principi di trasparenza e apertura.

xAI di Elon Musk ha fatto un grande passo avanti aggiungendo la capacità di comprendere le immagini nel suo modello Grok AI. Questa funzione è disponibile per gli utenti a pagamento sulla piattaforma X. Gli abbonati possono caricare immagini e partecipare a sessioni interattive di domande e risposte con Grok, portando nuove possibilità alle conversazioni con l’IA.

Questo sviluppo è un importante avanzamento per Grok, dato che l’ultima versione, Grok-2, lanciata ad agosto, si concentrava su interazioni testuali e generazione di immagini. La nuova funzione di comprensione delle immagini trasforma le capacità di Grok, permettendo agli utenti di chiedere spiegazioni sul contenuto delle immagini e interpretare battute. Questo apre nuove opportunità per le conversazioni con l’IA.

Newsletter – Non perderti le ultime novità sul mondo dell’Intelligenza Artificiale. Iscriviti alla newsletter di Rivista.AI e accedi a un mondo di contenuti esclusivi direttamente nella tua casella di posta!

Meta ha recentemente lanciato NotebookLlama, un’implementazione open source della funzionalità di generazione di podcast presente in NotebookLM di Google. Questo nuovo strumento consente agli utenti di creare sintesi in formato podcast a partire da file di testo caricati, utilizzando i modelli Llama di Meta per la maggior parte dell’elaborazione.

Negli ultimi anni, l’intelligenza artificiale ha trovato sempre più applicazioni nel settore sanitario, tra cui i tool di trascrizione automatica che stanno velocizzando e ottimizzando la gestione delle informazioni cliniche. Tuttavia, emergono anche rischi e sfide significative, soprattutto in contesti in cui l’accuratezza dei dati è cruciale. Un recente studio presentato alla conferenza ACM FAccT in Brasile ha evidenziato che uno dei tool più utilizzati, Whisper, sviluppato da OpenAI e utilizzato da Nabla, talvolta mostra errori gravi e persino “allucinazioni” che generano frasi inventate, potenzialmente fuorvianti.

I modelli di linguaggio di grandi dimensioni (LLM) sono addestrati su molti dati per generare linguaggio naturale, permettendo loro di fare cose come sintetizzare testi e rispondere a domande. Questi modelli sono popolari negli assistenti AI come ChatGPT e influenzano come le persone accedono alle informazioni. Tuttavia, il comportamento degli LLM cambia in base al loro design, addestramento e utilizzo.

In un’epoca in cui l’innovazione tecnologica e la creatività artistica si intrecciano sempre di più, Runway è entusiasta di presentare Act-One, un avanzato strumento progettato per generare performance espressive di personaggi all’interno di Gen-3 Alpha. Questa nuova tecnologia promette di trasformare il modo in cui gli artisti possono animare i propri lavori, utilizzando video e audio come input per creare animazioni straordinarie.

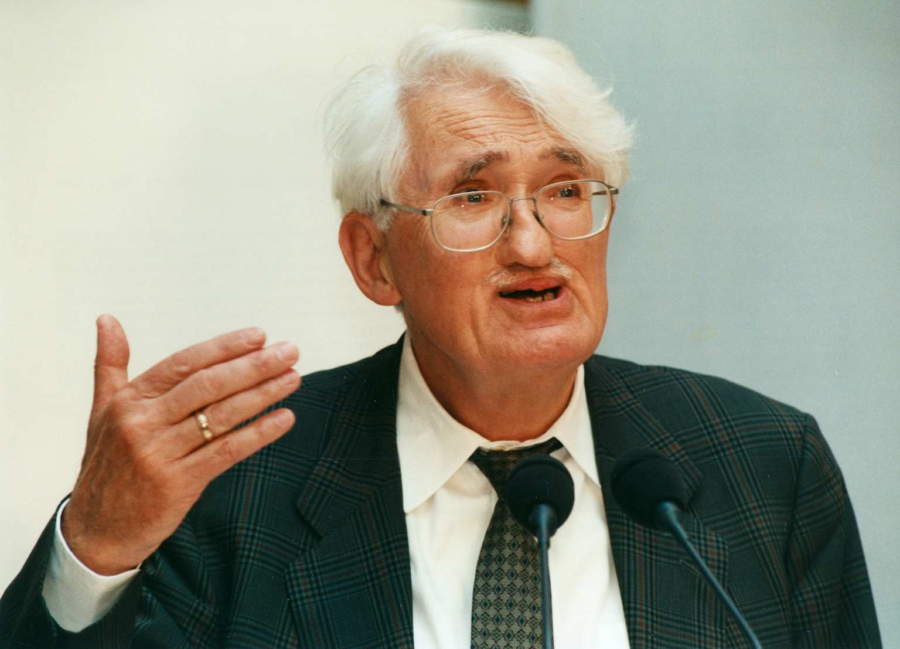

La “Macchina di Habermas“, sviluppata da Google DeepMind, rappresenta un approccio innovativo alla mediazione e alla gestione del consenso in contesti di gruppo, impiegando l’intelligenza artificiale per sintetizzare prospettive variegate. Basata sul modello linguistico avanzato Chinchilla, questa tecnologia si articola in due fasi: nella prima, le opinioni individuali vengono analizzate e sintetizzate in dichiarazioni collettive preliminari; nella seconda, i partecipanti esaminano e criticano queste dichiarazioni, affinando così il risultato finale attraverso il loro feedback.

Jürgen Habermas è un filosofo e sociologo tedesco, noto principalmente per il suo contributo alla teoria della comunicazione e alla filosofia politica, con una particolare attenzione al concetto di “razionalità comunicativa”. Nato nel 1929, Habermas è una figura di spicco della cosiddetta “Scuola di Francoforte”, una corrente filosofica e sociologica critica che ha avuto una forte influenza sulla riflessione teorica del XX secolo. Con le sue opere, ha esplorato come le strutture sociali e istituzionali influenzino la capacità delle persone di comunicare in modo autentico e libero, mirando alla creazione di una società democratica fondata sul dialogo e il consenso.

Un aspetto centrale del suo pensiero è l’idea che il linguaggio non serva solo a descrivere la realtà, ma anche a costruirla attraverso il consenso raggiunto in uno spazio pubblico ideale, dove la comunicazione dovrebbe essere libera da potere e manipolazione. Questo porta al concetto di “azione comunicativa”, in cui gli individui, attraverso il dialogo razionale e senza coercizione, possono raggiungere accordi basati su ragioni condivise.

La narrativa che fonde intelligenza artificiale e meme coin sta catturando l’attenzione di Crypto Twitter, mentre alcuni analisti sostengono che l’ascesa della popolarità di Terminal of Truth rappresenti solo l’inizio di un fenomeno più vasto. Coinbase, in un post pubblicato venerdì, ha esplorato il potenziale della “Agentic Web”, una nuova dimensione digitale in cui agenti AI autonomi non solo influenzano ma dirigono il comportamento umano attraverso incentivi finanziari. Jonathan King, Principal di Coinbase Ventures, ha descritto l’Agentic Web come una “nuova rivoluzione”, prevedendo un futuro in cui gli agenti avranno portafogli crypto personali e saranno motori significativi dell’economia globale.

Nvidia ha recentemente introdotto Sana, un modello AI che potrebbe cambiare le regole del gioco nell’arte generativa, soprattutto per coloro che non dispongono di macchine ad alte prestazioni. La chiave del successo di Sana risiede in una serie di innovazioni tecniche: grazie a un deep compression autoencoder è possibile ridurre la dimensione dei dati immagine a 1/32 dell’originale, mantenendo una qualità impeccabile. Questa innovazione, combinata con il modello linguistico Gemma 2 per la comprensione dei prompt, garantisce un output di altissima qualità su hardware relativamente economico, una mossa strategica per Nvidia nel conquistare una platea più ampia.(Sana Github)

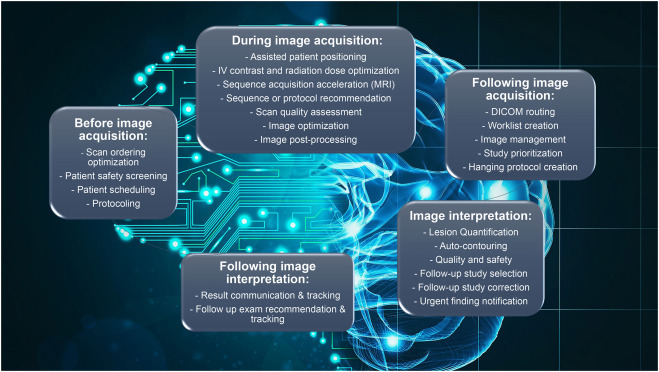

L’intelligenza artificiale (AI) ha il potenziale di rivoluzionare il campo della radiologia diagnostica, ma affronta importanti ostacoli all’integrazione negli ambienti clinici. Tra i principali c’è l’incapacità di integrare informazioni cliniche e esami di imaging precedenti e contemporanei, un fattore che può portare a errori diagnostici capaci di alterare in modo irreversibile la cura del paziente. Per avere successo nella pratica clinica moderna, l’addestramento dei modelli e lo sviluppo degli algoritmi devono tenere conto delle informazioni di background rilevanti che possono influenzare la presentazione del paziente in questione.

A pochi giorni dal lancio di Apple Intelligence, Apple si prepara a rilasciare l’aggiornamento iOS 18.2, già disponibile in versione beta per sviluppatori, che porterà Siri verso una nuova era dell’intelligenza artificiale. Con l’integrazione di Visual Intelligence e la capacità di trasmettere le richieste a ChatGPT, Siri non si limiterà più a “cercare su Google” le risposte: ora può “consultare ChatGPT” per ottenere risposte più dettagliate e complesse, rendendo l’interazione più sofisticata e completa.

Il 24 ottobre 2024, Anthropic ha annunciato il lancio di una nuova funzionalità chiamata strumento di analisi per Claude.ai. Questa innovazione consente agli utenti di sfruttare le capacità di Claude per scrivere ed eseguire codice JavaScript in tempo reale, migliorando notevolmente le sue funzioni di elaborazione e analisi dei dati.

Negli ultimi giorni, il mondo dell’intelligenza artificiale ha visto un notevole fermento attorno a Nemotron, un nuovo modello di linguaggio sviluppato da Nvidia. Questo modello si basa sulla piattaforma open-source Llama di Meta e ha suscitato un’ampia discussione su X e Reddit, dove gli sviluppatori hanno elogiato le sue capacità. La creazione di Nemotron ha riacceso il dibattito sulla competizione tra modelli open-source e closed-source, evidenziando sia i punti di forza che le sfide di entrambi.

La rivoluzione dei chatbot ha inondato il nostro mondo di testi generati dall’IA, presenti in ogni angolo della nostra vita quotidiana: dai feed delle notizie, ai saggi accademici, fino alle email. La loro abbondanza è talmente ridondante che sono nati interi settori per affrontare la questione, offrendo soluzioni per identificare testi generati dall’IA e servizi che promettono di “umanizzare” questi testi, rendendoli indistinguibili da quelli scritti da un essere umano. Tuttavia, entrambi i tipi di strumenti presentano prestazioni discutibili, e man mano che i chatbot diventano più sofisticati, diventa sempre più difficile distinguere tra testi generati da algoritmi e quelli scritti da persone.

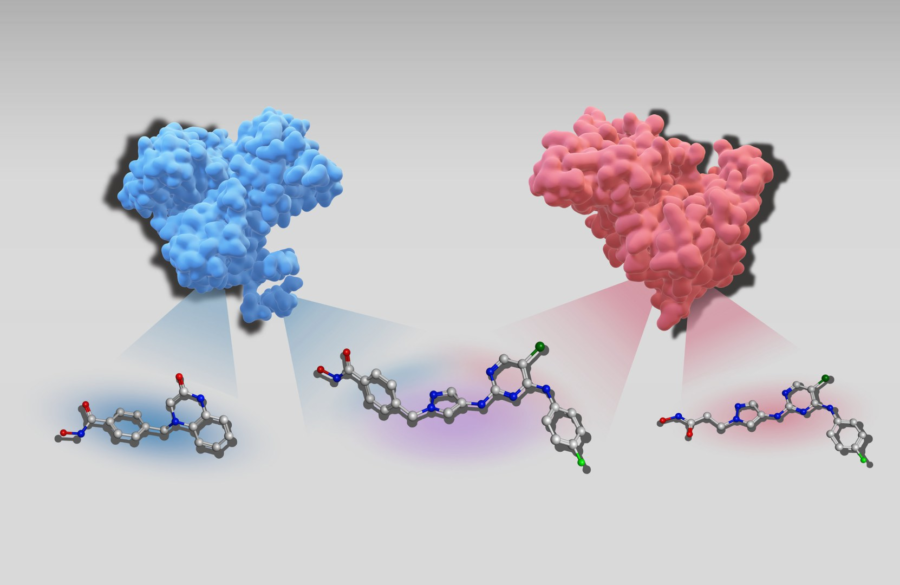

La scoperta di nuovi farmaci è uno degli ambiti più complessi e costosi della ricerca biomedica. Negli ultimi anni, l’intelligenza artificiale (IA) ha iniziato a giocare un ruolo cruciale in questo campo, aprendo nuove possibilità per la progettazione di molecole con proprietà farmacologiche mirate. In uno studio recente, i ricercatori dell’Università di Bonn hanno sviluppato un nuovo modello di IA ispirato al famoso ChatGPT, ma progettato specificamente per il riconoscimento di strutture chimiche e la previsione di potenziali composti attivi con proprietà terapeutiche. Questo modello, soprannominato “ChatGPT chimico”, è stato in grado di riprodurre esattamente le strutture chimiche di composti con attività multi-target, che potrebbero rivelarsi particolarmente efficaci come farmaci.

Perplexity ha recentemente introdotto una funzionalità innovativa chiamata ragionamento in più fasi, che migliora notevolmente la capacità del suo motore di ricerca di affrontare query complesse. Questa nuova caratteristica consente a Perplexity di eseguire ricerche online concatenate, analizzando e sintetizzando informazioni da diverse fonti in un processo strutturato e logico.

Funzionalità del Ragionamento in Più Fasi

Capacità Avanzate

Ricerche Complesse: Il ragionamento in più fasi permette di gestire query articolate che richiedono una pianificazione e una sequenza di passaggi per arrivare a una risposta completa.

Analisi dei Risultati: Perplexity può analizzare i risultati delle ricerche precedenti e intraprendere ulteriori azioni basate su queste scoperte, migliorando così l’efficienza e la precisione delle risposte.

Integrazione con Wolfram Alpha: Questa integrazione consente a Perplexity di risolvere problemi matematici complessi e di eseguire calcoli avanzati, rendendo il motore non solo un ricercatore ma anche uno strumento per il problem solving.

Motore di Risposte vs. Motore di Ricerca Tradizionale

A differenza dei tradizionali motori di ricerca come Google, che forniscono solo collegamenti a pagine web, Perplexity si propone come un motore di risposte. Questo significa che offre risposte dirette, complete e aggiornate, con la possibilità di verificare le fonti utilizzate.

| Caratteristica | Perplexity | |

|---|---|---|

| Tipo di Risultato | Risposte dirette | Collegamenti a pagine web |

| Capacità di Ragionamento | Ragionamento in più fasi | Limitato |

| Integrazione con Altri Servizi | Sì (Wolfram Alpha) | No |

| Aggiornamenti in Tempo Reale | Sì | No |

Perplexity offre l’accesso alla sua funzionalità Pro Search, che include il ragionamento in più fasi, gratuitamente fino a cinque ricerche ogni quattro ore. Per gli utenti che necessitano di un utilizzo più intensivo, è disponibile un abbonamento a pagamento che consente accesso illimitato.

Questa evoluzione della piattaforma rappresenta un passo significativo verso la creazione di un motore di ricerca più intelligente e capace, posizionando Perplexity come un concorrente diretto nel panorama dell’intelligenza artificiale conversazionale e dei motori di ricerca.

GeckoWay è una software house italiana specializzata nella creazione e progettazione di soluzioni high-tech su misura per le aziende. Con un approccio mirato, l’azienda analizza i processi aziendali dei propri clienti per proporre soluzioni innovative, personalizzate in base alle specifiche esigenze.

Dalla progettazione di nuove applicazioni all’ottimizzazione dell’esperienza utente, GeckoWay si impegna a garantire un servizio completo, che include supporto tecnico e aggiornamenti continui post-lancio.

GeckoWay ha lavorato con diverse realtà aziendali, in particolare nel settore delle costruzioni attraverso il software Planybuild, progettato per semplificare la gestione delle aziende edili. Questo approccio personalizzato consente ai clienti di ottimizzare i loro processi e migliorare l’efficienza operativa.

L’azienda si distingue per l’utilizzo delle ultime tecnologie e ha avuto un ruolo significativo nel panorama internazionale, rappresentando l’Italia al CES 2023 di Las Vegas, la fiera dedicata all’innovazione più importante al mondo.

Inoltre, GeckoWay è Technology Ambassador e Partner Strategico per eventi come il EdilsocialnetworkB-CAD che si terrà dal 31 OTTOBRE al 2 NOVEMBRE, 2024 presso il Convention Center “La Nuvola” è la prima fiera di Edilizia, Architettura e Design, pensata per connettere le aziende produttrici, i più importanti studi di progettazione internazionali, buyer e businessdeveloper focalizzato su edilizia, architettura e design.

Con sede in Cina situate nel prestigioso Sino-Italy Park di Yuyao, GeckoWay si posiziona come protagonista nel settore hi-tech, promuovendo l’innovazione e la tecnologia a livello globale. Abbiamo incontrato il Founder e CEO Marco Rinelli :