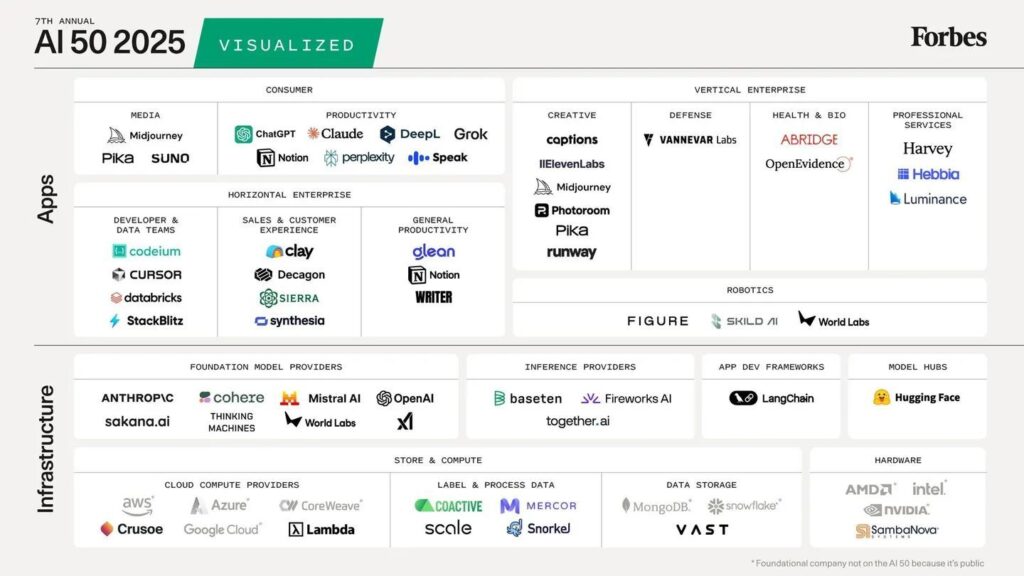

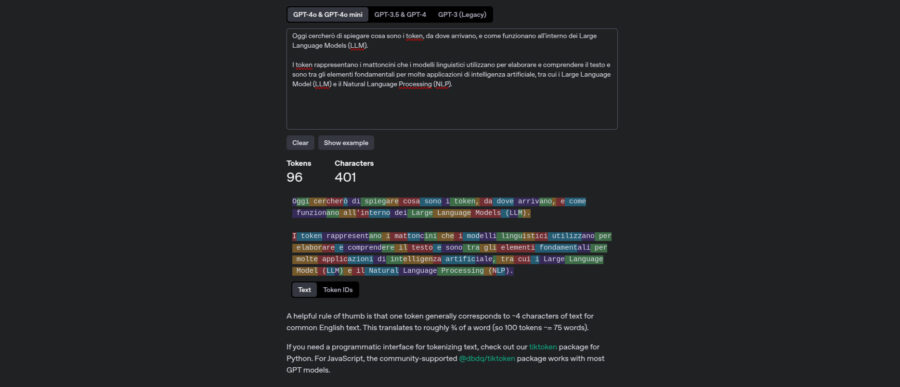

Quando si parla di intelligenza artificiale generativa, la maggior parte dei contenuti là fuori ha la stessa consistenza di una presentazione PowerPoint per investitori in fase seed: elegante, ma vuota. In un contesto in cui tutti sembrano esperti, ma pochi hanno realmente orchestrato l’implementazione di centinaia di agenti AI, non sorprende che le scelte sui modelli linguistici si riducano spesso a “quale è più cool oggi su Twitter”.

Il punto è che non serve un benchmark da laboratorio, ma una strategia da campo. I modelli linguistici AI non vanno scelti in base al marketing di chi li produce, ma in base alla geometria dei task da risolvere. Basta con la religione del “migliore in assoluto”. L’unico criterio che conta è l’adattabilità al contesto operativo. Il resto è rumore.