Il panorama dell’intelligenza artificiale è frammentato e caotico, con aziende e sviluppatori che faticano a gestire tool diversi, costi poco chiari e problemi di privacy. I modelli SaaS impongono vincoli ai vendor, mentre l’uso di API cloud apre scenari di rischio per la sicurezza dei dati. La scalabilità è un enigma complesso e l’integrazione di modelli multimodali è spesso un incubo per gli sviluppatori.

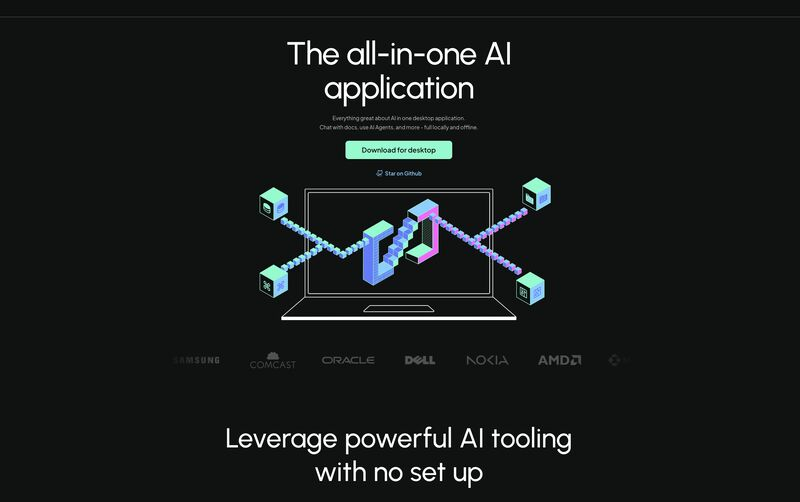

𝗔𝗻𝘆𝘁𝗵𝗶𝗻𝗴𝗟𝗟𝗠 si propone come la soluzione definitiva a questi problemi, offrendo un ambiente AI self-hosted, con Retrieval-Augmented Generation (RAG), agenti AI e controllo granulare delle operazioni. Si tratta di una piattaforma open-source che combina potenza, flessibilità e trasparenza.

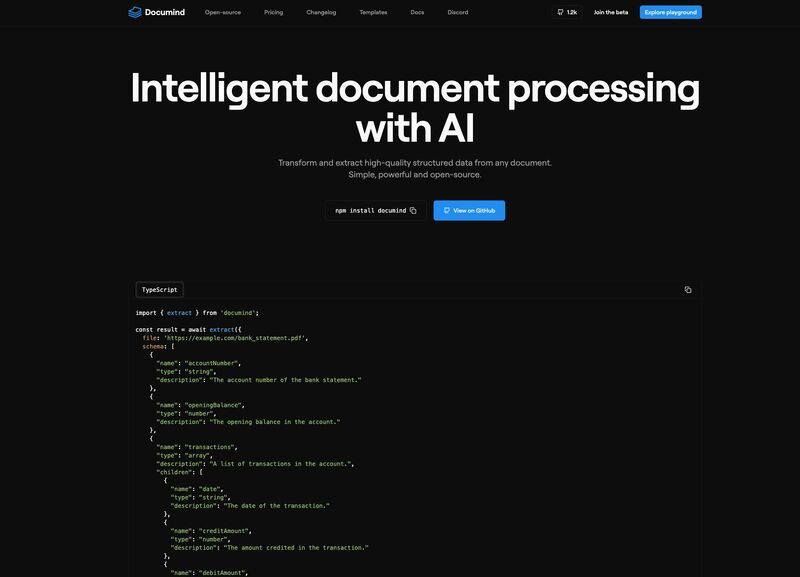

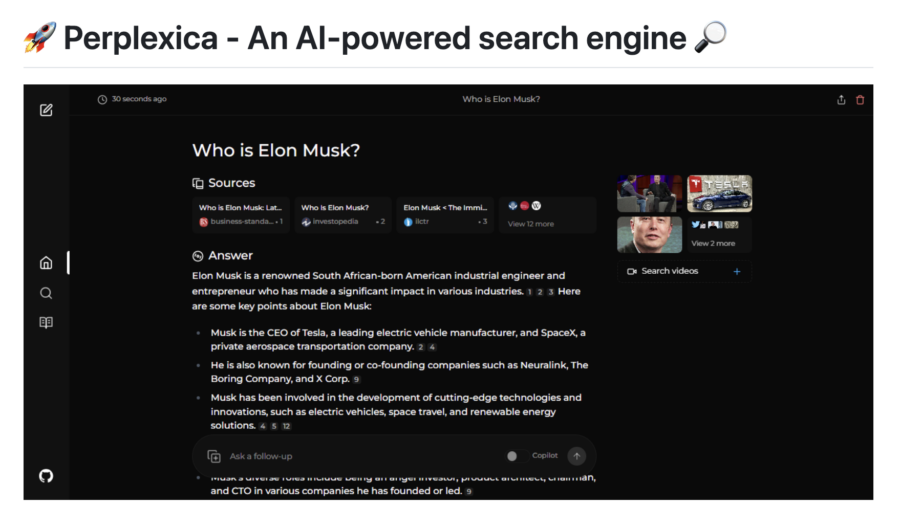

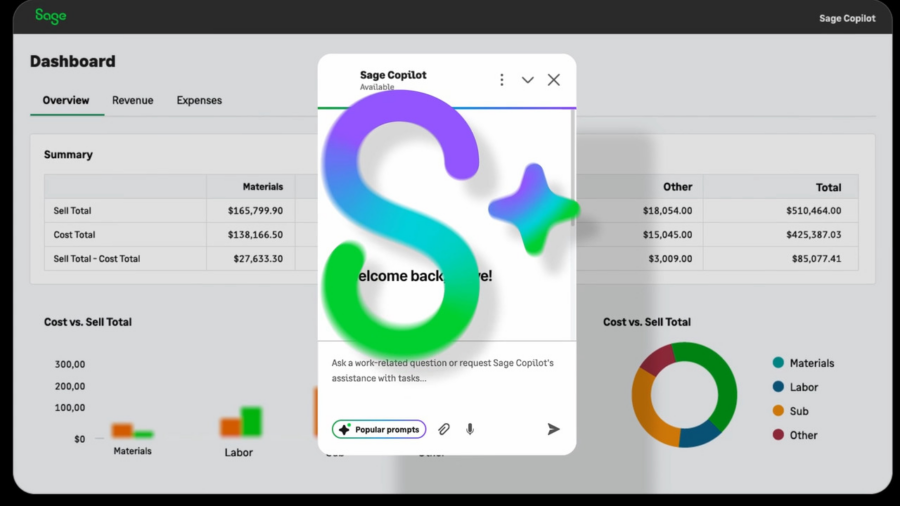

Le sue caratteristiche distintive comprendono un hub per modelli multi-LLM, un sistema di RAG che consente di interagire con documenti e siti web mantenendo il controllo dei dati, e agenti AI avanzati capaci di navigare il web, eseguire codice e orchestrare workflow personalizzati.

La sua flessibilità è evidente nelle opzioni di deployment: può essere eseguito localmente su desktop o scalato tramite Docker e Kubernetes. A livello enterprise, offre gestione utenti avanzata, audit log e politiche di accesso dettagliate. Un altro vantaggio competitivo è la trasparenza dei costi, eliminando i sovrapprezzi sulle query AI e le fee per utente tipiche dei servizi SaaS.

La community open-source di 𝗔𝗻𝘆𝘁𝗵𝗶𝗻𝗴𝗟𝗟𝗠 è in forte crescita, con oltre 3.000 stelle su GitHub e un ecosistema in espansione. Gli sviluppatori trovano strumenti robusti, API complete, widget web e un’estensione browser preconfigurata. Inoltre, offre una soluzione all-in-one per sostituire molteplici strumenti, consolidando chatbot, analisi documentale e automazione in un’unica piattaforma.

L’approccio orientato alla sovranità dei dati è un altro elemento chiave: l’hosting può avvenire su database locali come LanceDB, Chroma o Pinecone, garantendo totale indipendenza dal cloud.

𝗔𝗻𝘆𝘁𝗵𝗶𝗻𝗴𝗟𝗟𝗠 non è solo un framework AI, ma un cambio di paradigma per chi cerca potenza, privacy e controllo senza compromessi.

Repository: https://github.com/Mintplex-Labs/anything-llm

Website: https://anythingllm.com/