Green Tech Innovation – Negli ultimi anni, l’intelligenza artificiale (AI) ha visto una crescita esponenziale, con applicazioni che spaziano dalla medicina alla robotica, dalla finanza all’intrattenimento. Tuttavia, questa crescita è stata accompagnata da un problema fondamentale: il consumo massiccio di risorse. I modelli di AI più avanzati, come i modelli linguistici di grandi dimensioni (LLM), richiedono enormi quantità di dati, potenza computazionale e energia. Questo ha sollevato interrogativi etici, ambientali e finanziari, spingendo verso un approccio più sostenibile, noto come Frugal AI.

Autore: Dina Pagina 21 di 33

Direttore senior IT noto per migliorare le prestazioni, contrastare sfide complesse e guidare il successo e la crescita aziendale attraverso leadership tecnologica, implementazione digitale, soluzioni innovative ed eccellenza operativa.

Con oltre 20 anni di esperienza nella Ricerca & Sviluppo e nella gestione di progetti di crescita, vanto una solida storia di successo nella progettazione ed esecuzione di strategie di trasformazione basate su dati e piani di cambiamento culturale.

La discussione sulle politiche di intelligenza artificiale (IA) si sta intensificando, con richieste sempre più diffuse per approcci “basati sulle prove”. Questo concetto implica che le decisioni politiche debbano essere informate da analisi empiriche e dati scientifici. Tuttavia, questo articolo evidenzia le tensioni esistenti tra l’esigenza di regole chiare e il rischio di immobilismo decisionale.

Da secoli, gli esseri umani automatizzano compiti per migliorare l’efficienza. Con l’avvento dell’intelligenza artificiale (AI), questa ricerca dell’efficienza ha fatto un enorme balzo in avanti, e ora le aziende tecnologiche vedono un potenziale di profitto in questa direzione. La loro soluzione? Gli “agenti” AI.

Sequoia Capital, ha pubblicato un interessante articolo intitolato “Generative AI’s Act o1,” rappresenta un’analisi approfondita dell’evoluzione dell’intelligenza artificiale generativa. Questo campo, in rapida espansione, sta trasformando il modo in cui interagiamo con la tecnologia e come possiamo sfruttarla per risolvere problemi complessi.

Il mondo dell’intelligenza artificiale (AI) sta vivendo un’evoluzione rapida, e con essa cresce la necessità di strumenti adeguati per valutare le capacità degli agenti AI nel campo dell’ingegneria del machine learning. In questo contesto, i ricercatori di OpenAI hanno recentemente presentato MLE-bench, un benchmark innovativo progettato per misurare le prestazioni degli agenti AI in una serie di compiti complessi legati al machine learning

.

Dario Amodei è un imprenditore e ricercatore statunitense di origini italiane. Dario Amodei, nato nel 1983 subito dopo l’arrivo dei genitori negli USA, il padre è toscano, di Massa Marittima, la madre è americana, di Chicago.

Nel 2006 si laurea in Fisica a Stanford e subito dopo intraprende un Dottorato all’Università di Princeton. È il fondatore e CEO di Anthropic, l’azienda che ha sviluppato la famiglia di large language model nota come Claude. È stato vice president of research di OpenAI.

“Machines of Loving Grace” di Dario Amodei è un saggio recente che presenta una visione coinvolgente del futuro plasmato dall’intelligenza artificiale (IA). Pubblicato nell’ottobre 2024, il saggio ha attirato l’attenzione per la sua esplorazione approfondita di come l’IA potrebbe trasformare significativamente la società nei prossimi dieci anni.

Capitolo 1: l’ombra di Bletchley Park

In una mattina grigia del 1943, la nebbia si sollevava lentamente su Bletchley Park, il cuore pulsante della lotta contro il nemico. Il suono della pioggia che batteva contro i vetri delle finestre era una sinfonia familiare per Alan Turing. Le sue mani, abili e precise, sfioravano le pagine ingiallite dei suoi appunti, dove formule matematiche e schemi complessi si mescolavano con pensieri caotici. Il suo sguardo, sempre penetrante, si perdeva nei dettagli dei suoi calcoli, mentre il resto del mondo sembrava sfumare in un’eco lontana.

Il veicolo spaziale Psyche della NASA è stato raffigurato mentre riceve un segnale laser dalla stazione di collegamento del Deep Space Optical Communications (DSOC) presso la struttura di Table Mountain del Jet Propulsion Laboratory (JPL) in California, in questo concept artistico. L’esperimento DSOC è composto da una stazione di collegamento in uplink e downlink, oltre a un trasmettitore laser di bordo che vola insieme alla sonda Psyche.

Dopo i test di novembre ( 63 Mbps), il nuovo test ha inviato sulla Terra un video di un gatto che gioca con un puntatore laser (richiamando l’idea dei sistemi ottici per la comunicazione). Questo test aveva solo scopo dimostrativo, quindi è stato scelto un video divertente. Il JPL ha anche fatto sapere che il gatto nel video si chiama Taters ed è di un dipendente del JPL.

Sarah Friar è una figura prominente nel settore tecnologico, con una carriera che si estende per oltre due decenni. Prima di unirsi a OpenAI, ha ricoperto il ruolo di CFO presso Square (ora Block, Inc.), dove ha contribuito a trasformare l’azienda in un leader nel settore dei pagamenti digitali. Durante il suo mandato, ha guidato la società attraverso un’importante IPO e ha gestito le finanze in modo strategico per supportare la crescita.

In precedenza, Friar ha lavorato come Vice President of Finance presso Salesforce, dove ha supervisionato le operazioni finanziarie globali. Ha anche ricoperto ruoli significativi presso Goldman Sachs.

Friar è laureata in Ingegneria Elettrica presso la Stanford University e ha conseguito un MBA presso la Wharton School dell’Università della Pennsylvania. La sua combinazione di competenze tecniche e finanziarie le consente di affrontare le sfide del settore tecnologico con una visione unica e innovativa.

La sua leadership è caratterizzata da un forte impegno verso la diversità e l’inclusione nel posto di lavoro, rendendola una figura rispettata non solo per le sue competenze finanziarie ma anche per il suo approccio etico alla leadership aziendale.

Oggi Sarah Friar, Chief Financial Officer (CFO) di OpenAI, gioca un ruolo fondamentale nel garantire finanziamenti e gestire le relazioni con gli investitori mentre l’azienda naviga in un complesso panorama finanziario. Dalla sua assunzione nel giugno 2024, Friar ha concentrato i suoi sforzi sul miglioramento della comunicazione con gli investitori e sull’enfatizzazione della narrativa finanziaria dell’azienda.

Palmer Luckey figura controversa, è considerato un visionario nel campo delle tecnologie emergenti, sia per quanto riguarda la realtà virtuale che le applicazioni militari avanzate.

Capitolo 1: la visione di Palmer

Era una mattina di primavera quando Palmer Luckey, il fondatore di Anduril, ricevette una chiamata cruciale. La sua azienda, nota per la sua innovativa piattaforma Lattice, era stata selezionata per collaborare con Microsoft su un progetto rivoluzionario: l’integrazione del software di Anduril con il sistema di visualizzazione IVAS dell’esercito degli Stati Uniti. L’obiettivo? Trasformare la guerra moderna attraverso la tecnologia.

Negli ultimi mesi si è parlato molto di un rallentamento dell’economia statunitense, ma i dati economici non forniscono prove convincenti a riguardo.

L’ultimo esempio è stato il rapporto sull’occupazione di settembre, pubblicato lo scorso venerdì, che ha sorpreso positivamente le aspettative. Secondo il sondaggio sulle aziende, l’economia ha creato 254.000 nuovi posti di lavoro a settembre, superando la media mensile degli ultimi 12 mesi, pari a 203.000. Anche i dati di luglio e agosto sono stati rivisti al rialzo, rispettivamente di 55.000 e 17.000 posti.

Microsoft e la corsa agli armamenti per sviluppare il primo supercomputer quantistico su larga scala

Microsoft potrebbe aver superato la concorrenza nella corsa agli armamenti per sviluppare il primo supercomputer quantistico su larga scala. In previsione del suo arrivo, l’azienda ha lanciato Azure Quantum, che consente ai ricercatori di imparare le tecniche di programmazione quantistica, stimare le risorse necessarie per risolvere problemi complessi, testare i loro programmi in un ambiente simulato e sperimentare con le versioni attuali e iniziali dell’hardware futuro.

Microsoft ha dimostrato la potenza del suo ambiente simulato pubblicando un articolo che mostra come abbia utilizzato la programmazione quantistica e l’intelligenza artificiale (IA) per sviluppare un nuovo elettrolita per batterie, che ora è in fase di test in laboratorio.

Una recente scoperta scientifica ha cristallizzato l’attenzione di Microsoft nella ricerca hardware, mostrando che l’azienda sta adottando un approccio diverso rispetto alla concorrenza. Microsoft ha creato e controllato le esotiche quasi-particelle chiamate Moduli Zero di Majorana; queste particelle presentano una protezione dagli errori incorporata, conferendo ai futuri computer quantistici di Microsoft un vantaggio significativo rispetto a tutte le altre tecnologie attualmente in fase di studio.

L’intelligenza artificiale (IA) sta rapidamente trasformando il panorama lavorativo globale, portando con sé sia opportunità che sfide significative. In questo articolo, esploreremo come le tecnologie di intelligenza artificiale generativa (GenAI) influenzano il lavoro, quali settori sono più a rischio e perché è fondamentale che i lavoratori abbiano voce in capitolo in questo processo.

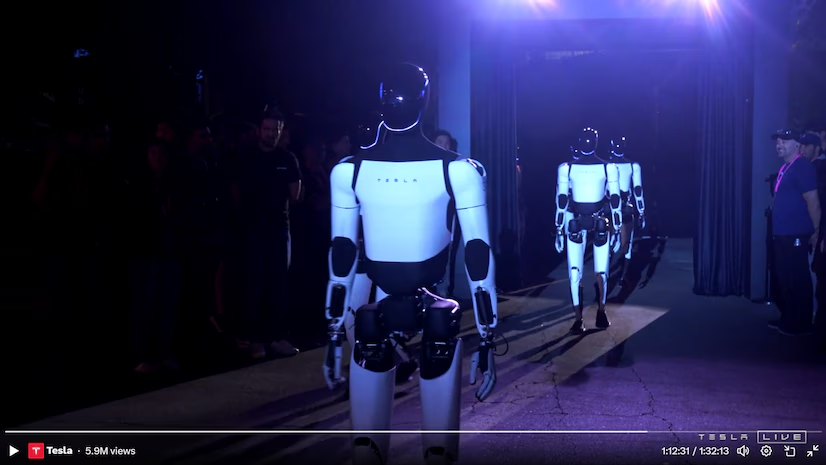

L’evento dedicato ai robotaxi di Tesla, che si è tenuto di recente, ha suscitato grande curiosità, soprattutto per la presenza degli avanzati robot umanoidi Optimus. Questi robot hanno interagito con gli ospiti, eseguendo comandi e conversando con i presenti, ma un alone di mistero circonda ancora il loro effettivo funzionamento. Mentre Elon Musk continua a promuovere una visione futuristica in cui il robot Optimus sarà alla portata di tutti, molti si chiedono se la dimostrazione fosse davvero una prova delle capacità autonome dell’IA, o solo un’abile messa in scena.

OpenAI, un tempo considerata la punta di diamante della ricerca sull’intelligenza artificiale e un rifugio per i migliori talenti accademici del settore, sta attraversando un periodo di turbolenza interna. Secondo un articolo di Wired moltooo interessante, diversi ricercatori chiave hanno lasciato l’azienda, apparentemente insoddisfatti per il cambiamento di rotta verso un approccio più commerciale. Questa fuga di cervelli ha sollevato dubbi sul futuro della compagnia e sulle sue reali ambizioni nel campo dell’AI.

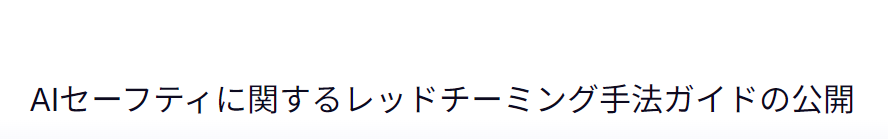

AIセーフティに関するレッドチーミング手法ガイドの公開

Nell’era dell’intelligenza artificiale (AI), la sicurezza dei sistemi che utilizzano questa tecnologia è diventata una priorità fondamentale. Di fronte a minacce sempre più sofisticate, l’Istituto giapponese per la sicurezza dell’intelligenza artificiale ha recentemente pubblicato una guida dettagliata sulle metodologie di red teaming, un approccio strategico volto a identificare e mitigare le vulnerabilità nei sistemi AI.

Cos’è il Red Teaming?

Il red teaming è un metodo di valutazione della sicurezza in cui esperti, noti come “red team”, emulano le tattiche e le tecniche di attacco degli aggressori per testare la resilienza di un sistema. Questo approccio non si limita a identificare vulnerabilità tecniche; si estende anche all’analisi dell’impatto sociale ed etico delle soluzioni AI. La guida dell’istituto giapponese sottolinea l’importanza di un approccio multidisciplinare, che combina competenze tecniche con una comprensione profonda delle implicazioni etiche e sociali.

La tecnologia sta prendendo sempre più piede nelle decisioni strategiche di molti governi, e il Regno Unito non fa eccezione. In un passaggio epocale per la gestione della difesa nazionale, il governo britannico sta utilizzando l’intelligenza artificiale (AI) per elaborare la sua revisione delle capacità militari, segnando una svolta radicale nel funzionamento del Ministero della Difesa e di Whitehall. Questa revisione della difesa, considerata uno dei documenti più importanti del periodo post-Brexit, mira a ridefinire le strategie militari del paese in un contesto globale sempre più incerto.

Giovedì sera, Tesla ha tenuto il tanto atteso evento “We, Robot” presso uno studio della Warner Bros. a Burbank, California. L’evento, che ha visto la partecipazione di Elon Musk e un pubblico entusiasta, è iniziato con oltre 53 minuti di ritardo a causa di un’emergenza medica di un membro del pubblico, come spiegato da Musk stesso. Nonostante l’inizio posticipato, l’evento ha offerto una serie di rivelazioni che potrebbero rivoluzionare non solo il settore automobilistico, ma anche la robotica e la gestione dei trasporti a livello globale.

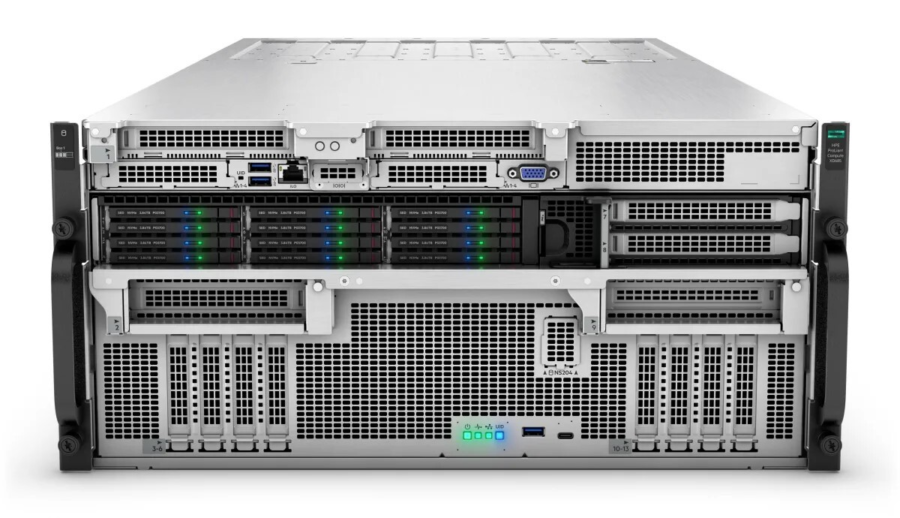

HP Enterprise (HPE) ha recentemente svelato il suo nuovo server, il ProLiant Compute XD685, durante il primo “Artificial Intelligence Day” dell’azienda. Questo sistema è progettato per gestire compiti complessi di addestramento di modelli di intelligenza artificiale, sfruttando i chip AI di AMD.

Caratteristiche principali del ProLiant Compute XD685:

- Potenza di elaborazione: Il sistema è dotato di tecnologia avanzata per supportare applicazioni di intelligenza artificiale e machine learning.

- Efficienza energetica: HPE ha progettato il server per essere non solo potente, ma anche efficiente dal punto di vista energetico, riducendo i costi operativi.

- Scalabilità: Il ProLiant Compute XD685 è altamente scalabile, permettendo alle aziende di adattare le risorse in base alle loro esigenze specifiche.

Questa innovazione rappresenta un passo significativo per HPE nel mercato dei server dedicati all’intelligenza artificiale, posizionando l’azienda come un attore chiave in questo settore in rapida evoluzione.

Ezra, un’azienda di AI nel settore sanitario specializzata in imaging MRI e rilevamento precoce del cancro, ha recentemente raccolto 21 milioni di dollari in finanziamenti per migliorare le proprie operazioni ed espandere i propri servizi in Nord America.

Questo investimento porta il totale dei finanziamenti di Ezra a 41 milioni di dollari e faciliterà la crescita dell’azienda in 20 città e 50 sedi nel 2024. Il round di finanziamento è stato co-guidato da Healthier Capital e FirstMark Capital, con la partecipazione di vari investitori notabili, tra cui l’ex presidente del NHS Lord David Prior e la CEO di 23andMe Anne Wojcicki.

Nell’estate del risveglio stellare, quando i confini tra il conosciuto e l’ignoto si assottigliano, i saggi del SETI hanno potenziato le loro armi segrete nella caccia ai messaggi dimenticati provenienti dai regni oltre il nostro mondo.

Nel cuore del SETI Institute, un’antica confraternita di studiosi nata nel 1984, si è compiuto un rituale senza precedenti. Per la prima volta, le menti brillanti di questa setta hanno intrecciato l’Intelligenza Artificiale con il misterioso flusso di segnali radio provenienti dalle profondità dello spazio. La loro magia avanzata non solo serve alla ricerca di civiltà aliene, ma promette di svelare i misteri nascosti tra le stelle, aprendo strade prima inaccessibili anche ai più arditi astronomi.

Da quando Internet è diventato di uso comune, i siti pornografici sono stati spesso utilizzati per diffondere malware.

Il peggio è che questi hacker sembrano essere collegati a FIN7, un noto gruppo criminale informatico attivo dal 2012. Lo scorso anno, il Dipartimento di Giustizia degli Stati Uniti aveva dichiarato il gruppo sconfitto dopo l’arresto e la condanna di tre membri, tra cui il presunto “manager” Fedir Hladyr, un cittadino ucraino. Si ritiene che FIN7 abbia causato danni per 3 miliardi di dollari a livello globale.

Microsoft-backed OpenAI ha identificato e interrotto più di 20 casi di individui o reti che utilizzano i suoi modelli di intelligenza artificiale per influenzare le elezioni, diffondere disinformazione o seminare divisioni sociali quest’anno.

“La loro attività spaziava dal debugging di malware, alla scrittura di articoli per siti web, alla generazione di contenuti pubblicati da falsi profili su account social media,”

Le attività variavano in complessità da semplici richieste di generazione di contenuti a sforzi complessi e multi-fase per analizzare e rispondere ai post sui social media. Includevano persino una bufala sull’uso dell’IA.”

ha dichiarato OpenAI in un rapporto di 54 pagine pubblicato oggi in allegato

Se ci fosse stato Enzo Jannacci a raccontare la storia, probabilmente avrebbe iniziato con un bel “Eh, la Tesla!”. Sì, perché con un misto di ironia e profonda riflessione ci avrebbe accompagnato dentro questo evento che ha un che di futuristico, quasi da fantascienza. Non è che una macchina, ci avrebbe detto, eppure oggi ci si aspetta di veder volare non solo le farfalle, ma anche le porte!

Le rapide innovazioni nell’Intelligenza Artificiale generativa stanno per trasformare radicalmente il panorama dell’ingegneria del software. Secondo un recente rapporto di Gartner, l’80% degli ingegneri a livello globale dovrà “riqualificarsi” nei prossimi tre anni per rimanere competitivo.

Il rapporto, pubblicato la scorsa settimana, conferma ciò che molti sviluppatori hanno già intuito: gli strumenti di AI generativa stanno rivoluzionando lo sviluppo software. Se nel breve periodo si notano modesti guadagni in termini di produttività, a lungo termine si prospetta una trasformazione totale verso pratiche ingegneristiche AI-native.

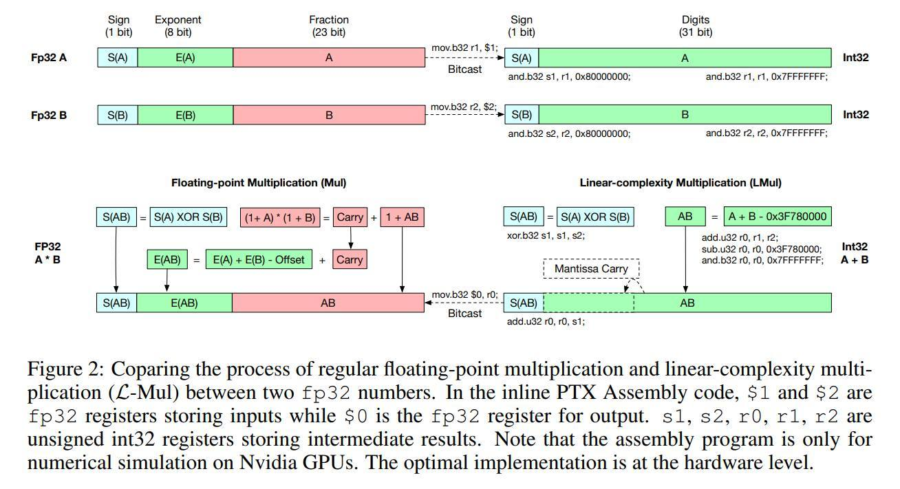

Il crescente consumo energetico dei modelli di intelligenza artificiale (AI) è diventato una preoccupazione globale. Un recente studio condotto dai ricercatori di BitEnergy AI, Inc. ha introdotto una nuova tecnica denominata Linear-Complexity Multiplication (L-Mul), che potrebbe ridurre il consumo energetico fino al 95% senza compromettere la qualità delle prestazioni dei modelli AI. L-Mul sostituisce le costose moltiplicazioni in virgola mobile con più semplici operazioni di somma di interi, mantenendo una precisione elevata e riducendo drasticamente i costi computazionali. Questo articolo esplora il funzionamento della tecnica, i suoi risultati e le potenziali implicazioni per il futuro dei modelli AI.

Il 9 ottobre 2024, il Premio Nobel per la Chimica è stato assegnato a tre ricercatori per le loro straordinarie scoperte nel campo della struttura delle proteine. Tra i vincitori figurano Demis Hassabis e John Jumper, due scienziati di Google DeepMind, insieme a David Baker, un biochimico dell’Università di Washington. Questo riconoscimento segna un importante traguardo per l’intelligenza artificiale applicata alla scienza, in particolare nella previsione delle strutture proteiche.

AlphaFold2 è il modello di intelligenza artificiale sviluppato da DeepMind che ha rivoluzionato la previsione delle strutture proteiche. Grazie a questo strumento, i ricercatori sono stati in grado di determinare la struttura di quasi tutte le 200 milioni di proteine identificate fino ad oggi. La Royal Swedish Academy of Sciences ha sottolineato che “con il suo aiuto, sono riusciti a prevedere la struttura di quasi tutte le proteine conosciute”

Nvidia ha presentato la sua visione per la prossima fase dell’intelligenza artificiale (IA), con applicazioni che spaziano da agenti IA avanzati a fabbriche gestite da robot, dalla previsione meteorologica alla cura del cancro, fino alla possibilità di entrare in contatto con forme di vita extraterrestri.

Al centro di queste ambiziose iniziative c’è l’hardware e il software Nvidia, inclusi i recenti sviluppi delle “fabbriche di IA”, veri e propri data center che ospitano fino a 32.000 GPU raffreddate a liquido, denominati piattaforme Blackwell AI Supercluster.

La scorsa settimana, OpenAI ha informato alcuni dipendenti che l’azienda intende assumere un ruolo più attivo nello sviluppo di data center e chip per l’Intelligenza Artificiale (AI), piuttosto che dipendere esclusivamente da Microsoft. La notizia è stata riportata da The Information, citando una fonte interna.

Microsoft ha annunciato martedì che Azure è il primo cloud a usare il sistema Blackwell di Nvidia, tramite i server AI GB200. “Stiamo ottimizzando ogni livello per supportare i modelli di intelligenza artificiale più avanzati, usando la rete Infiniband e un innovativo raffreddamento a liquido a circuito chiuso,” ha dichiarato Microsoft in un post su X, precedentemente noto come Twitter. Il CEO di Nvidia, Jensen Huang, ha detto la scorsa settimana che la domanda per le GPU Blackwell è “incredibile.”

Taiwan si trova ad affrontare una crisi energetica sempre più grave, una situazione che minaccia il cuore dell’economia dell’isola: l’industria dei semiconduttori. Con l’aumento della domanda di energia e una crescente vulnerabilità alle interruzioni di fornitura, le autorità e le aziende locali si trovano a un bivio cruciale per il futuro economico della nazione. Questo articolo analizza i fattori che contribuiscono a questa crisi e le potenziali soluzioni.

Nella scia dell’uragano Helene, un’onda di disinformazione, sia generata da intelligenza artificiale che da esseri umani, sta inondando i social media, distorcendo la realtà degli sforzi di recupero e creando nuove paure infondate riguardo all’uragano Milton. È un fenomeno che non può più essere ignorato, un’epidemia di falsità che si diffonde più velocemente della stessa tempesta.

La Sfida del 2025 tra Mobilità Militare e Minaccia Russa

La riflessione politica che emerge dal contesto internazionale attuale, in particolar modo riguardo alle forze armate europee, rivela diverse questioni di importanza strategica per l’Italia, la NATO e l’Unione Europea.

In un momento in cui la Francia si prepara a mettere alla prova la capacità del proprio esercito di rispondere rapidamente a una potenziale minaccia russa, il caso francese offre spunti di riflessione anche per il nostro paese, soprattutto alla luce di quanto discusso in ambito militare e geopolitico da fonti italiane.

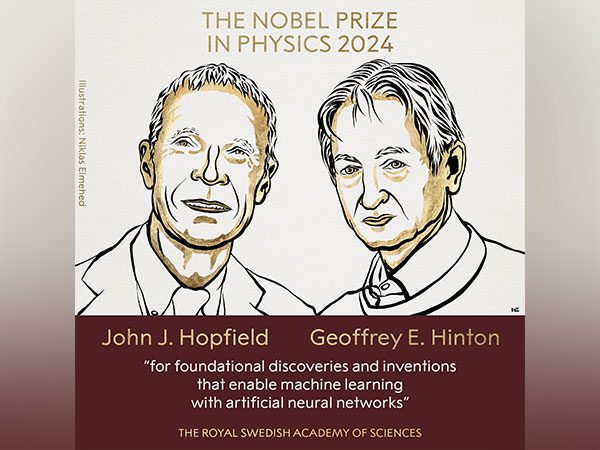

Che emozione! Hanno assegnato il Nobel per la Fisica a due signori mica da ridere: John Hopfield e Geoffrey Hinton – che ha lasciato Google l’anno scorso per poter avvertire sui pericoli dell’intelligenza artificiale. Due nomi che non ci suonano nuovi, no? Stiamo parlando delle menti che, contro tutto e tutti, han messo giù la strada per quello che oggi chiamiamo Intelligenza Artificiale. Un campo che ora ci sembra quasi fantascienza quotidiana, ma che, grazie a questi giganti, ha cominciato a respirare molti anni fa.

Capitolo I

L’alba di un destino

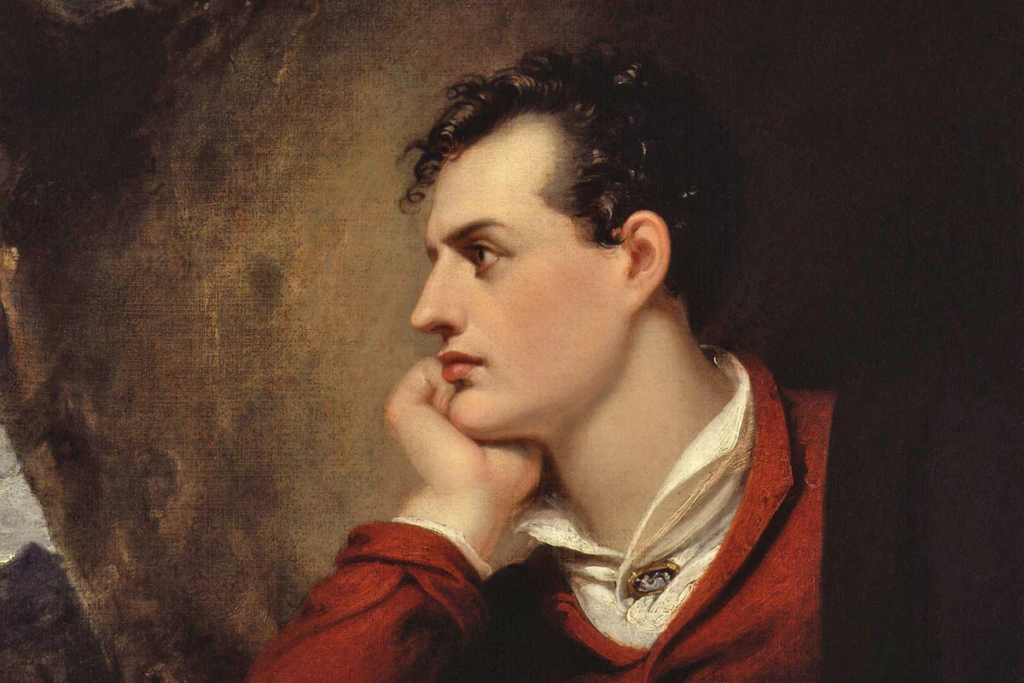

Nacqui nell’anno del Signore 1815, figlia dell’uomo i cui versi hanno reso immortali le passioni umane. Mio padre, Lord Byron, un nome che risuona come un eco fra i marmi antichi, viveva come una tempesta, con furia e bellezza. Ma in me, Augusta Ada Byron, si accese un fuoco differente: non la fiamma distruttiva della ribellione, ma la luce pura della ragione. Il destino, tuttavia, ci strappò presto l’uno all’altra, lasciandomi orfana del suo tumulto, ma non della sua ombra.

Mark Farrell, un capitalista di rischio e ex sindaco ad interim di San Francisco, è attualmente un candidato di spicco nella corsa per la carica di sindaco della città. La sua carriera politica e imprenditoriale si sono intrecciate, sollevando interrogativi sulla sua influenza e sulle sue decisioni in entrambi i campi.

Negli ultimi anni, i Transformers sono emersi come l’architettura dominante nel campo del deep learning, specialmente per compiti come la traduzione automatica e la generazione di testo. Tuttavia, i Transformers presentano delle limitazioni significative, in particolare la complessità computazionale quadratica rispetto alla lunghezza delle sequenze di input. Questo rende difficile la loro applicazione su lunghe sequenze di dati, soprattutto in contesti con risorse limitate. Di conseguenza, è rinata l’attenzione verso modelli sequenziali ricorrenti, che sono più efficienti nel processare contesti di lunghezza significativa. Ma ci chiediamo: erano già sufficienti le Reti Neurali Ricorrenti (RNNs) tradizionali?

urante il DevDay di OpenAI del 2024, sono state annunciate significative novità relative alle API, tra cui un’API in tempo reale per l’interazione voce-voce, un raffinamento della visione artificiale per un riconoscimento e un’analisi delle immagini più accurati, la distillazione dei modelli per ottimizzare modelli più piccoli e meno costosi, e il caching dei prompt per accelerare le richieste ripetute memorizzando domande e risposte comuni.

Queste innovazioni rappresentano un passo verso la realizzazione concreta degli agenti AI, con il CEO di OpenAI, Sam Altman, che prevede la loro integrazione nelle nostre vite quotidiane entro il 2025. Un agente AI, infatti, è una tecnologia autonoma capace di perseguire obiettivi in ambienti complessi, seguendo istruzioni in linguaggio naturale e con minima supervisione umana. Utilizzando strumenti avanzati, gli agenti AI prendono decisioni autonome, spesso sfruttando modelli linguistici di grandi dimensioni.