E così, a distanza di decenni, i Beatles si portano a casa l’ottavo Grammy competitivo, e lo fanno grazie a un nuovo membro della band: l’intelligenza artificiale. Chi l’avrebbe mai detto che il futuro del rock sarebbe passato da un algoritmo? E invece eccoci qua, con “Now and Then”, una canzone nata da un nastro impolverato degli anni ‘70, ripescata negli anni ‘90, abbandonata per limiti tecnici e poi resuscitata nel 2021 da Paul McCartney e Ringo Starr con l’aiuto di Peter Jackson e del suo team di maghi digitali. L’AI è il nuovo produttore di Abbey Road, piaccia o meno.

Autore: Dina Pagina 10 di 33

Direttore senior IT noto per migliorare le prestazioni, contrastare sfide complesse e guidare il successo e la crescita aziendale attraverso leadership tecnologica, implementazione digitale, soluzioni innovative ed eccellenza operativa.

Con oltre 20 anni di esperienza nella Ricerca & Sviluppo e nella gestione di progetti di crescita, vanto una solida storia di successo nella progettazione ed esecuzione di strategie di trasformazione basate su dati e piani di cambiamento culturale.

OpenAI ha appena lanciato l’ennesima novità per ChatGPT: Deep Research, un’aggiunta che promette di trasformare il chatbot da semplice generatore di testo in un analista autonomo capace di pianificare, eseguire ricerche multi-step e perfino tornare sui propri passi se necessario. Un’intelligenza artificiale che finalmente può correggersi da sola? Quasi, ma non troppo.

L’idea è che ora ChatGPT non si limiti a rispondere con il solito testo preconfezionato, ma mostri un processo di ricerca “trasparente” nella nuova barra laterale, includendo citazioni e spiegazioni su come ha costruito la sua risposta. Un’innovazione che suona rassicurante, fino a quando OpenAI stessa ammette che Deep Research può ancora allucinare fatti inesistenti, confondere bufale con dati ufficiali e non avere la minima idea di quanto sia sicuro delle sue risposte. Insomma, un po’ come un analista finanziario sotto pressione, ma con meno senso della realtà.

Diciamocelo chiaramente, il quantum computing non è una di quelle diavolerie futuristiche che trovi solo nei romanzi di Asimov o nei film di Nolan. È già tra noi. Ricordo ancora quando, da bambino, il mio primo computer era un Lemon II prodotto in italia dalla Selcom di Ravenna con ben 48 kilobyte di memoria. Era il massimo della tecnologia per l’epoca, La mainboard era una copia pressoché identica di quella dell’Apple II+, si differenziava dall’originale per pochi particolari, come per esempio l’utilizzo di EPROM al posto dele ROM , Lemon, scelto tra i nomi inglesi di frutti a 5 lettere com Apple nei paesi di lingua anglofona il termine è sinonimo di “bidone”..

Ammiro Jensen Huang, il visionario CEO di Nvidia, ma quando dice che l’uso “pratico” del quantum computing è distante almeno vent’anni, credo che stia sottovalutando la situazione. Certo, Nvidia è un gigante dell’innovazione, ma fidatevi: il quantum computing sta già facendo passi da gigante in campi come la sicurezza, la finanza e la farmaceutica.

Il 1° febbraio 2025, il Presidente degli Stati Uniti Donald Trump ha ufficialmente imposto tariffe del 25% su tutte le importazioni provenienti da Canada e Messico, e del 10% su quelle cinesi, con l’obiettivo dichiarato di affrontare questioni legate all’immigrazione illegale e al traffico di fentanyl. Inoltre, i prodotti energetici canadesi saranno soggetti a una tariffa del 10%.

Il ministero del commercio cinese ha dichiarato: “La Cina è fortemente insoddisfatta di questo e si oppone fermamente”, aggiungendo che si tratta di una “grave violazione” delle regole dell’Organizzazione Mondiale del Commercio, secondo la BBC.

Il confronto tra DeepSeek e OpenAI nel contesto dell’intelligenza artificiale può essere interpretato attraverso la lente storica e filosofica della crisi della fisica del XX secolo, un parallelo che richiama la tensione tra modelli consolidati e nuove prospettive.

Se la fisica classica aveva costruito un edificio apparentemente solido fino all’inizio del Novecento, la relatività e la meccanica quantistica ne hanno scardinato i principi fondamentali, portando a una crisi epistemologica che ancora oggi si cerca di risolvere. Analogamente, il monopolio occidentale sulle IA avanzate, incarnato da OpenAI, si trova ora di fronte alla sfida di nuovi attori come DeepSeek, espressione della crescente capacità tecnologica cinese.

Ultima settimana nel magico mondo dell’AI: ecco DeepSeek, un servizio simile a ChatGPT, ma realizzato a una frazione del costo. Miracolo tecnologico? Non proprio. Si mormora che il modello sia stato sviluppato grazie a una tecnica raffinata chiamata “distillazione”—un termine che in Occidente fa rima con “proprietà intellettuale violata”, mentre in Cina si traduce con “business intelligente”.

Ma chi ha tempo per scandalizzarsi? Parliamo piuttosto del vero takeaway: il “Metodo Cinese dell’Innovazione”. Dopo anni “difficili” provenienti da società americane, passati fianco a fianco con i migliori ingegneri asiatici, posso garantire che questa storia è tutto tranne che nuova.

Ho speso una buona parte della mia vita lavorando per Anglo Americani quello che li ha sempre caratterizzati, forse come ex potenza coloniale, è avere una Roadmap questa è la dimostrazione : Devi avere un Piano

Il governo britannico ha appena rilasciato un documento di policy destinato a rafforzare la sua posizione come potenza globale nell’intelligenza artificiale. Questa iniziativa, basata su 50 misure specifiche, non è solo una dichiarazione d’intenti, ma un piano strategico ben strutturato che dimostra la volontà di guidare il futuro dell’AI con investimenti mirati, regolamentazioni intelligenti e un ecosistema favorevole all’innovazione.

A differenza dell’Europa continentale, spesso intrappolata in un labirinto normativo e burocratico che rallenta lo sviluppo tecnologico, il Regno Unito adotta un approccio pragmatico, delineando obiettivi concreti e misurabili. Questa roadmap comprende l’espansione delle capacità di calcolo, lo sviluppo di hub dedicati all’AI, la creazione di zone di crescita specializzate, incentivi alla condivisione dei dati e un investimento strategico nella formazione e nel talento.

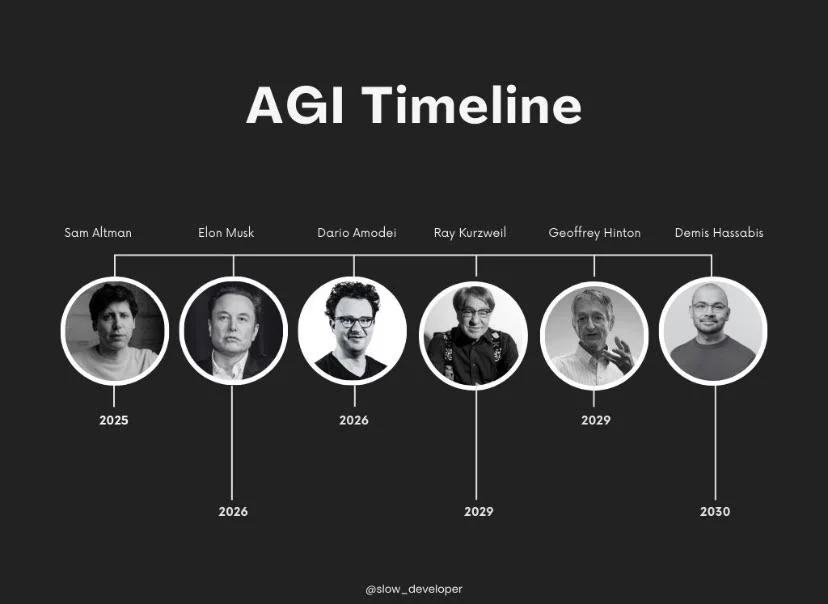

Negli ultimi anni, il dibattito sulla timeline per raggiungere l’AGI (Artificial General Intelligence, ovvero un’intelligenza artificiale capace di comprendere e svolgere compiti di livello umano in ogni dominio) si è intensificato. Voci influenti dell’industria e della ricerca, tra cui Sam Altman, Ray Kurzweil, Demis Hassabis, Elon Musk e altri, hanno espresso opinioni divergenti. La questione non riguarda solo la tecnologia, ma anche le implicazioni sociali, economiche e filosofiche di un traguardo che cambierebbe radicalmente il mondo.

Recap della settimana, il nuovo Maccartismo

Howard Lutnick, il candidato alla carica di Segretario del Commercio degli Stati Uniti, ha esordito davanti al Senato con una denuncia infuocata: DeepSeek avrebbe rubato tecnologia americana per spazzare via la concorrenza occidentale. “Hanno rubato, si sono introdotti, hanno preso la nostra proprietà intellettuale”, ha dichiarato con sdegno. Un’accusa che riflette la crescente paranoia americana nei confronti delle aziende cinesi, colpevoli – a quanto pare – di giocare sporco quando sono loro a vincere.

La Casa Bianca, prevedibilmente, ha cavalcato l’ondata di indignazione, valutando i rischi per la sicurezza nazionale. I giganti della Silicon Valley, terrorizzati dalla rivoluzione tecnologica scatenata da DeepSeek, hanno rapidamente dipinto l’azienda cinese come un’entità fraudolenta, intenta a sabotare il mercato con spregiudicate manovre di spionaggio industriale e dumping tecnologico.

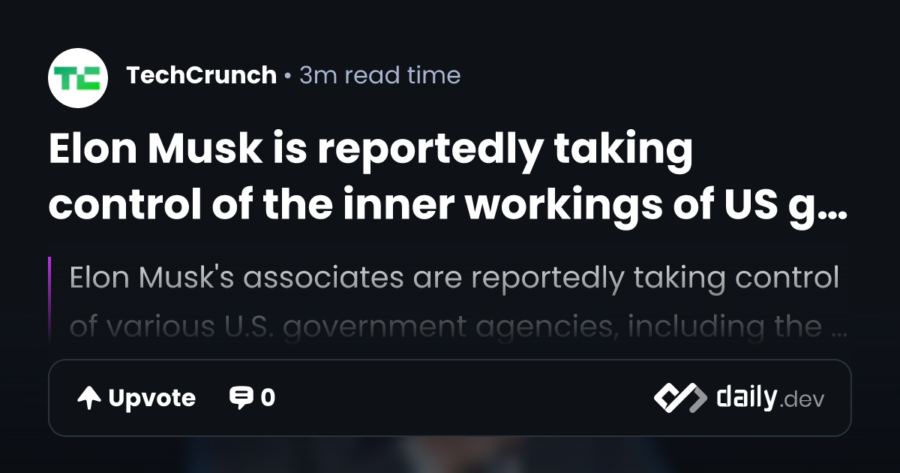

L’immagine di Elon Musk come l’uomo che guida l’innovazione attraverso il caos è ormai consolidata. Eppure, il suo recente ingresso nel governo federale degli Stati Uniti sembra portare questo concetto a un livello decisamente più macabro e ironico. Secondo quanto riportato dal Washington Post, i suoi collaboratori stanno prendendo il controllo delle dinamiche interne di diverse agenzie governative cruciali, tra cui l’Office of Personnel Management, il Department of the Treasury e la General Services Administration (GSA). Ma in che modo l’imprenditore noto per il suo approccio irriverente sta influenzando il funzionamento della macchina burocratica americana?

Il 2025 si apre con un messaggio chiaro: se il tuo lavoro dipende dalla scrittura, dalla creatività o dalla produzione di contenuti, hai un problema. Alex Wei, uno YouTuber freelance, ha pubblicato un video diventato virale il primo dell’anno con un titolo che suona come un epitaffio: “Happy 2025. Ho perso il mio lavoro da freelance per colpa dell’AI”.

Recentemente, il presidente Donald Trump ha espresso forti critiche nei confronti della Federal Reserve (Fed) e del suo presidente, Jerome Powell, accusandoli di aver gestito in modo inadeguato la regolamentazione bancaria e di non essere riusciti a controllare l’inflazione.

In un post su Truth Social, Trump ha dichiarato: “Poiché Jay Powell e la Fed non sono riusciti a fermare il problema che hanno creato con l’inflazione, lo farò io”, sottolineando l’intenzione di affrontare personalmente le sfide economiche attuali.

Questo libro è tra i più illuminanti mai scritti sugli LLM: una vera e propria lezione magistrale!

(Poter vivere in un’epoca in cui risorse di questo calibro sono liberamente accessibili a chiunque voglia approfondire è semplicemente straordinario).

In 200 pagine, il libro affronta in dettaglio:

- Le basi dei modelli transformer pre-addestrati

- Come i transformer alimentano i moderni LLM

- Tecniche di addestramento e scalabilità degli LLM

- Strategie di prompting, dalle nozioni fondamentali a quelle avanzate

- Metodi di fine-tuning per applicazioni pratiche

Se desideri superare le discussioni superficiali sull’intelligenza artificiale e comprendere davvero come funzionano questi modelli, questa lettura è un must. Assolutamente consigliato!

Se lo trovi utile, condividi il contenuto con la tua rete e aiutaci a diffondere la conoscenza sull’IA!

Un vero tesoro da scoprire. Buona lettura!

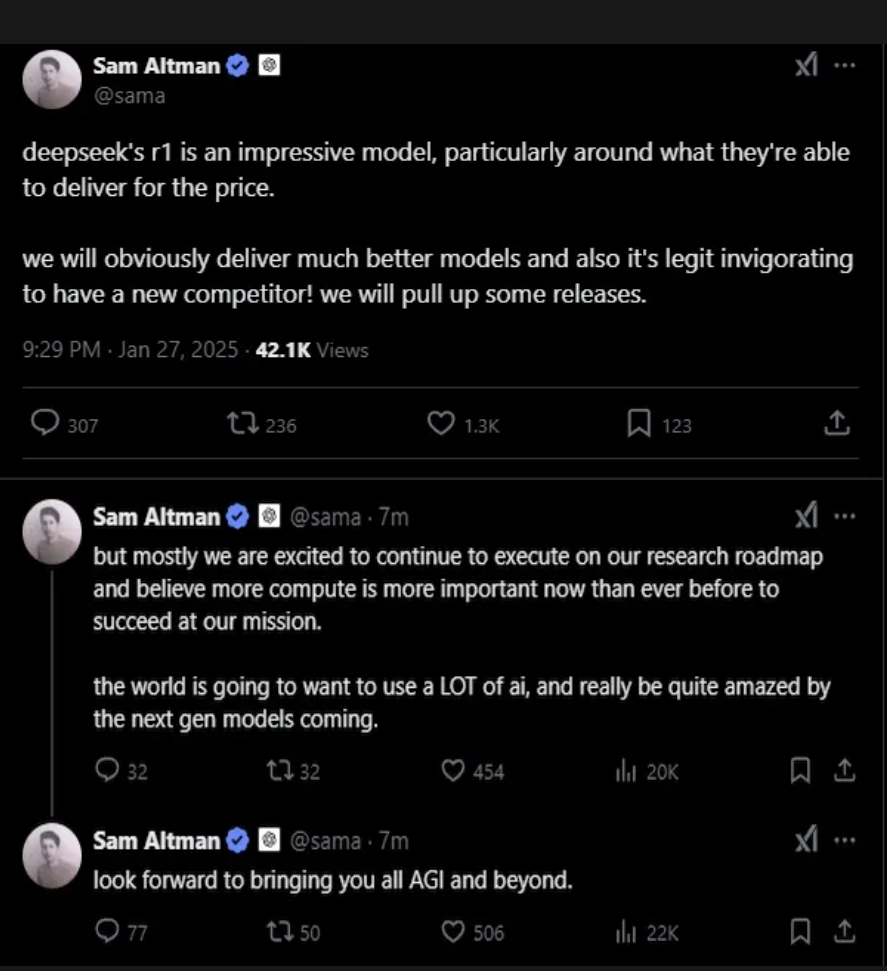

Sam Altman, il guru di OpenAI, ha finalmente avuto un’epifania: “Forse essere aperti non è stata la mossa migliore forse essere closed-source come una cassaforte svizzera sarebbe stato meglio” Certo, non è che la compagnia ci sia arrivata da sola, ma è stata spinta con forza da un terremoto chiamato DeepSeek, lo ha detto durante il Reddit “Ask Me Anything“, (AMA) anche se a Roma significa altro..

Durante un’illuminante sessione su Reddit, Altman ha confessato candidamente che forse OpenAI ha “sbagliato lato della storia” sul tema dell’open source. Ovviamente, non tutti in OpenAI condividono questa opinione, e nemmeno è la loro “priorità assoluta” – perché perché mai dovrebbe esserlo?

La memoria umana è la colonna portante della nostra identità. È quel misto di ricordi imbarazzanti, momenti epici e dettagli irrilevanti che ci permette di dire “io sono questo.” Ma è anche un sistema ingannevole, un archivio disorganizzato e pieno di falle. Ora immaginate di prendere questa meravigliosa confusione e cercare di replicarla in un’intelligenza artificiale. Sembra una buona idea? Certo, come lanciare un boomerang in uno spazio angusto e sperare che non ritorni per colpirti.

La memoria a lungo termine (LTM) e la memoria a breve termine (STM) non sono solo concetti accademici da manuale di psicologia. Sono i due poli su cui si basa ogni processo cognitivo umano. La STM è quella lavagna temporanea su cui scriviamo le informazioni per risolvere problemi immediati: ricordare il numero di una stanza d’hotel, fare calcoli mentali, trovare un modo elegante per uscire da una conversazione noiosa. La LTM, invece, è il magazzino delle nostre esperienze, il contenitore che ci permette di ricordare la lezione di geometria del liceo (anche se ormai non ci serve più) o il nome del nostro primo amore.

Il lavoro di Donald MacKenzie in Inventing Accuracy (1990) offre un quadro concettuale utile per analizzare ciò che sta accadendo oggi nel campo dell’intelligenza artificiale con lo sviluppo di modelli come quelli di DeepSeek e OpenAI. Il parallelo principale risiede nel modo in cui l’innovazione tecnologica non è mai un processo puramente tecnico, ma il risultato di un complesso intreccio di fattori politici, economici e istituzionali.

In un’epoca in cui l’Intelligenza Artificiale (IA) è diventata protagonista di dibattiti, investimenti miliardari e rivoluzioni tecnologiche, capire davvero di cosa si tratta può sembrare un’impresa da far sanguinare il naso. Eppure, durante una serata speciale del programma Splendida Cornice, condotta da una superlativa Geppi Cucciari su Rai 3, il professor Luciano Floridi, filosofo ed esperto di etica digitale, ha offerto una spiegazione chiara e accessibile, promettendo di farci uscire dal bar senza emorragie nasali.

Luciano Floridi è Professor and Founding Director of the Digital Ethics Center all’Università di Yale e insegna Sociologia della Comunicazione all’Università di Bologna. E’ tra i massimi esperti internazionali nel campo della filosofia dell’informazione e delle trasformazioni digitali, ed è stato recentemente nominato presidente della Fondazione Leonardo. A parte i titoli ha dimostrato, sempre, di essere un personaggio di spessore.

Floridi ha offerto una visione critica e complessa sull’Intelligenza Artificiale (IA), che va oltre la semplice analisi tecnologica. Il suo approccio, come emerso nel programma, si concentra sulla natura stessa dell’intelligenza e sul rapporto tra uomo e macchina, mettendo in discussione alcune delle nostre assunzioni più comuni.

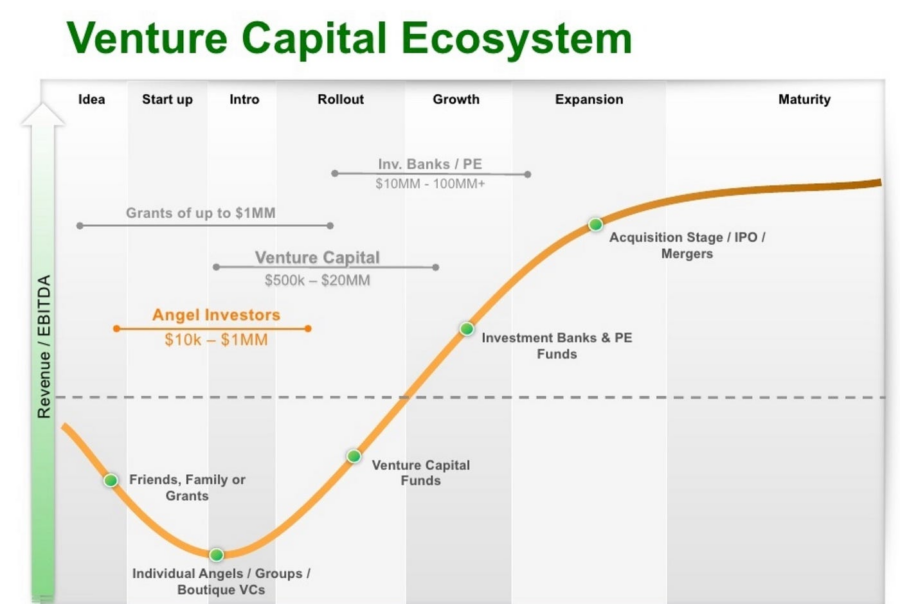

Il capitalismo ha una regola ferrea: se c’è un trend, c’è un fondo pronto a specularci sopra. E così, dopo aver spremuto a dovere gli ex dipendenti di Google, il fondo di venture capital Felicis ha trovato una nuova miniera d’oro nei reduci di OpenAI. La strategia è sempre la stessa: raccogliere gli ex di grandi aziende, spacciarli per guru della prossima rivoluzione tecnologica e investirci sopra miliardi. L’ultima mossa? L’assunzione di Peter Deng, ex vicepresidente consumer di OpenAI, ora quinto socio generale di Felicis.

Il profumo del caffè avvolge l’aria del Bar dei Daini, un piccolo angolo di riflessione dove gli imprenditori, i manager e gli appassionati di tecnologia si ritrovano per discutere delle ultime novità dal mondo finanziario e tecnologico. Tra un espresso intenso e un cappuccino schiumoso, le conversazioni spaziano dalle acquisizioni strategiche ai futuri scenari dell’intelligenza artificiale, passando per le mosse dei giganti del settore tecnologico.

Apple ha pubblicato i risultati del trimestre di dicembre, e come sempre c’è chi vede il bicchiere mezzo pieno e chi lo vede mezzo vuoto. Ma per un’azienda che vive di storytelling e numeri scintillanti, il problema è quando nel bicchiere ci sono più crepe che liquido.

Partiamo dalle note stonate: la Cina, che dovrebbe essere la miniera d’oro di Apple, ha deciso che forse è meglio tornare a scavare in casa propria. I ricavi nel Paese del Dragone si sono ridotti dell’11%, un segnale chiaro che il vento sta cambiando. Huawei e gli altri marchi locali, spinti da un’ondata di orgoglio nazionale e da una tecnologia che non ha nulla da invidiare, stanno erodendo la posizione dominante dell’iPhone. E se l’azienda di Cupertino si consola con un calo “solo” dello 0,8% nelle vendite globali di iPhone, è evidente che il problema cinese non è un mal di pancia passeggero, ma un’ulcera cronica.

“Ogni paese nel mondo potrebbe avere un progetto di quel tipo in corso, se riesce ad acquisire il talento necessario e a lavorarci, naturalmente. Il resto dell’industria imparerà da questo,” ha detto Shuman Ghosemajumder, co-fondatore e amministratore delegato di Reken, una startup di intelligenza artificiale con sede a San Francisco.

Liang Wenfeng è un nome che sta rapidamente emergendo nell’elite tecnologica globale. Alcuni lo definiscono il “Sam Altman cinese”, un riferimento al noto CEO di OpenAI, mentre altri lo paragonano a Jim Simons, il leggendario matematico e fondatore di Renaissance Technologies, pionere degli investimenti quantitativi.

L’analisi quantitativa è una tecnica di analisi finanziaria che cerca di capire il comportamento dei mercati finanziari usando modelli matematici e statistici. L’obiettivo è scoprire le cause delle fluttuazioni dei mercati, prevederle e anticiparle.

Masayoshi Son ha di nuovo aperto il portafoglio. E stavolta lo ha fatto in grande, con un potenziale investimento fino a 25 miliardi di dollari in OpenAI, un’operazione che, se confermata, scalzerebbe Microsoft dal trono del principale finanziatore dell’azienda di Sam Altman. Un ribaltone che non solo ridefinisce le alleanze nel settore dell’intelligenza artificiale, ma evidenzia anche il ritorno in scena di SoftBank con la sua solita, inarrestabile ambizione di plasmare il futuro della tecnologia.

Non si tratta solo di una pioggia di miliardi gettata nel vuoto. Questo affare arriva sulla scia di Stargate, un mega-progetto da 500 miliardi di dollari annunciato nientemeno che da Donald Trump (sì, proprio lui), con la promessa di costruire data center in Texas e creare 100.000 posti di lavoro americani. Masayoshi Son, ovviamente, è stato nominato presidente del progetto. Che Trump possa essere un kingmaker dell’AI è un twist che nemmeno Hollywood avrebbe osato scrivere.

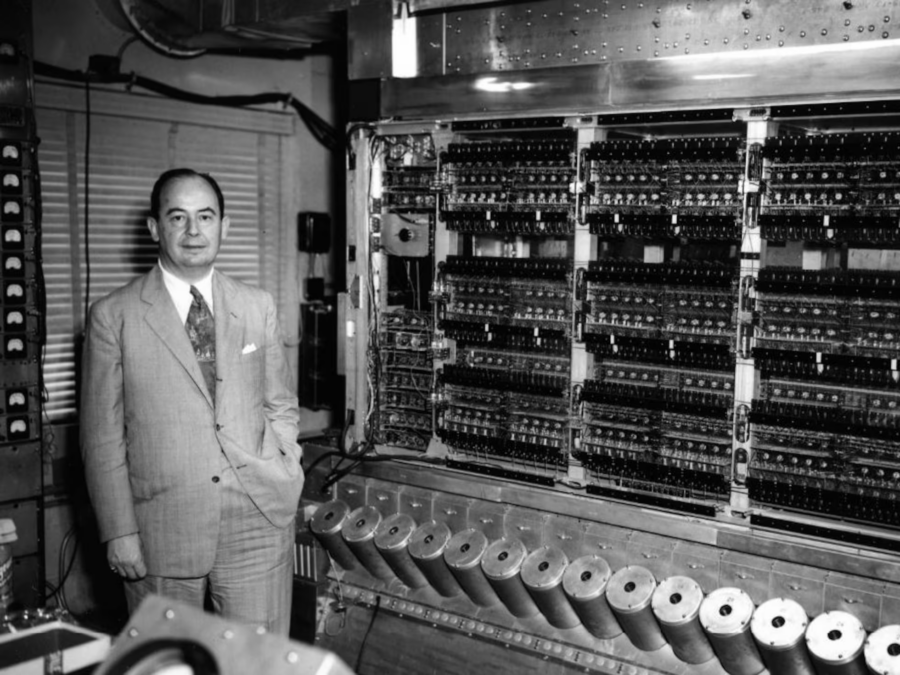

John von Neumann nacque nel 1903 con un problema che non sapeva ancora di avere. Certo, era un bambino prodigio, capace di moltiplicare numeri a sei cifre a mente mentre i suoi coetanei si limitavano a non mangiarsi i pastelli a cera. Ma il destino aveva in serbo per lui una beffa matematica: creare un’architettura informatica così geniale da diventare lo standard… e al tempo stesso così limitante da tormentare generazioni di ingegneri per decenni.

Von Neumann, che si dilettava in ogni campo dello scibile umano – dalla matematica all’economia, dalla teoria dei giochi alle bombe nucleari – non poteva immaginare che il suo capolavoro, l’architettura di Von Neumann, sarebbe diventato anche il suo più grande lascito problematico.

Il principio era semplice, quasi elegante: una CPU che esegue istruzioni prelevandole dalla memoria, elaborando dati e rispedendoli indietro. Un’idea brillante… finché non si iniziò a chiedere sempre più velocità ai computer. Fu allora che il suo nome venne associato a un concetto che avrebbe fatto impallidire qualunque inventore: il Bottleneck di Von Neumann.

Il problema era che memoria e processore dovevano comunicare attraverso un unico canale, come una sola persona che tenta di svuotare il Titanic con un cucchiaio. Più i dati aumentavano, più questa strozzatura diventava soffocante. L’era dei supercomputer e delle intelligenze artificiali esigeva prestazioni sempre più elevate, ma l’antica architettura di Von Neumann resisteva, come un vecchio nobile che si rifiuta di abbandonare il suo castello decrepito.

Le menti più brillanti del mondo si arrovellavano su come superare questo limite. Alcuni tentarono la strada delle architetture neuromorfiche, ispirate al cervello umano, con connessioni parallele e sinapsi di silicio. Altri puntarono sulle memorie computazionali, cercando di portare l’elaborazione vicino ai dati, invece di spedirli avanti e indietro come pacchi Amazon. Ma la vera sorpresa arrivò da un gruppo di ricercatori chiamato DeepSeek, che aveva un asso nella manica: Multihead Latent Attention.

Questa tecnica, apparentemente astrusa, si rivelò una benedizione per chiunque fosse costretto a lavorare con enormi moli di dati. Invece di affidarsi a una gestione rigida e sequenziale delle informazioni, Multihead Latent Attention riusciva a lavorare con matrici più piccole, riducendo drasticamente il peso computazionale dei modelli di deep learning.

Era come se Von Neumann, dal suo ipotetico aldilà, si fosse piegato su una scacchiera quantistica e avesse esclamato: “Ah, ecco dove sbagliavo!”

Il principio era affascinante: anziché dover manipolare enormi matrici dense – come i classici Transformer, che si portavano dietro una zavorra pesantissima – Multihead Latent Attention trovava un modo per far emergere le informazioni essenziali senza sprechi. Un po’ come filtrare le conversazioni più interessanti in una festa caotica senza dover ascoltare tutti gli invitati.

Questa tecnica, che strizzava l’occhio alle bio-memorie e ai processori neuromorfici, rappresentava un passo avanti epocale: il bottleneck di Von Neumann non veniva eliminato, ma aggirato con un’eleganza che avrebbe fatto sorridere lo stesso Von Neumann. Finalmente, dopo decenni di tentativi, la sua eredità poteva essere riscattata non con la distruzione dell’architettura che portava il suo nome, ma con una soluzione che la faceva funzionare meglio, quasi senza sforzo.

Forse il vecchio Von Neumann, noto per il suo sarcasmo e il suo senso dell’ironia, avrebbe apprezzato il colpo di scena. Dopo tutto, anche la scienza ama le sue beffe: per risolvere il problema più grande del suo genio, c’è voluto un secolo e un’intelligenza artificiale.

OpenAI ha annunciato una collaborazione con il Los Alamos National Laboratory (LANL) per integrare i suoi modelli di intelligenza artificiale di ultima generazione, noti come o1, nel supercomputer Venado del laboratorio. Questa iniziativa mira a potenziare la ricerca sulla sicurezza nazionale, con un focus particolare sulla riduzione del rischio di guerra nucleare e sulla sicurezza dei materiali e delle armi nucleari a livello globale.

Il supercomputer Venado, sviluppato in collaborazione con Hewlett Packard Enterprise (HPE) e NVIDIA, rappresenta un avanzamento significativo nelle capacità di calcolo del LANL. Dotato di 2.560 superchip Grace Hopper di NVIDIA, Venado è progettato per gestire applicazioni di intelligenza artificiale su larga scala e calcoli ad alte prestazioni. Questa infrastruttura consentirà ai ricercatori di eseguire simulazioni avanzate in vari campi, tra cui la scienza dei materiali e l’astrofisica ad alta risoluzione.

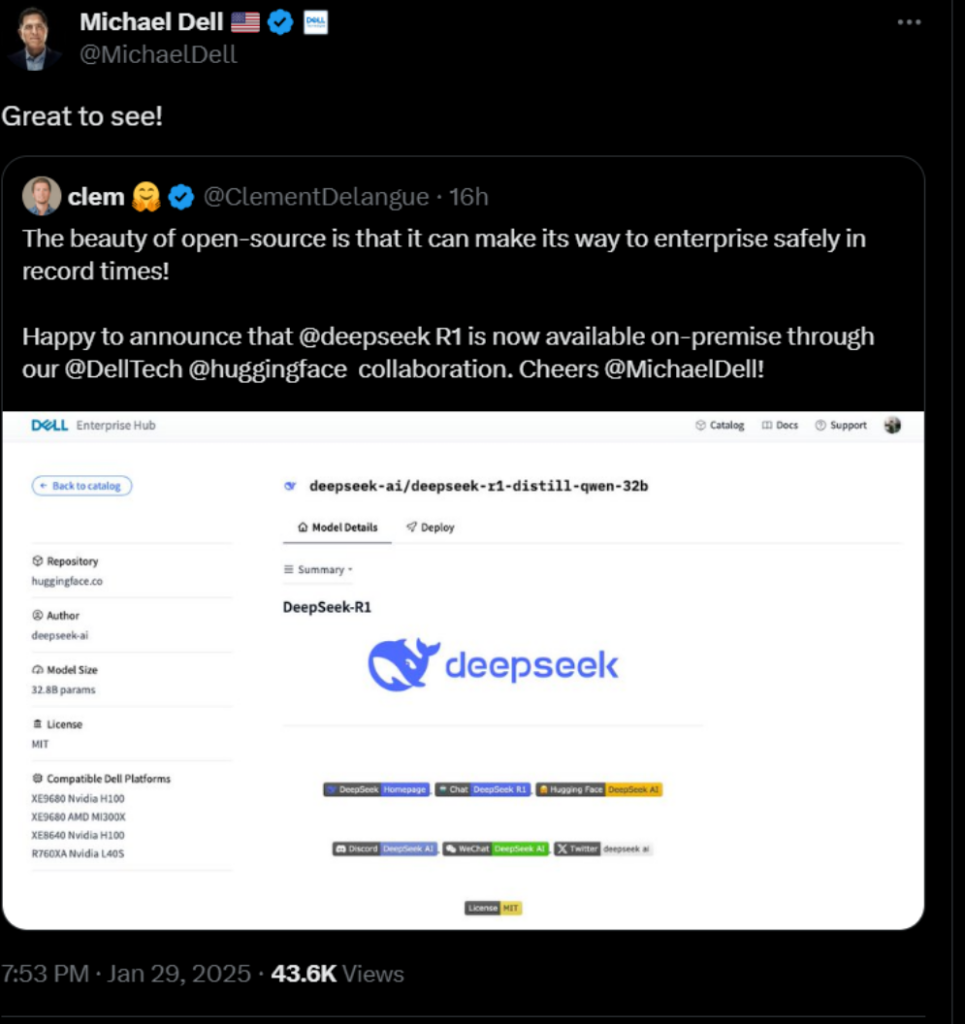

Silicon Valley ha un nuovo incubo: DeepSeek, la startup cinese che è riuscita a sviluppare modelli AI avanzati con un budget da pizza e birra rispetto ai miliardi di dollari bruciati da OpenAI. Un miracolo? O forse un po’ di sana, vecchia ingegneria inversa con una spruzzata di “prendiamo in prestito e vediamo come va”?

Microsoft e OpenAI hanno lanciato un’indagine perché sospettano che DeepSeek abbia usato le API di OpenAI per addestrare i propri modelli. Secondo fonti interne, a fine 2024 sono stati individuati enormi flussi di dati in uscita dagli account sviluppatore di OpenAI, apparentemente collegati a DeepSeek. In altre parole, qualcuno ha trovato il rubinetto aperto e ha riempito la piscina.

L’intensificarsi della competizione tra Stati Uniti e Cina nel campo dell’intelligenza artificiale ha portato a un acceso dibattito sulle politiche di controllo delle esportazioni di chip avanzati. Recentemente, DeepSeek, un’azienda cinese di AI, ha dimostrato di poter sviluppare modelli all’avanguardia a costi inferiori rispetto a quelli statunitensi. Ma questo significa che i controlli sulle esportazioni hanno fallito? Secondo Dario Amodei, CEO di Anthropic, la risposta è no. Anzi, la sua analisi suggerisce che le recenti evoluzioni rendono ancora più cruciale il mantenimento e il rafforzamento delle restrizioni sulle esportazioni di semiconduttori verso la Cina.

Ma chi lo avrebbe mai detto? Una piccola startup cinese ha mandato in tilt l’intero settore tecnologico americano, e non con qualche trucchetto sporco, ma semplicemente costruendo un’intelligenza artificiale più efficiente e meno costosa.

DeepSeek ha rilasciato il suo modello R1, capace di competere con i mostri sacri americani a una frazione del costo. Risultato? Un bagno di sangue in borsa: Nvidia ha bruciato 600 miliardi di dollari di valore in un colpo solo. Per un attimo, sembrava di essere tornati al 2008, ma senza i banchieri di Wall Street da incolpare. Questa volta, il colpevole è un manipolo di programmatori cinesi che, a quanto pare, sanno fare di meglio con meno.

Il pellegrinaggio verso la magione di Masayoshi Son a Tokyo. (50 Billion$) – Speciale un caffè al Bar dei Daini

Questa volta è stato Sam Altman a imbarcarsi in quell’estenuante volo di 11 ore da San Francisco, nella speranza di convincere il miliardario giapponese a iniettare qualche miliardo nella sua ultima fantasia da tech bro. E ha funzionato. SoftBank sta per prendersi la fetta più grande del rischio finanziario dietro Stargate, il mega progetto da 500 miliardi di dollari che promette di rivoluzionare i data center. Son ha promesso di investire circa 40 miliardi, forse divisi tra Stargate e OpenAI. Chiaramente, dettagli insignificanti.

Ma ecco la realtà: il progetto sarà pesantemente finanziato a debito, come sempre. E per far funzionare i numeri, Son dovrà mescolare il suo inossidabile ottimismo tecnologico con la solita finanza creativa. Peccato che i mercati non siano più quelli del 2021 e trovare creditori pronti a credere nell’ennesimo sogno tech potrebbe non essere così facile. Il rischio è enorme, ma per Son è l’ennesima chance di sedersi al tavolo che conta nell’AI, un’ossessione che lo perseguita da anni.

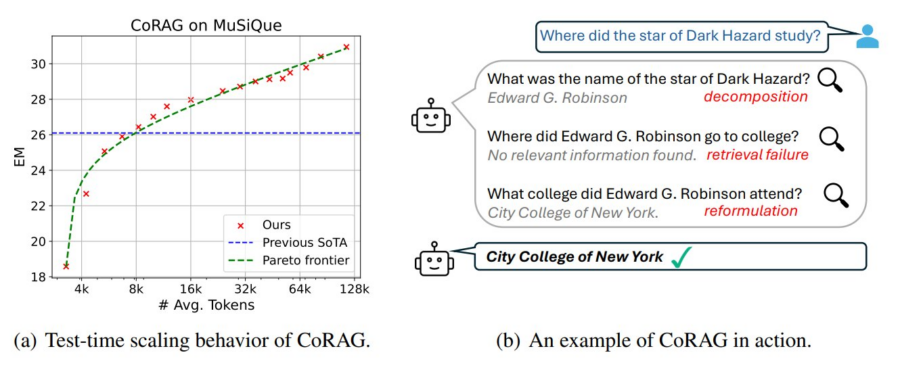

La generazione aumentata dal recupero delle informazioni (Retrieval-Augmented Generation, RAG) si evolve con l’introduzione del Chain-of-Retrieval Augmented Generation (CoRAG), che combina il potere del recupero iterativo con modelli di ragionamento Chain-of-Thought (CoT). Questo approccio consente di affrontare domande complesse suddividendo il processo in passaggi successivi, recuperando informazioni rilevanti e ragionando su di esse prima di generare una risposta finale.

Cos’è il CoRAG?

Il CoRAG migliora il tradizionale RAG integrando un ragionamento passo-passo, emulando il modo in cui un essere umano affronta domande a più livelli (multi-hop). Questo approccio si rivela cruciale in contesti dove una semplice pipeline “query-risposta” non è sufficiente, come nei task di domande complesse o nei problemi che richiedono più passaggi logici per essere risolti.

Il Costo dell’Addestramento: Un Investimento Molto Maggiore

Secondo Philipp Schmid Technical Lead & LLMs aHugging Face, DeepSeek R1 è emerso come un attore di rilievo nel panorama dell’intelligenza artificiale e del machine learning, suscitando molta attenzione sia nelle comunità tecnologiche che scientifiche.

Tuttavia, tra l’entusiasmo crescente, sono circolate numerose informazioni errate che hanno generato confusione, portando molti a credere a false affermazioni. Analizziamo i fatti e facciamo chiarezza su alcuni dei punti chiave errati che circolano riguardo a DeepSeek R1, le sue capacità e la sua storia.Una delle affermazioni più fuorvianti riguarda il presunto basso costo dell’addestramento del modello DeepSeek R1.

Alcuni rapporti hanno suggerito che l’addestramento sarebbe costato solo circa 6 milioni di dollari. Questa cifra è ben lontana dalla realtà.

In effetti, la potenza di calcolo necessaria per il modello base (senza reinforcement learning o altri aggiustamenti) ha avuto un costo di circa 5,5 milioni di dollari in ore GPU.

Questa cifra non comprende altre componenti cruciali, come le ablation, i piccoli esperimenti, la generazione dei dati e altre fasi dell’intero processo di addestramento di DeepSeek R1.

L’affermazione che l’addestramento sia costato solo 6 milioni è quindi una semplificazione eccessiva che non tiene conto della complessità e delle risorse coinvolte nella costruzione di un modello così avanzato.

Qwen 2.5 VL è la risposta concreta a tutte le aspettative legate ai modelli multimodali. Mentre Deepseek continua a generare clamore, Qwen si posiziona come leader nel settore con il suo modello Vision Language (VL), che introduce capacità straordinarie per interfacciarsi con la tecnologia quotidiana, interpretare documenti complessi e persino controllare dispositivi come computer e smartphone.

DeepSeek AI ha presentato DeepSeek-R1, un modello open source che si pone come un diretto concorrente del noto OpenAI-o1 nei compiti di ragionamento complesso. Questo traguardo è stato raggiunto grazie all’introduzione di un algoritmo innovativo chiamato Group Relative Policy Optimization (GRPO) e a un approccio multi-stage basato sul reinforcement learning (RL). La combinazione di queste tecniche ha consentito di superare molte delle limitazioni tradizionali nei modelli di intelligenza artificiale per il ragionamento avanzato.

Donald Trump ha annunciato lunedì l’intenzione di imporre dazi all’importazione su settori strategici come i semiconduttori e i prodotti farmaceutici, in un’iniziativa volta a riportare la produzione di beni essenziali sul suolo americano. L’ex presidente ha esposto questa proposta durante un intervento al ritiro dei repubblicani del Congresso a Miami, sostenendo che queste misure mirano a ridurre la dipendenza da Paesi esteri per tecnologie e beni fondamentali.

Trump ha messo in evidenza il caso specifico dei semiconduttori, un settore cruciale per l’industria tecnologica globale. “Hanno lasciato gli Stati Uniti per andare a Taiwan… e noi vogliamo che tornino indietro”, ha dichiarato, riferendosi in particolare ai produttori di chip. Questa dichiarazione sembra rivolgersi direttamente a Taiwan Semiconductor Manufacturing Company (TSMC), il più grande produttore di semiconduttori al mondo, che potrebbe subire significative conseguenze economiche nel caso di un inasprimento delle tariffe commerciali.

DeepSeek, dichiara di aver sviluppato il suo modello con un budget di soli 5 milioni di dollari, ha sovvertito il paradigma tradizionale dell’IA, basato su enormi risorse computazionali. Mentre aziende occidentali come OpenAI spendono miliardi di dollari in infrastrutture, DeepSeek sembra aver dimostrato che è possibile ottenere risultati comparabili con un approccio più efficiente e innovativo. Tuttavia, questa straordinaria efficienza tecnica è ora sotto esame, non solo per la sua innovatività, ma anche per le implicazioni geopolitiche e di sicurezza che comporta.

Marc Andreessen ha recentemente definito (WSJ) il periodo che stiamo vivendo come “il momento Sputnik dell’IA”, un’affermazione che, a prima vista, potrebbe sembrare esagerata, ma che, se esaminata più a fondo, si svela come una descrizione sorprendentemente precisa del momento storico che stiamo attraversando.

L’analogia con lo Sputnik non è casuale. Quando il satellite sovietico fu lanciato nel 1957, il mondo occidentale, in particolare gli Stati Uniti, si ritrovò di fronte a un’invasione tecnologica che non aveva previsto e che li costrinse a reagire. Non era una questione di forza militare, ma di superiorità tecnologica che modificava l’equilibrio globale.

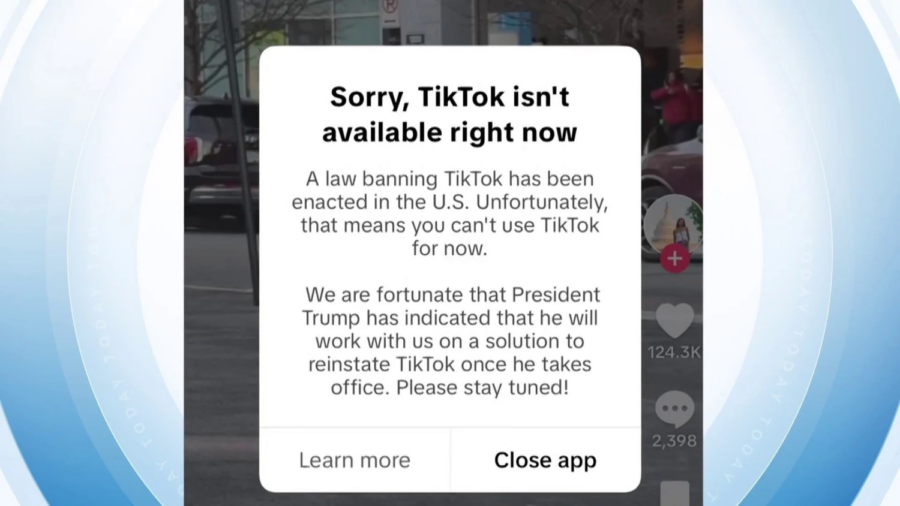

La recente decisione di Starlink di bloccare TikTok, coinvolgendo anche gli utenti italiani, getta una luce inquietante sulla fragilità dell’infrastruttura digitale globale e sui rischi legati alla “raggiungibilità giuridica”. Questo episodio, per quanto apparentemente circoscritto, rappresenta un esempio concreto di come decisioni tecnologiche e geopolitiche possano avere un impatto diretto e spesso imprevedibile sugli utenti finali, specialmente quando i fornitori di servizi globali si trovano a operare in un vuoto normativo o, peggio, in una cornice regolatoria dominata da interessi unilaterali.

Nvidia ha visto sparire dalla sua capitalizzazione di mercato la bellezza di 589 miliardi di dollari in una sola giornata, un record storico che di certo non verrà celebrato con una targa. Il crollo è stato causato, ironia della sorte, da una startup cinese dal nome apparentemente innocuo, DeepSeek, che ha avuto l’audacia di presentare un modello linguistico di grandi dimensioni, il famigerato R1, gettando un’ombra sul dominio AI degli Stati Uniti. Jensen Huang, CEO di Nvidia, potrebbe non aver preso bene la notizia, anche se ufficialmente la compagnia applaude l’innovazione… come chi applaude il rivale che gli soffia la corona.