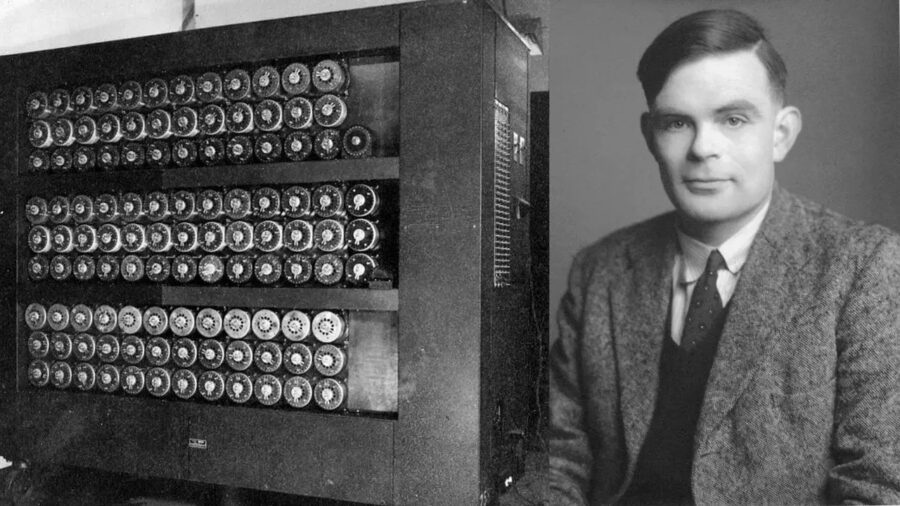

L’AI Safety Summit sull’Intelligenza Artificiale, organizzato dal Primo Ministro inglese Rishi Sunak si è concluso con un accordo noto come la Dichiarazione di Bletchley, che mira a gestire i rischi dell’IA e a promuovere la collaborazione attraverso organizzazioni internazionali esistenti e nuove iniziative.

Quali sono i punti Chiave della Dichiarazione di Bletchley

La Dichiarazione di Bletchley traccia una visione condivisa per promuovere la sicurezza e le considerazioni etiche nello sviluppo e nell’implementazione dell’Intelligenza Artificiale (IA).

Di seguito i principi fondamentali inclusi nella dichiarazione:

Cooperazione Internazionale

Si pone un forte accento sulla promozione della cooperazione internazionale per affrontare il complesso panorama della sicurezza dell’IA. La dichiarazione sottolinea la necessità di un fronte unito nel far fronte alle sfide e nel sfruttare le opportunità che l’IA presenta su scala globale.

Standard di Sicurezza

La dichiarazione sostiene l’istituzione e l’adesione a standard di sicurezza elevati nella progettazione, sviluppo e implementazione dei sistemi di IA. Ciò include un impegno condiviso a ridurre i rischi associati all’IA e assicurare che queste tecnologie siano sviluppate con un approccio orientato alla sicurezza.

IA Etica

Una forte bussola morale guida la dichiarazione, enfatizzando l’importanza delle considerazioni etiche nell’IA. Questo include assicurare che le tecnologie di IA rispettino i diritti umani, la privacy e i valori democratici, promuovendo un approccio centrato sull’essere umano all’IA.

Trasparenza e Responsabilità

La dichiarazione mette in luce anche l’importanza critica della trasparenza e della responsabilità nei sistemi di IA. Questo è visto come un pilastro fondamentale per costruire la fiducia e la comprensione del pubblico, essenziali per l’integrazione di successo delle tecnologie di IA nella società.

Condivisione della Conoscenza

L’incoraggiamento alla condivisione della conoscenza e alla ricerca collaborativa tra le nazioni è un aspetto chiave della dichiarazione. Questo mira ad accelerare la comprensione globale e la mitigazione dei rischi legati all’IA, promuovendo una cultura di apprendimento condiviso e miglioramento continuo nelle pratiche di sicurezza dell’IA.

Sotto il testo integrale della Dichiarazione di Bletchley:

“L’intelligenza artificiale (AI) presenta enormi opportunità globali: ha il potenziale per trasformare e migliorare il benessere umano, la pace e la prosperità. Per realizzare ciò, affermiamo che, per il bene di tutti, l’intelligenza artificiale dovrebbe essere progettata, sviluppata, implementata e utilizzata in modo sicuro, in modo tale da essere incentrata sull’uomo, affidabile e responsabile. Accogliamo con favore gli sforzi compiuti finora dalla comunità internazionale per cooperare sull’intelligenza artificiale per promuovere la crescita economica inclusiva, lo sviluppo sostenibile e l’innovazione, per proteggere i diritti umani e le libertà fondamentali e per promuovere la fiducia del pubblico nei sistemi di intelligenza artificiale per realizzare appieno il loro potenziale.

I sistemi di intelligenza artificiale sono già utilizzati in molti ambiti della vita quotidiana, tra cui alloggio, occupazione, trasporti, istruzione, sanità, accessibilità e giustizia, e il loro utilizzo è destinato ad aumentare. Riconosciamo che questo è quindi un momento unico per agire e affermare la necessità di uno sviluppo sicuro dell’IA e di utilizzare le opportunità di trasformazione dell’IA per il bene e per tutti, in modo inclusivo nei nostri paesi e a livello globale. Ciò include servizi pubblici come sanità e istruzione, sicurezza alimentare, scienza, energia pulita, biodiversità e clima, per realizzare il godimento dei diritti umani e per rafforzare gli sforzi verso il raggiungimento degli obiettivi di sviluppo sostenibile delle Nazioni Unite.

Oltre a queste opportunità, l’intelligenza artificiale comporta anche rischi significativi, anche negli ambiti della vita quotidiana. A tal fine, accogliamo con favore gli sforzi internazionali volti a esaminare e affrontare il potenziale impatto dei sistemi di intelligenza artificiale nei forum esistenti e in altre iniziative pertinenti, e il riconoscimento che la tutela dei diritti umani, la trasparenza e la spiegabilità, l’equità, la responsabilità, la regolamentazione, la sicurezza, un’adeguata È necessario affrontare il problema del controllo umano, dell’etica, della mitigazione dei pregiudizi, della privacy e della protezione dei dati. Notiamo inoltre i potenziali rischi imprevisti derivanti dalla capacità di manipolare contenuti o generare contenuti ingannevoli. Tutte queste questioni sono di fondamentale importanza e affermiamo la necessità e l’urgenza di affrontarle.

Particolari rischi per la sicurezza emergono alla “frontiera” dell’IA , intesa come quei modelli di IA per scopi generali altamente capaci , compresi i modelli di base, che potrebbero svolgere un’ampia varietà di compiti, così come l’ IA specifica e ristretta che potrebbe mostrare capacità che causano danno – che corrispondono o superano le capacità presenti nei modelli più avanzati di oggi. Rischi sostanziali possono derivare da un potenziale uso improprio intenzionale o da problemi di controllo non intenzionali relativi all’allineamento con l’intento umano. Questi problemi sono in parte dovuti al fatto che tali capacità non sono completamente comprese e sono quindi difficili da prevedere. Siamo particolarmente preoccupati da tali rischi in settori quali la sicurezza informatica e la biotecnologia, nonché laddove i sistemi di intelligenza artificiale di frontiera possono amplificare rischi come la disinformazione. Esiste il rischio di danni gravi, persino catastrofici, deliberati o involontari, derivanti dalle capacità più significative di questi modelli di intelligenza artificiale . Dato il tasso di cambiamento rapido e incerto dell’intelligenza artificiale e nel contesto dell’accelerazione degli investimenti nella tecnologia, affermiamo che approfondire la nostra comprensione di questi potenziali rischi e delle azioni per affrontarli è particolarmente urgente.

Molti rischi derivanti dall’intelligenza artificiale sono intrinsecamente di natura internazionale e quindi possono essere affrontati meglio attraverso la cooperazione internazionale. Decidiamo di lavorare insieme in modo inclusivo per garantire un’IA incentrata sull’uomo, affidabile e responsabile che sia sicura e sostenga il bene di tutti attraverso i forum internazionali esistenti e altre iniziative pertinenti, per promuovere la cooperazione per affrontare l’ampia gamma di rischi posti da AI . In tal modo, riconosciamo che i paesi dovrebbero considerare l’importanza di una governance e di un approccio normativo proporzionato e pro-innovazione che massimizzi i benefici e tenga conto dei rischi associati all’intelligenza artificiale . Ciò potrebbe includere, ove opportuno, classificazioni e categorizzazioni dei rischi basate sulle circostanze nazionali e sui quadri giuridici applicabili. Notiamo inoltre l’importanza della cooperazione, ove opportuno, su approcci quali principi comuni e codici di condotta. Per quanto riguarda i rischi specifici riscontrati molto probabilmente in relazione all’IA di frontiera, decidiamo di intensificare e sostenere la nostra cooperazione e di ampliarla con altri paesi, per identificare, comprendere e, se del caso, agire, attraverso i forum internazionali esistenti e altre iniziative pertinenti, tra cui futuri vertici internazionali sulla sicurezza dell’intelligenza artificiale .

Tutti gli attori hanno un ruolo da svolgere nel garantire la sicurezza dell’IA : le nazioni, i forum internazionali e altre iniziative, le aziende, la società civile e il mondo accademico dovranno lavorare insieme. Rilevando l’importanza di un’intelligenza artificiale inclusiva e di colmare il divario digitale, riaffermiamo che la collaborazione internazionale dovrebbe cercare di coinvolgere un’ampia gamma di partner, a seconda dei casi, e accogliere con favore approcci e politiche orientati allo sviluppo che potrebbero aiutare i paesi in via di sviluppo a rafforzare lo sviluppo e l’effetto leva delle capacità dell’intelligenza artificiale . il ruolo abilitante dell’intelligenza artificiale per sostenere la crescita sostenibile e colmare il divario di sviluppo.

Affermiamo che, sebbene la sicurezza debba essere considerata in tutto il ciclo di vita dell’IA , gli attori che sviluppano capacità di IA di frontiera , in particolare quei sistemi di IA insolitamente potenti e potenzialmente dannosi, hanno una responsabilità particolarmente forte nel garantire la sicurezza di questi sistemi di IA , anche attraverso sistemi per i test di sicurezza, attraverso valutazioni e altre misure appropriate. Incoraggiamo tutti gli attori rilevanti a fornire trasparenza e responsabilità adeguate al contesto sui loro piani per misurare, monitorare e mitigare le capacità potenzialmente dannose e gli effetti associati che potrebbero emergere, in particolare per prevenire abusi e problemi di controllo e l’amplificazione di altri rischi.

Nel contesto della nostra cooperazione, e per informare l’azione a livello nazionale e internazionale, la nostra agenda per affrontare il rischio dell’IA di frontiera si concentrerà su:

- identificare i rischi per la sicurezza dell’IA di interesse condiviso, costruire una comprensione scientifica condivisa e basata sull’evidenza di questi rischi e sostenere tale comprensione mentre le capacità continuano ad aumentare, nel contesto di un approccio globale più ampio alla comprensione dell’impatto dell’IA nelle nostre società .

- costruendo rispettive politiche basate sul rischio in tutti i nostri paesi per garantire la sicurezza alla luce di tali rischi, collaborando in modo appropriato e riconoscendo che i nostri approcci possono differire in base alle circostanze nazionali e ai quadri giuridici applicabili. Ciò include, oltre a una maggiore trasparenza da parte degli attori privati che sviluppano capacità di intelligenza artificiale di frontiera , parametri di valutazione adeguati, strumenti per test di sicurezza e lo sviluppo di capacità pertinenti del settore pubblico e della ricerca scientifica.

A sostegno di questo programma, decidiamo di sostenere una rete inclusiva a livello internazionale di ricerca scientifica sulla sicurezza dell’IA di frontiera che comprenda e integri la collaborazione multilaterale, plurilaterale e bilaterale esistente e nuova, anche attraverso forum internazionali esistenti e altre iniziative pertinenti, per facilitare la fornitura di la migliore scienza disponibile per l’elaborazione delle politiche e il bene pubblico.

Riconoscendo il potenziale positivo di trasformazione dell’IA e come parte della garanzia di una più ampia cooperazione internazionale sull’IA , decidiamo di sostenere un dialogo globale inclusivo che coinvolga i forum internazionali esistenti e altre iniziative pertinenti e contribuisca in modo aperto a discussioni internazionali più ampie, e continuare la ricerca sulla sicurezza dell’IA di frontiera per garantire che i vantaggi della tecnologia possano essere sfruttati in modo responsabile per il bene e per tutti. Non vediamo l’ora di incontrarci di nuovo nel 2024″.