L’FBI combatte gli attacchi informatici attraverso una serie di strategie avanzate. L’FBI è responsabile di investigare e prevenire le minacce informatiche, specialmente in settori critici come la sanità, dove attacchi ransomware o violazioni di dati sensibili possono avere impatti devastanti.

Autore: Alessandra Innocenti Pagina 12 di 18

L’industria della moda e del lusso sta davvero attraversando una rivoluzione senza precedenti, e il motore di questo cambiamento è l’Intelligenza Artificiale (IA). Sebbene molti associno l’uso dell’IA semplicemente ad automazione o analisi dei dati, oggi la sua applicazione nel settore è molto più profonda e trasformativa. Stiamo parlando della capacità di creare capi unici, su misura per i gusti e desideri personali di ogni singolo cliente, inaugurando una nuova era di estrema personalizzazione.

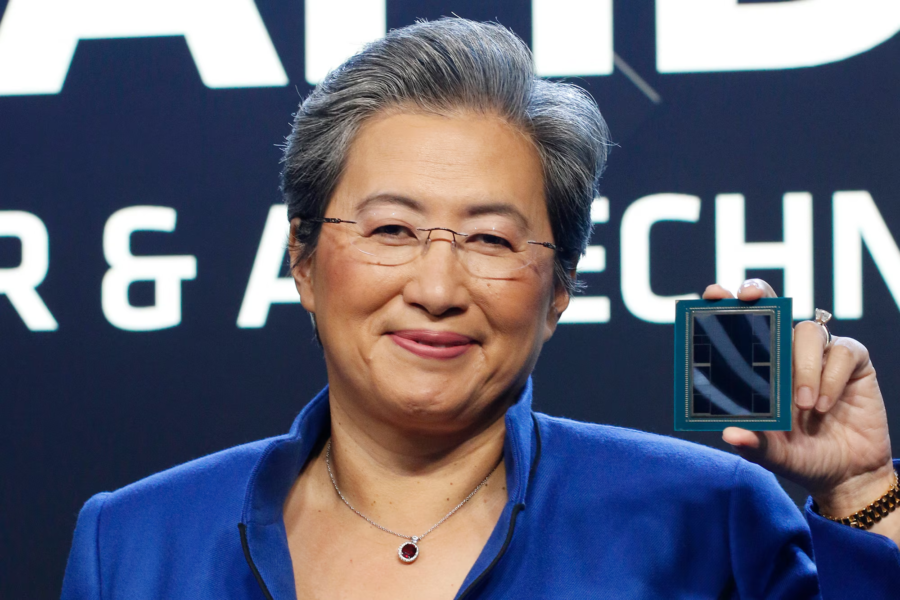

AMD ha svelato il suo ultimo chip per intelligenza artificiale, l’Instinct MI325X, durante un evento volto a sfidare il dominio di Nvidia nel mercato delle GPU per data center. Questo nuovo chip inizierà la produzione entro la fine del 2024 ed è progettato per competere direttamente con i prossimi chip Blackwell di Nvidia, che si prevede inizieranno a essere spediti all’inizio del prossimo anno.

Elad Gil, un investitore di spicco nel panorama tecnologico, sta compiendo significativi passi nel settore sanitario sostenendo Abridge, una startup focalizzata sull’uso dell’intelligenza artificiale per migliorare la documentazione clinica. Abridge ha sviluppato strumenti innovativi che trascrivono e strutturano in tempo reale le conversazioni tra medici e pazienti, con l’obiettivo di alleviare i carichi amministrativi affrontati dai professionisti della salute.

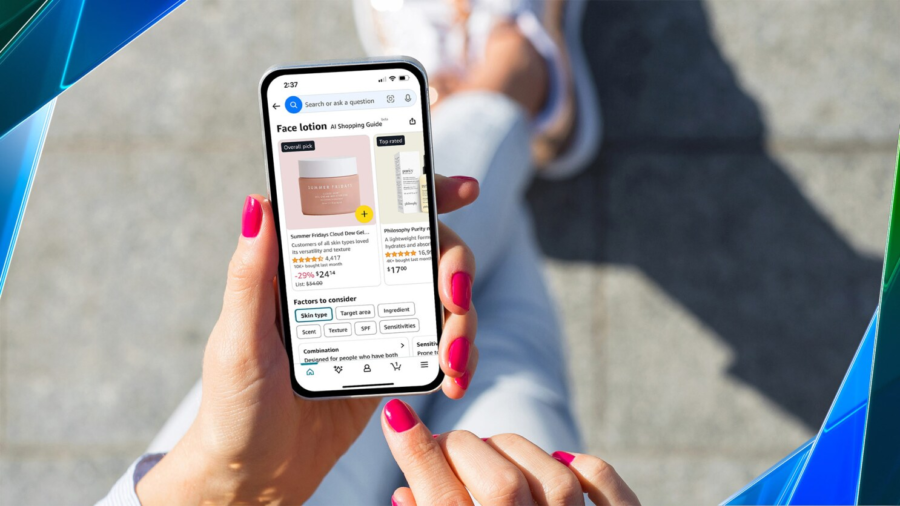

Amazon ha lanciato un nuovo strumento di shopping che utilizza l’intelligenza artificiale per aiutare i clienti a trovare rapidamente prodotti in base a caratteristiche specifiche. I “Shopping Guides” alimentati da AI sono ora disponibili negli Stati Uniti sul sito mobile di Amazon e nelle app per iOS e Android, offrendo agli utenti informazioni sui prodotti e raccomandazioni più personalizzate durante la navigazione.

Secondo l’Accademia Reale Svedese delle Scienze, Demis Hassabis e John Jumper di Google DeepMind hanno vinto il Premio Nobel per la Chimica 2024 per il loro rivoluzionario lavoro sulla previsione della struttura delle proteine tramite l’intelligenza artificiale, condividendo l’onore con David Baker per i suoi progressi nella progettazione computazionale delle proteine.

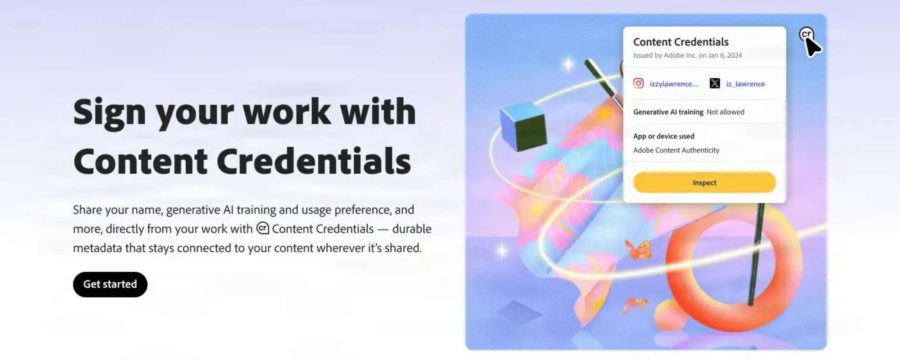

Negli ultimi anni, l’emergere dell’intelligenza artificiale (IA) ha sollevato preoccupazioni significative tra gli artisti riguardo alla protezione delle loro opere. Adobe, un gigante nel settore del software creativo, ha recentemente annunciato una serie di iniziative volte a proteggere i diritti degli artisti nell’era dell’IA. Queste misure includono un nuovo strumento web che consente agli artisti di contrassegnare le loro opere e di escluderle dall’uso per l’addestramento dei modelli generativi di IA.

Microsoft-backed OpenAI continua a espandere le sue partnership con editori, avendo recentemente siglato un nuovo accordo con Hearst, uno dei più grandi editori di giornali e riviste negli Stati Uniti. Questa collaborazione permetterà a OpenAI di integrare contenuti provenienti da oltre 60 giornali e più di 20 riviste di Hearst nei suoi prodotti di intelligenza artificiale, inclusi ChatGPT.

L’accordo comprende pubblicazioni rinomate come Houston Chronicle, San Francisco Chronicle, Esquire e Cosmopolitan.

Le spese in conto capitale dei data center sono previste in aumento del 40% anno su anno da parte delle quattro grandi aziende di cloud, il che dovrebbe fornire opportunità ai fornitori di interconnessione dei data center (DCI), secondo Citi Research.

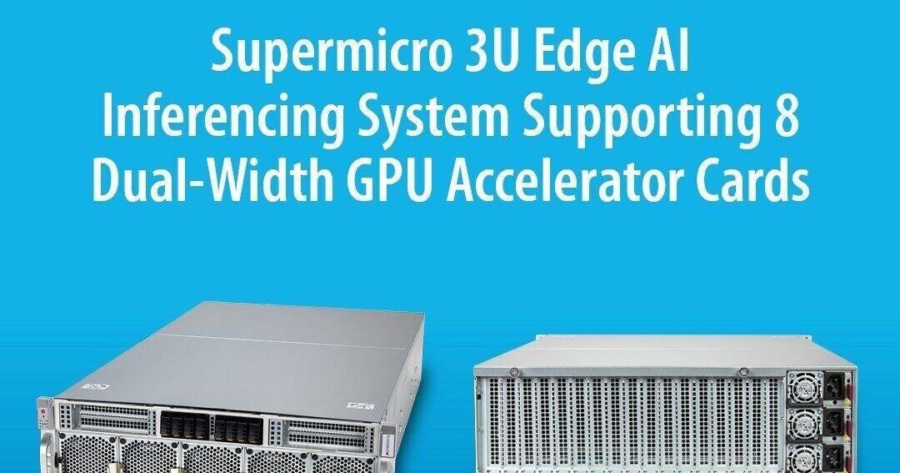

Supermicro Computer ha lanciato un nuovo server Edge AI 3U che supporta fino a 18 GPU e monta processori Dual Intel Xeon serie 6900 con P-core.

“Con la crescita del mercato AI, i clienti cercano soluzioni potenti e versatili per l’elaborazione dei dati sul posto,” ha detto il CEO di Supermicro, Charles Liang. “Il nostro nuovo sistema Edge AI 3U offre loro la possibilità di eseguire applicazioni innovative con bassa latenza.”

Il nuovo SYS-322GB-NR include due processori Intel Xeon 6900 con P-core, 8800 MT/s MRDIMM e fino a 20 slot di espansione PCIe 5.0. Il sistema supporta GPU a singola o doppia larghezza, oppure può usare alcuni slot di espansione per I/O ad alte prestazioni o altre schede aggiuntive.

Il server offre fino a 6TB di memoria RDIMM e fino a 14 unità E1.S o 6 unità U.2 NVMe. Questo lancio segue la notizia di lunedì che Supermicro ha distribuito oltre 100.000 GPU con il suo sistema di raffreddamento a liquido per grandi fabbriche di AI e fornitori di servizi cloud.

Google ha recentemente avviato il rollout della sua nuova funzionalità “Ask Photos” per alcuni utenti di Google Photos. Questa innovativa funzione, alimentata dall’intelligenza artificiale Gemini, consente agli utenti di interagire con la propria libreria fotografica utilizzando un linguaggio naturale, rendendo più semplice e intuitivo trovare foto e video specifici.

“Ask Photos” è un sistema di ricerca conversazionale che permette di porre domande relative alle proprie immagini e video memorizzati nell’app Google Photos. Gli utenti possono chiedere informazioni su eventi passati, come ad esempio “Mostrami le foto dei costumi di Halloween nel corso degli anni” o “Quando mio figlio ha imparato a nuotare”. La funzionalità è progettata per rispondere a domande più complesse rispetto alla semplice ricerca basata su parole chiave.

Google ha recentemente aggiornato il suo strumento NotebookLM, integrando nuove funzionalità che permettono di supportare audio e video grazie all’uso del modello di intelligenza artificiale Gemini 1.5 Pro. Queste innovazioni rappresentano un passo significativo nella ricerca e nell’analisi dei contenuti, rendendo NotebookLM uno strumento ancora più versatile per studenti, professionisti e chiunque necessiti di organizzare informazioni in modo efficiente.

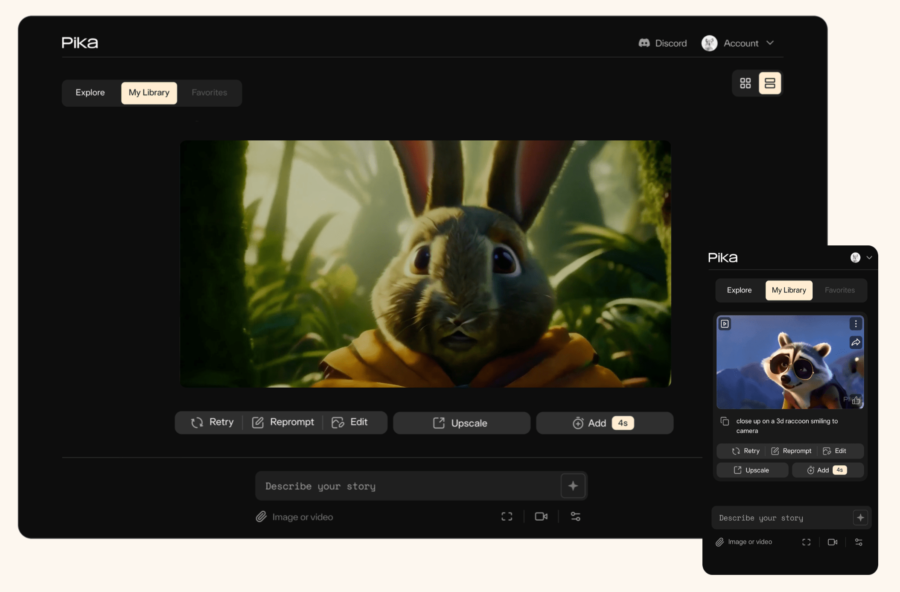

PIKA è un innovativo generatore di video basato su intelligenza artificiale che consente agli utenti di creare video a partire da testi, immagini o video esistenti. È stato lanciato da un team di sviluppatori che ha raccolto un significativo finanziamento di 55 milioni di dollari da nomi noti nel settore della tecnologia e dell’IA. Questo strumento si distingue per la sua capacità di generare e modificare video in vari stili seguendo il principio del text-to-video, rendendo la creazione video accessibile anche a chi non ha competenze tecniche.

Il progetto Quandoom, una versione del leggendario gioco DOOM (1997) sviluppata per computer quantistici, sta affrontando enormi ostacoli tecnici. Per funzionare, richiede ben 72.376 qubit e 80 milioni di porte quantistiche, superando di gran lunga le capacità dei più avanzati computer quantistici disponibili oggi. Attualmente, il computer quantistico più potente al mondo, creato da Atom Computing, ha solo 1.225 qubit, mostrando quanto ambizioso sia il progetto di Quandoom e quanto lontano siamo dal renderlo realtà.

DigitalOcean Holdings ha recentemente lanciato un modello di pagamento flessibile che consente a startup e aziende digitali in crescita di accedere alle GPU H100 di Nvidia per applicazioni di intelligenza artificiale (AI). Questa iniziativa mira a democratizzare lo sviluppo dell’AI fornendo risorse informatiche ad alte prestazioni a un costo accessibile, senza la necessità di investimenti iniziali significativi in hardware.

Microsoft ha annunciato oggi che pagherà gli editori per i contenuti utilizzati nel suo nuovo Copilot Daily.

Microsoft ha presentato Copilot Daily, un riepilogo giornaliero di notizie ed eventi rilevanti per l’utente, insieme a diverse nuove funzionalità di intelligenza artificiale. “

Copilot Daily utilizzerà solo fonti di contenuti autorizzate,” ha dichiarato Microsoft in un post sul blog oggi. “Stiamo collaborando con partner come Reuters, Axel Springer, Hearst Magazine e Financial Times, e contiamo di aggiungere ulteriori fonti nel tempo. Aggiungeremo anche più personalizzazioni e controlli in Copilot Daily nel tempo.

” Queste sono alcune delle stesse fonti di contenuti utilizzate da OpenAI, sostenuta da Microsoft, per addestrare i modelli di intelligenza artificiale. Altre nuove funzionalità di Copilot che Microsoft ha iniziato a implementare oggi includono Copilot Voice, Personalized Discover, Copilot in Microsoft Edge, Copilot Labs, Copilot Vision e Think Deeper.

OpenAI, la startup di intelligenza artificiale generativa sostenuta da Microsoft ha presentato martedì nuovi strumenti per facilitare lo sviluppo di modelli di intelligenza artificiale, tra cui un’API definita “Realtime API”. Questa API, disponibile immediatamente, consente agli sviluppatori di creare esperienze di conversazione vocale in tempo reale all’interno delle loro applicazioni utilizzando un’unica serie di istruzioni.

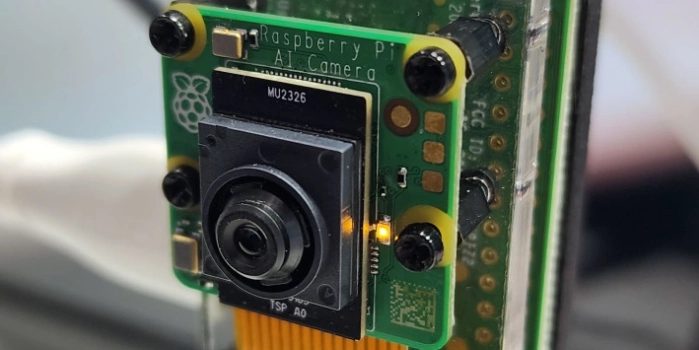

Raspberry Pi e Sony hanno recentemente lanciato un modulo di fotocamera AI, il Raspberry Pi AI Camera, disponibile al prezzo di $70. Questo dispositivo innovativo è progettato per facilitare lo sviluppo di soluzioni AI edge, capaci di analizzare dati visivi direttamente sul campo, senza la necessità di hardware aggiuntivo come GPU o acceleratori esterni.

SoftBank Investirà 500 Milioni di Dollari in OpenAI: Un Passo Strategico Verso una Valutazione di 150 Milardi

SoftBank, il gigante giapponese delle telecomunicazioni e della tecnologia, ha annunciato un investimento di 500 milioni di dollari in OpenAI, la società nota per lo sviluppo di ChatGPT. Questo investimento fa parte di un round di finanziamento più ampio in cui OpenAI mira a raccogliere un totale di 6,5 miliardi di dollari, valutando la compagnia a 150 miliardi di dollari.

NotebookLM di Google ha recentemente introdotto miglioramenti significativi, consentendo agli utenti di riassumere efficacemente i video di YouTube e i file audio. Questo aggiornamento segna un’espansione notevole delle capacità della piattaforma, che inizialmente si concentrava sui contenuti scritti.

OpenAI sta apportando modifiche al suo modello di generazione video Sora prima del rilascio, puntando a migliorare la velocità e la coerenza. Sora è un modello avanzato di intelligenza artificiale in grado di creare video realistici e coinvolgenti a partire da istruzioni testuali. Utilizza un’architettura di tipo transformer, simile a quella dei modelli GPT, e si basa su un approccio chiamato modelli di diffusione. Questo processo inizia con un video che appare come rumore statico e lo affina gradualmente, rimuovendo il rumore in più passaggi per ottenere dettagli intricati e transizioni fluide.

Apple sta preparando il lancio di un nuovo prodotto chiamato HomeAccessory, potenzialmente nella primavera del 2025. Questo dispositivo dovrebbe integrare funzionalità di vari prodotti Apple esistenti, tra cui iPad, Apple TV e HomePod, e potrebbe rappresentare un passo importante in avanti nell’ecosistema smart home di Apple.

OpenAI ha ufficialmente lanciato la sua Modalità Voce Avanzata per ChatGPT, migliorando l’esperienza conversazionale per gli utenti dei piani Plus e Teams. Questa nuova funzionalità mira a creare interazioni più naturali e fluide, sfruttando il più recente modello GPT-4o, che integra capacità di elaborazione di testo, visione e audio.

Ai2 ha recentemente lanciato Molmo, un modello di intelligenza artificiale open-source multimodale che si propone di competere con i sistemi proprietari più affermati. Questa nuova AI si distingue per le sue notevoli capacità nelle attività basate sulla visione, riuscendo a ottenere risultati comparabili a quelli dei modelli commerciali, ma utilizzando un dataset significativamente più piccolo.

Baidu ha recentemente svelato significativi aggiornamenti alle sue piattaforme AI durante un evento a Pechino, segnando un momento cruciale nello sviluppo continuo delle tecnologie di intelligenza artificiale da parte dell’azienda. Il punto culminante di questo evento è stata l’introduzione dell’Ernie 4.0 Turbo, una versione potenziata del modello Ernie esistente, che mira a competere direttamente con i principali sistemi AI come il GPT-4 di OpenAI.

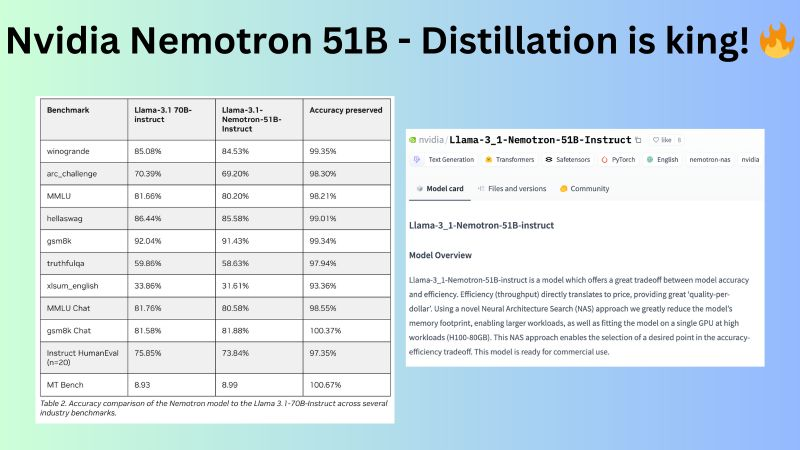

NVIDIA ha recentemente presentato il Nemotron 51B, un modello di linguaggio AI all’avanguardia che vanta metriche di prestazione impressionanti, essendo 220% più veloce e capace di gestire 400% in più di carico di lavoro rispetto al suo predecessore, il Llama 3.1 70B. Questo modello rappresenta un significativo progresso nella tecnologia AI, in particolare in termini di velocità e scalabilità, rendendolo un rilascio notevole nel campo dell’AI generativa.

Microsoft ha annunciato un investimento significativo di 1,3 miliardi di dollari in Messico, volto a potenziare la propria infrastruttura di intelligenza artificiale (AI) e cloud nei prossimi tre anni. Questa iniziativa è stata svelata dal Presidente e CEO di Microsoft, Satya Nadella, durante il Microsoft AI Tour 2024 a Città del Messico.

L’investimento si concentrerà sul miglioramento della connettività, sulla promozione delle competenze digitali e sull’incentivazione dell’adozione dell’AI tra le piccole e medie imprese (PMI) per accelerare i loro sforzi di trasformazione digitale.

Gli analisti di International Data Corporation (IDC) hanno pubblicato un nuovo studio intitolato ‘The Global Impact of Artificial Intelligence on the Economy and Jobs‘, che esamina come l’AI influenzerà la crescita economica e il mercato del lavoro a livello globale e regionale. Secondo le previsioni, entro il 2030, l’Intelligenza Artificiale rappresenterà il 3,5% del PIL mondiale, con ogni dollaro speso in AI che genererà 4,6 dollari nell’economia globale.

“La logistica è uno degli asset del nostro Paese e lo sarà sempre di più” ha dichiarato il ministro delle Imprese e del Made in Italy, Adolfo Urso, durante l’inaugurazione del nuovo polo logistico di Kuehne+Nagel per Adidas a Mantova. Questo settore, che rappresenta 93 miliardi di euro di PIL (pari al 5,4%) e impiega oltre un milione di persone, è stato definito da Urso come un “motore dell’economia” e un “punto fondamentale per l’Italia“.

Gli Small Language Models (SLM) stanno guadagnando popolarità nel campo del Natural Language Processing (NLP) grazie alla loro efficienza e capacità di operare con risorse limitate. Questi modelli, caratterizzati da un numero di parametri significativamente inferiore rispetto ai Large Language Models (LLM), offrono prestazioni competitive in vari compiti di elaborazione del linguaggio naturale, pur mantenendo un consumo energetico e computazionale ridotto.

L’intelligenza artificiale (AI) sta rivoluzionando il settore della moda, trasformando il modo in cui i marchi analizzano le tendenze, progettano i prodotti e interagiscono con i consumatori. Questa evoluzione è guidata dalla capacità dell’AI di elaborare enormi quantità di dati e fornire previsioni più accurate rispetto ai metodi tradizionali.

Un primo passo verso la sostenibilità e la chiarezza normativa del settore dei Data Center, comparto altamente strategico per il Paese, è stato fatto. Secondo l’Osservatorio Data Center del Politecnico di Milano, questo settore potrebbe valere fino a 15 miliardi di euro di investimenti entro il 2025. Milano, in particolare, ha il potenziale per diventare una delle cinque top destination a livello europeo per questo segmento. Le nuove linee guida per le procedure di valutazione ambientale dei Data Center, pubblicate dal Ministero dell’Ambiente e della Sicurezza Energetica (Mase) a fine agosto, rappresentano un primo passo importante, anche se in Italia manca ancora una legislazione ad hoc per queste infrastrutture.

In un contesto in cui l’intelligenza artificiale sta diventando sempre più centrale nelle operazioni aziendali, ci si interroga se strumenti come ChatGPT siano sottovalutati o sovrastimati.

Mistral AI ha recentemente introdotto un livello API gratuito, consentendo agli sviluppatori di testare e perfezionare le proprie applicazioni utilizzando i modelli AI della startup. Questa iniziativa è stata annunciata attraverso un post sul blog dell’azienda e rappresenta un significativo passo avanti nella strategia di Mistral per attrarre sviluppatori, in un mercato sempre più competitivo.

L’UE è pronta a mettere in guardia Apple affinché apra il sistema operativo dell’iPhone a tecnologie concorrenti, altrimenti rischia di incorrere in multe significative, ha riportato Bloomberg News.

Secondo la Digital Markets Act (DMA) della regione, la Commissione Europea annuncerà che Apple deve rispettare le nuove regole che rendono i sistemi operativi completamente funzionali con altre tecnologie, ha aggiunto il rapporto citando fonti informate sulla questione.

Alibaba ha recentemente ampliato la sua offerta nel campo dell’intelligenza artificiale con il lancio di oltre 100 nuovi modelli open-source, che includono strumenti avanzati per la generazione di contenuti. Questi modelli sono progettati per soddisfare le esigenze di vari settori, dall’automotive ai giochi, e rappresentano un’importante evoluzione nell’ambito dell’AI generativa.

Secondo un rapporto di Reuters, i nuovi modelli di intelligenza artificiale variano tra 0,5 miliardi e 72 miliardi di parametri e supportano più di 29 lingue.

YouTube ha recentemente annunciato l’integrazione di Veo, il modello di generazione video di Google DeepMind, nella sua piattaforma Shorts. Questa nuova funzionalità, presentata durante l’evento “Made On YouTube”, consentirà ai creatori di generare sfondi di alta qualità e clip autonome di sei secondi utilizzando semplici prompt testuali.

Transizione Energetica 2.0: come l’Intelligenza Artificiale può rivoluzionare il futuro dell’energia

L’impatto e i costi sociali e finanziari della transizione energetica devono essere condivisi da tutti per riscuotere il consenso dell’opinione pubblica e non pesare troppo sulle fasce più deboli, che devono essere aiutate. Durante la conferenza con l’Agenzia Internazionale per l’Energia (AIE) ospitata dalla Banca d’Italia, il Governatore Fabio Panetta e il Ministro dell’Economia Giancarlo Giorgetti hanno sottolineato l’importanza di non arrestare l’inevitabile transizione energetica, anche se gli investimenti sembrano rallentare.

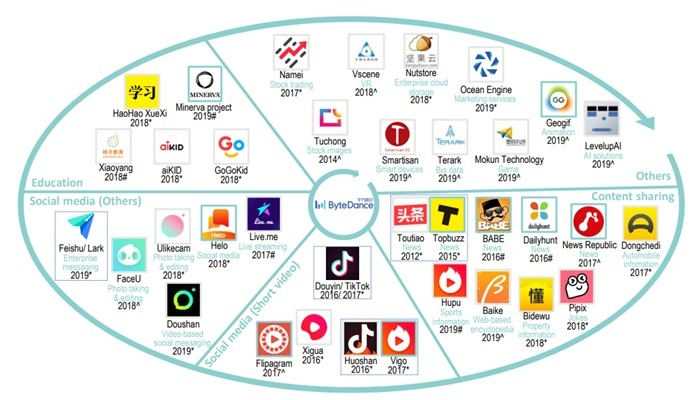

ByteDance, (il proprietario di TikTok), sta intensificando i suoi sforzi per sviluppare chip di intelligenza artificiale (AI) in un tentativo di ottenere un vantaggio competitivo nel mercato cinese dei chatbot. Secondo un rapporto di The Information, l’azienda prevede di avviare la produzione in serie di due semiconduttori progettati internamente entro il 2026, in collaborazione con Taiwan Semiconductor Manufacturing Company (TSMC).