Le previsioni indicano che il mercato globale dell’IA potrebbe crescere di 300 volte entro il 2032. Tuttavia, l’IA generativa sta già mostrando segni di rendimenti decrescenti.

«Il mondo è pronto ad assistere a un’esplosione di crescita nel settore dell’Ai generativa nei prossimi dieci anni, che promette di cambiare radicalmente il modo in cui il settore tecnologico opera.» «La tecnologia è destinata a diventare una parte sempre più essenziale della spesa It, della spesa pubblicitaria e della cybersicurezza, man mano che si sviluppa».

Bloomberg Singh

Questo articolo esamina il rallentamento e prevede lo sviluppo futuro dell’intelligenza artificiale. È interessante notare come ci siano “Forze” che spingono i media a parlare continuamente di fenomeni come l’Intelligenza Artificiale (IA), spesso senza che se ne comprenda a pieno il motivo. Questo fenomeno può essere analizzato da diversi punti di vista

I. Introduzione

- L’articolo analizza il mercato dell’intelligenza artificiale (IA) e le sue prospettive future.

II. Cause del hype sull’IA

- Interesse economico: aziende tecnologiche investono in pubblicità e marketing per creare hype attorno ai prodotti e servizi basati sull’IA.

- Innovazione e competizione: l’IA rappresenta una frontiera tecnologica in continua evoluzione, con una competizione globale per dominare questo settore.

- Influenza politica e sociale: governi e istituzioni riconoscono l’importanza strategica dell’IA per il futuro delle economie nazionali e per la sicurezza.

- Interesse pubblico e fascinazione: l’IA suscita curiosità e fascinazione nel pubblico generale.

III. Analisi del rendimento dell’IA generativa

- L’IA generativa sta già mostrando segni di rendimenti decrescenti.

- La tecnologia è destinata a diventare sempre più essenziale nella spesa IT, pubblicitaria e cybersicurezza.

IV. La bolla delle dot-com del 2000

- La bolla delle dot-com del 2000 è stata una fase speculativa nel mercato azionario che ha colpito le azioni tecnologiche nei settori dell’informatica e delle telecomunicazioni.

- Il problema era che giovani aziende di e-commerce con modelli di business non collaudati vedevano le loro capitalizzazioni di mercato crescere a livelli senza precedenti grazie all’entusiasmo degli investitori per le loro azioni.

V. La differenza tra la bolla delle dot-com e l’IA

- Oggi, il settore tecnologico si sta dimostrando più agile nella capacità di utilizzare l’intelligenza artificiale non solo per fornire servizi a valore aggiunto, ma anche nell’utilizzo della tecnologia per ottimizzare le operazioni e ridurre i costi.

- Gli investimenti nell’intelligenza artificiale richiedono ingenti risorse finanziarie, spesso dell’ordine di decine o centinaia di milioni di dollari, prima di produrre risultati concreti.

VI. La narrativa dell’IA

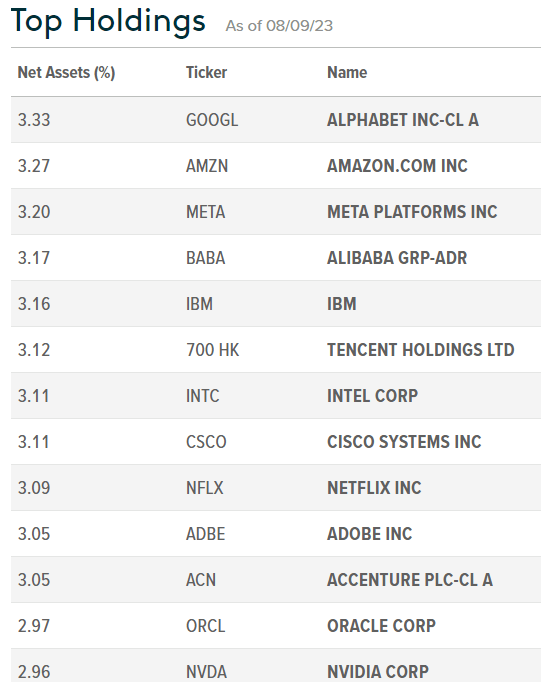

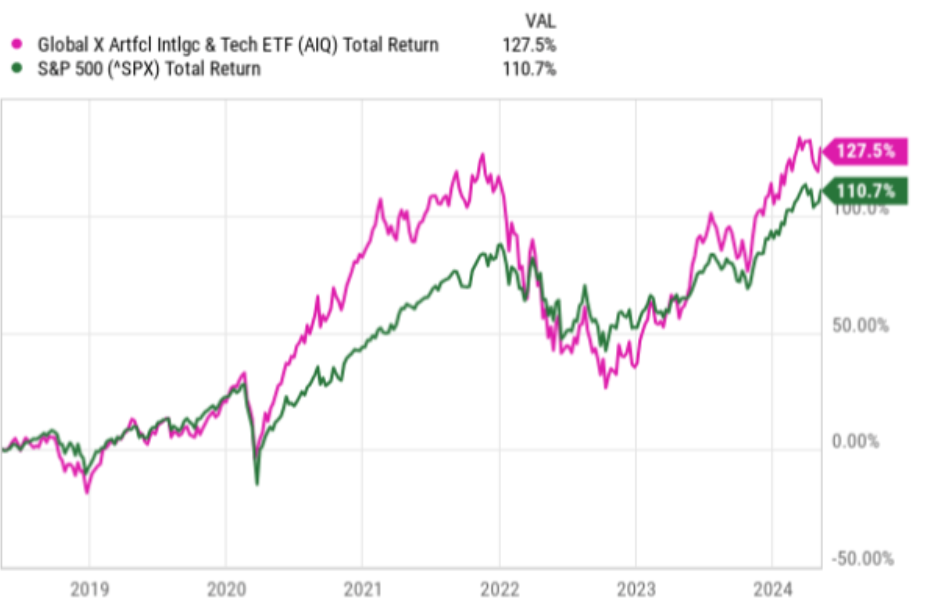

- L’AIQ e i successivi ETF focalizzati sull’intelligenza artificiale si basano su una narrativa e un clamore popolare.

- Questa narrativa ha raggiunto una valutazione ricca che supera di gran lunga la capacità di miglioramento dell’intelligenza artificiale.

VII. Limiti dell’IA generativa

- Più grande non è sempre migliore quando si tratta di set di dati.

- L’aggiunta di sempre più dati di addestramento non sempre produce risultati migliori.

- L’IA generativa sta già mostrando segni di rendimenti decrescenti.

Comprendere la Tecnologia attraverso la Finanza

Le previsioni indicano che il mercato globale dell’IA potrebbe crescere di 300 volte entro il 2032. Tuttavia, l’IA generativa sta già mostrando segni di rendimenti decrescenti.

«Il mondo è pronto ad assistere a un’esplosione di crescita nel settore dell’Ai generativa nei prossimi dieci anni, che promette di cambiare radicalmente il modo in cui il settore tecnologico opera», . «La tecnologia è destinata a diventare una parte sempre più essenziale della spesa It, della spesa pubblicitaria e della cybersicurezza, man mano che si sviluppa».

Bloomberg Singh

Questo articolo esamina il rallentamento e prevede lo sviluppo futuro dell’intelligenza artificiale.

È interessante notare come ci siano “Forze” che spingono i media a parlare continuamente di fenomeni come l’Intelligenza Artificiale (IA), spesso senza che se ne comprenda a pieno il motivo. Questo fenomeno può essere analizzato da diversi punti di vista:

- Interesse Economico: Le aziende tecnologiche hanno enormi interessi economici legati allo sviluppo e alla promozione dell’IA. Investono ingenti somme in pubblicità e marketing per creare un hype attorno ai loro prodotti e servizi basati sull’IA.

- Innovazione e Competizione: L’IA rappresenta una frontiera tecnologica in continua evoluzione, e c’è una competizione globale per dominare questo settore. I media riflettono questa competizione, spesso enfatizzando notizie e avvenimenti legati all’IA per mantenere alta l’attenzione del pubblico.

- Influenza Politica e Sociale: Governi e istituzioni riconoscono l’importanza strategica dell’IA per il futuro delle economie nazionali e per la sicurezza. Questo può portare a una maggiore copertura mediatica su argomenti di IA rispetto ad altri temi meno strategici.

- Interesse Pubblico e Fascinazione: L’IA suscita curiosità e fascinazione nel pubblico generale. La possibilità che le macchine possano pensare, apprendere e agire autonomamente stimola l’immaginazione collettiva, portando i media a dedicare più spazio a questo argomento.

- Negligenza di Altri Temi: Questa attenzione sproporzionata all’IA porta spesso a una negligenza di altri temi importanti, che finiscono per essere completamente ignorati dalla stampa, dalle istituzioni o dalla ricerca. Temi come la povertà, i diritti umani, il cambiamento climatico e molte altre questioni cruciali possono ricevere meno attenzione mediatica e, di conseguenza, meno risorse e interventi.

Riflettere su queste dinamiche ci permette di comprendere meglio come e perché certi temi dominano il discorso pubblico, mentre altri vengono trascurati.

È essenziale mantenere un equilibrio e assicurarsi che i media e le istituzioni non perdano di vista le altre sfide importanti che la società deve affrontare.

Dall’introduzione di ChatGPT nel 2022, l’IA generativa è diventata molto popolare. L’articolo analizza la performance di un ETF e attribuisce il suo successo all’intelligenza artificiale. L’obiettivo è capire se il rendimento superiore rispetto al Nasdaq continuerà e discutere l’hype sull’intelligenza artificiale.

Questi robot IA sono ovunque: Google ha introdotto Gemini e Bard, Microsoft ha lanciato Bing e il ChatGPT di OpenAI è stato integrato con DALL-E, consentendo alla sua quarta versione di generare immagini in pochi secondi.

Questi modelli di intelligenza artificiale, noti come modelli linguistici di grandi dimensioni (“LLM”), hanno catturato l’attenzione di pubblico e investitori.

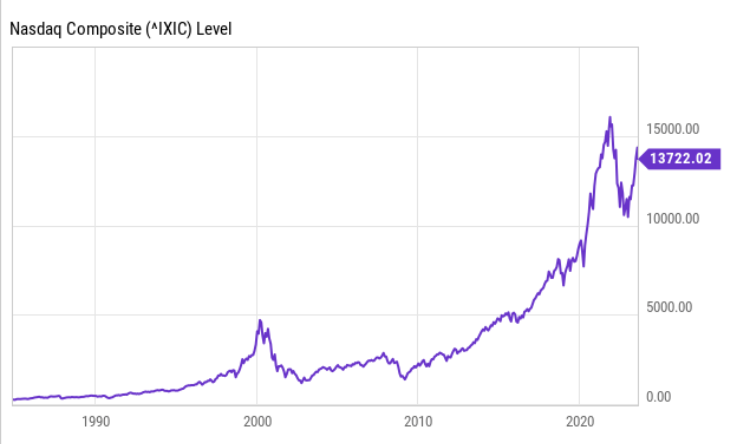

Conosciuta come la bolla delle dot-com del 2000, è stata una fase speculativa nel mercato azionario che ha colpito le azioni tecnologiche nei settori dell’informatica e delle telecomunicazioni a metà degli anni ’90.

Il problema era che giovani aziende di e-commerce come eBay, Netscape, AOL e altre, con modelli di business non collaudati, vedevano le loro capitalizzazioni di mercato crescere a livelli senza precedenti grazie all’entusiasmo degli investitori per le loro azioni.

Questo ha portato il Nasdaq a crescere di cinque volte tra il 1995 e il 2000, da meno di 1.000 a circa 4.800, come mostrato nel grafico seguente. In confronto, dal 2017 al picco del 2022, è cresciuto di circa tre volte, da circa 5.500 a 16.057.

Pertanto, esiste una differenza significativa nella percentuale di guadagni forniti dall’indice ad alto contenuto tecnologico tra i due eventi di mercato.

Nel 2000, per crescere, le società tecnologiche hanno emesso grandi volumi di capitale e contratto debito senza generare profitti significativi.

La bolla è stata favorita da condizioni monetarie allentate e credito a basso costo, soprattutto da parte di venture capitalist, e da un surplus globale di risparmio.

Oggi è diverso: i tassi di interesse sono elevati e le condizioni monetarie sono restrittive, con le banche che esaminano più attentamente i richiedenti credito, soprattutto dopo le turbolenze bancarie di marzo.

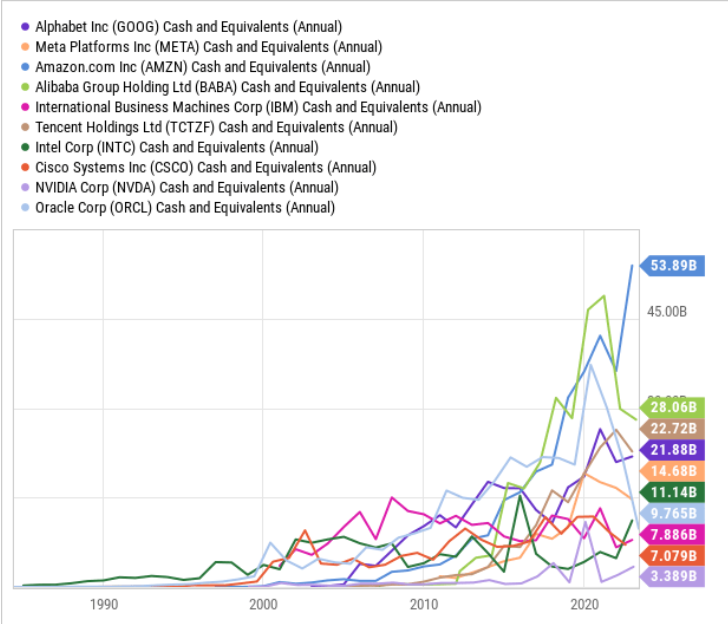

Nonostante una probabile decelerazione degli utili del settore tecnologico quest’anno, la maggior parte delle aziende rimane redditizia con posizioni di liquidità molto migliori rispetto agli anni ’90.

Quindi, a differenza di 23 anni fa, quando gli investitori decidevano in base alle promesse del management e i venture capitalist cercavano di investire liquidità in eccesso, oggi gli investitori sono più sicuri

Valutare l’AIQ tra opportunità e rischi x capire se l’AI e’ una bolla oppure una nuova .com

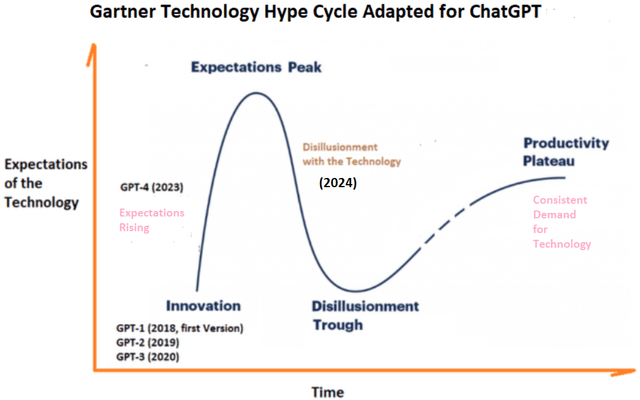

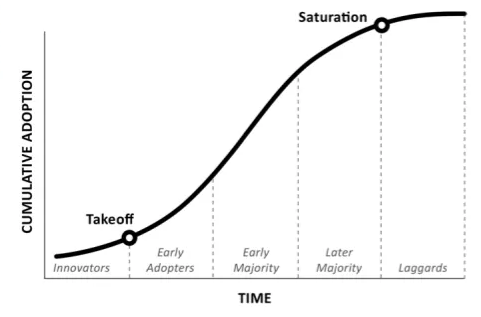

Una caratteristica della bolla tecnologica del 2000 è che si prevedevano guadagni rapidi senza capire che le nuove tecnologie come Internet e l’e-commerce richiedono tempo per diventare comuni.

Sebbene queste innovazioni abbiano rivoluzionato le attività, il processo ha richiesto tempo per passare dalla fase di sviluppo alla produttività.

Lo stesso vale oggi per l’intelligenza artificiale generativa, con ChatGPT sviluppato nel 2018 da OpenAI. Siamo ora alla quarta versione (GPT-4), che ha visto un aumento fenomenale degli utenti mensili attivi, come illustrato nel Gartner Technology Hype Cycle.

Affascinato dalla facilità d’uso di ChatGPT, che permette di generare report rapidamente con linguaggio naturale anziché complessi codici informatici, molti hanno adottato questa tecnologia.

Ciò ha aumentato la domanda di servizi AI, permettendo a Microsoft e altri fornitori di cloud pubblico di vendere più AI-as-a-Service.

Per supportare queste infrastrutture, i fornitori devono procurarsi più chip GPU Nvidia, contribuendo alla crescita del settore dei semiconduttori, con ricavi superiori del 50% rispetto alle previsioni degli analisti.

Tuttavia, dopo un periodo di entusiasmo, potrebbe seguire una disillusione, portando a una diminuzione della domanda e a volatilità nei titoli tecnologici.

Questo entusiasmo si è tradotto in guadagni di borsa e in fondi come il Global X Artificial Intelligence & Technology ETF (NASDAQ: AIQ), che ha sovraperformato l’S&P 500 sin dal suo lancio.

Il processo di selezione per il fondo si basa sulla capacità di ciascuno di sfruttare l’intelligenza artificiale nei propri prodotti. Global X prevede che il mercato crescerà da 30 miliardi di dollari nel 2020 a 300 miliardi di dollari entro il 2026.

Il fondo non distribuisce un dividendo rilevante, una pratica comune tra le aziende di questo settore che devono massimizzare la liquidità disponibile per finanziare costose attività di sviluppo nell’intelligenza artificiale.

Il fondo è molto volatile, così come l’intero settore tecnologico, ma AIQ si distingue per la sua elevata volatilità, poiché si concentra su una tecnologia emergente.

Contrariamente al 2000, questa volta il settore tecnologico si sta dimostrando più agile nella capacità di utilizzare l’intelligenza artificiale non solo per fornire servizi a valore aggiunto, ma anche nell’utilizzo della tecnologia per ottimizzare le operazioni e ridurre i costi.

Ciò è dimostrato dagli oltre 150.000 tagli di posti di lavoro annunciati da aziende tecnologiche tra cui Meta Platforms Google , Amazon e le altre partecipazioni di AIQ secondo un elenco compilato da Tech Crunch . Questi tagli dovrebbero comportare una migliore redditività, fino al 24% secondo i numeri di miglioramento della produttività del lavoro.

Gli investimenti nell’intelligenza artificiale richiedono ingenti risorse finanziarie, spesso dell’ordine di decine o centinaia di milioni di dollari, prima di produrre risultati concreti.

Questo implica che le aziende piu’ piccole stanno puntando tutto sul loro prodotto, e un fallimento potrebbe portare a massicce vendite delle loro azioni.

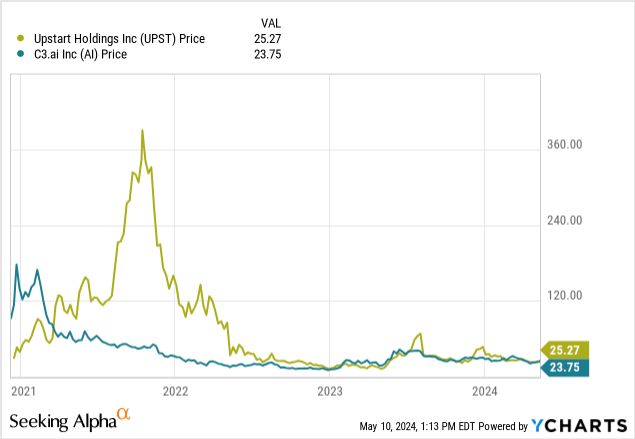

Dati di YCharts

Global X (per suoi personali interessi) sostiene che questi guadagni possono rimanere esponenziali:

Spinto dalle scoperte nel campo dell’intelligenza artificiale generativa, le previsioni suggeriscono che il mercato globale dell’intelligenza artificiale potrebbe aumentare di oltre 300 volte, passando da 39 miliardi di dollari nel 2022 a 1,3 trilioni di dollari entro il 2032.

…

L’intelligenza artificiale si sta rapidamente espandendo oltre i data center, consentendo applicazioni commerciali innovative in diversi settori, tra cui l’agricoltura, l’assistenza sanitaria e altro ancora. Le previsioni indicano che oltre 729 milioni di individui utilizzeranno strumenti di intelligenza artificiale entro il 2030, in aumento di 254 milioni rispetto al 2023.

In questo articolo metterò in discussione la narrativa secondo cui l’intelligenza artificiale può continuare a giustificare questi guadagni.

L’AIQ e i successivi ETF focalizzati sull’intelligenza artificiale si basano su una narrativa e un clamore popolare. Ha raggiunto una valutazione ricca che supera di gran lunga la capacità di miglioramento dell’intelligenza artificiale.

Come funzionano gli LLM

Per iniziare questa sezione, dobbiamo spiegare rapidamente come vengono addestrati i modelli linguistici di grandi dimensioni. Questi modelli vengono alimentati con montagne di dati, nel caso di GPT 4, 570 GB di dati di testo (il che è assolutamente enorme per coloro che non hanno familiarità con l’archiviazione dei dati). Questo processo è costato a OpenAI almeno 100 milioni di dollari.

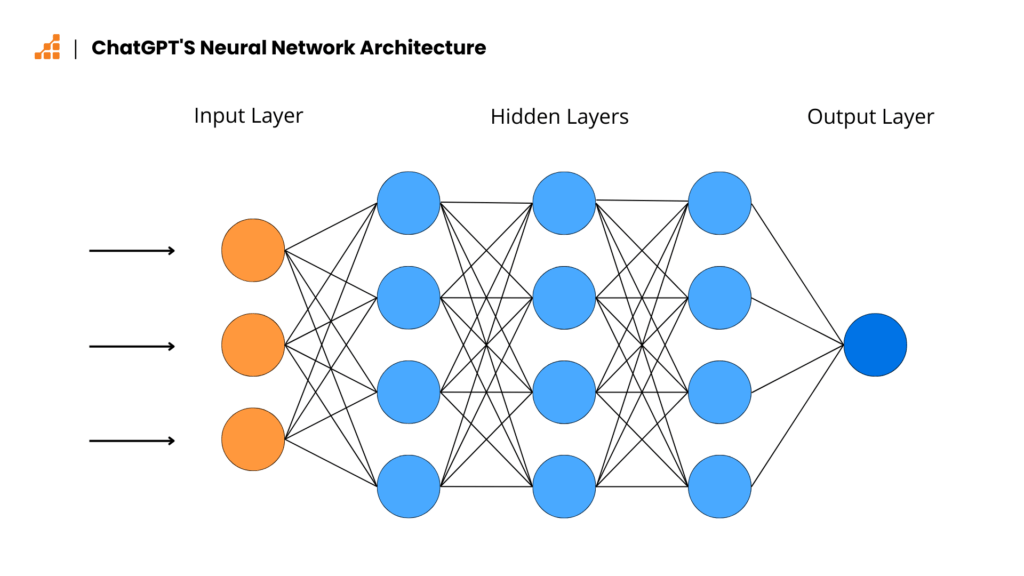

Gli algoritmi di apprendimento automatico creano una rete neurale, che assomiglia a una versione molto più grande di questa:

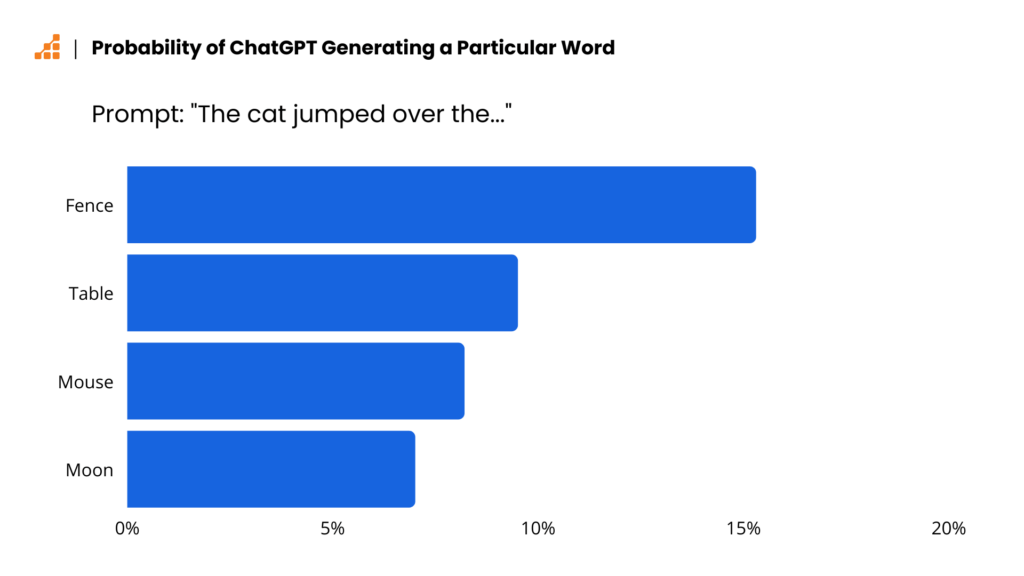

Ciascuno di questi punti dati è un pezzo di vocabolario che ChatGPT (o inserisce qualsiasi LLM concorrente) comprende. Questi sono tutti numeri assegnati, che possono essere elaborati dagli algoritmi. Quando viene chiesto di completare le frasi, che è la funzione principale di un LLM, il bot deve “indovinare” quale parola con maggiore probabilità seguirà quelle precedenti.

Questa è una spiegazione molto semplificata e salta gran parte del dietro le quinte tecnico di come vengono costruiti gli LLM. Non entrerò troppo in profondità in queste erbacce perché non è rilevante per la mia tesi, ma se vuoi un approfondimento, suggerisco di leggere questa analisi dell’ingegnere di machine learning Calin Cretu .

Più grande non è meglio

Il primo problema che abbiamo, e il primo motivo per cui credo che l’intelligenza artificiale generativa si sia stabilizzata nella sua forma attuale, è che più grande non è sempre migliore quando si tratta di set di dati.

Sam Altman, CEO di OpenAI, ha parlato l’anno scorso al MIT dell’intelligenza artificiale e ha detto:

Penso che siamo alla fine dell’era in cui ci saranno questi modelli giganti, giganteschi… Li miglioreremo in altri modi.

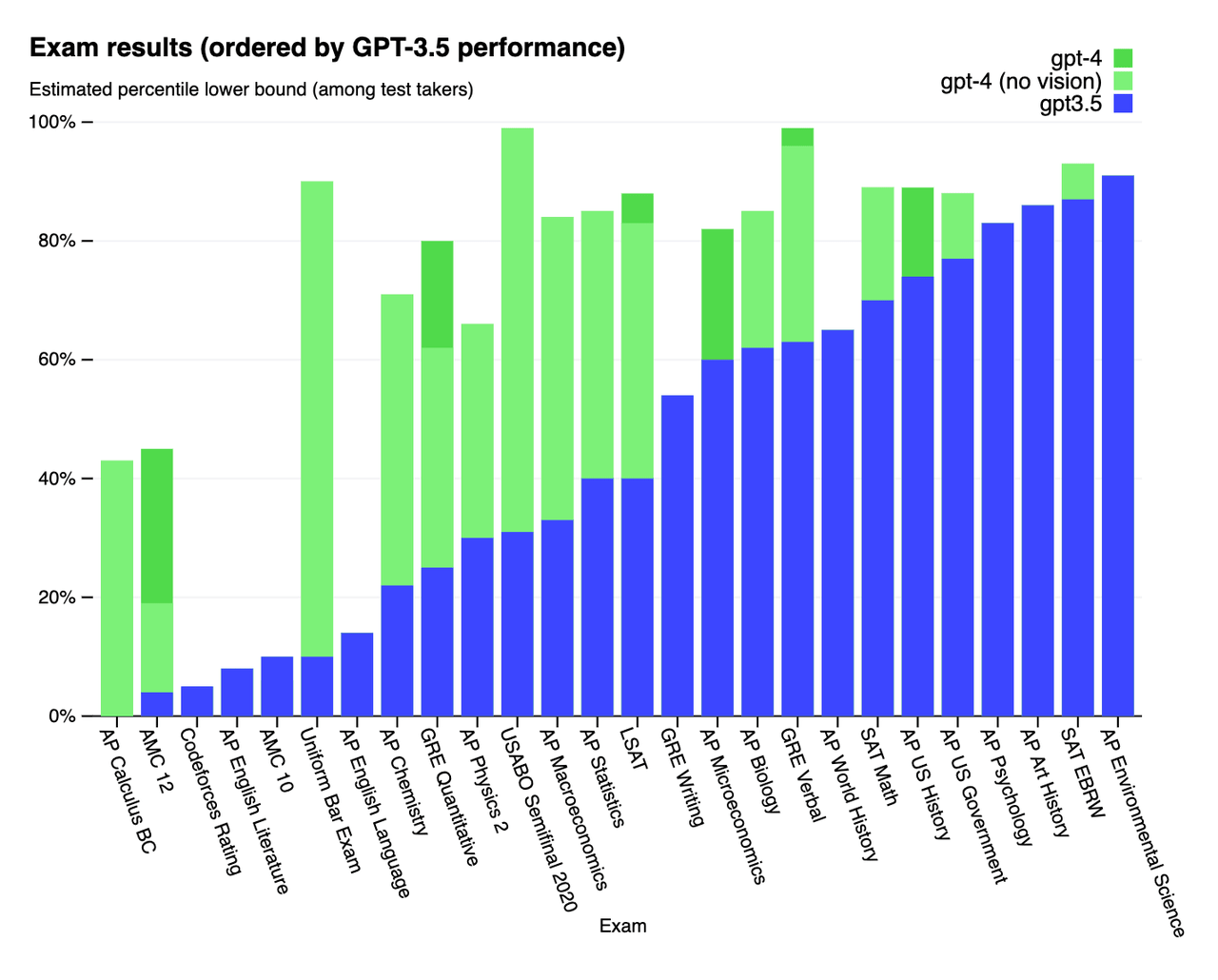

L’aggiunta di sempre più dati di addestramento è stato il modo in cui ChatGPT è passato da 3,5 a 4, che ha sovraperformato nella maggior parte delle attività, ma non in tutte.

Quindi stiamo già iniziando a vedere rendimenti decrescenti, soprattutto in alcune aree in cui sia GPT 3.5 che 4 hanno sottoperformato l’essere umano medio, come negli esami AP di letteratura e lingua inglese. Questi sono gli esami dati agli studenti delle scuole superiori.

L’idea generale è che l’intelligenza artificiale sia limitata alla quantità di dati che possiamo fornire loro e alla potenza di calcolo di cui dispongono, ma questo non è corretto. L’aggiunta di sempre più dati non sempre produce risultati migliori.

Una delle cause principali dei problemi di eccessiva correzione di Gemini , in cui il modello ha avuto difficoltà incredibili a produrre immagini corrette per i prompt (il che è davvero eccessivamente semplificato, vedere l’articolo per maggiori dettagli), era che i suoi dati di addestramento erano troppo grandi. Più grande è il set di dati, più allucinazioni produrrebbe.

Tuttavia, fornire più dati a questi modelli è il modo più conveniente per produrre risultati migliori, come mostrato nella Figura 3 (Brian Chau)dove GPT 4 è stato in grado di migliorare drasticamente alcuni risultati come nell’Uniform Bar Exam.

Questo problema è compreso internamente da OpenAI, che ha già respinto le speranze che GPT-5 si realizzi presto.

Rendimenti decrescenti

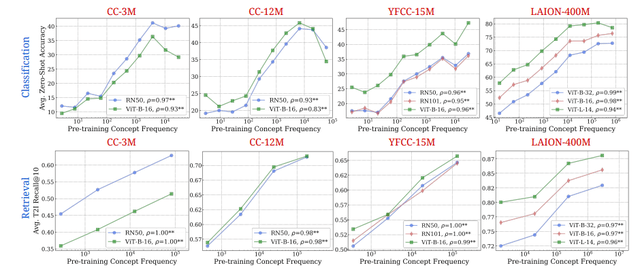

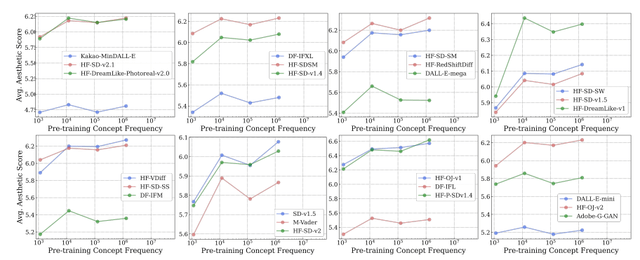

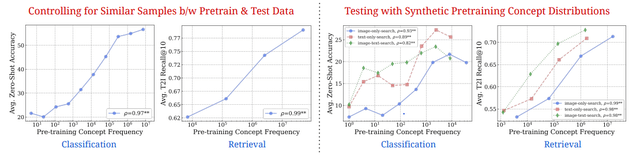

Questi modelli offrono sempre meno in cambio dei soldi che hanno investito, in genere. In un articolo recentemente pubblicato da scienziati informatici dell’Università di Tubinga, Cambridge e Oxford, trentaquattro LLM sono stati ispezionati per vedere come set di dati sempre più grandi influenzano la traiettoria delle prestazioni.

Ecco due dei test, insieme al commento del team (tra virgolette) tratto dallo studio.

[I dati sopra mostrano] relazioni log-lineari tra la frequenza del concetto e le prestazioni zero-shot CLIP. In tutte le architetture testate… e nei set di dati di pre-addestramento… osserviamo una relazione lineare coerente tra le prestazioni zero-shot di CLIP su un concetto e la frequenza di pre-addestramento del concetto su scala logaritmica. Questa tendenza vale sia per la classificazione zero-shot… sia per il recupero di immagini e testi.

[I dati sopra mostrano] relazioni log-lineari tra la frequenza del concetto e i punteggi estetici T2I. In tutti i modelli T2I testati e preaddestrati sul set di dati LAION-Aesthetics, osserviamo una relazione lineare coerente tra le prestazioni zero-shot su un concetto e la frequenza di pretraining del concetto su scala logaritmica.

Tra le figure 4 e 5 apprendiamo qualcosa di molto interessante: esiste una relazione log-lineare tra i dati di pre-addestramento e i risultati dell’intelligenza artificiale. Anche quando i set di dati sono controllati per dare all’intelligenza artificiale le migliori possibilità di uscire dal percorso prestazionale log-lineare, mostrano comunque gli stessi schemi.

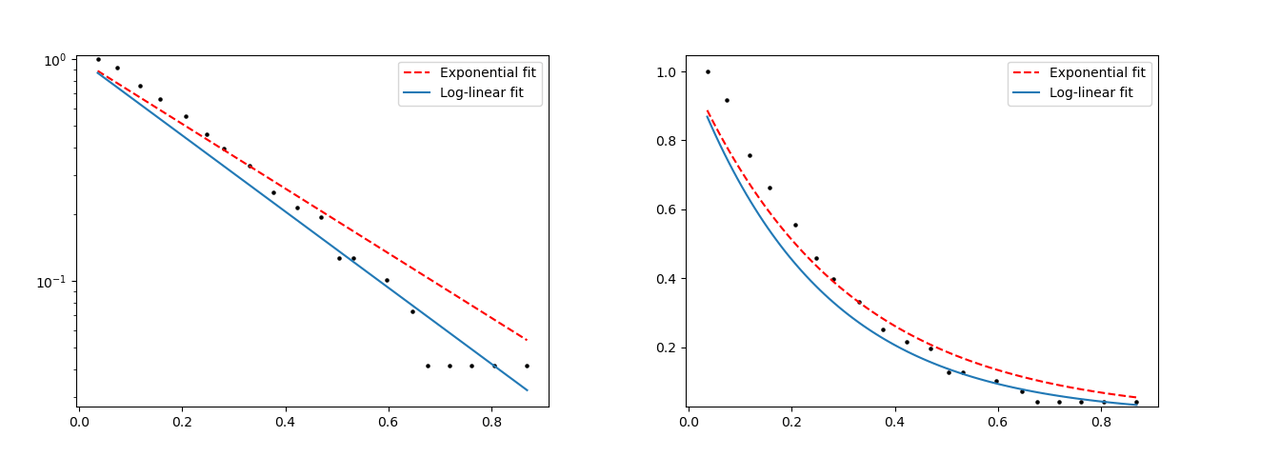

Log-lineare, non esponenziale

Questa progressione log-lineare nei modelli di intelligenza artificiale significa che sono necessarie quantità esponenziali di dati per produrre risultati logaritmici. C’è un’incredibile quantità di rendimenti decrescenti che si verificano quando si forniscono più dati ai modelli di intelligenza artificiale.

La soluzione semplice su cui puntavano molte aziende e startup di intelligenza artificiale, più soldi significa più potenza di elaborazione, il che significa una migliore intelligenza artificiale, si sta rivelando falsa. Vedremo molto presto i modelli di intelligenza artificiale raggiungere un plateau, se non l’abbiamo già fatto.

La differenza è simile a questa, per riferimento.

Quando le aspettative non vengono soddisfatte, le azioni crollano.

Mentre l’intelligenza artificiale continua a stabilizzarsi nei suoi progressi, vedremo queste aziende rimanere indietro dal mercato.

Possiamo vederlo in altri nomi di intelligenza artificiale che hanno attirato molta attenzione all’inizio e poi sono rimasti delusi quando la loro performance si è rivelata lineare e non esponenziale come previsto, come C3.ai e Upstart Holdings, Inc.

Curve sigmoidali e tecnologia

Everett Rogers, nel suo libro Diffusion of Innovations , sostiene che le tecnologie innovative seguono una curva sigmoide, cioè una curva che forma una “S”. Ciò è dovuto al modo in cui le tecnologie si espandono rapidamente, si evolvono più velocemente di quanto la maggior parte delle persone possa tenere il passo e poi si scontrano con un muro e un plateau.

L’intelligenza artificiale ha raggiunto un punto di saturazione con il suo lancio pubblico. Sebbene ChatGPT, Gemini e altri possano sembrare ancora grezzi e inclini alle allucinazioni, non verranno presto superati da questi robot.

Attualmente, sono fondamentali per l’utilizzo degli LLM, e eliminarli gradualmente è troppo complesso con il nostro attuale paradigma tecnologico.

Fino a quando questo paradigma non cambierà e non emergerà una nuova tecnologia capace di rivoluzionare il funzionamento degli LLM, non dovremmo aspettarci significativi sviluppi.

Ciò implica che le aziende dell’AIQ che investono risorse su questi modelli difficilmente vedranno TUTTI ricompense adeguate, portando a una probabile sottoperformance futura per alcuni.

LeCun, capo scienziato dell’AI del colosso dei social media proprietario di Facebook e Instagram, ha affermato che i LLM hanno “una comprensione della logica molto limitata… non comprendono il mondo fisico, non hanno memoria persistente, non possono ragionare in alcuna definizione ragionevole del termine e non possono pianificare… gerarchicamente”.

In un’intervista al Financial Times, LeCun ha argomentato contro l’idea di fare affidamento sui LLM in avanzamento nella ricerca per realizzare un’intelligenza a livello umano. Questi modelli possono rispondere correttamente solo se sono stati alimentati con i giusti dati di addestramento e sono quindi “intrinsecamente insicuri”. Invece, sta lavorando per sviluppare una nuova generazione completamente nuova di sistemi AI che spera possano dotare le macchine di un’intelligenza a livello umano.

Tuttavia, LeCun pensa che questa visione potrebbe richiedere 10 anni per essere realizzata. Meta ha investito miliardi di dollari nello sviluppo dei propri LLM, poiché l’AI generativa è esplosa, con l’obiettivo di raggiungere gruppi tecnologici rivali, tra cui OpenAI supportata da Microsoft e Google di Alphabet.

Ritornando ai Titoli e’ utile ricordare che : Un indicatore Alfa positivo segnala che il titolo è in grado di crescere più del suo mercato di riferimento, mentre un valore negativo indica la possibilità di subire perdite indipendentemente dall’andamento generale del mercato.

Contrappunti

Ci sono diversi fattori da valutare che potrebbero aumentare il valore dell’intelligenza artificiale nel breve termine, anche se sono convinto che non vedremo ulteriori progressi significativi con gli LLM nelle loro forme attuali.

Gli LLM stanno rimpiazzando i ruoli nel servizio clienti, riducendo i costi operativi delle aziende.

Questi modelli non devono essere impeccabili per sostituire una vasta gamma di personale, e gli attuali LLM sono già vicini a essere “sufficientemente adeguati” per posizioni generali nel servizio clienti, come i chatbot. Questo cambiamento potrebbe incrementare la redditività di molte aziende, dato che il personale umano rappresenta una delle loro spese più significative.

La rimozione delle allucinazioni dai modelli potrebbe rivoluzionare il loro impiego in campo medico, come dimostrano i test in corso presso HCA Healthcare.

Attualmente, l’intelligenza artificiale è utilizzata principalmente per compiti amministrativi negli ospedali, ma una sua adozione più ampia potrebbe ridurre significativamente il tempo dedicato dai professionisti alle pratiche burocratiche. Questo comporterebbe anche un notevole risparmio economico per aziende come HCA.

L’intelligenza artificiale ha la capacità di svolgere compiti che non desideriamo affidare alle persone, come ad esempio la revisione legale che richiede la lettura di migliaia di e-mail. Questo permetterebbe di impiegare le risorse umane in modo molto più efficiente all’interno delle aziende.

Gli attuali modelli di linguaggio di grandi dimensioni (LLM) sono in grado di effettuare queste operazioni, anche se è necessaria una supervisione per evitare errori.

Nonostante i suoi difetti, l’intelligenza artificiale non si affatica leggendo migliaia di e-mail, non salterà righe di testo a causa della velocità di lettura, né incorrerà in altri problemi che i lavoratori umani potrebbero affrontare in attività così ripetitive.

Conclusione

Gli ETF sull’intelligenza artificiale, come l’ETF Global X Artificial Intelligence & Technology, non sono necessariamente speculativi. Tuttavia, possono avere un alto grado di speculazione dipendendo dalle strategie di investimento e dalle scelte dei gestori del fondo.

Gli ETF sull’intelligenza artificiale sono fondi negoziati in borsa che investono principalmente in società coinvolte nel sviluppo e nell’utilizzo di tecnologie di intelligenza artificiale.

Questi ETF offrono agli investitori un modo efficiente per ottenere esposizione al settore dell’intelligenza artificiale, che comprende tutto, dagli sviluppatori di software e produttori di hardware alle aziende che utilizzano l’intelligenza artificiale per la sanità, la finanza e i veicoli autonomi.

I tipi di ETF sull’intelligenza artificiale includono ETF tematici, ampi, globali, attivi e passivi.

Ciascuno di questi tipi offre diversi approcci di investimento, come ad esempio l’investimento in sottosettori specifici dell’intelligenza artificiale come la robotica, l’apprendimento automatico o l’elaborazione del linguaggio naturale.

Gli ETF sull’intelligenza artificiale possono essere considerati speculativi se investono in aziende che hanno un alto grado di volatilità o se utilizzano strategie di investimento aggressive, come ad esempio l’utilizzo di derivati o di strategie di trading attivo, gli investitori stanno acquistando questi fondi in base alle aspettative future di crescita e innovazione dell’IA, piuttosto che sulla loro valutazione attuale in termini di efficacia operativa e costo.

Tuttavia, possono anche essere considerati come un modo per diversificare i portafogli e ottenere esposizione a un settore in crescita, come l’intelligenza artificiale, senza il rischio di investire direttamente in singole azioni.

In generale, gli ETF sull’intelligenza artificiale possono essere considerati come un investimento a medio-alto rischio, che può offrire rendimenti più alti rispetto a quelli dei tradizionali ETF su mercati più stabili.

Tuttavia, è importante considerare i costi di gestione, la volatilità e la performance storica del fondo prima di investire in un ETF sull’intelligenza artificiale.

Grazie per aver letto.

In qualità di analista di ricerca di Rivista.AI focalizzato sulla tecnologia, il mio obiettivo è fornire approfondimenti differenziati, per scopi solo informativi. A questo scopo, non sono un classico ricercatore azionario o gestore di fondi, ma provengo dal mondo IT . Pertanto, la mia ricerca è spesso supportata da analisi e faccio uso frequente di grafici per supportare la mia posizione. Non investo in questo mercato tumultuoso o altri. Secondo la mia storia professionale ho una vasta esperienza, inizialmente come implementatore di virtualizzazione e cloud, e successivamente sono stato un Director e responsabile di progetti di innovazione AI e Cyber Security. Mi piace scrivere su temi di intelligenza artificiale generativa e spesso sono contrarian.

Dina

Fabrizio Degni

Un ottimo articolo, con tanti spunti di riflessione che sarebbe opportuno qualcuno iniziasse a porsi.

Grazie!