Nel panorama dell’intelligenza artificiale, OpenAI e altre aziende del settore stanno affrontando nuove sfide e incertezze mentre cercano di superare le aspettative di crescita dei modelli di linguaggio di grandi dimensioni. Nonostante l’enorme successo dei chatbot come ChatGPT, gli esperti del settore si stanno rendendo conto che le tecniche tradizionali di scalabilità, che si basano sull’aumento della potenza computazionale e dei dati, potrebbero non essere più sufficienti per raggiungere i traguardi desiderati. La ricerca si sta ora orientando verso approcci che riflettono il “pensiero” umano, in grado di pensare, ragionare e prendere decisioni in modo simile a come farebbe una persona.

La beata Quartina:

L’Evoluzione della Scienza AI: Dall’Esplosione della Scalabilità alla Scoperta di Nuove Tecniche

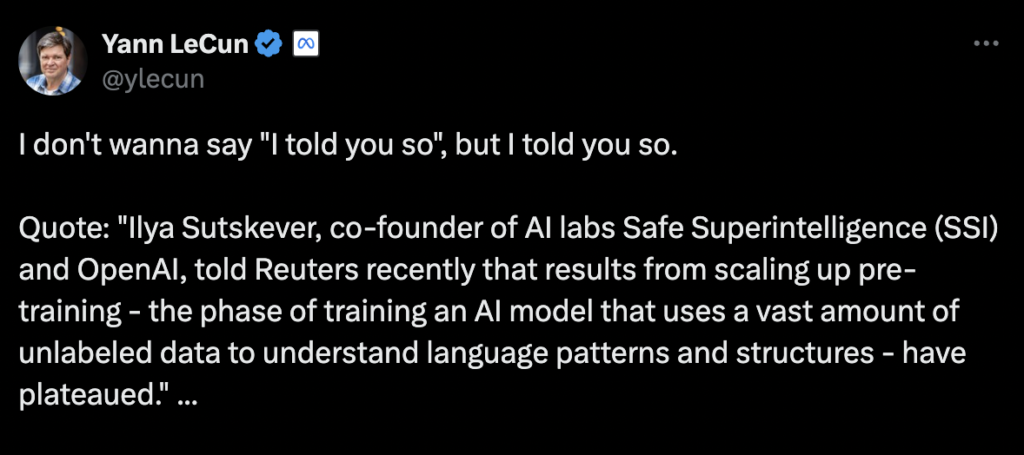

Ilya Sutskever, co-fondatore di OpenAI, ha recentemente dichiarato che la semplice espansione dei modelli AI, attraverso l’aumento dei dati e della potenza di calcolo, ha raggiunto un punto di stagnazione. Secondo Sutskever, l’era della “scalabilità” che ha dominato gli anni 2010 è finita, e ora siamo tornati a un’epoca di “meraviglia e scoperta”, dove l’obiettivo non è più solo aumentare la grandezza dei modelli, ma sviluppare tecniche che possano migliorare la qualità e la funzionalità degli stessi. Questo cambiamento di paradigma è evidente nei progressi compiuti dal modello “o1” di OpenAI, il quale utilizza un approccio che riflette il ragionamento umano e l’elaborazione di informazioni in modo più complesso e strutturato.

Le Nuove Tecniche di Allenamento: Pensare come un Essere Umano

Il modello o1, recentemente rilasciato da OpenAI, è stato progettato per risolvere i problemi in modo simile a come lo farebbe una persona, affrontando compiti complessi come calcoli matematici, programmazione o decisioni che richiedono un ragionamento più articolato. Una delle innovazioni principali dietro questo modello è l’uso del cosiddetto “test-time compute”, una tecnica che ottimizza l’efficienza del modello durante la fase di inferenza (quando il modello è in uso) anziché durante la fase di pre-allenamento, come avveniva nei modelli precedenti. In questo approccio, i modelli non si limitano a selezionare immediatamente una risposta, ma generano e valutano diverse possibilità in tempo reale per scegliere quella più appropriata.

Noam Brown, ricercatore di OpenAI, ha sottolineato l’efficacia di questo approccio, citando un esperimento in cui il miglioramento delle prestazioni di un bot in una mano di poker, pensando per 20 secondi, ha avuto un impatto simile a quello di aumentare il modello di 100.000 volte e allenarlo per 100.000 volte più a lungo. Questo dimostra come l’adozione di una logica di pensiero più umana possa rendere i modelli molto più efficienti e reattivi rispetto alla semplice crescita dei dati e della potenza di calcolo.

La Competizione e l’Evoluzione della Hardware AI

Con l’avanzare di questi nuovi approcci, la domanda di hardware specifico per AI potrebbe cambiare radicalmente. Mentre i chip di Nvidia hanno dominato finora il mercato della formazione dei modelli grazie alla loro capacità di gestire carichi di lavoro massicci, il nuovo orientamento verso l’ottimizzazione dell’inferenza potrebbe portare alla nascita di nuove sfide per le aziende tecnologiche. L’inferenza cloud, un’alternativa distribuita basata su server cloud per l’elaborazione dei modelli, potrebbe ridurre la necessità di giganteschi cluster di pre-allenamento, aprendo la strada a una concorrenza più intensa per Nvidia, specialmente nella fase di inferenza.

Kevin Weil, chief product officer di OpenAI, ha già dichiarato che l’azienda si sta preparando per un futuro in cui, con l’adozione di queste nuove tecniche, sarà sempre più difficile per i concorrenti mantenere il passo con OpenAI. Il passaggio dalle enormi operazioni di pre-allenamento a sistemi distribuiti di inferenza potrebbe cambiare completamente le dinamiche del mercato AI, modificando le priorità degli investitori e delle aziende che finora hanno puntato su Nvidia per il loro hardware di intelligenza artificiale.

Un Nuovo Capitolo nella Crescita delle AI

L’ascesa del modello o1 segna un punto di svolta significativo per l’intero settore dell’intelligenza artificiale. La capacità di “pensare” in modo più simile agli esseri umani potrebbe non solo migliorare le prestazioni dei modelli AI, ma anche avere un impatto sostanziale sull’industria tecnologica nel suo complesso, modificando la natura delle risorse richieste per costruire e ottimizzare tali modelli. In questo nuovo scenario, le aziende che riescono a sviluppare metodi più sofisticati di allenamento e inferenza potrebbero dominare la competizione, portando a una rinnovata corsa tecnologica con implicazioni globali per la gestione dell’energia, il design dei chip e l’economia dei dati.