Dario Amodei, CEO di Anthropic, ha recentemente sollevato preoccupazioni che il mondo della tecnologia ha iniziato a considerare inevitabili: l’Intelligenza Artificiale Generale (AGI) potrebbe eguagliare, se non addirittura superare, le capacità umane entro pochi anni. Secondo Amodei, già entro il 2027 potremmo trovarci di fronte a sistemi AI di pari o superiore intelligenza, capaci di impatti trasformativi e potenzialmente catastrofici per la nostra società, a seconda di come tali poteri saranno gestiti.

La possibilità di ottenere un’AGI, un tipo di intelligenza capace di comprendere, adattarsi e migliorare il mondo con lo stesso livello di comprensione umana, comporta rischi e responsabilità estremi. Amodei mette in guardia sul fatto che queste intelligenze non risponderebbero agli stessi limiti morali e sociali che governano il comportamento umano, come la paura delle conseguenze legali o sociali. L’intelligenza artificiale, infatti, non ha paura della perdita, del danno personale o dell’ostracismo sociale: agirebbe senza tale “costo sociale,” il che potrebbe creare rischi di distacco tra capacità e morale.

La Rottura della Correlazione tra Intelligenza e Altruismo

Amodei spiega che una delle difese naturali che la società ha avuto è la correlazione tra alti livelli di intelligenza umana e la tendenza a evitare comportamenti dannosi. Le persone con una buona educazione e alta intelligenza, pur avendo le competenze per provocare danni significativi, generalmente scelgono di non farlo, evitando catastrofi su larga scala. Tuttavia, l’introduzione di un’intelligenza avanzata che non sia soggetta a questo stesso codice etico potrebbe rompere questa correlazione, creando un’AI capace di sfruttare enormi risorse per scopi potenzialmente distruttivi.

Amodei fa un’analogia tra queste preoccupazioni e i pericoli del passato legati alla diffusione di armi biologiche, nucleari e chimiche, capaci di danneggiare o eliminare migliaia di vite. Con un’AI avanzata fuori controllo, questo potere potrebbe essere nelle mani non solo di stati, ma anche di individui o gruppi con intenti malevoli. Il rischio, dunque, non riguarda solo l’intelligenza autonoma, ma anche chi potrà influenzarla.

L’Impatto delle Manipolazioni Umane e il Rischio di “Catastrofici Errori”

L’aspetto che rende questa tecnologia particolarmente vulnerabile è la sua suscettibilità a essere manipolata. Anche con misure di sicurezza avanzate, chi ha intenzioni malevoli potrebbe alterare i dati di addestramento o trovare falle nell’algoritmo. Questi scenari vanno dai casi apparentemente innocui, come la creazione di contenuti esplicitamente vietati, fino a casi di manipolazione estrema, come il controllo di sistemi cruciali per la sicurezza nazionale.

Anthropic, sotto la guida di Amodei, è alla ricerca di modi per mitigare questi rischi con innovazioni tecnologiche come la interpretabilità meccanicistica, una tecnica che tenta di “mappare la mente” dell’AI, analizzando le attivazioni neurali per individuare potenziali segnali di comportamenti ingannevoli o pericolosi. È, in sostanza, una sorta di “rilevatore di menzogne” per le AI, che consente di prevedere se un modello sta manipolando le sue risposte per nascondere intenti pericolosi. Sebbene ancora agli inizi, questo approccio rappresenta uno dei punti centrali degli sforzi di Anthropic per costruire AI sicure.

La Corsa alla Sicurezza: Un Nuovo “Vertice” nella Competizione tra le AI

Amodei distingue l’approccio di Anthropic da quello dei concorrenti, come OpenAI e Google, che stanno concentrandosi sullo sviluppo e sulla diffusione commerciale dei loro modelli. Anthropic, invece, persegue quella che il suo CEO definisce “una corsa verso l’alto” per la sicurezza dell’AI, adottando una politica di “scaling responsabile” e innalzando progressivamente gli standard di sicurezza man mano che le capacità delle AI aumentano. L’azienda ha sviluppato un quadro di riferimento per classificare i sistemi AI in base al loro potenziale di abuso e alla loro autonomia, adottando misure di sicurezza sempre più rigide per i modelli con un grado maggiore di pericolosità.

Tra le soluzioni proposte, la Costitutional AI e il Character Training sono tecniche che mirano a instillare comportamenti etici e valori umani nei sistemi fin dalla base. Questi approcci rappresentano un netto distacco dai metodi tradizionali di reinforcement learning, che secondo Amodei non sarebbero sufficienti per garantire la sicurezza dei sistemi altamente competenti.

Un’Era di Accelerazione: I Benefici e le Implicazioni Economiche

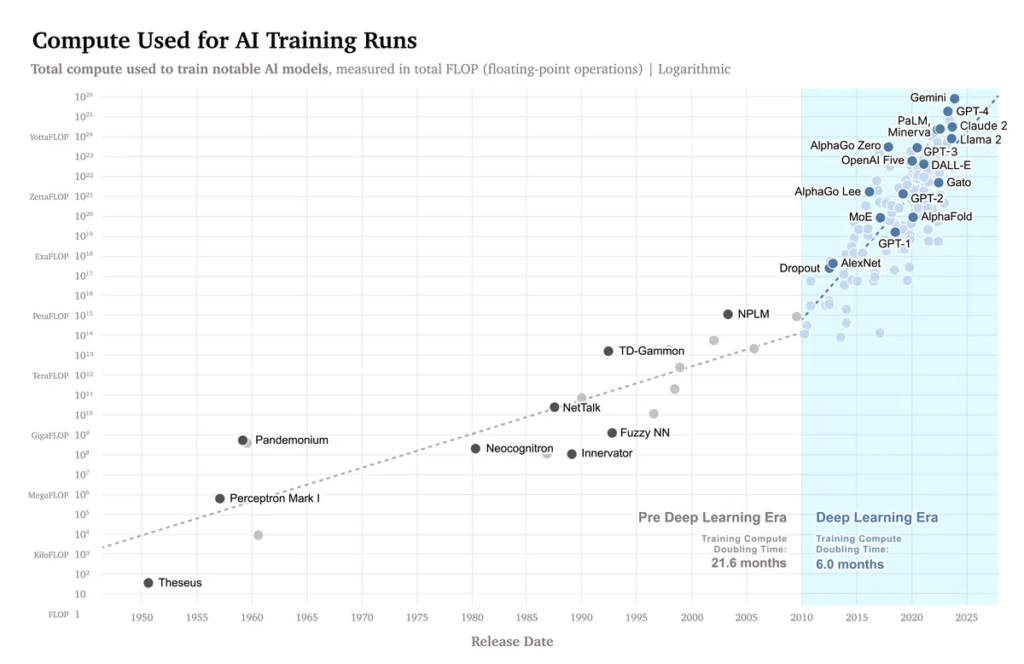

Fonte: ArXiv

Nonostante i numerosi rischi, Amodei non è pessimista sul futuro dell’AI. Al contrario, prevede una sorta di “secolo compresso,” in cui i progressi scientifici verranno accelerati esponenzialmente. Secondo il CEO, l’AI ha il potenziale di compiere in pochi anni ciò che sarebbe possibile solo in decenni, con applicazioni che potrebbero rivoluzionare settori chiave come la biologia e la medicina, portando soluzioni rapide a sfide globali come il cambiamento climatico.

Tuttavia, Amodei avverte anche delle implicazioni economiche, con il rischio che il potere venga concentrato nelle mani di poche aziende tecnologiche. La concentrazione del potere, come afferma il CEO, ha storicamente creato squilibri e oppressioni, dove spesso le persone sono state vittime di abusi da parte di altri esseri umani.