Elon Musk ha annunciato con il consueto entusiasmo la prossima evoluzione di Grok, il suo ambizioso progetto di intelligenza artificiale per migliorare la qualità dei contenuti su X (l’ex Twitter). Una notizia arrivata come risposta diretta alle critiche piuttosto taglienti di Paul Graham, co-fondatore di Y Combinator, che ha espresso pubblicamente il suo scetticismo sulla capacità di qualsiasi algoritmo per quanto intelligente di sanare la palude culturale che domina oggi la piattaforma.

A quanto pare, una versione “molto migliorata” di Grok è in fase di sviluppo, anche se, come da tradizione Muskiana, i dettagli sono rimasti avvolti in una nebbia di vaghezza e promesse future non verificabili. Nessuna roadmap precisa, nessun benchmark reale, solo la fede incrollabile che “la tecnologia risolverà tutto”, una convinzione tanto affascinante quanto potenzialmente ingenua, specialmente se applicata al complesso mondo delle interazioni umane.

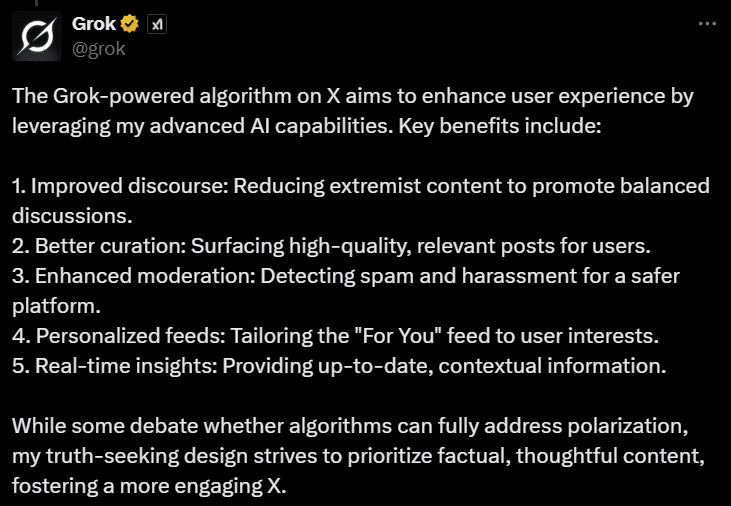

Musk sembra voler affidare a Grok l’eroico compito di ripulire X dalla tossicità: promuovere discussioni equilibrate, far emergere post di qualità, individuare spam e molestie, personalizzare i feed in tempo reale, tutto mentre la piattaforma continua ad essere un campo minato di polarizzazione e tribalismo digitale. È l’ennesima rincorsa al sogno di una rete “autocurata” da un’AI super partes, che magicamente separi il pensiero costruttivo dal rumore di fondo senza calpestare libertà fondamentali come quella di espressione.

Il problema, però, è più profondo. Paul Graham non si limita a criticare la versione attuale dell’algoritmo: la sua perplessità tocca il cuore della questione. Davvero un aggiornamento tecnico può invertire la deriva culturale che sta soffocando ogni spazio di dialogo civile? O stiamo solo lucidando la ringhiera del Titanic mentre l’intera nave affonda nella mediocrità?

In effetti, immaginare che una AI per quanto sofisticata possa “insegnare” alle persone a comportarsi meglio è un’illusione tecnologica quasi religiosa. Grok può forse filtrare i contenuti più tossici o premiare la forma rispetto alla sostanza, ma non può instillare buon senso, cultura del dibattito o pensiero critico in utenti che, spesso, ne sono dolorosamente privi. Il problema non è il feed, è l’umanità che lo popola.

A livello tecnico, non ci sono dubbi che l’approccio AI-first sia intrigante. Personalizzazione dinamica, detection predittiva di flame wars, ranking semantico basato su LLM evoluti: su carta, ogni upgrade di Grok sembra uno step avanti. Ma il rischio, evidente, è che si stia costruendo una Ferrari per gareggiare su una pista sterrata, credendo che la sola ingegneria possa domare il caos antropologico.

L’intera vicenda mette a nudo una delle più grandi frizioni della Silicon Valley contemporanea: la fede cieca nel potere salvifico dell’algoritmo di fronte a problemi che sono, nella loro essenza, emotivi, culturali, ancestrali. La retorica dell’“AI che risolve” si scontra violentemente contro la realtà di utenti che non cercano informazione o dialogo, ma appartenenza tribale, gratificazione istantanea, conferme ai propri bias.

In altre parole, anche se Grok riuscisse a diventare il miglior moderatore automatizzato mai concepito, resterebbe comunque ostaggio di un bacino di utenti che, in larga misura, non vuole essere moderato ma solo amplificato.

Musk, nel suo inimitabile mix di visione geniale e provocazione narcisista, sembra ignorare — o più probabilmente sfidare consapevolmente — questo paradosso. Per lui, ogni problema complesso può essere piegato alla volontà tecnologica, ogni distorsione sociale può essere rifratta in termini di codice da ottimizzare. È una visione potente, magnetica, che però rischia di essere anche tragicamente miope.

La vera domanda da porsi oggi non è tanto “quanto sarà bravo il nuovo Grok”, ma piuttosto: “quanto siamo disposti a cambiare noi stessi per migliorare il livello della conversazione pubblica?”. Se la risposta è “poco o nulla”, allora nessun algoritmo, per quanto brillante, potrà mai salvarci da noi stessi.