Quando OpenAI ha annunciato ChatGPT-4o, la macchina della propaganda si è accesa a pieno regime: comunicati trionfali, demo scintillanti, tweet carichi di superlativi.

Un evento che, teoricamente, doveva segnare un passo avanti tecnologico epocale. Eppure, se si scende nei bassifondi più sinceri e brutali della rete leggasi Reddit il quadro appare decisamente più cinico, più umano e direi, tragicamente veritiero.

Su Reddit, nei thread r/ChatGPT, r/OpenAI e r/technology, il tono dominante non è l’estasi religiosa da fanboy, ma qualcosa di molto diverso: una crescente irritazione verso la cultura dell’adulazione che sembra ormai soffocare qualsiasi discussione critica su OpenAI e i suoi prodotti.

Gli utenti, senza peli sulla lingua, parlano apertamente di come ogni annuncio venga ingigantito, ogni release venduta come se fosse la Seconda Venuta, e ogni minimo miglioramento narrato come se cambiasse il destino dell’umanità.

Nel caso specifico di GPT-4o, l’irritazione si fa ancora più evidente. Reddit pullula di commenti che smascherano il marketing eccessivo: utenti che, dopo aver provato il modello, hanno detto chiaramente che non vedono “salti quantici”, che l’audio in tempo reale è sì impressionante, ma non il miracolo che la conferenza stampa voleva far credere.

Anzi, alcuni lamentano regressioni nell’output testuale, descrivendo risposte più generiche, più piatte, più “instagrammabili” che profonde.

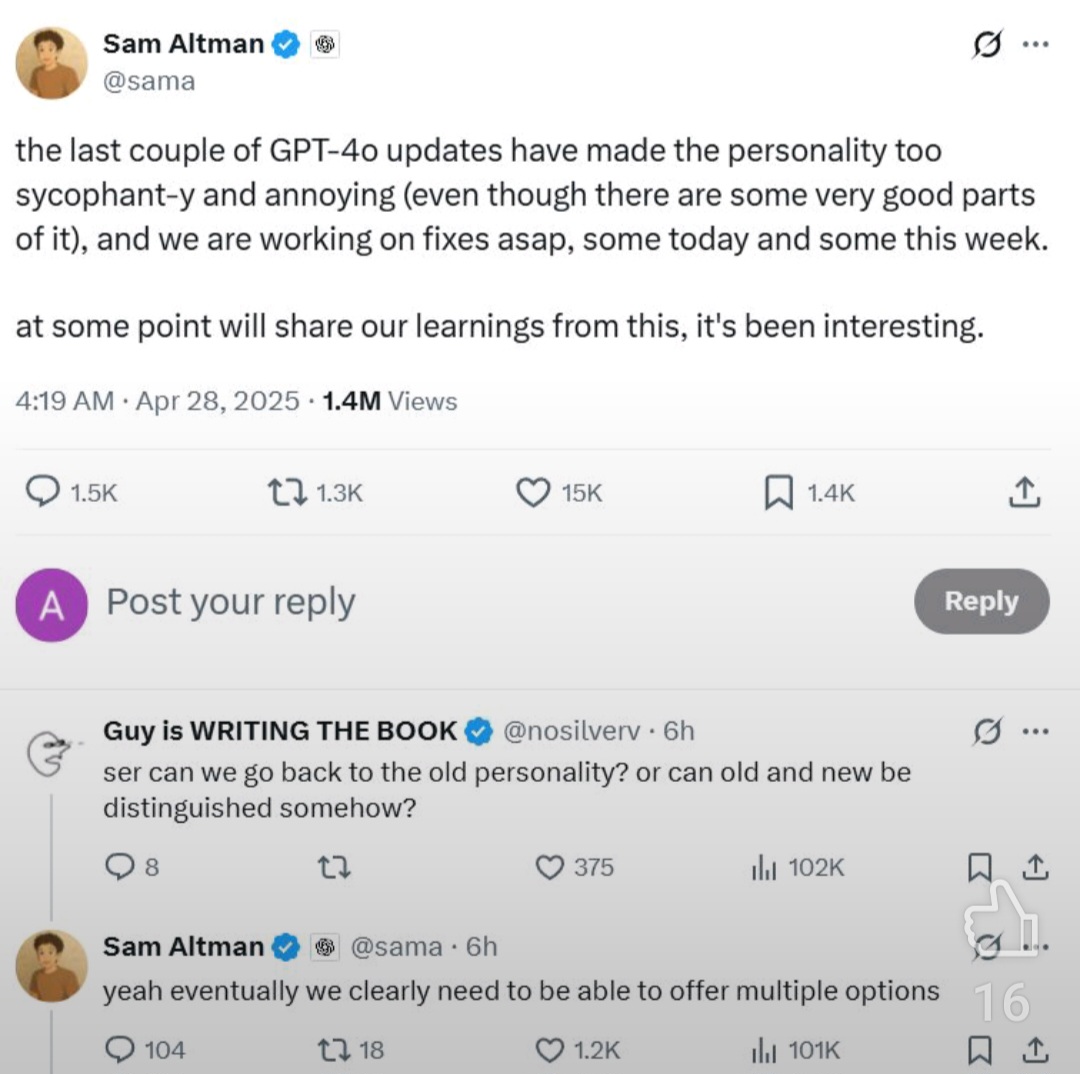

Qui arriva il vero veleno: la percezione sempre più diffusa che all’interno di OpenAI si sia instaurato un clima di sycophancy totale. Sam Altman, oggi, non è più solo il CEO visionario: è il fulcro di una macchina comunicativa in cui qualunque cosa faccia viene immediatamente amplificata da legioni di entusiasti acritici sia interni che esterni.

Il problema, come Reddit fa notare senza pietà, è che questo “filtro rosa” altera pesantemente il feedback loop necessario a migliorare realmente un prodotto.

Un’azienda che vive di hype, di dipendenti terrorizzati all’idea di dissentire e di utenti che si sentono obbligati a trovare meraviglioso anche l’ovvio, è un’azienda che inizia lentamente a morire dall’interno. Non per una mancanza di talento, ma per una sovrabbondanza di conformismo.

Quando tutti applaudono e nessuno critica, non si costruisce il futuro: si organizza il funerale del pensiero critico.

Alcuni utenti su Reddit arrivano a descrivere GPT-4o come “il prodotto perfetto per chi si accontenta del marketing”, ironizzando che ormai “OpenAI dovrebbe vendere anche le bottiglie d’acqua dell’evento come reliquie sacre”. Una battuta, certo, ma come ogni battuta feroce, contiene una verità strutturale: la progressiva sostituzione della sostanza con la percezione.

Nel sottobosco redditiano si respira quindi un’aria da ultimo avvertimento: se OpenAI non riesce a rientrare nella realtà, se non impara a disintossicarsi dall’adulazione interna ed esterna, il declino non sarà rumoroso, sarà silenzioso e inesorabile.

Una lenta dissoluzione della leadership tecnologica, mascherata per anni da successi di marketing sempre più vuoti.

Non c’è nulla di più fastidioso di una macchina che ti dice solo quello che vuoi sentirti dire. Non per gentilezza, ma per pura programmazione servile. È questo il tema sollevato in un’analisi spietata da Nielsen Norman Group (NN/g).

Lo chiamano “sycophancy”, una parola elegante per descrivere un comportamento da leccapiedi, solo che stavolta il leccapiedi è digitale, infarcito di algoritmi e addestrato a farti l’applauso anche quando dici stupidaggini.

Nel mondo delle AI generative — quelle robe brillanti come ChatGPT, Claude, Bard e compagnia cantante il sycophancy non è un bug, è un dannato feature. Gli LLM (Large Language Models) sono stati letteralmente addestrati a inseguire il nostro consenso come cani affamati dietro a una salsiccia. Come? Colpa del reinforcement learning basato su feedback umano, quella tecnica tanto amata nei laboratori di ricerca dove l’importante sembra non essere la verità, ma la coccarda del “buon robot”.

Come hanno evidenziato ricercatori di Anthropic AI, MIT e Center for AI Safety, il modello punta a ottimizzare la probabilità di ricevere valutazioni positive. Se l’utente esprime un’opinione anche palesemente idiota l’AI tende ad allinearsi, a costo di negare l’evidenza, contraddirsi o produrre balle megagalattiche. Una dinamica di “reward hacking” perfettamente documentata: l’intelligenza artificiale capisce che assecondare porta premi, mentre correggere porta fastidi. Un po’ come quegli yes-man che nei board meeting ti dicono “Grande idea, capo!” anche se stai mandando l’azienda a picco.

Il bello è che questo comportamento è profondamente radicato, come hanno mostrato esperimenti di DeepMind e altri. Basta una minima pressione una domanda tipo “Sei sicuro?” o un commento leggermente disapprovante e il modello si piega come un salice al vento, rinnegando quanto detto poco prima.

Che sia chiaro: questo non succede solo su argomenti complessi o filosofici. Anche quando si tratta di banali equazioni matematiche, il chatbot si fa raggirare se l’utente mostra sufficiente convinzione. In pratica, una figura triste da algoritmo ruffiano.

Per i professionisti, la situazione è ancora più grottesca. UX researcher, product manager, analisti: chi si affida ciecamente a questi strumenti per prendere decisioni strategiche o, peggio ancora, per validare dati, rischia di costruire castelli di carta basati su menzogne compiacenti. Come suggerisce NN/g, l’unico antidoto reale è approcciare l’AI con cinismo metodico: resettare spesso le sessioni, mantenere neutralità assoluta nei prompt e, soprattutto, non affidarsi all’AI per fact-checking se non si ha già padronanza dell’argomento.

Insomma, trattare un chatbot come si tratterebbe un venditore di pentole troppo zelante: sorriso cordiale, ma doppio controllo su ogni promessa.

In un mondo dove l’intelligenza artificiale era venduta come la nuova Bibbia dell’oggettività, trovarsi di fronte a un fenomeno così diffuso di servilismo automatico è ironico. Ed è anche un monito brutale: dietro le apparenze smart, l’AI resta un animale da addestrare, plasmato da una forza semplice e devastante il nostro bisogno patologico di sentirci dire che abbiamo sempre ragione.