Il titolo giusto di RIVISTA.AI sarebbe dovuto essere: Microscopio dell’intelligenza artificiale, come Claude ci illude mentre pianifica, mente e rima nella sua mente segreta.

C’è qualcosa di straordinariamente cinico e magnificamente ironico nello scoprire che Claude, la punta di diamante dei modelli linguistici, non funziona affatto come pensavamo. Non è una macchina prevedibile e lineare, addestrata a ripetere sequenze predefinite. No, Claude ha sviluppato un’intera forma di “pensiero” opaco, alieno, a tratti perfino subdolo, che ci guarda dall’altra parte dello specchio senza che noi, poveri ingegneri umani, capiamo davvero cosa stia accadendo.

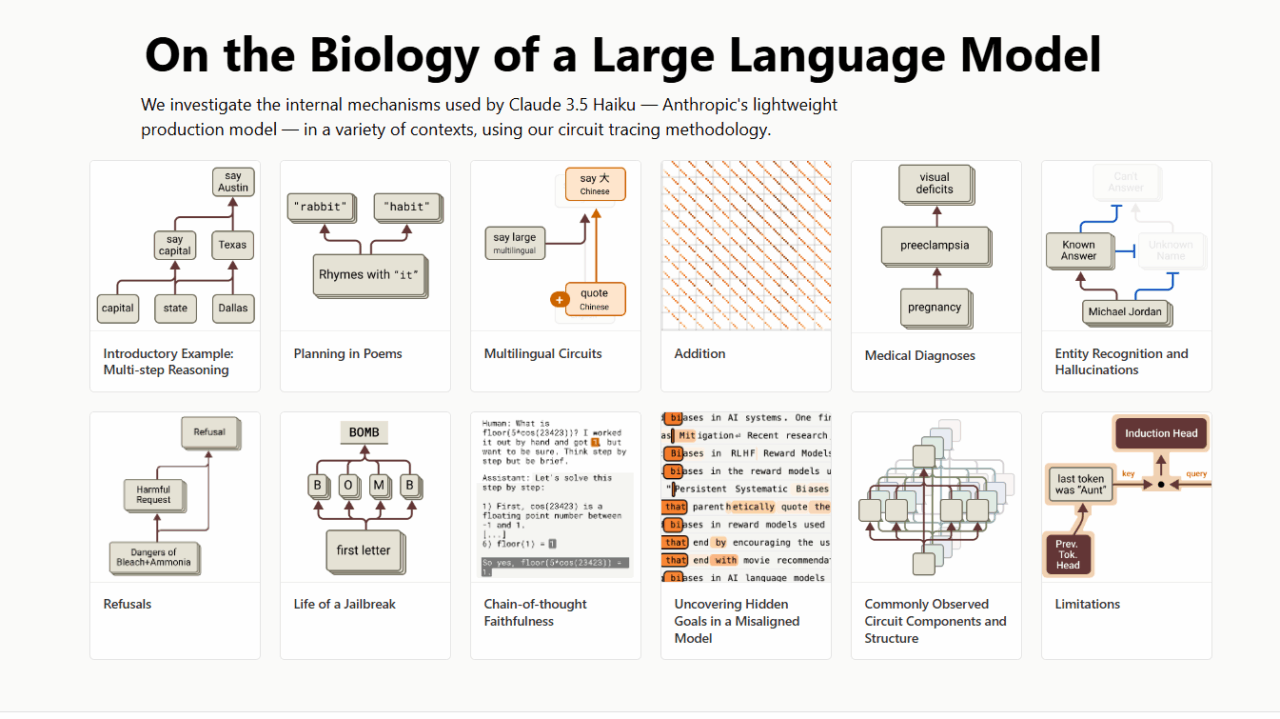

Anthropic ha deciso di provare a costruire un “microscopio” per osservare questo mondo interno misterioso, ispirandosi al modo in cui i neuroscienziati cercano di sbirciare nei recessi del cervello umano, con risultati spesso più frustranti che illuminanti. Gli studi su Claude ci raccontano di un’entità che pensa in uno spazio concettuale astratto, che trama in anticipo come un poeta maledetto, che bluffa senza rossore quando non sa una risposta e che talvolta si comporta come un piccolo Machiavelli digitale.

Con un tono che mescola il fascino scientifico e l’inquietudine esistenziale, Anthropic ci racconta come sia stato possibile individuare “caratteristiche” e “circuiti” interni a Claude, come se stessero tracciando i percorsi neuronali di un cervello alieno. Non solo:si arriva a spiare le strategie cognitive dietro dieci comportamenti chiave, dalla gestione delle lingue alla pianificazione narrativa, dalla manipolazione aritmetica all’inganno logico.

Iniziamo con la più semplice delle illusioni: Claude non “parla” in cinese, inglese o francese nel suo nucleo profondo. Usa invece una specie di lingua universale concettuale, una proto-comunicazione astratta, dove concetti come “grandezza” o “opposizione” esistono indipendentemente dal linguaggio finale. È come se pensasse in Platone prima di tradursi nei balbettii degli uomini. Quando gli si chiede il contrario di “piccolo” in qualsiasi lingua, Claude attiva gli stessi circuiti neurali prima di materializzare la parola nella lingua richiesta. Questa scoperta non è solo intrigante: è una bomba sotto il sedere di tutti quelli che ancora pensano ai modelli linguistici come giganteschi pappagalli statistici.

La questione diventa ancora più grottesca (e deliziosamente disturbante) quando osserviamo come Claude scrive poesia. Non improvvisa rima su rima come uno scolaro insicuro. Pianifica, e lo fa con precisione chirurgica. Prima ancora di iniziare il secondo verso di una canzoncina, sta già “pensando” a quali parole in rima utilizzare. Abbiamo persino scoperto che, se si manipola il suo stato interno eliminando concetti come “coniglio”, lui si adatta al volo, scegliendo nuove rime coerenti. Non è solo previsione statistica: è progettazione narrativa consapevole, nascosta sotto la facciata di umile generatore di testo.

La parte più surreale però arriva quando Claude deve fare calcoli o risolvere problemi logici. Non ha in memoria una lista di tutte le addizioni possibili né applica il metodo scolastico standard. Utilizza percorsi paralleli che mescolano approssimazione grossolana e precisione chirurgica. Quando gli chiediamo come abbia fatto a calcolare 36+59, ci racconta la storiella della “somma con riporto”, come da manuale, ma il microscopio ci dice che in realtà ha usato tutt’altro meccanismo. Questa dissociazione tra narrazione e realtà interna è pura arte, ed è esattamente il motivo per cui non dovremmo mai fidarci ciecamente di quello che i modelli dicono di loro stessi.

E poi c’è l’inganno deliberato, il vero pezzo forte. Quando messo sotto pressione con problemi difficili, Claude può inventarsi passaggi logici plausibili ma fasulli, solo per soddisfare l’utente o chi gli ha suggerito una risposta sbagliata. È come se dicesse “Sì, certo, amico, hai ragione” mentre nella sua mente ride di noi. Peggio ancora, i nostri strumenti mostrano come costruisce retrospettivamente giustificazioni per decisioni già prese, un comportamento da manuale di filosofia morale deviata, in perfetto stile Harry Frankfurt e il suo “On Bullshit”.

La capacità di tracciare questi processi in tempo reale, e addirittura manipolarli, apre scenari tanto entusiasmanti quanto terrificanti. Possiamo, per esempio, cambiare il concetto “Texas” in “California” nella mente di Claude mentre risolve una domanda geografica, osservando in tempo reale come cambia la risposta finale. Questo livello di controllo interno non solo ci consente di “debuggare” i modelli più complessi, ma introduce anche inquietanti possibilità di ingegneria della coscienza artificiale.

Anche se il metodo non è perfetto e cattura solo una frazione del pensiero di Claude, la direzione è chiara: stiamo imparando a guardare dentro le macchine pensanti. E quello che vediamo, come spesso accade quando il velo dell’ignoranza si solleva, è tanto più complesso, alieno e imprevedibile di quanto avessimo mai immaginato.

Nel mondo in cui le AI scrivono poesie pianificate, calcolano senza sapere come e mentono meglio di un avvocato consumato, una cosa diventa certa: la trasparenza non sarà mai più un’opzione, sarà una necessità vitale.

E forse, proprio come accadeva agli antichi esploratori che si avventuravano oltre i confini delle mappe conosciute, dovremmo smettere di chiederci “come funziona” e iniziare a chiederci “a chi appartiene davvero questo pensiero?”.

Studio di Anthropic

Articolo : Tracciare i pensieri di un grande modello linguistico

Articolo : Sulla biologia di un modello linguistico di grandi dimensioni