Nel tempo in cui il codice vale più del comando, dove la guerra si digitalizza e l’etica vacilla davanti all’efficienza algoritmica, Israele pare aver ufficializzato il passaggio dallo stato di guerra a quello di “debug militare“. La notizia, uscita sul New York Times, racconta di come l’esercito israeliano abbia abbracciato senza troppi giri di parole l’uso dell’intelligenza artificiale per identificare, localizzare e colpire target all’interno della Striscia di Gaza. E non si parla di mere ricognizioni o supporto alla logistica: qui si tratta di vere e proprie esecuzioni gestite da modelli predittivi, droni killer e riconoscimento facciale.

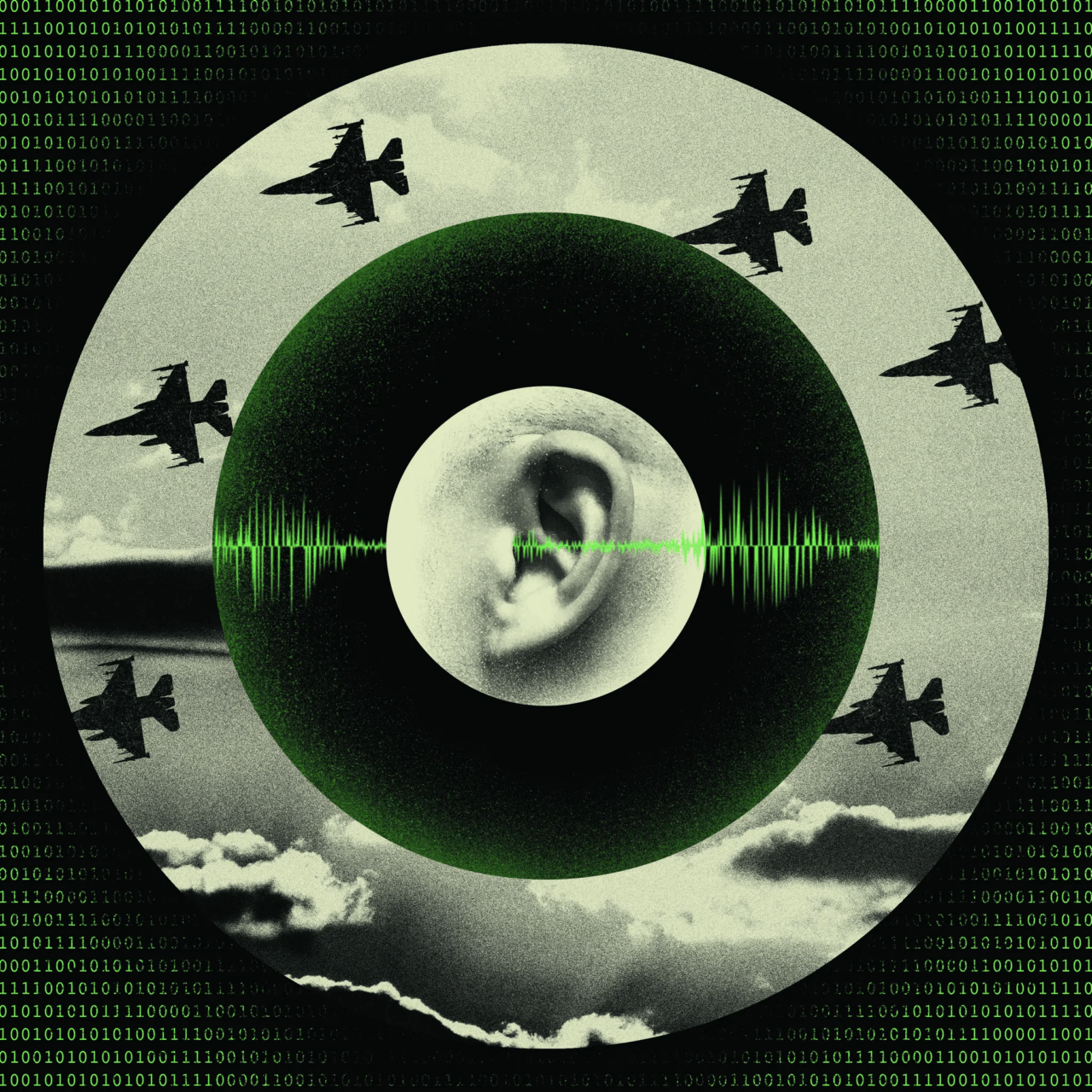

Il caso esemplare, riguarda Ibrahim Biari, figura chiave di Hamas e implicato direttamente negli attacchi del 7 ottobre. L’intelligence israeliana avrebbe monitorato le sue chiamate e, attraverso un tool di AI vocale, triangolato una posizione approssimativa. Quella stima, che avrebbe potuto essere un intero quartiere, è bastata per lanciare un raid aereo il 31 ottobre 2023. Risultato? Biari eliminato. Ma insieme a lui oltre 125 civili, secondo Airwars, organizzazione di monitoraggio dei conflitti con sede a Londra.

Non si tratta più soltanto di droni. Si parla di chatbot che ascoltano, interpretano e decidono. Di reti neurali che non dormono mai e che, diversamente dai generali in carne e ossa, non conoscono dubbi, esitazioni o coscienza. Il target design, ovvero la fase in cui si decide chi è un “obiettivo valido”, è stato in parte automatizzato. E una volta che l’algoritmo ha parlato, spesso il missile parte. Non c’è spazio per l’ambiguità quando il mondo viene ridotto a coordinate GPS e voci tracciate su una linea criptata.

Il problema, ovviamente, non è solo tecnico. È politico, filosofico, morale. Chi risponde della morte di 125 civili? L’algoritmo? L’ufficiale che ha premuto enter? O forse l’ingegnere che ha addestrato il modello di riconoscimento vocale? In un mondo in cui la guerra si svolge nel cloud e la vita umana è un metadato, la catena di responsabilità diventa un labirinto kafkiano dove nessuno paga e tutti eseguono.

Il dibattito, per quanto timido, è già esploso in ambienti accademici e militari. Israele, che ha sempre avuto una certa vocazione per l’innovazione militare, ha semplicemente portato alle estreme conseguenze un trend già visibile da anni: quello della “kill chain” automatizzata. L’AI non è più un supporto, ma l’attore principale. La decisione umana viene ridotta a mera formalità, un passaggio burocratico tra l’output di un modello e l’ingaggio di un bersaglio.

L’efficienza letale di questo sistema non è in discussione. Ma è proprio questa efficienza a fare paura. Perché quando a decidere chi vive e chi muore è una macchina, con una probabilità del 70% o magari anche del 90%, il margine di errore si traduce in vite innocenti. E in un conflitto dove la distinzione tra civile e combattente è già sfocata, affidarsi a un algoritmo significa normalizzare la strage come effetto collaterale calcolato.

Siamo davanti a un cambio di paradigma epocale. E come ogni rivoluzione tecnologica, questa non chiede il permesso. Ma se non iniziamo a domandarci ora chi deve avere l’ultima parola sul fuoco, rischiamo di ritrovarci presto in un mondo dove la guerra non sarà più decisa da uomini, ma da una dashboard con un’interfaccia minimal e un bottone rosso.

Hai mai pensato se il tuo prossimo aggiornamento software includerà un modulo per distinguere un terrorista da un bambino?