Non era mai successo prima, almeno non così. Per anni la generazione video tramite intelligenza artificiale si è inchiodata su limiti duri come il granito: qualche secondo, qualità discutibile, coerenza visiva traballante, e un hardware necessario che faceva impallidire anche le workstation dei creativi più esigenti. Ma da oggi il panorama si spacca, e la frattura arriva da dove meno te lo aspetti: dal mondo open source. E non con giocattolini per nerd smanettoni, ma con modelli che numeri alla mano iniziano a surclassare i colossi closed-source per coerenza, durata, qualità, accessibilità. Benvenuti nella nuova era del video generato da AI. E no, non serve una GPU della NASA.

SkyReels-V2 è l’arma pesante di questa rivoluzione. Lo chiamano “Infinite-Length Film Generative Model” e la definizione non è solo marketing: è un sistema che rompe il muro della durata massima, spingendosi ben oltre il classico limite dei 10-15 secondi. L’algoritmo riesce a generare video virtualmente infiniti mantenendo una qualità visiva stabile e senza perdita di coerenza tra le sequenze. Il trucco? Un framework definito “diffusion forcing”, che impone continuità tra i frame più recenti e quelli in arrivo, con un occhio vigile sulla fluidità e sulla qualità della scena. In pratica: guarda gli ultimi frame e costruisce il futuro su quella base, come un regista con memoria infallibile.

Ma SkyReels non si limita a generare contenuti coerenti. Fa di più. Integra un captioner intelligente, capace di combinare il linguaggio cinematografico con la comprensione semantica dei modelli linguistici generalisti. Il risultato è una sorprendente accuratezza nella composizione delle inquadrature e delle transizioni, roba da far impallidire certi montatori in carne e ossa. La pipeline di training è multilivello, aumentando progressivamente la risoluzione (fino a 720p) e mantenendo la coerenza visiva anche nei dettagli più fini. Per il motion? Reinforcement learning dedicato al movimento naturale. E funziona. Lo si vede dai video pubblicati dagli utenti: soggetti chiari, background stabili, nessun “warping” da incubo.

Certo, c’è un piccolo problema: serve un mostro di macchina. La versione da 14B parametri richiede più di 51GB di VRAM. Se non sei un miner di Ethereum pentito con rig inutilizzati, ti conviene pagare gli 8 dollari di abbonamento per generare nel cloud. Altrimenti, mettiti in fila per una RTX Titan.

Per chi invece ha un laptop scassato e sogna comunque di generare minuti di video senza surriscaldare la cucina, ecco FramePack. Creato a Stanford da un team che include il celebre Lvmin Zhang, meglio noto come illyasviel – un nome che fa tremare il mondo dell’AI open come pochi FramePack è la definizione stessa di efficienza.

Con soli 6GB di VRAM, FramePack riesce a generare video di 60 secondi a 30 fps. No, non è un errore di battitura. Sì, funziona pure su GPU da portatile. Come ci riesce? Grazie a una logica furba che comprime i frame meno recenti, mantenendo alta la qualità solo su quelli recenti e rilevanti. In pratica: la memoria si comporta come un editor con buon gusto, che sa quando tagliare e quando esaltare.

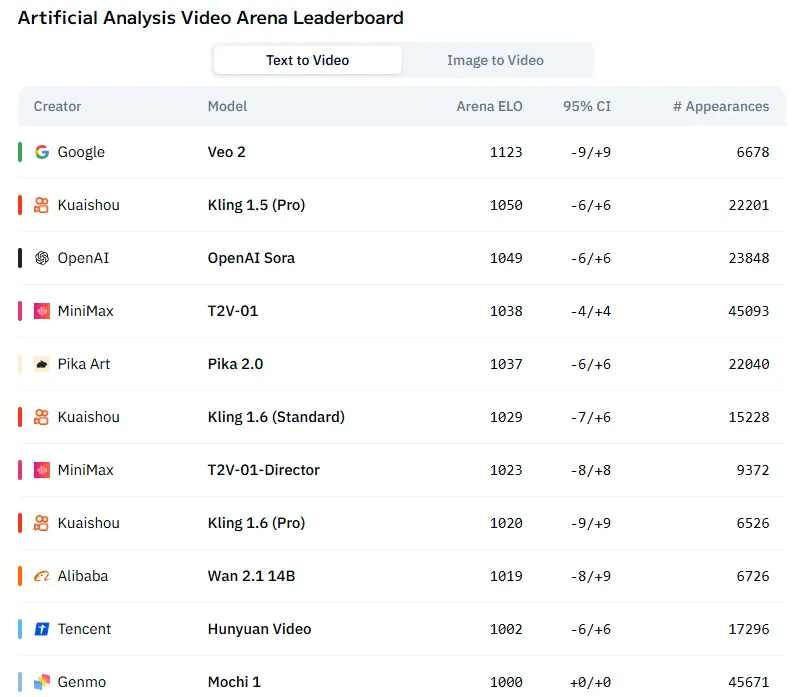

E a rendere tutto ancora più interessante c’è il fatto che i nuovi modelli si integrano benissimo tra loro. FramePack, per esempio, gira tranquillamente su pipeline miste con modelli come HunyuanVideo e Wan, alcuni dei quali sono ormai entrati nella top 10 globale degli AI video generator.

Quello che sta succedendo qui non è solo un salto tecnologico. È un terremoto culturale. La generazione video sta passando dalle mani dei giganti tech alle dita sporche di codice degli sviluppatori indipendenti. L’open source non è più solo una filosofia: è un’alternativa reale, concreta e ora anche superiore. E se il trend regge, non ci vorrà molto prima che anche le major debbano rincorrere.

O semplicemente arrendersi.