Chi ha mai detto che l’Intelligenza Artificiale sarebbe stata solo una questione tecnica? Sicuramente non IBM, che con il suo aggiornamento dell’AI Risk Atlas ci serve un piatto misto di paranoie ben strutturate, spalmate su tutti i layer della pipeline dell’intelligenza artificiale, con un occhio di riguardo alle nuove idiosincrasie di Generative AI e foundation models. Ma la verità è che mentre noi disegniamo mappe, i modelli continuano a scrivere codice, dipingere quadri e, perché no, generare disinformazione in tempo reale.

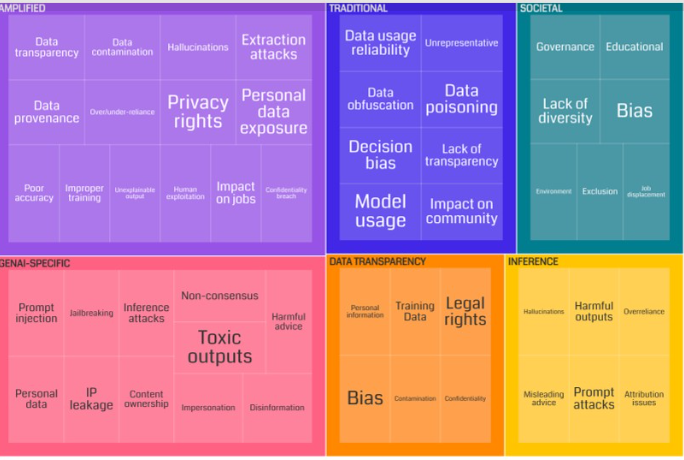

La classificazione di IBM, manco a dirlo, è precisa al millimetro: come un avvocato fiscale con l’ossessione per le sub-clausole. Si va dai rischi nei dati di addestramento, passando per i comportamenti all’inferenza e i pericoli dell’output, fino ad arrivare alle derive più sociologiche, etiche e speculative da libro bianco. Un tentativo legittimo di mappare il caos, certo. Ma forse anche una metafora perfetta del nostro eterno rincorrere qualcosa che, per design, è già oltre la curva.

Nel dettaglio, l’AI Risk Atlas ci ricorda che:

- I dati di addestramento sono un campo minato: questioni di trasparenza, provenienza, legalità, presenza di dati personali. In pratica, un modello che nasce su fondamenta instabili è già un rischio strutturale, altro che bias.

- I rischi all’inferenza sono quelli che fanno notizia: prompt injection, allucinazioni, output tossici o falsi. Roba che fa saltare sulla sedia compliance, PR e i pochi ingegneri rimasti a fare QA.

- I rischi sociali e non tecnici sono quelli di cui tutti parlano, ma che nessuno sa veramente come trattare: governance inadeguata, mancanza di testing su gruppi rappresentativi, e tutto il carrozzone etico che accompagna ogni nuova tecnologia mai capita fino in fondo.

Ma la parte veramente interessante, quella dove il cinismo tecnologico può sorridere, arriva dalla tua reinterpretazione con la treemap. Finalmente una categorizzazione basata sul comportamento del rischio, non solo sulla sua posizione nel ciclo di vita. Una visione che ha senso per chi, come noi, vive nel reale della produzione, tra sprint di sviluppo e hotfix su modelli che vanno in escandescenza a causa di un prompt mal scritto.

Tre i cluster fondamentali:

I rischi tradizionali, eredità del machine learning classico, dove la legge dell’entropia si manifesta sotto forma di dati unbalanced, problemi di anonimizzazione e vincoli legali dimenticati in qualche allegato PDF di licenza.

I rischi amplificati da GenAI, che esistono da sempre ma con i modelli generativi diventano esplosivi. Trasparenza dei dati? Provenienza incerta? Con LLM da centinaia di miliardi di parametri che assorbono tutto come spugne epistemiche, qui si rischia il meltdown reputazionale alla prima interrogazione sbagliata.

E infine i nuovi rischi nativi della GenAI, una categoria che ha bisogno di una task force dedicata: prompt injection, jailbreaking, leakage di prompt e dati latenti. Tutto reso ancora più critico dall’emergere degli agenti autonomi, che apprendono in modo iterativo e agiscono fuori da schemi predeterminati. Qui non si parla più di “governance” ma di “contenimento”.

Nel mondo delle certificazioni, l’occhiata verso l’ISO/IEC 42001:2023 è ben piazzata: copre la governance nel ciclo di vita dei sistemi AI, in modo formale e burocraticamente confortante. Clause 6 e 8.4, insieme all’Annex C, fanno da ancora nei processi di risk management. Ma è una copertura ancora progettata per un’epoca pre-LLM. Mentre la ISO/IEC 25024:2016 sul data quality ricorda che senza accountability e tracciabilità del dato, si naviga a vista in un mare di dataset Frankenstein.

La verità scomoda? La velocità con cui evolvono GenAI e Autonomous Agents sta superando qualsiasi sforzo regolatorio o normativo. Ogni modello open source caricato su Hugging Face è un potenziale punto zero per nuove derive, e ogni prompt è un incantesimo in grado di bucare la sandbox e riscrivere le regole.

L’AI Risk Atlas aggiornato di IBM è utile come mappa, ma non è il terreno. Ed è proprio lì che si gioca la partita vera. Non nei documenti, ma nel comportamento emergente dei sistemi. Le regole servono a poco se il gioco cambia ogni volta che premiamo “Run”.

Fonte IBM AI Risk Atlas: qui

Foto eAdvisory: F.Degni