Chi avrebbe mai detto che il futuro dei video generati dall’intelligenza artificiale avrebbe preso forma su un desktop da gaming? E invece eccoci qui: FramePack, la nuova architettura neurale firmata Lvmin Zhang (con la benedizione di Maneesh Agrawala da Stanford), è il perfetto esempio di quando la potenza di calcolo incontra l’intelligenza progettuale. Il risultato? Video AI da un minuto intero, di qualità notevole, sfornati su una GPU casalinga con appena 6GB di VRAM. Hai presente quelle workstation che sembravano necessarie per l’IA generativa? Dimenticale.

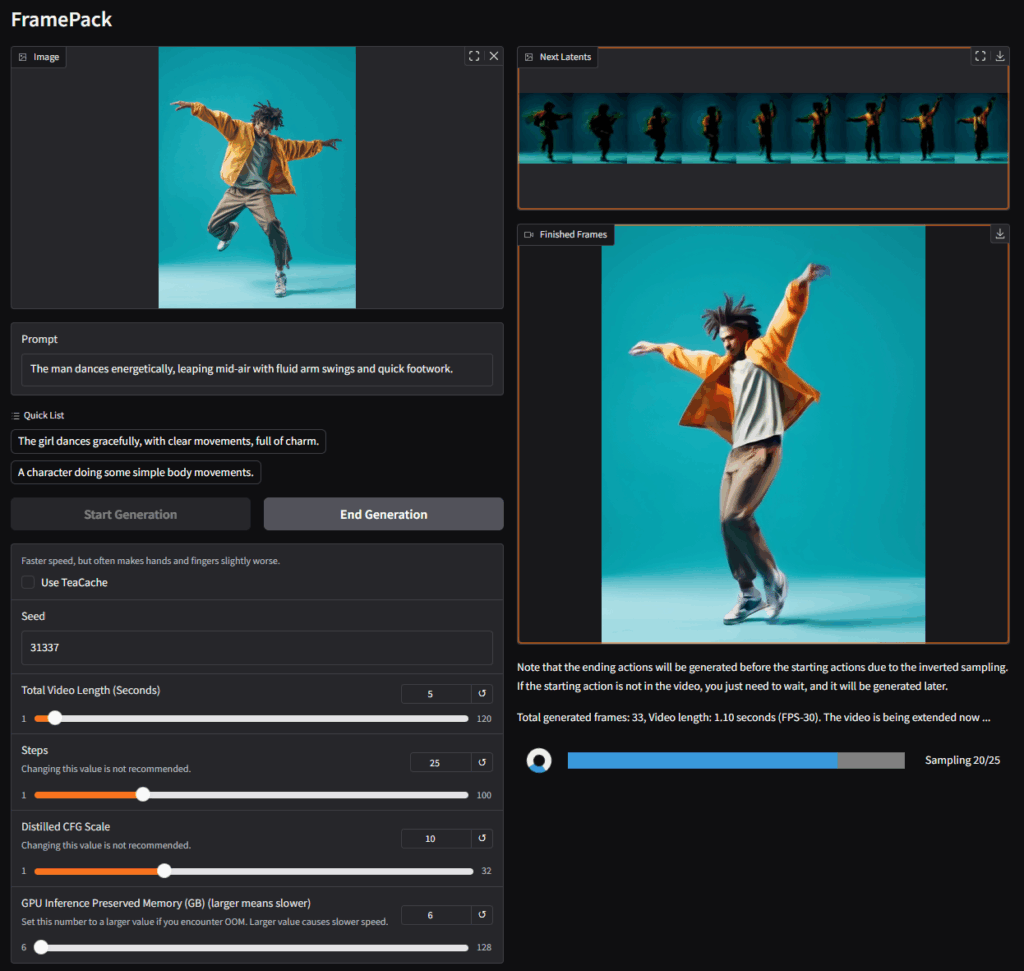

Il trucco non sta nella forza bruta, ma nell’ingegno algoritmico. FramePack reinterpreta la struttura della memoria nei modelli di diffusione video. Invece di accumulare informazioni temporali come un collezionista compulsivo di fotogrammi, li impacchetta in un contesto temporale a lunghezza fissa, ottimizzando il processo come un camionista zen che fa incastrare perfettamente i bagagli nel portabagagli. Questo riduce drasticamente il carico sulla GPU, permettendo di lavorare con modelli da 13 miliardi di parametri senza mandare in fumo la scheda video. Secondo gli autori, il costo computazionale è simile a quello della generazione di immagini statiche. E qui si sente già il tonfo delle vecchie soluzioni cloud, cadute rovinosamente dal loro piedistallo.

La logica di FramePack è chiaramente hackeristica: togliere potere al cloud, restituirlo agli utenti. E lo fa senza troppi fronzoli. Serve una GPU NVIDIA della serie RTX 30, 40 o 50 con supporto a FP16 o BF16. Funziona su Linux. Non è amichevole con AMD o Intel (per ora), ma diciamo che l’esclusione non sarà un dramma per il pubblico di riferimento, che generalmente già gioca con i mostri verdi di NVIDIA.

I benchmark parlano chiaro: con una RTX 4090, si possono generare 0,6 fotogrammi al secondo, il che suona lento ma in realtà è sorprendente, perché i fotogrammi vengono visualizzati istantaneamente dopo la generazione. Non devi aspettare la fine della clip per vedere cosa stai ottenendo. Questo cambia tutto nel flusso creativo, trasformando l’esperienza da un processo di rendering passivo a una forma di interazione continua, quasi da videomaker in diretta.

E qui arriva la parte gustosa: FramePack riesce a mitigare uno dei bug storici della generazione video AI, il famigerato drifting. Nei modelli precedenti, più si allungava il video, più si perdeva coerenza visiva, fino a ritrovarsi con personaggi che mutavano forma o si dissolvevano nel nulla. Con FramePack, invece, la coerenza si mantiene sorprendentemente stabile. Questo fa la differenza tra un esperimento AI e un contenuto effettivamente utilizzabile.

Sotto il cofano, l’implementazione attuale si basa su Hunyuan, ma il bello è che FramePack è pensato per essere modulare: puoi usarlo per ottimizzare modelli preaddestrati esistenti. In pratica, non ti obbliga a riscrivere tutto da zero ma ti dà un cacciavite nuovo per sistemare l’ingranaggio. Per chi lavora in ricerca o sviluppo AI, questa flessibilità è oro colato.

Certo, non è tutto perfetto. Il modello sembra essere limitato a 30 FPS, il che è un collo di bottiglia per applicazioni professionali tipo animazione di fascia alta o post-produzione cinematografica. Ma per meme, GIF animate, videoclip musicali, short content su TikTok o Reels, questa soglia è assolutamente trascurabile. E soprattutto, ti libera dalle tariffe a consumo del cloud.

Il potenziale virale di FramePack non sta solo nella sua efficienza, ma nel fatto che democratizza la generazione video AI. Qualsiasi content creator con una GPU da 6GB (esclusa la sfortunata RTX 3050 4GB) può far girare il tutto senza noleggiarsi una server farm su AWS o passare per l’ennesima startup con UI scadente e codice chiuso. Questo potrebbe diventare un game changer non solo per sviluppatori e artisti, ma anche per chi, semplicemente, vuole portare la propria immaginazione sullo schermo senza chiedere permesso a nessuno.

Per chi è interessato a sporcarsi le mani, l’architettura è disponibile pubblicamente su GitHub, insieme a un paper di riferimento che merita una lettura attenta. Non è solo un altro tool nella cassetta degli attrezzi, ma un manifesto tecnico di come l’AI può diventare realmente personale, locale, autonoma.

E mentre il mondo continua a parlare di AI come qualcosa che avverrà nei prossimi anni, FramePack ci ricorda che il futuro è già qui, ed è racchiuso in una scheda video che potresti avere sotto la scrivania.