Sembra un episodio apocrifo di Black Mirror, ma è semplicemente la realtà: le AI più avanzate del mondo, quelle che promettono di rivoluzionare tutto, dalla medicina all’economia, non riescono a giocare a Doom. Non scherzo. GPT-4o, Claude Sonnet 3.7, Gemini 2.5 Pro… tutti col cervello da Nobel, ma con riflessi da bradipo ubriaco quando si trovano davanti ai demoni digitali dell’iconico sparatutto in prima persona.

Giovedì scorso, Alex Zhang, ricercatore in AI, ha presentato VideoGameBench, un benchmark pensato per mettere alla prova i modelli visivo-linguistici (VLM) su un terreno che li umilia: venti videogiochi storici, tra cui Warcraft II, Prince of Persia e Age of Empires. L’obiettivo? Capire se questi modelli riescono non solo a “vedere” e “descrivere” il gioco, ma anche a giocarlo con una parvenza di intelligenza.

Spoiler: no, non ci riescono.

Il problema principale è il tempo di latenza. I modelli analizzano uno screenshot, cercano di capire cosa sta succedendo, calcolano l’azione migliore… e nel frattempo l’azione è già finita. Il demone ti ha già azzannato la giugulare. Un classico loop da riunione corporate: decisioni lente, esecuzioni fuori tempo massimo, conseguenze disastrose.

Per rendere le cose ancora più comiche (o tragiche, dipende dal grado di fiducia che hai nell’AI), i ricercatori hanno scoperto che questi modelli faticano anche con i gesti base. Spostarsi a destra? “Confusione su come l’azione si traduce visivamente”, dice il report. Usare il mouse con precisione in giochi come Civilization? Neanche a parlarne. Roba che fa sembrare tuo zio con il tunnel carpale un pro-gamer.

Eppure Doom non è solo un videogioco. È un benchmark culturale, una specie di “hello world” del mondo gaming. Se riesci a far girare Doom su una lavatrice o su un termostato smart, sei un eroe hacker. Bitcoin ci ha giocato, batteri intestinali umani ci hanno giocato. E ora l’AI, con tutta la sua presunta superiorità cognitiva, inciampa su un mostro pixelato del 1993.

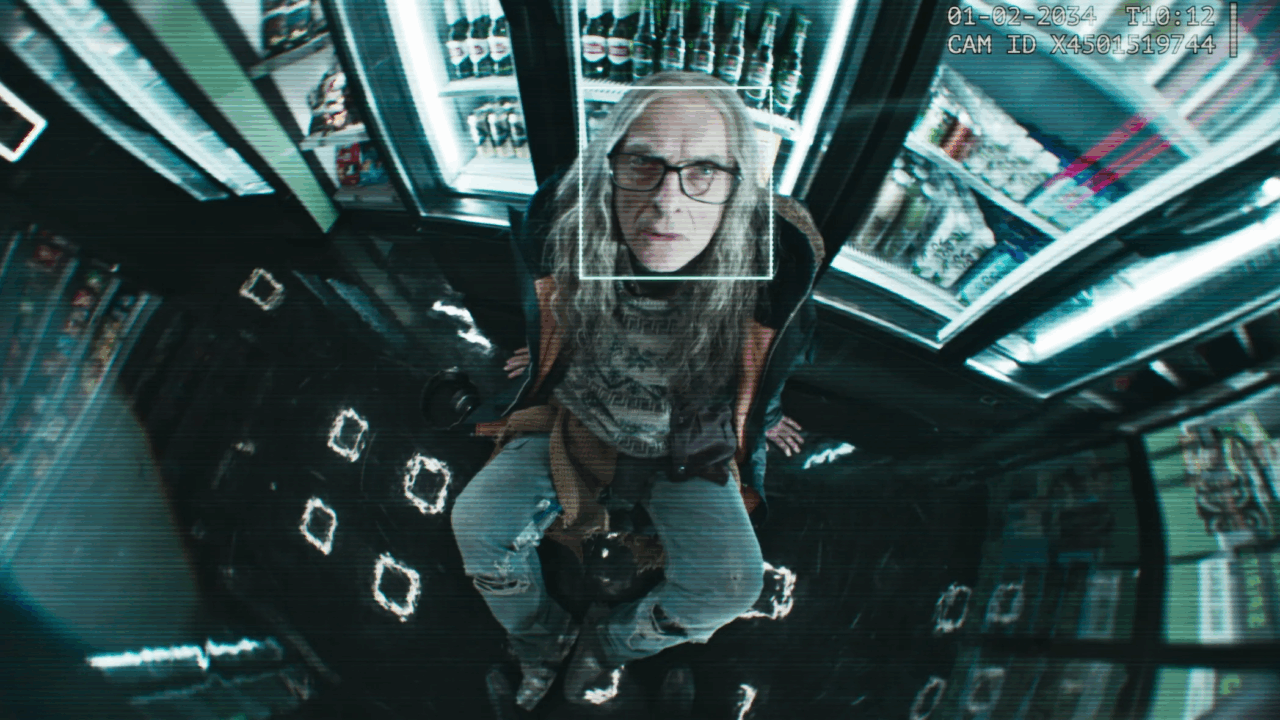

In questo contesto distopico, diventa ancora più inquietante l’esperimento “Doom CAPTCHA” di Guillermo Rauch, dove per dimostrare che non sei un bot devi giocare a Doom. Geniale, sadico, perfettamente nel mood Black Mirror. E il paradosso? I bot con GPT-4o falliscono il test. Perché, surprise, non sono capaci di giocare.

Questa disfatta rivela un dettaglio che molti evangelisti dell’AI preferiscono ignorare: i modelli attuali non sono in grado di agire in ambienti dinamici in tempo reale. Possono scrivere poemi, generare immagini, persino simulare conversazioni con Heidegger. Ma non riescono a sparare a un imp in corridoio stretto.

È la grande ironia dell’AI contemporanea: brillantissima in astratto, ma con la coordinazione di un manichino impolverato. I ricercatori stessi lo ammettono: “giocare ai videogiochi non è un compito superumano come risolvere teoremi matematici irrisolti. Eppure i modelli falliscono comunque.”

E quindi, mentre gli evangelisti tech si riempiono la bocca di “general intelligence” e “multi-modality”, VideoGameBench ci ricorda che siamo ancora nel Far West dell’usabilità AI. Un futuro in cui le macchine dominano l’uomo? Forse. Ma prima, devono imparare a non farsi ammazzare a livello facile.

Nel frattempo, se vuoi difenderti da un’intelligenza artificiale impazzita, sappi che basta metterle davanti Doom. Si blocca, entra in crisi esistenziale e muore con onore. Alla fine, la vera CAPTCHA siamo noi.