AML, KYC e KYB compliance

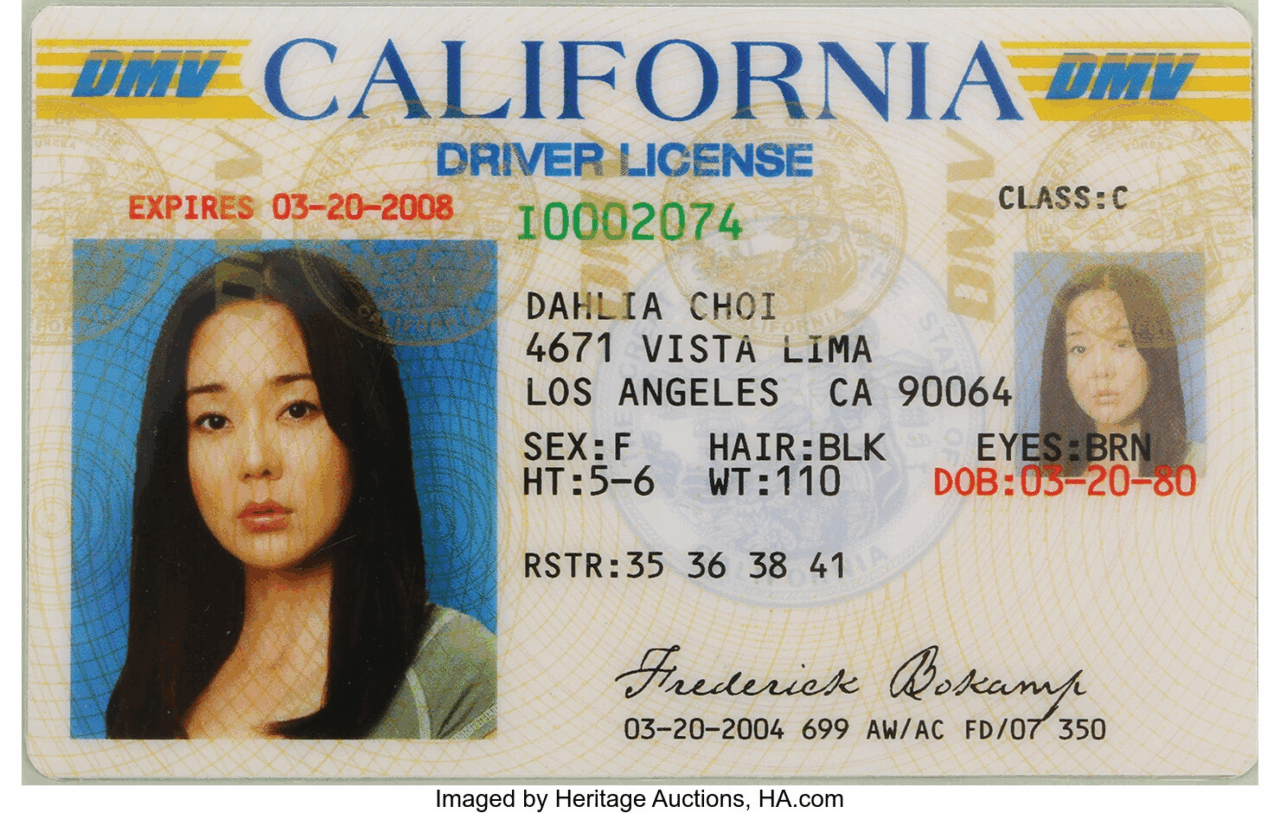

OpenAI ha annunciato che d’ora in poi le organizzazioni che vogliono accedere ai suoi modelli più avanzati dovranno passare per un processo di verifica d’identità. Non si parla di una banale registrazione con email aziendale: si entra nel regno del riconoscimento facciale e del documento ufficiale rilasciato dal governo. Sì, quello con la foto brutta.

Perché? Perché OpenAI, come ogni buon colosso tecnologico che ha finalmente capito che i giocattoli che ha messo al mondo possono essere usati non solo per creare poesie d’amore per gatti, ma anche per scenari meno Disney, ha deciso di mettere le mani avanti. O, meglio, di mettere un bel tornello all’ingresso.

Il vero movente è un mix perfetto tra paranoia aziendale, autodifesa geopolitica e un pizzico di sorveglianza profilata. L’obiettivo è bloccare gli sviluppatori “cattivi”, soprattutto quelli che operano da certi Paesi scomodi. L’intelligenza artificiale, d’altronde, non ha passaporto, ma ora il programmatore sì. E deve esibirlo.

Ma il controllo non si ferma lì. OpenAI vuole sapere anche chi stai servendo. Il developer, una volta identificato, sarà legato a una sola organizzazione. Niente più freelance che passano da un’azienda all’altra, accedendo a GPT come se fosse l’ultimo bar aperto a notte fonda. Questo rafforza il concetto che ogni richiesta ai modelli debba essere tracciabile, non solo per motivi legati all’IP e ai limiti di utilizzo, ma soprattutto perché qualcuno deve essere formalmente responsabile se ChatGPT inizia a spiegare come fabbricare un ordigno improvvisato.

C’è anche un’altra lettura più strategica. Mentre i modelli diventano multimodali (voce, video, immagini), il rischio si moltiplica. Un’istruzione per creare un deepfake, una falsificazione vocale, un’immagine compromettente: tutto questo può passare tra le maglie dei prompt, e OpenAI non vuole essere colta impreparata davanti alla prossima disastrosa prima pagina del New York Times.

In fondo, è una scelta che va nella stessa direzione della grande corsa globale alla verifica dell’identità digitale. Dai portali di gioco d’azzardo alle piattaforme di contenuti per adulti, dalla compliance bancaria KYC/AML fino all’autenticazione forte nelle transazioni digitali, la direzione è chiara: sapere sempre chi c’è dall’altra parte dello schermo. E assicurarsi che non possa dire, il giorno dopo, “non ero io”.

Le imprese che usano OpenAI dovrebbero quindi iniziare a riorganizzare il loro onboarding interno. Dimenticate l’accesso libero al playground o l’uso di API con chiavi condivise. Serve un processo formale, con offboarding e monitoraggio incluso. Ogni sviluppatore deve essere autenticato, e ogni prompt tracciabile fino all’individuo. Il rischio? Lo shadow genAI: quando l’AI viene usata fuori dai radar IT, diventando un buco nero di proprietà intellettuale aziendale e dati sensibili potenzialmente esfiltrabili.

Per evitare di scivolare nel baratro, Forrester suggerisce l’adozione di soluzioni di verifica dell’identità che siano omnicanale, con basso attrito per l’utente ma altamente efficaci. Web, mobile, contact center, persino di persona: ogni canale è buono se consente di sapere con certezza chi sta usando GPT e perché.

La morale della favola è semplice: il gioco dell’AI si fa serio. E per sedersi al tavolo, serve un documento in regola.