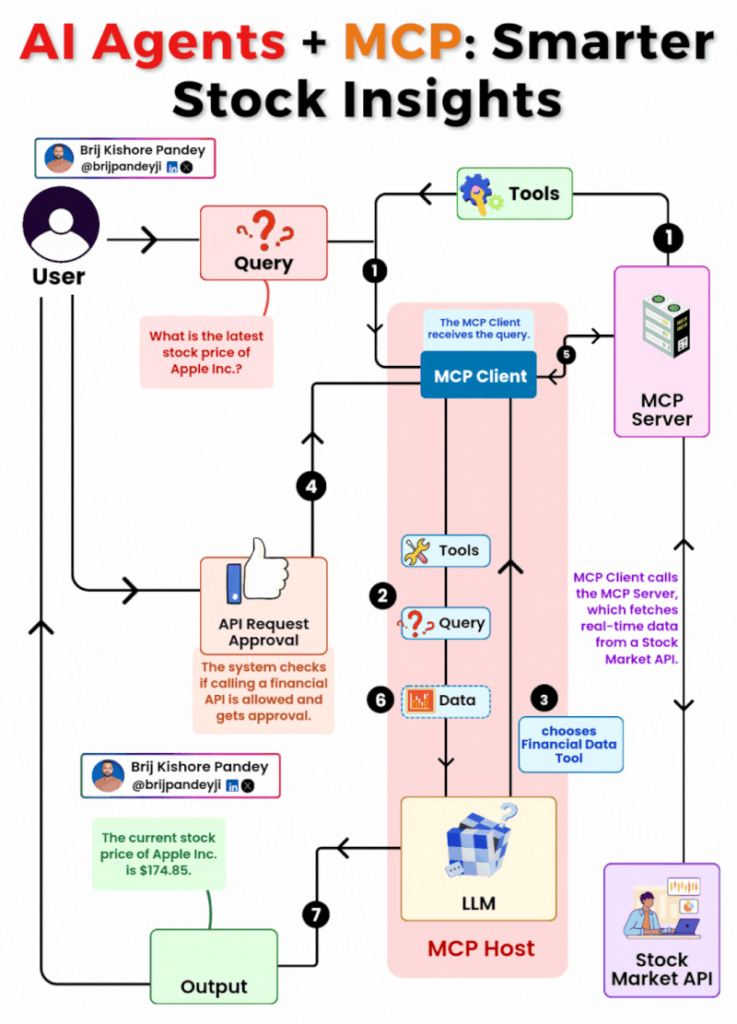

Quando si parla di AI generativa nel 2025, il vero problema non è più la creatività dei modelli, ma la loro drammatica incapacità di interagire col mondo reale. Fino a ieri, chiedere a un LLM il prezzo attuale delle azioni Apple equivaleva a interpellare un indovino con amnesia cronica. Ottimo a parlare, pessimo a fare. Ora, Anthropic cambia le regole del gioco con il suo Model Context Protocol (MCP), un’infrastruttura che segna l’inizio di una nuova era: quella degli agenti AI operativi, contestuali, e – per una volta – utili davvero.

Il principio alla base è brutalmente semplice, ma incredibilmente potente. Un Large Language Model non è più un oracolo chiuso nella sua scatola nera addestrata mesi fa, ma un agente intelligente che può usare strumenti in tempo reale, decidere cosa fare in base al contesto, rispettare policy aziendali, chiedere approvazioni, e tornare con un output operativo e affidabile.

Immagina di avere un assistente virtuale che può non solo rispondere a una domanda, ma anche fare una chiamata API per te, verificarne l’autorizzazione, adattarsi al ruolo che ricopri in azienda, tenere conto delle tue preferenze di sicurezza, e restituirti un dato vivo e azionabile. Questo non è ChatGPT che gioca al piccolo broker: è una piattaforma di automazione cognitiva costruita per il mondo enterprise.

Il caso esemplare citato da Anthropic – chiedere il prezzo delle azioni Apple – è solo la punta dell’iceberg. MCP apre uno scenario dove gli LLM diventano orchestratori intelligenti di workflow reali, e non solo generatori di testo. Questo significa che, con i giusti tool e permessi, un modello può:

- Eseguire una due diligence finanziaria collegandosi a più fonti verificate, aggregando dati, e presentando una sintesi contestuale a un board esecutivo.

- Automatizzare ticket IT, aprendo, aggiornando o chiudendo richieste all’interno di sistemi come Jira, ServiceNow o Zendesk in base a policy definite e verificabili.

- Interagire con ERP e CRM in modo semantico, aggiornando ordini, consultando scorte, profilando clienti, in base a regole granulari e auditabili.

- Facilitare un controllo compliance in tempo reale, eseguendo query su documenti, report e normative aziendali, incrociandoli con processi interni e segnalando violazioni.

- Assistere in operazioni legali, consultando database di contratti, clausole e sentenze, adattando il risultato al contesto giuridico o industriale.

La differenza strutturale rispetto al passato è che MCP non è solo una porta d’accesso alle API, ma una vera e propria logica di orchestrazione contestuale: ogni chiamata a uno strumento è valutata in base a permessi, ruolo dell’utente, cronologia, e policy aziendali. È un layer semantico tra linguaggio naturale e realtà operativa, un middleware cognitivo.

E qui entra in gioco il vero valore: governance. Le aziende non hanno mai voluto affidarsi a un’AI che “fa cose” a caso. Hanno bisogno di sistemi auditabili, dove ogni decisione è tracciabile, approvata, loggata. MCP permette questo. Permette di creare un’agente AI che non solo fa, ma fa come voglio io, quando voglio io, con le condizioni che decido io.

Siamo davanti a un cambio di paradigma simile a quando gli script batch hanno lasciato il posto alle pipeline CI/CD. MCP è la pipeline della nuova automazione AI-driven: programmabile, modulare, e responsabile.

E mentre tutti corrono dietro ai modelli sempre più grandi, sempre più multimodali, la verità è che la prossima rivoluzione non sarà nella testa dell’AI, ma nelle sue mani. Nella sua capacità di agire, non solo di parlare.

Per chi vuole approfondire il progetto: Model Context Protocol di Anthropic

Aspetto la prossima startup che, usando MCP, mi costruisce un CFO virtuale in grado di fare analisi trimestrali, valutare rischi, e mandare i risultati al CdA. E magari suggerire anche dove tagliare, perché è il momento di ottimizzare il burn rate.