Google ha appena alzato l’asticella dell’illusionismo AI. Con l’ultima evoluzione di Veo 2, il suo modello video generativo, promette che chiunque dallo stagista al regista frustrato potrà produrre contenuti “cinematografici” degni di un trailer Marvel, senza nemmeno sporcare le mani con una telecamera vera. L’update arriva tramite la piattaforma Vertex AI e spalma le novità anche su Imagen 3 per le immagini e su Lyria e Chirp 3 per musica e voce. Ma dietro le luci della ribalta c’è il solito dilemma: chi sta veramente scrivendo questa nuova grammatica visiva e sonora?

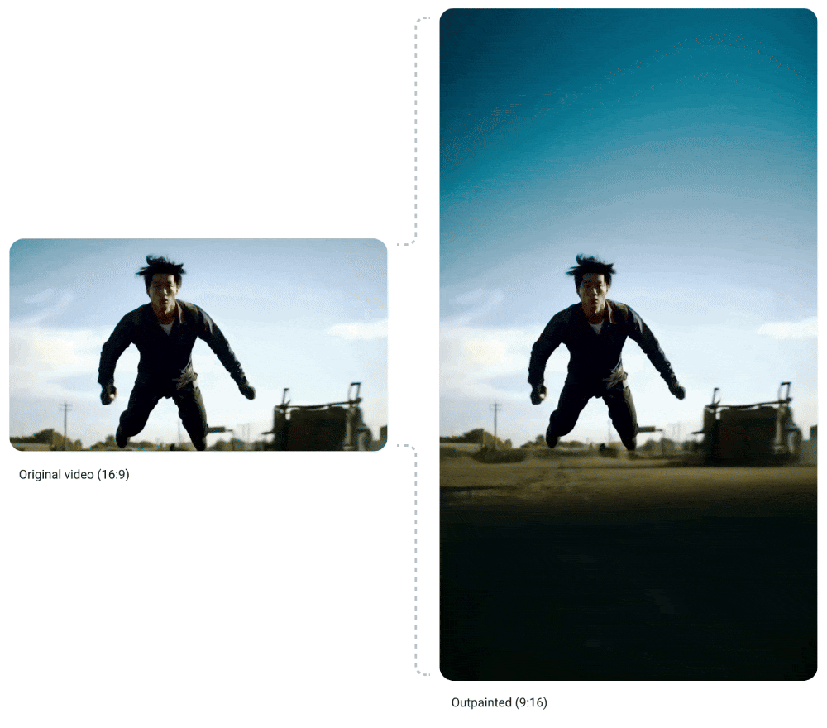

Il cuore dell’dell’aggiornamento di Veo 2 pulsa attorno a due concetti presi in prestito da Photoshop ma portati in video: inpainting e outpainting. Il primo cancella elementi indesiderati da una clip — loghi, sfondi fuori luogo, o dettagli che potrebbero ricordarti che la realtà è meno perfetta di un feed Instagram. L’outpainting invece espande il frame, aggiungendo porzioni di video create artificialmente, in modo coerente con la scena. Una specie di Photoshop Motion per video, con la mano invisibile dell’AI che completa lo spazio vuoto come se fosse un assistente di Kubrick.

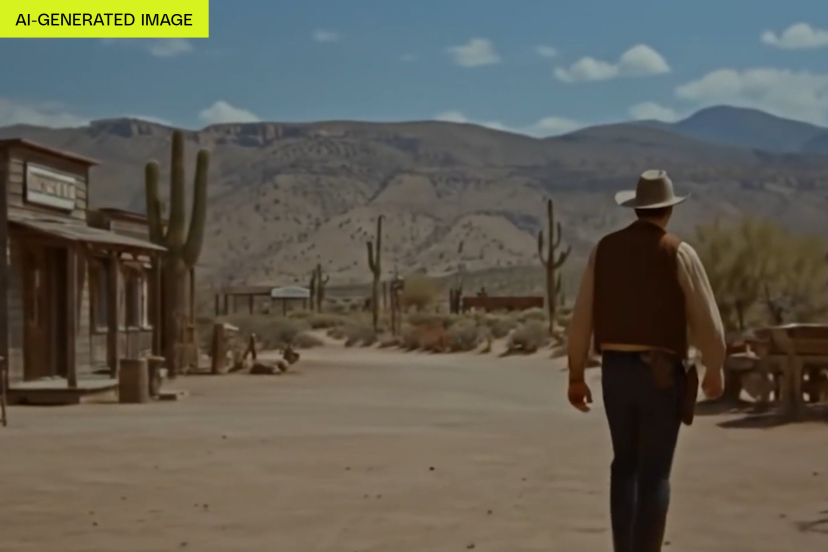

Poi c’è il giochino delle “preset cinematiche”. Basta inserire nella descrizione un riferimento a tecniche come timelapse, drone POV o panoramica da camera dolly, e Veo 2 cercherà di replicare le intenzioni del tuo inner regista. Il tutto funziona più come un filtro di Instagram avanzato che come una direzione creativa vera, ma se sei un brand come Kraft Heinz che deve sfornare 50 clip per TikTok alla settimana, il tempo è più importante dell’autorialità.

Non paghi della realtà espansa, Google ha introdotto anche la video interpolation tra due immagini statiche. Tradotto: dai un inizio e una fine e l’AI ti inventa la parte nel mezzo. Magia? No, solo deep learning e una discreta quantità di compromessi visivi. Ma per il marketing non serve un capolavoro, basta una narrazione che tenga lo spettatore incollato per 8 secondi.

Per non farci mancare nulla, Imagen 3 migliora la rimozione automatica degli oggetti nelle immagini statiche, rendendo i risultati meno glitchati e più “naturali” — qualunque cosa significhi naturale in un mondo dove un hamburger può essere creato da un prompt. L’Oreal e Heinz stanno già usando questi strumenti per produrre contenuti che una volta richiedevano settimane. Ora servono solo otto ore e una connessione decente. Welcome to the AI sweatshop.

Nel campo audio, Google ha fatto entrare in preview Lyria, il suo modello testo-in-musica, e aggiornato Chirp 3, che ora può clonare una voce realistica partendo da 10 secondi di audio. E se vi suona inquietante, è perché lo è. Una voce sintetica che suona come te, creata da un vocale WhatsApp. Potente, certo. Ma anche perfettamente sfruttabile per deepfake, manipolazioni o peggio, customer care automatizzati che ti rispondono con la voce di tua madre.

E come se non bastasse, debutta anche Gemini 2.5 Flash, una versione “light e veloce” del loro modello multimodale, ottimizzato per risposte rapide. Può decidere quanto potere computazionale usare a seconda della complessità del compito, un dettaglio che farà godere i reparti IT che ancora litigano con i budget di inferenza.

Infine, Google sta aggiornando i suoi strumenti agentici, permettendo agli AI di parlarsi tra loro ed eseguire compiti in ecosistemi aziendali tipo PayPal e Salesforce. Sì, stiamo entrando nell’era in cui gli agenti AI negozieranno fra loro mentre tu cerchi di capire dove sono finiti i tuoi dati.

Certo, tutto questo è scintillante. Ma sotto c’è l’incongruenza di sempre: Adobe giura che i suoi modelli sono addestrati su contenuti pubblici e con licenza. Google, invece, gioca al pesce in barile: “abbiamo addestrato i nostri modelli su tutto il web”. Inclusi i tuoi video, i miei articoli, le immagini di tua nonna su Flickr.

Siamo davvero sicuri di voler girare un film con uno sceneggiatore che ha copiato tutte le battute dalla rete?