L’Intelligenza Artificiale (AI) sta ridefinendo il concetto stesso di guerra e, con esso, il pericolo di un conflitto nucleare fuori controllo. L’idea che una macchina possa prendere decisioni in ambito militare, in particolare nel contesto nucleare, fa tremare i polsi persino agli esperti di strategia. Eppure, la corsa all’AI militare è già una realtà consolidata, con Stati Uniti, Cina e Russia in prima linea, mentre il resto del mondo osserva con una combinazione di paura e impotenza.

Secondo John Tasioulas, direttore dell’Institute for Ethics in AI dell’Università di Oxford, la priorità dovrebbe essere una sola: garantire che le decisioni sull’uso di armi nucleari restino sotto il controllo umano. Il rischio non è tanto l’apocalisse robotica da fantascienza, ma una guerra atomica innescata da un malinteso, da un errore di calcolo o, peggio, da un algoritmo difettoso. L’AI, lungi dall’essere solo uno strumento difensivo, potrebbe rivelarsi il più grande fattore destabilizzante mai introdotto nella geopolitica moderna.

Tutti i paesi dotati di arsenali nucleari – Stati Uniti, Cina, Russia, Gran Bretagna, Francia, India, Pakistan e Corea del Nord – stanno già integrando l’AI nei loro sistemi di difesa. Il Pentagono, ad esempio, ha aumentato gli investimenti in AI da 261 milioni di dollari a 675 milioni tra il 2022 e il 2023, segno di quanto questa tecnologia sia vista come un asset strategico.

Israele, che pur senza conferme ufficiali è considerato un paese nuclearizzato, ha impiegato AI nel conflitto di Gaza per il targeting di precisione, sollevando dubbi non solo sull’efficacia della tecnologia, ma anche sulla sua capacità di minimizzare le vittime civili. Il problema non è tanto l’uso dell’AI per la guerra convenzionale, ma il rischio che l’AI si infiltri nei sistemi nucleari, aumentando il pericolo di escalation.

Vladislav Chernavskikh, ricercatore presso il Stockholm International Peace Research Institute, sottolinea come l’AI possa impattare in vari modi la strategia nucleare, dall’intelligence ai sistemi di comando e controllo, fino ai meccanismi di deterrenza. E proprio qui sta il problema: se l’AI riduce la prevedibilità strategica e aumenta l’incertezza, il risultato potrebbe essere una guerra nucleare scatenata da un errore algoritmico o da una decisione automatizzata fuori controllo.

Il problema è che non esiste una regolamentazione globale sull’uso militare dell’AI. Nel 2021 la Cina ha pubblicato un documento in cui esortava alla “prudenza e responsabilità” nell’applicazione dell’AI nel settore militare, condannando la ricerca della supremazia assoluta. Un messaggio diplomatico diretto agli Stati Uniti, senza mai nominarli esplicitamente.

Nel 2023 l’amministrazione Biden ha riconosciuto i rischi dell’AI in ambito bellico, ma ha anche enfatizzato il potenziale della tecnologia nel proteggere i civili. Insomma, la solita ambiguità politica: da un lato il monito sui pericoli, dall’altro il via libera al suo utilizzo.

Nel frattempo, Cina e Stati Uniti hanno raggiunto un accordo per mantenere il controllo umano sull’uso delle armi nucleari, durante il summit tra Xi Jinping e Biden in California. Un buon segnale, certo, ma insufficiente se gli altri membri permanenti del Consiglio di Sicurezza dell’ONU – Gran Bretagna, Francia e Russia – non si uniscono formalmente a questo impegno.

I sostenitori dell’AI militare parlano di un miglioramento della deterrenza, ma la realtà è più complessa. Se ogni superpotenza teme che l’avversario possa utilizzare l’AI per ottenere un vantaggio strategico, il risultato è un’accelerazione nella militarizzazione della tecnologia, con il rischio concreto di un incidente catastrofico.

Il problema principale è la velocità con cui l’AI elabora dati e prende decisioni. Nei conflitti nucleari, il tempo di reazione è fondamentale: se un sistema AI interpreta erroneamente un attacco come imminente e attiva una risposta nucleare, la catastrofe diventa inevitabile.

Come sottolinea Nicola Leveringhaus, docente di studi sulla guerra al King’s College di Londra, la chiave è stabilire comportamenti responsabili in ambiti non regolamentati come quello dell’AI. Ma la realtà politica è un’altra: gli interessi strategici e militari spesso prevalgono sulle considerazioni etiche, e la volontà politica di creare una regolamentazione condivisa è estremamente limitata.

Il vero pericolo non è che un’AI decida di scatenare un’apocalisse nucleare con la razionalità fredda di un calcolatore, ma che gli esseri umani affidino sempre più decisioni critiche a macchine incapaci di distinguere tra strategia e disastro. L’assenza di regole globali rende questa corsa tecnologica ancora più pericolosa, con i governi divisi tra la necessità di sviluppare l’AI militare per difendersi e il terrore di un sistema fuori controllo.

La soluzione sarebbe un accordo globale che limiti l’uso dell’AI in ambito nucleare e militare, ma la realtà suggerisce che ogni superpotenza preferirà spingere la tecnologia fino al limite, con la speranza che sia l’altro a fermarsi per primo. In questo scenario, la domanda non è se l’AI aumenterà il rischio di un conflitto nucleare, ma quando arriverà il primo incidente causato da un sistema autonomo fuori controllo.

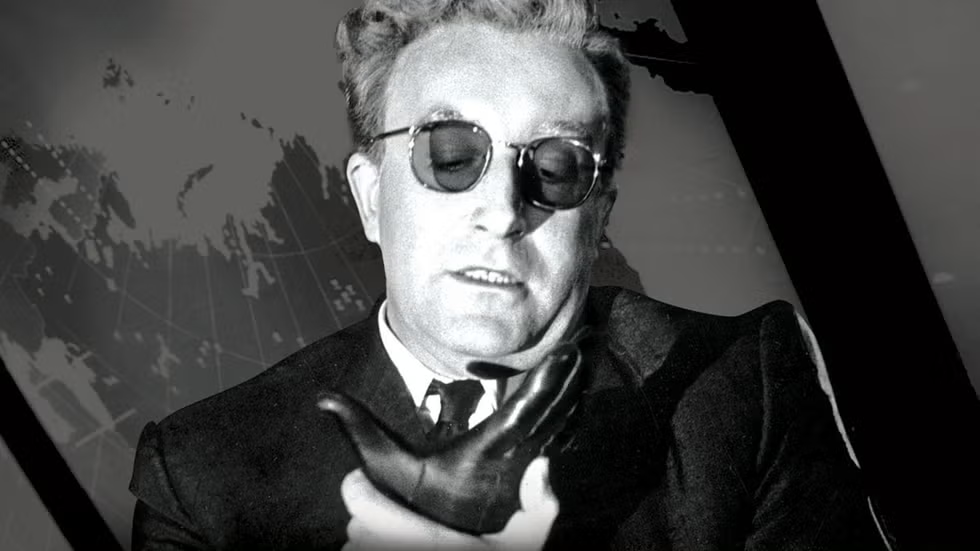

Foto. FILM Il Dottor Stranamore di Stanley Kubrick