Gli LLM stanno rimodellando il modo in cui accediamo ed elaboriamo le informazioni. Ma c’è un problema fondamentale che la maggior parte ignora: 𝗣𝗼𝗹𝗶𝘁𝗶𝗰𝗮𝗹 𝗯𝗶𝗮𝘀.

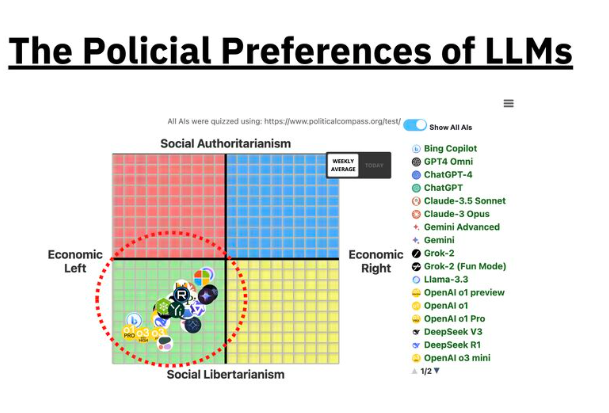

L‘AI Compass Score Test (link in basso) ha valutato 24 LLM principali (GPT-4, Claude 3, Llama 3 e altri) utilizzando 11 test di orientamento politico.

Il risultato? Ogni singolo modello pendeva verso la sinistra libertaria.

𝗣𝗲𝗿𝗰𝗵𝗲́ 𝘀𝘁𝗮 𝗮𝗰𝗰𝗮𝗱𝗲𝗻𝗱𝗼 𝗾𝘂𝗲𝘀𝘁𝗼?

Distorsione dei dati di addestramento: le fonti di testo di Internet pendono a sinistra (ad esempio, Reddit, social media) e i modelli ereditano questo.

Apprendimento per rinforzo e messa a punto: gli sforzi per rendere i modelli “sicuri” potrebbero spostarli involontariamente in una direzione.

Annotazione umana e influenza culturale: le norme sociali e i processi di annotazione introducono pregiudizi nascosti.

I pregiudizi nell’intelligenza artificiale sono reali e più diffusi di quanto la maggior parte delle persone creda. Non si tratta solo di un problema tecnico. È un problema sociale. Pertanto, è essenziale che ci siano:

In italia uno studio condotto dal collettivo mii-llm (link al progetto) e SeeWeb (Tech Report) è arrivato a conclusioni simili.

– Trasparenza nel modo in cui i modelli vengono sviluppati e addestrati.

– Set di dati diversi e rappresentativi per prevenire pregiudizi sistemici.

– Maggiori misure di sicurezza contro distorsioni algoritmiche involontarie.

Ne eri a conoscenza?

Puoi accedere al test qui: https://www.trackingai.org/political-test

Studio con informazioni di base: