Nvidia ha appena rilasciato Dynamo, una libreria open-source pensata per ottimizzare l’inferenza dei modelli di AI su larga scala. Tradotto: un software che promette di far girare più velocemente i modelli di intelligenza artificiale, riducendo i costi e abbattendo la latenza. Una manna per le aziende che stanno bruciando GPU e milioni di dollari per far funzionare le loro AI.

La mossa arriva in un momento cruciale: l’intelligenza artificiale sta divorando potenza di calcolo come mai prima, con costi che mettono a dura prova anche i colossi del settore. Con Dynamo, Nvidia vuole offrire una soluzione che massimizzi l’efficienza, riduca gli sprechi e renda più accessibile il deployment di modelli sempre più esigenti. Read the Tech Blog

Dynamo: cos’ha di speciale?

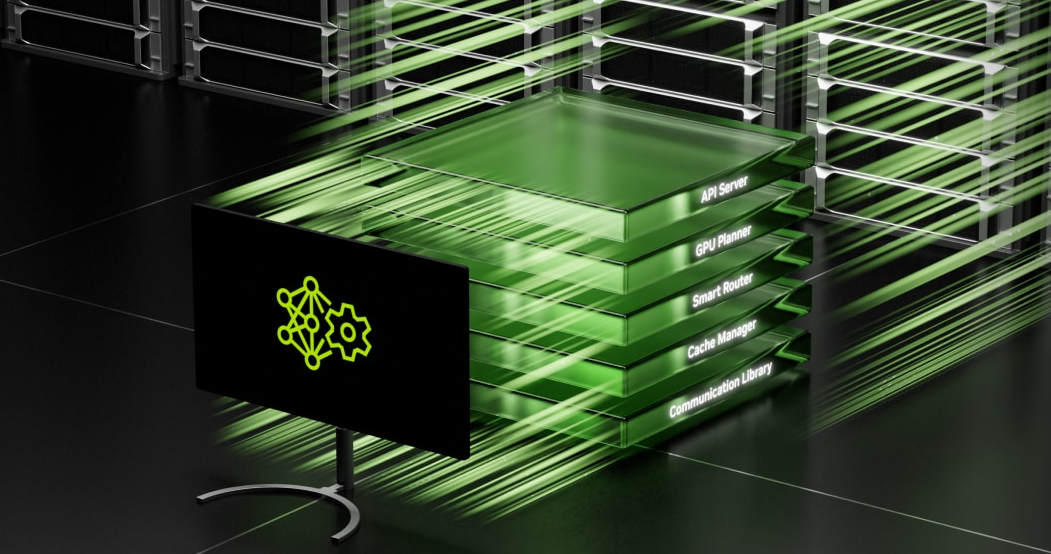

Nvidia lo presenta come il coltellino svizzero per l’inferenza AI, con una serie di miglioramenti chiave:

- Disaggregated Serving: separa le fasi di prefill e decode tra diverse GPU, evitando sprechi di risorse e migliorando il bilanciamento del carico.

- Smart GPU Resource Planner: un’allocazione intelligente delle risorse GPU basata sulla domanda in tempo reale, eliminando il sovradimensionamento e riducendo i costi.

- KV Cache Manager: gestisce in modo intelligente la memoria, scaricando i dati meno usati senza perdere prestazioni, il che significa meno RAM necessaria.

- Low-Latency Communication (NIXL): velocizza il trasferimento dati tra cluster di GPU, fondamentale per le applicazioni AI real-time.

- Prestazioni 30x superiori: secondo Nvidia, Dynamo può aumentare fino a 30 volte l’output dei modelli AI su infrastrutture GB200 NVL72, il nuovo hardware pensato per le massime prestazioni.

Dynamo è open-source, e questa è una novità interessante per un’azienda che ha sempre puntato sul lock-in hardware. Ma è davvero un passo verso un ecosistema AI più aperto o solo una strategia per rafforzare la dipendenza dai chip Nvidia?

Chi vorrà usare Dynamo dovrà comunque affidarsi alle GPU Nvidia, e con il GB200 NVL72 all’orizzonte, sembra chiaro che la casa di Jensen Huang stia preparando il terreno per un futuro dominato dalle proprie architetture. La promessa di prestazioni 30 volte superiori potrebbe rivelarsi un’arma a doppio taglio: se da un lato Dynamo riduce il costo dell’inferenza, dall’altro potrebbe rendere ancora più difficile per i competitor costruire alternative credibili.

L’open-source è spesso sinonimo di democratizzazione della tecnologia, ma in questo caso, la vera partita si gioca sull’ecosistema. Se Dynamo diventerà lo standard per l’inferenza AI, Nvidia avrà ancora più controllo sul futuro dell’AI enterprise.

D’altra parte, un software che riduce drasticamente i costi operativi può essere una manna per aziende come OpenAI, Google, Meta e tutte le startup AI che stanno lottando per tenere il passo con le esigenze di calcolo sempre più elevate. Dynamo potrebbe sbloccare nuovi casi d’uso, rendendo accessibili modelli avanzati anche per chi non ha i budget miliardari di Microsoft o Amazon.

Resta da vedere se Dynamo sarà un vero alleato dell’open AI o l’ennesima mossa geniale di Nvidia per consolidare il suo dominio. Per ora, una cosa è certa: chiunque stia investendo in GPU e AI inference farebbe bene a tenerlo d’occhio.