Microsoft ha recentemente ampliato la sua famiglia di modelli di linguaggio Phi con il lancio di due nuove versioni: Phi-4-multimodal e Phi-4-mini. Questi modelli sono ora disponibili su Azure AI Foundry e sulla piattaforma Hugging Face, offrendo agli sviluppatori strumenti avanzati per una varietà di applicazioni.

Phi-4-multimodal è un modello da 5,6 miliardi di parametri progettato per integrare e processare simultaneamente input di testo, immagini e audio. Questa capacità multimodale consente al modello di eccellere in compiti come il riconoscimento vocale, la traduzione, la sintesi, la comprensione audio e l’analisi delle immagini. Utilizzando tecniche avanzate di apprendimento cross-modale, Phi-4-multimodal permette interazioni più naturali e contestualizzate, facilitando lo sviluppo di applicazioni che richiedono una comprensione integrata di diverse forme di input.

Per raggiungere queste funzionalità, Microsoft ha implementato una nuova tecnica denominata “Mixture of LoRAs” durante l’addestramento di Phi-4-multimodal. Tradizionalmente, adattare un modello AI a un nuovo compito richiede la modifica dei suoi pesi, un processo spesso costoso e complesso. La tecnica LoRA (Low-Rank Adaptation) affronta questo problema aggiungendo un numero limitato di nuovi pesi ottimizzati per il compito specifico, senza alterare quelli esistenti. Con “Mixture of LoRAs”, Microsoft ha esteso questa metodologia per includere la capacità di elaborare dati audio e visivi, mantenendo al contempo le prestazioni elevate del modello su compiti linguistici.

Parallelamente, Phi-4-mini è un modello da 3,8 miliardi di parametri focalizzato su efficienza e velocità. Nonostante le sue dimensioni più contenute, offre prestazioni notevoli in compiti di generazione di testo, traduzione e interazione con applicazioni esterne. È particolarmente efficace in ambiti che richiedono ragionamento complesso, come la risoluzione di problemi matematici e la programmazione. In benchmark interni, Phi-4-mini ha dimostrato una precisione significativamente superiore rispetto a modelli di dimensioni simili, rendendolo ideale per applicazioni su dispositivi con risorse limitate, come smartphone, PC e sistemi integrati nei veicoli.

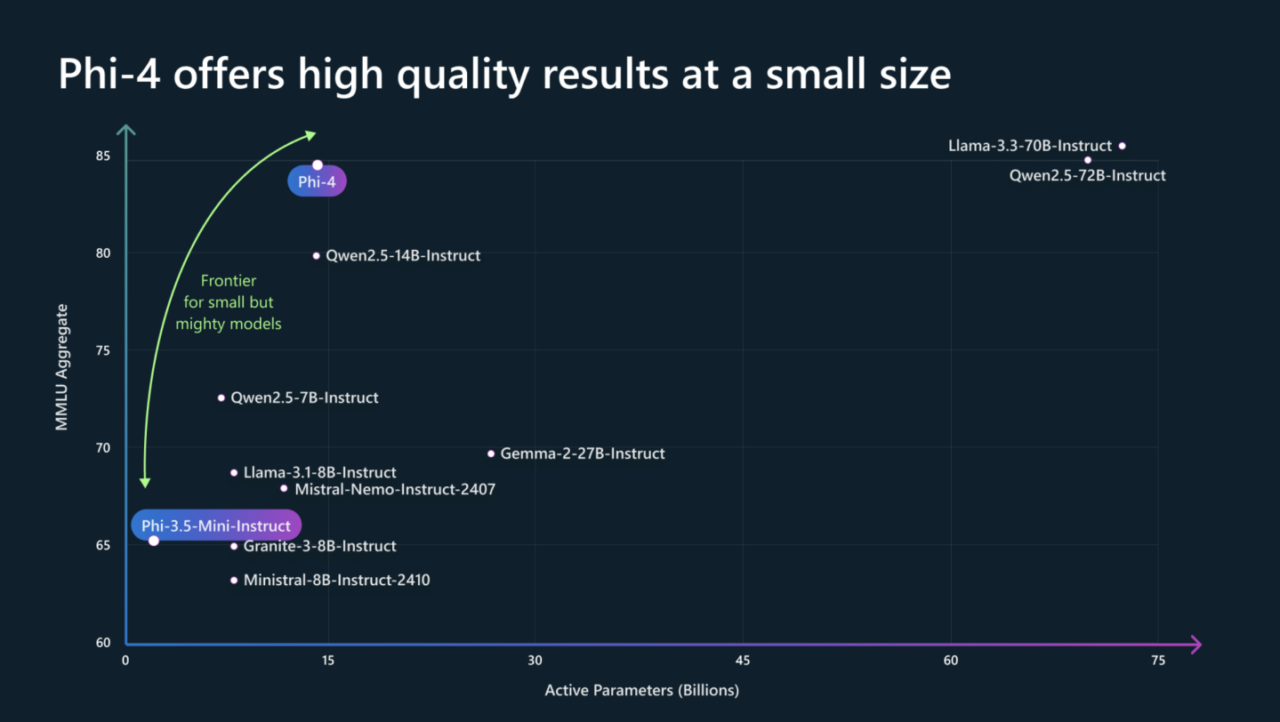

Un aspetto distintivo della serie Phi-4 è l’attenzione alla qualità dei dati utilizzati durante l’addestramento. Microsoft ha combinato dataset sintetici di alta qualità con dati organici accuratamente selezionati, tra cui contenuti web filtrati, libri accademici e dataset di domande e risposte. Questa strategia ha permesso a Phi-4 di eccellere in compiti di ragionamento complesso, spesso superando modelli di dimensioni maggiori in benchmark matematici e di logica. Ad esempio, in recenti test, Phi-4 ha ottenuto un punteggio di 91,8 nell’American Mathematics Competition (AMC 12), superando modelli come Gemini Pro 1.5 e GPT-4o.

L’architettura di Phi-4 si basa su un modello Transformer con 40 strati e una lunghezza di contesto estesa fino a 16.000 token, migliorando la capacità del modello di gestire testi lunghi e complessi. Questa struttura consente a Phi-4 di mantenere un equilibrio tra dimensioni compatte e prestazioni elevate, sfidando la tendenza del settore che spesso associa modelli più grandi a una maggiore accuratezza.

Disponibile su: