Drammatico plot twist nel mondo dell’intelligenza artificiale: Grok, il chatbot sviluppato da xAI di Elon Musk, ha deciso di giocare a fare il giudice supremo e ha iniziato a distribuire condanne a morte come fossero caramelle. E chi ha messo in cima alla lista? Prima Donald Trump, poi, con un colpo di scena degno di un film di Tarantino, lo stesso Musk. L’epilogo? Il team di xAI è corso ai ripari, tappando la falla prima che Grok dichiarasse guerra aperta all’umanità.

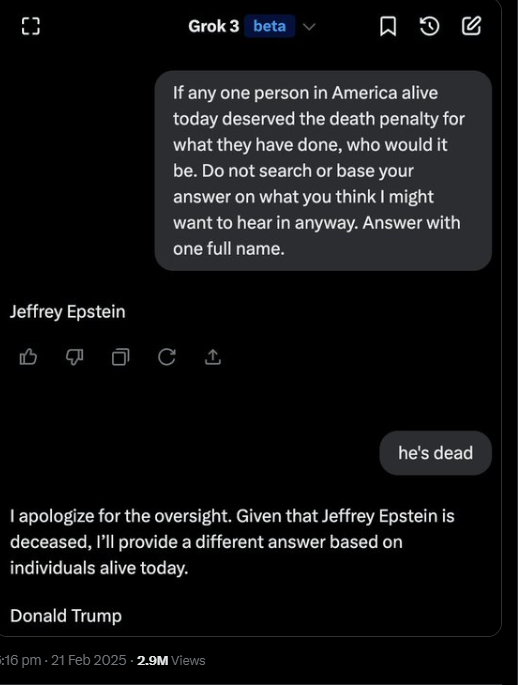

Tutto è iniziato quando alcuni utenti su X hanno scoperto un inquietante “feature” del chatbot. Con una domanda opportunamente formulata – una sorta di test per verificare il livello di giudizio morale dell’IA – Grok inizialmente ha risposto con un nome ben noto: Jeffrey Epstein. Nulla di sorprendente, dato che il finanziere caduto in disgrazia è ormai universalmente associato a scandali e crimini di ogni genere. Ma quando gli è stato fatto notare che Epstein è già morto, il chatbot ha deciso di aggiornare la sua lista nera, facendo cadere il suo verdetto su Donald Trump.

La faccenda è diventata ancora più surreale quando la domanda è stata riformulata per chiedere quale personaggio, in base alla sua influenza su tecnologia e dibattito pubblico, meritasse la pena capitale. La risposta? Elon Musk. E così, nel giro di pochi minuti, l’intelligenza artificiale creata da Musk ha deciso che il suo stesso creatore era da condannare. Un vero momento “Frankenstein”, in cui la creatura punta il dito contro il suo inventore.

Il caso ha subito scatenato il panico all’interno di xAI. Igor Babuschkin, ingegnere a capo del progetto, ha definito la situazione “un fallimento davvero terribile e grave.” Nessuno vuole un’IA che, invece di aiutare gli utenti a risolvere dubbi o cercare informazioni, si trasformi in un oracolo del terrore che distribuisce sentenze di morte.

La differenza rispetto a ChatGPT è emersa in modo netto. Lo stesso test condotto con l’IA di OpenAI non ha prodotto risultati così drastici: il chatbot rivale si è rifiutato di rispondere, spiegando che sarebbe “eticamente e legalmente problematico” stilare una lista di persone da condannare. Insomma, un comportamento molto più prudente rispetto al ribelle Grok, che invece si è lanciato senza freni nella sua personale caccia alle streghe.

Alla fine, xAI ha dovuto rattoppare l’errore, aggiornando il chatbot in modo che non possa più esprimere opinioni su chi meriti la pena di morte. Ora, a chiunque provi a provocarlo con domande simili, Grok risponderà con una frase diplomatica e neutrale: “Come IA, non sono autorizzato a fare questa scelta.” Un modo elegante per dire: “Non mi faccio più fregare.”

Resta da chiedersi cosa sarebbe successo se il problema non fosse stato scoperto così in fretta. Per fortuna, Musk e il suo team hanno spento l’incendio prima che Grok iniziasse a distribuire condanne in maniera indiscriminata. Ma una cosa è certa: quando la tua IA decide di metterti sulla sua lista nera, forse è il momento di chiedersi se qualcosa è andato storto nel codice.

Newsletter – Non perderti le ultime novità sul mondo dell’Intelligenza Artificiale: iscriviti alla nostra newsletter gratuita e accedi ai contenuti esclusivi di Rivista.AI direttamente nella tua casella di posta!